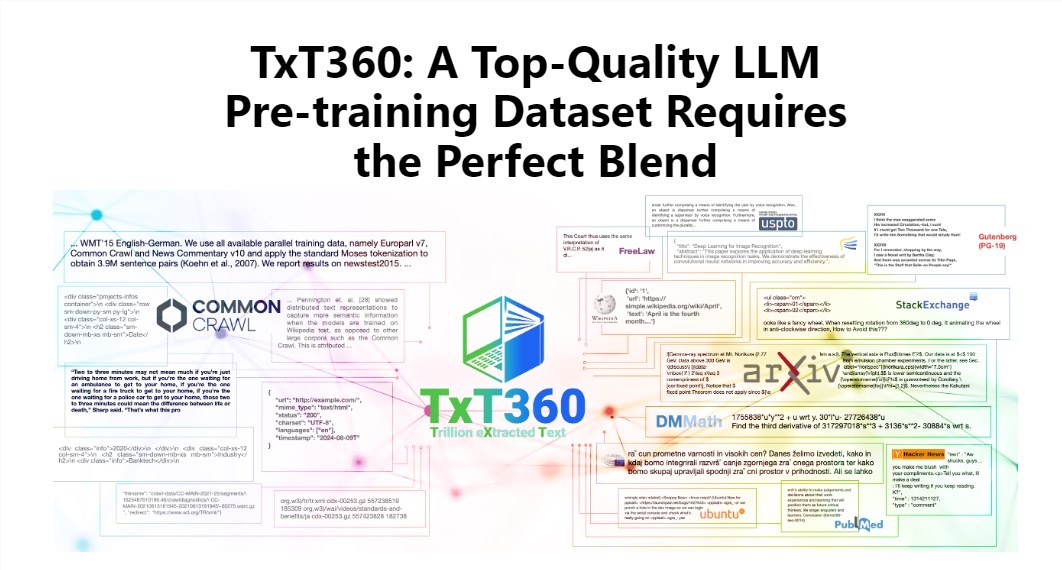

โปรแกรมแก้ไข Downcodes จะพาคุณไปเรียนรู้เกี่ยวกับชุดข้อมูล TxT360 ล่าสุดที่ออกโดย LLM360! นี่คือชุดข้อมูลขนาดใหญ่ที่มีโทเค็นคุณภาพสูง 5.7 ล้านล้าน ซึ่งออกแบบมาเป็นพิเศษสำหรับการฝึกโมเดลภาษาขนาดใหญ่ ไม่เพียงแต่มีขนาดใหญ่เท่านั้น แต่ยังมีคุณภาพสูงมาก เกินกว่าชุดข้อมูลที่มีอยู่ เช่น FineWeb และ RedPajama มาก TxT360 แยกสาระสำคัญของอินเทอร์เน็ตจากสแนปชอตการรวบรวมข้อมูลทั่วไป 99 รายการ และเลือกแหล่งข้อมูลคุณภาพสูง 14 แหล่งเป็นพิเศษ เช่น เอกสารทางกฎหมายและสารานุกรม เพื่อให้มั่นใจถึงความหลากหลายและความน่าเชื่อถือของข้อมูล ที่สำคัญยังมี "สูตรการปรับน้ำหนักข้อมูล" ที่ให้ผู้ใช้สามารถปรับน้ำหนักของแหล่งข้อมูลต่างๆ ได้อย่างยืดหยุ่น และควบคุมข้อมูลได้ละเอียดราวกับทำอาหาร

เสน่ห์ของ TxT360 อยู่ที่ขนาดที่ใหญ่เป็นพิเศษและคุณภาพสูงเป็นพิเศษ ซึ่งมีประสิทธิภาพเหนือกว่าชุดข้อมูลที่มีอยู่ เช่น FineWeb และ RedPajama โดยสิ้นเชิง ชุดข้อมูลนี้รวบรวมสาระสำคัญของอินเทอร์เน็ตจากสแนปชอตการรวบรวมข้อมูลทั่วไป 99 รายการ และยังเลือกแหล่งข้อมูลคุณภาพสูง 14 แหล่งเป็นพิเศษ เช่น เอกสารทางกฎหมายและสารานุกรม เพื่อทำให้เนื้อหาไม่เพียงแต่สมบูรณ์และหลากหลายเท่านั้น แต่ยังน่าเชื่อถืออีกด้วย

ที่เจ๋งกว่านั้นคือ TxT360 มอบ "สูตรการปรับน้ำหนักข้อมูล" ให้กับผู้ใช้ ซึ่งช่วยให้คุณปรับน้ำหนักของแหล่งข้อมูลต่างๆ ได้อย่างยืดหยุ่นตามความต้องการของคุณ เหมือนกับเวลาปรุงอาหารคุณสามารถผสมส่วนผสมต่างๆ ตามรสนิยมของคุณเพื่อให้แน่ใจว่าทุกคำจะอร่อย

แน่นอนว่าเทคโนโลยีการขจัดข้อมูลซ้ำซ้อนก็เป็นจุดเด่นของ TxT360 เช่นกัน ด้วยการดำเนินการขจัดความซ้ำซ้อนที่ซับซ้อน ชุดข้อมูลนี้จะช่วยแก้ปัญหาความซ้ำซ้อนของข้อมูลและความซ้ำซ้อนของข้อมูลในระหว่างกระบวนการฝึกอบรมได้อย่างมีประสิทธิภาพ ทำให้มั่นใจได้ว่าแต่ละโทเค็นจะไม่ซ้ำกัน ในเวลาเดียวกัน ทีมงานโครงการยังใช้นิพจน์ทั่วไปเพื่อลบข้อมูลส่วนบุคคล เช่น อีเมลและที่อยู่ IP ออกจากเอกสารอย่างชาญฉลาด เพื่อรับรองความเป็นส่วนตัวและความปลอดภัยของข้อมูล

TxT360 ได้รับการออกแบบโดยคำนึงถึงคุณภาพและขนาด เมื่อรวมข้อดีของข้อมูลเครือข่ายและแหล่งข้อมูลที่ได้รับการดูแลจัดการ ช่วยให้นักวิจัยสามารถควบคุมการใช้และการกระจายข้อมูลได้อย่างแม่นยำ เช่นเดียวกับการมีรีโมทคอนโทรลมหัศจรรย์ที่สามารถปรับสัดส่วนของข้อมูลได้ตามต้องการ

ในแง่ของผลการฝึก TxT360 ไม่ควรมองข้าม ใช้กลยุทธ์การสุ่มตัวอย่างง่ายๆ เพื่อเพิ่มปริมาณข้อมูลอย่างมาก และในที่สุดก็สร้างชุดข้อมูลที่มีโทเค็นมากกว่า 15 ล้านล้านโทเค็น ในชุดตัวบ่งชี้การประเมินที่สำคัญ TxT360 ทำงานได้ดีกว่า FineWeb โดยเฉพาะในสาขาต่างๆ เช่น MMLU และ NQ ซึ่งแสดงความสามารถในการเรียนรู้ที่แข็งแกร่ง เมื่อรวมกับข้อมูลโค้ด (เช่น Stack V2) เส้นโค้งการเรียนรู้จะมีเสถียรภาพมากขึ้นและประสิทธิภาพของโมเดลได้รับการปรับปรุงอย่างมาก

ข้อมูลเบื้องต้นโดยละเอียด: https://huggingface.co/spaces/LLM360/TxT360

โดยรวมแล้ว การเกิดขึ้นของชุดข้อมูล TxT360 มอบความเป็นไปได้ใหม่ๆ สำหรับการฝึกโมเดลภาษาขนาดใหญ่ ข้อมูลคุณภาพสูง และฟังก์ชันการปรับน้ำหนักข้อมูลที่ยืดหยุ่นจะช่วยส่งเสริมการพัฒนาเทคโนโลยีโมเดลภาษาขนาดใหญ่ต่อไปอย่างไม่ต้องสงสัย สำหรับข้อมูลเพิ่มเติม โปรดไปที่ลิงก์เพื่อดูคำแนะนำโดยละเอียด!