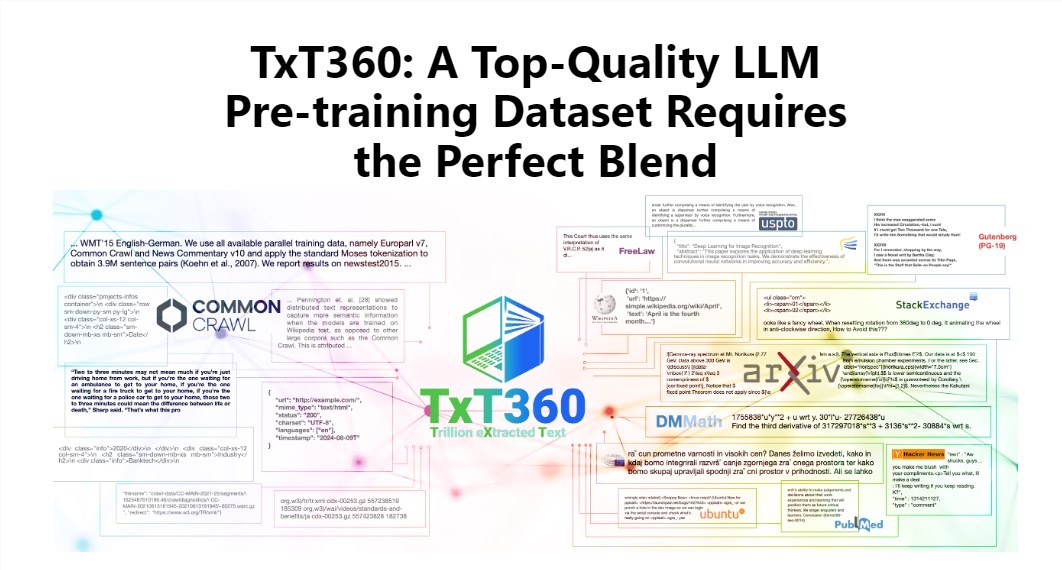

Der Herausgeber von Downcodes zeigt Ihnen den neuesten TxT360-Datensatz, der von LLM360 veröffentlicht wurde! Dabei handelt es sich um einen riesigen Datensatz mit 5,7 Billionen hochwertigen Token, der speziell für das Training großer Sprachmodelle entwickelt wurde. Es ist nicht nur riesig groß, sondern auch von extrem hoher Qualität und übertrifft bestehende Datensätze wie FineWeb und RedPajama bei weitem. TxT360 extrahiert die Essenz des Internets aus 99 Common Crawl-Snapshots und wählt speziell 14 hochwertige Datenquellen wie Rechtsdokumente und Enzyklopädien aus, um Datenvielfalt und Zuverlässigkeit sicherzustellen. Noch wichtiger ist, dass es „Rezepte zur Datengewichtsanpassung“ bereitstellt, mit denen Benutzer die Gewichte verschiedener Datenquellen flexibel anpassen und die Daten so fein steuern können wie beim Kochen.

Der Charme von TxT360 liegt in seinem extrem großen Maßstab und seiner extrem hohen Qualität, die bestehende Datensätze wie FineWeb und RedPajama völlig übertrifft. Dieser Datensatz erfasst die Essenz des Internets aus 99 Common Crawl-Schnappschüssen und wählt außerdem speziell 14 hochwertige Datenquellen wie Rechtsdokumente und Enzyklopädien aus, um seinen Inhalt nicht nur reichhaltig und vielfältig, sondern auch recht zuverlässig zu machen.

Noch cooler ist, dass TxT360 Benutzern ein „Rezept zur Anpassung der Datengewichtung“ bietet, mit dem Sie die Gewichtungen verschiedener Datenquellen flexibel an Ihre Bedürfnisse anpassen können. Dies ist wie beim Kochen: Sie können verschiedene Zutaten nach Ihrem Geschmack mischen, um sicherzustellen, dass jeder Bissen köstlich ist.

Natürlich ist auch die Deduplizierungstechnologie ein Highlight von TxT360. Durch komplexe Deduplizierungsvorgänge löst dieser Datensatz effektiv das Problem der Datenredundanz und Informationsduplizierung während des Trainingsprozesses und stellt sicher, dass jedes Token einzigartig ist. Gleichzeitig nutzte das Projektteam auch reguläre Ausdrücke, um personenbezogene Daten wie E-Mails und IP-Adressen geschickt aus den Dokumenten zu entfernen, um Datenschutz und Sicherheit zu gewährleisten.

Bei der Entwicklung des TxT360 standen sowohl die Qualität als auch die Skalierbarkeit im Vordergrund. Durch die Kombination der Vorteile von Netzwerkdaten und kuratierten Datenquellen können Forscher die Nutzung und Verteilung von Daten genau steuern, als hätten sie eine magische Fernbedienung, mit der sie den Anteil der Daten nach Belieben anpassen können.

In puncto Trainingseffekt ist TxT360 nicht zu übertreffen. Es verwendet eine einfache Upsampling-Strategie, um die Datenmenge erheblich zu erhöhen und schließlich einen Datensatz von mehr als 15 Billionen Token zu erstellen. Bei einer Reihe wichtiger Bewertungsindikatoren schneidet TxT360 besser ab als FineWeb, insbesondere in Bereichen wie MMLU und NQ, und weist starke Lernfähigkeiten auf. In Kombination mit Codedaten (wie Stack V2) ist die Lernkurve stabiler und die Modellleistung wird deutlich verbessert.

Detaillierte Einführung: https://huggingface.co/spaces/LLM360/TxT360

Alles in allem bietet das Aufkommen des TxT360-Datensatzes neue Möglichkeiten für das Training großer Sprachmodelle. Sein riesiger Umfang, die hochwertigen Daten und die flexiblen Funktionen zur Datengewichtung werden zweifellos die Weiterentwicklung der Technologie großer Sprachmodelle vorantreiben. Für weitere Informationen besuchen Sie bitte den Link für eine detaillierte Einführung!