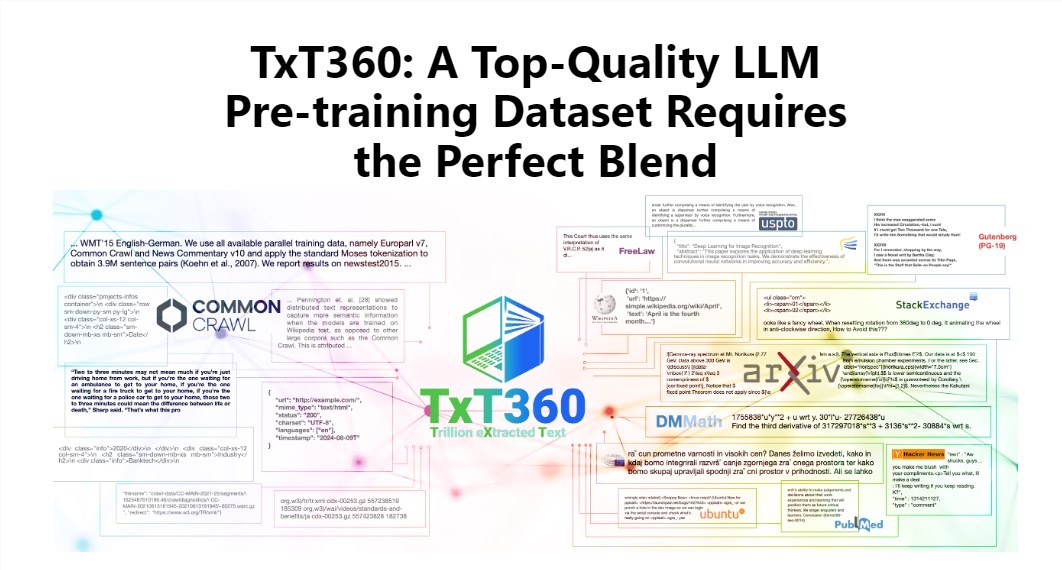

Редактор Downcodes познакомит вас с последним набором данных TxT360, выпущенным LLM360! Это огромный набор данных с 5,7 триллионами высококачественных токенов, специально разработанный для обучения больших языковых моделей. Он не только огромен по масштабу, но и чрезвычайно высокого качества, намного превосходя существующие наборы данных, такие как FineWeb и RedPajama. TxT360 извлекает суть Интернета из 99 снимков Common Crawl и специально отбирает 14 высококачественных источников данных, таких как юридические документы и энциклопедии, чтобы обеспечить разнообразие и надежность данных. Что еще более важно, он предоставляет «рецепты корректировки веса данных», которые позволяют пользователям гибко настраивать веса различных источников данных и контролировать данные так же точно, как приготовление пищи.

Очарование TxT360 заключается в его сверхбольшом масштабе и сверхвысоком качестве, которое полностью превосходит существующие наборы данных, такие как FineWeb и RedPajama. Этот набор данных отражает суть Интернета из 99 снимков Common Crawl, а также специально отбирает 14 высококачественных источников данных, таких как юридические документы и энциклопедии, чтобы сделать его контент не только богатым и разнообразным, но и достаточно достоверным.

Что еще круче, так это то, что TxT360 предоставляет пользователям «рецепт корректировки веса данных», который позволяет гибко настраивать веса различных источников данных в соответствии с вашими потребностями. Это похоже на то, как при приготовлении пищи вы можете смешивать различные ингредиенты по своему вкусу, чтобы каждый кусочек был вкусным.

Конечно, технология дедупликации также является изюминкой TxT360. Благодаря сложным операциям дедупликации этот набор данных эффективно решает проблему избыточности данных и дублирования информации в процессе обучения, гарантируя уникальность каждого токена. В то же время команда проекта также использовала регулярные выражения для умелого удаления личной информации, такой как адреса электронной почты и IP-адреса, из документов, чтобы обеспечить конфиденциальность и безопасность данных.

TxT360 был разработан с учетом качества и масштаба. Сочетая в себе преимущества сетевых данных и курируемых источников данных, он позволяет исследователям точно контролировать использование и распространение данных, подобно волшебному пульту дистанционного управления, который может регулировать долю данных по своему желанию.

С точки зрения тренировочного эффекта TxT360 не отстает. Он использует простую стратегию повышения дискретизации, чтобы значительно увеличить объем данных, в конечном итоге создавая набор данных из более чем 15 триллионов токенов. По ряду ключевых показателей оценки TxT360 работает лучше, чем FineWeb, особенно в таких областях, как MMLU и NQ, демонстрируя сильные способности к обучению. В сочетании с данными кода (например, Stack V2) кривая обучения становится более стабильной, а производительность модели значительно улучшается.

Подробное введение: https://huggingface.co/spaces/LLM360/TxT360.

В целом, появление набора данных TxT360 открывает новые возможности для обучения больших языковых моделей. Его огромные масштабы, высококачественные данные и гибкие функции корректировки веса данных, несомненно, будут способствовать дальнейшему развитию технологии больших языковых моделей. Для получения дополнительной информации, пожалуйста, перейдите по ссылке для подробного ознакомления!