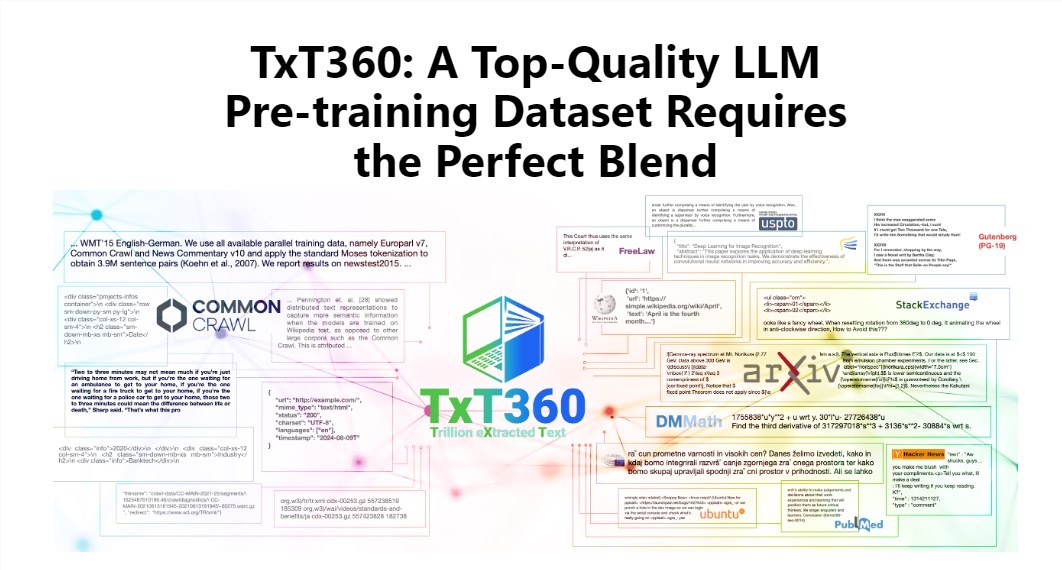

다운코드 편집기를 통해 LLM360에서 출시된 최신 TxT360 데이터 세트에 대해 알아볼 수 있습니다! 이는 대규모 언어 모델 훈련을 위해 특별히 설계된 5.7조 개의 고품질 토큰을 포함하는 거대한 데이터 세트입니다. 규모가 엄청날 뿐만 아니라 FineWeb 및 RedPajama와 같은 기존 데이터세트를 훨씬 능가하는 매우 높은 품질을 자랑합니다. TxT360은 99개의 Common Crawl 스냅샷에서 인터넷의 본질을 추출하고 법률 문서, 백과사전 등 14개의 고품질 데이터 소스를 특별히 선택하여 데이터 다양성과 신뢰성을 보장합니다. 더 중요한 점은 사용자가 다양한 데이터 소스의 가중치를 유연하게 조정하고 요리처럼 세밀하게 데이터를 제어할 수 있는 '데이터 가중치 조정 레시피'를 제공한다는 점이다.

TxT360의 매력은 FineWeb, RedPajama 등 기존 데이터세트를 완전히 뛰어넘는 초대형 규모, 초고화질에 있습니다. 이 데이터 세트는 99개의 Common Crawl 스냅샷에서 인터넷의 본질을 포착하고 법률 문서 및 백과사전과 같은 14개의 고품질 데이터 소스를 특별히 선택하여 콘텐츠를 풍부하고 다양할 뿐만 아니라 상당히 신뢰할 수 있게 만듭니다.

더욱 멋진 점은 TxT360이 사용자에게 필요에 따라 다양한 데이터 소스의 가중치를 유연하게 조정할 수 있는 "데이터 가중치 조정 레시피"를 제공한다는 것입니다. 이는 마치 요리를 할 때 입맛에 따라 다양한 재료를 섞어서 한 입 한 입 먹어도 맛있을 수 있는 것과 같습니다.

물론 중복제거 기술도 TxT360의 하이라이트입니다. 복잡한 중복 제거 작업을 통해 이 데이터 세트는 교육 과정 중 데이터 중복 및 정보 중복 문제를 효과적으로 해결하여 각 토큰이 고유하도록 보장합니다. 동시에 프로젝트 팀은 데이터 개인정보 보호 및 보안을 보장하기 위해 정규식을 사용하여 이메일, IP 주소 등의 개인 식별 정보를 문서에서 교묘하게 제거했습니다.

TxT360은 품질과 규모를 염두에 두고 설계되었습니다. 네트워크 데이터와 큐레이팅된 데이터 소스의 장점을 결합하면, 마치 데이터의 비율을 마음대로 조절할 수 있는 마법의 리모콘을 가진 것처럼 연구자들이 데이터의 사용과 배포를 정밀하게 제어할 수 있습니다.

훈련 효과 측면에서는 TxT360을 따라올 수 없습니다. 간단한 업샘플링 전략을 사용하여 데이터 양을 크게 늘려 결국 15조 개가 넘는 토큰의 데이터 세트를 생성합니다. 일련의 핵심 평가 지표에서 TxT360은 특히 MMLU, NQ 등의 분야에서 FineWeb보다 우수한 성능을 보여 강력한 학습 능력을 보여줍니다. 코드 데이터(예: Stack V2)와 결합하면 학습 곡선이 더욱 안정적이고 모델 성능이 크게 향상됩니다.

자세한 소개 : https://huggingface.co/spaces/LLM360/TxT360

전체적으로, TxT360 데이터 세트의 출현은 대규모 언어 모델 학습에 대한 새로운 가능성을 제공하며, 그 거대한 규모, 고품질 데이터 및 유연한 데이터 가중치 조정 기능은 의심할 여지 없이 대규모 언어 모델 기술의 추가 개발을 촉진할 것입니다. 자세한 내용은 링크를 통해 자세한 소개를 확인해주세요!