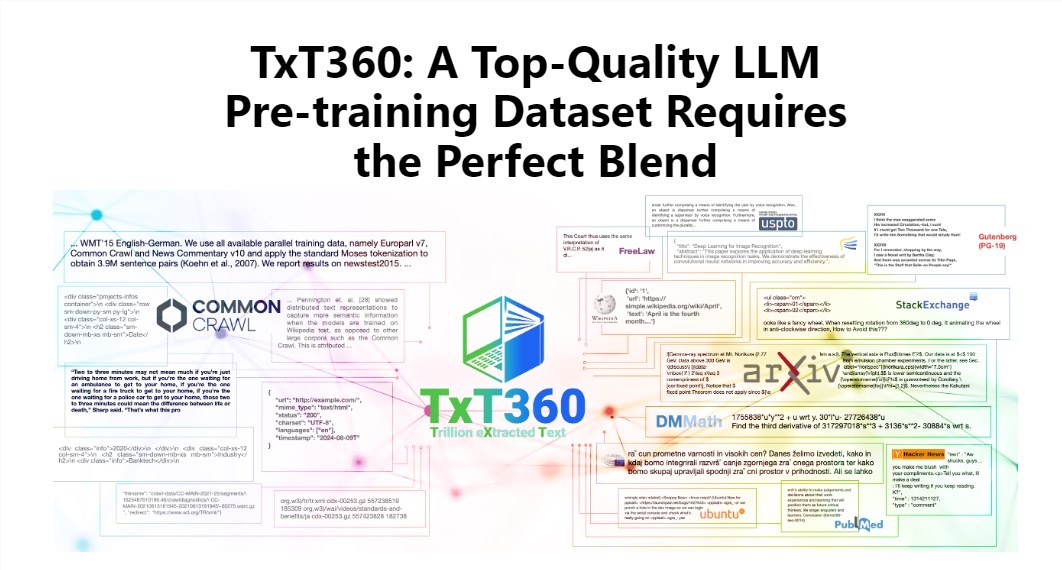

Editor Downcodes akan membawa Anda mempelajari kumpulan data TxT360 terbaru yang dirilis oleh LLM360! Ini adalah kumpulan data besar dengan 5,7 triliun token berkualitas tinggi, yang dirancang khusus untuk pelatihan model bahasa berukuran besar. Tidak hanya skalanya yang besar, kualitasnya juga sangat tinggi, jauh melebihi kumpulan data yang ada seperti FineWeb dan RedPajama. TxT360 mengekstrak esensi Internet dari 99 snapshot Common Crawl dan secara khusus memilih 14 sumber data berkualitas tinggi, seperti dokumen hukum dan ensiklopedia, untuk memastikan keragaman dan keandalan data. Lebih penting lagi, ia menyediakan "resep penyesuaian berat data" yang memungkinkan pengguna menyesuaikan berat berbagai sumber data secara fleksibel dan mengontrol data sehalus memasak.

Pesona TxT360 terletak pada skalanya yang sangat besar dan kualitasnya yang sangat tinggi, yang benar-benar mengungguli kumpulan data yang ada seperti FineWeb dan RedPajama. Kumpulan data ini menangkap esensi Internet dari 99 snapshot Common Crawl, dan juga secara khusus memilih 14 sumber data berkualitas tinggi, seperti dokumen hukum dan ensiklopedia, untuk menjadikan kontennya tidak hanya kaya dan beragam, tetapi juga cukup andal.

Yang lebih keren lagi adalah TxT360 memberi pengguna “resep penyesuaian bobot data” yang memungkinkan Anda menyesuaikan bobot berbagai sumber data secara fleksibel sesuai kebutuhan Anda. Ibaratnya saat memasak, Anda bisa mencampurkan berbagai bahan sesuai selera untuk memastikan setiap gigitannya lezat.

Tentu saja, teknologi deduplikasi juga menjadi keunggulan TxT360. Melalui operasi deduplikasi yang kompleks, kumpulan data ini secara efektif memecahkan masalah redundansi data dan duplikasi informasi selama proses pelatihan, memastikan bahwa setiap token bersifat unik. Pada saat yang sama, tim proyek juga menggunakan ekspresi reguler untuk secara cerdik menghapus informasi identitas pribadi, seperti email dan alamat IP, dari dokumen untuk memastikan privasi dan keamanan data.

TxT360 dirancang dengan mempertimbangkan kualitas dan skala. Menggabungkan keunggulan data jaringan dan sumber data yang dikurasi, memungkinkan peneliti mengontrol penggunaan dan distribusi data secara tepat, seperti memiliki kendali jarak jauh ajaib yang dapat menyesuaikan proporsi data sesuka hati.

Dalam hal efek pelatihan, TxT360 tidak mau kalah. Ini menggunakan strategi upsampling sederhana untuk meningkatkan jumlah data secara signifikan, yang pada akhirnya menghasilkan kumpulan data lebih dari 15 triliun token. Dalam serangkaian indikator evaluasi utama, kinerja TxT360 lebih baik daripada FineWeb, terutama di bidang seperti MMLU dan NQ, yang menunjukkan kemampuan pembelajaran yang kuat. Jika dikombinasikan dengan data kode (seperti Stack V2), kurva pembelajaran menjadi lebih stabil dan performa model meningkat secara signifikan.

Pengenalan mendetail: https://huggingface.co/spaces/LLM360/TxT360

Secara keseluruhan, kemunculan kumpulan data TxT360 memberikan kemungkinan baru untuk pelatihan model bahasa besar. Skalanya yang besar, data berkualitas tinggi, dan fungsi penyesuaian bobot data yang fleksibel tidak diragukan lagi akan mendorong pengembangan lebih lanjut dari teknologi model bahasa besar. Untuk informasi lebih lanjut, silakan kunjungi tautan untuk pengenalan mendetail!