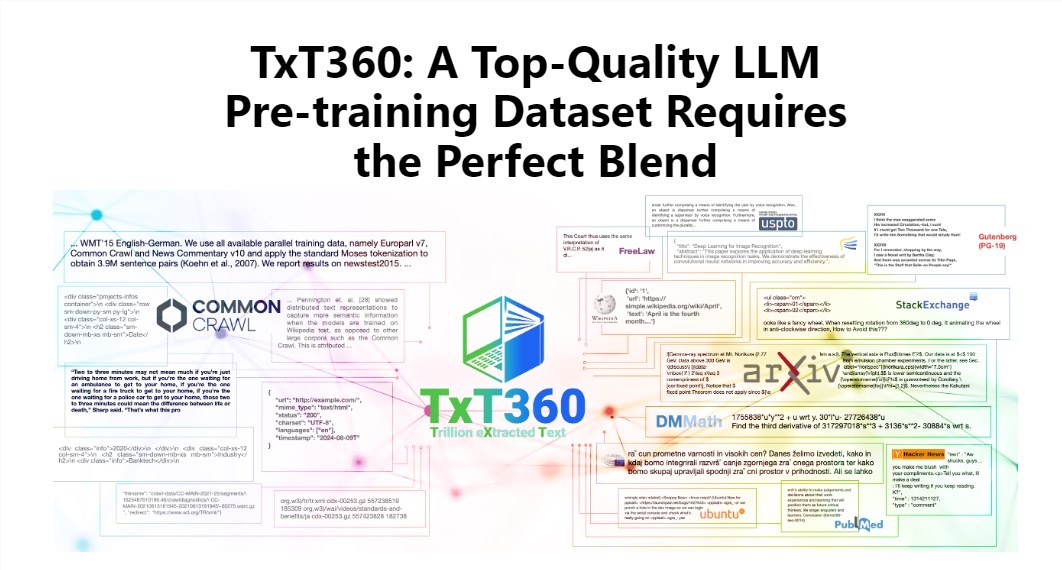

O editor de Downcodes levará você para conhecer o último conjunto de dados TxT360 lançado pela LLM360! Este é um enorme conjunto de dados com 5,7 trilhões de tokens de alta qualidade, especialmente projetados para treinamento de grandes modelos de linguagem. Não é apenas enorme em escala, mas também de qualidade extremamente alta, excedendo em muito os conjuntos de dados existentes, como FineWeb e RedPajama. O TxT360 extrai a essência da Internet de 99 snapshots do Common Crawl e seleciona especialmente 14 fontes de dados de alta qualidade, como documentos legais e enciclopédias, para garantir a diversidade e a confiabilidade dos dados. Mais importante ainda, ele fornece “receitas de ajuste de peso de dados” que permitem aos usuários ajustar com flexibilidade os pesos de diferentes fontes de dados e controlar os dados com a mesma precisão que cozinham.

O charme do TxT360 está em sua escala ultragrande e qualidade ultra-alta, que supera completamente os conjuntos de dados existentes, como FineWeb e RedPajama. Este conjunto de dados captura a essência da Internet a partir de 99 instantâneos de rastreamento comum e também seleciona especialmente 14 fontes de dados de alta qualidade, como documentos jurídicos e enciclopédias, para tornar seu conteúdo não apenas rico e diversificado, mas também bastante confiável.

O que é ainda mais legal é que o TxT360 fornece aos usuários uma “receita de ajuste de peso de dados” que permite ajustar com flexibilidade os pesos de diferentes fontes de dados de acordo com suas necessidades. É como cozinhar, você pode misturar vários ingredientes de acordo com seu gosto para garantir que cada mordida seja deliciosa.

É claro que a tecnologia de desduplicação também é um destaque do TxT360. Através de operações complexas de desduplicação, este conjunto de dados resolve efetivamente o problema de redundância de dados e duplicação de informações durante o processo de treinamento, garantindo que cada token seja único. Ao mesmo tempo, a equipe do projeto também usou expressões regulares para remover de forma inteligente informações de identificação pessoal, como e-mails e endereços IP, dos documentos para garantir a privacidade e segurança dos dados.

O TxT360 foi projetado tendo em mente a qualidade e também a escala. Combinando as vantagens dos dados em rede e das fontes de dados selecionadas, permite aos pesquisadores controlar com precisão o uso e a distribuição dos dados, como se tivessem um controle remoto mágico que pode ajustar a proporção dos dados à vontade.

Em termos de efeito de treinamento, o TxT360 não deve ficar atrás. Ele usa uma estratégia simples de upsampling para aumentar significativamente a quantidade de dados, criando eventualmente um conjunto de dados de mais de 15 trilhões de tokens. Em uma série de indicadores-chave de avaliação, o TxT360 tem um desempenho melhor que o FineWeb, especialmente em áreas como MMLU e NQ, mostrando fortes capacidades de aprendizagem. Quando combinado com dados de código (como Stack V2), a curva de aprendizado é mais estável e o desempenho do modelo é significativamente melhorado.

Introdução detalhada: https://huggingface.co/spaces/LLM360/TxT360

Em suma, o surgimento do conjunto de dados TxT360 oferece novas possibilidades para o treinamento de modelos de linguagem de grande porte. Sua enorme escala, dados de alta qualidade e funções flexíveis de ajuste de peso de dados irão, sem dúvida, promover o desenvolvimento da tecnologia de modelos de linguagem de grande porte. Para mais informações, visite o link para uma introdução detalhada!