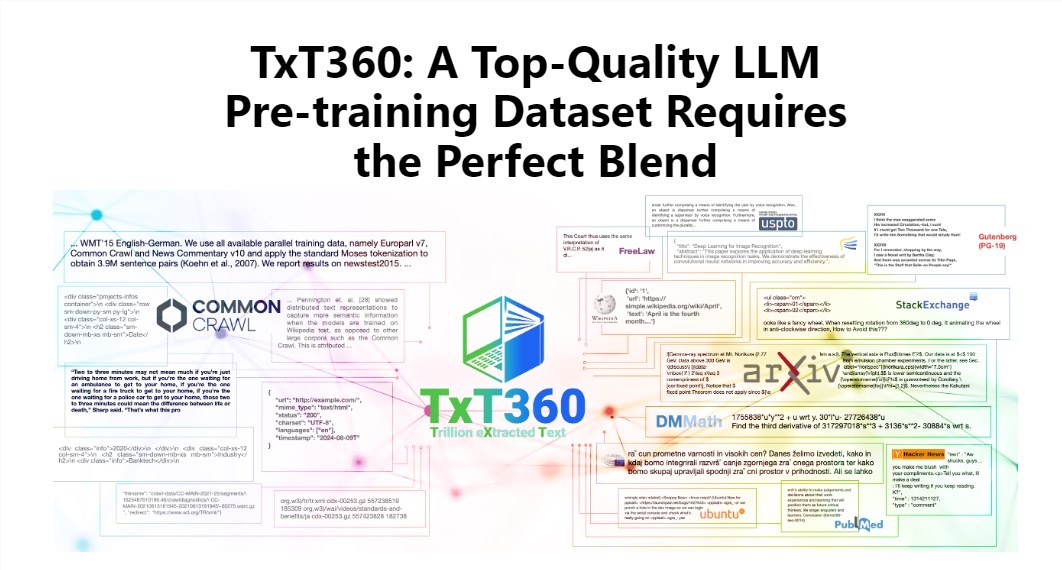

سيأخذك محرر Downcodes للتعرف على أحدث مجموعة بيانات TxT360 الصادرة عن LLM360! هذه مجموعة بيانات ضخمة تحتوي على 5.7 تريليون رمز عالي الجودة، مصممة خصيصًا للتدريب على نماذج اللغة الكبيرة. إنها ليست ضخمة الحجم فحسب، بل إنها أيضًا ذات جودة عالية للغاية، وتتجاوز بكثير مجموعات البيانات الموجودة مثل FineWeb وRedPajama. يستخرج TxT360 جوهر الإنترنت من 99 لقطة للزحف المشترك ويختار بشكل خاص 14 مصدر بيانات عالي الجودة، مثل المستندات القانونية والموسوعات، لضمان تنوع البيانات وموثوقيتها. والأهم من ذلك، أنه يوفر "وصفات لضبط وزن البيانات" التي تسمح للمستخدمين بضبط أوزان مصادر البيانات المختلفة بمرونة والتحكم في البيانات بدقة مثل الطهي.

يكمن سحر TxT360 في حجمه الكبير جدًا وجودته العالية جدًا، والتي تتفوق تمامًا على مجموعات البيانات الموجودة مثل FineWeb وRedPajama. تلتقط مجموعة البيانات هذه جوهر الإنترنت من 99 لقطة للزحف المشترك، كما تختار بشكل خاص 14 مصدرًا للبيانات عالية الجودة، مثل المستندات القانونية والموسوعات، لجعل محتواها ليس غنيًا ومتنوعًا فحسب، بل موثوقًا به أيضًا.

والأمر الأكثر روعة هو أن TxT360 يوفر للمستخدمين "وصفة لضبط وزن البيانات" تسمح لك بضبط أوزان مصادر البيانات المختلفة بمرونة وفقًا لاحتياجاتك. هذا هو الحال عند الطهي، يمكنك مزج المكونات المختلفة حسب ذوقك للتأكد من أن كل قضمة لذيذة.

وبطبيعة الحال، تعد تقنية إلغاء البيانات المكررة أيضًا من أبرز ميزات TxT360. من خلال عمليات إلغاء البيانات المكررة المعقدة، تحل مجموعة البيانات هذه بشكل فعال مشكلة تكرار البيانات وتكرار المعلومات أثناء عملية التدريب، مما يضمن أن كل رمز مميز فريد من نوعه. وفي الوقت نفسه، استخدم فريق المشروع أيضًا التعبيرات العادية لإزالة معلومات التعريف الشخصية بذكاء، مثل رسائل البريد الإلكتروني وعناوين IP، من المستندات لضمان خصوصية البيانات وأمانها.

تم تصميم TxT360 مع وضع الجودة في الاعتبار بالإضافة إلى الحجم. ومن خلال الجمع بين مزايا بيانات الشبكة ومصادر البيانات المنسقة، فإنه يسمح للباحثين بالتحكم الدقيق في استخدام البيانات وتوزيعها، تمامًا مثل وجود جهاز تحكم عن بعد سحري يمكنه ضبط نسبة البيانات حسب الرغبة.

من حيث تأثير التدريب، لا يمكن التفوق على TxT360. ويستخدم إستراتيجية بسيطة لاختزال العينات لزيادة كمية البيانات بشكل كبير، مما يؤدي في النهاية إلى إنشاء مجموعة بيانات تضم أكثر من 15 تريليون رمز مميز. في سلسلة من مؤشرات التقييم الرئيسية، يكون أداء TxT360 أفضل من FineWeb، خاصة في مجالات مثل MMLU وNQ، مما يظهر قدرات تعليمية قوية. عند دمجه مع بيانات التعليمات البرمجية (مثل Stack V2)، يكون منحنى التعلم أكثر استقرارًا ويتم تحسين أداء النموذج بشكل ملحوظ.

مقدمة تفصيلية: https://huggingface.co/spaces/LLM360/TxT360

بشكل عام، يوفر ظهور مجموعة بيانات TxT360 إمكانيات جديدة لتدريب نماذج لغوية كبيرة الحجم، وبيانات عالية الجودة، ووظائف ضبط وزن البيانات المرنة ستعزز بلا شك التطوير الإضافي لتكنولوجيا نماذج اللغة الكبيرة. لمزيد من المعلومات، يرجى زيارة الرابط للحصول على مقدمة مفصلة!