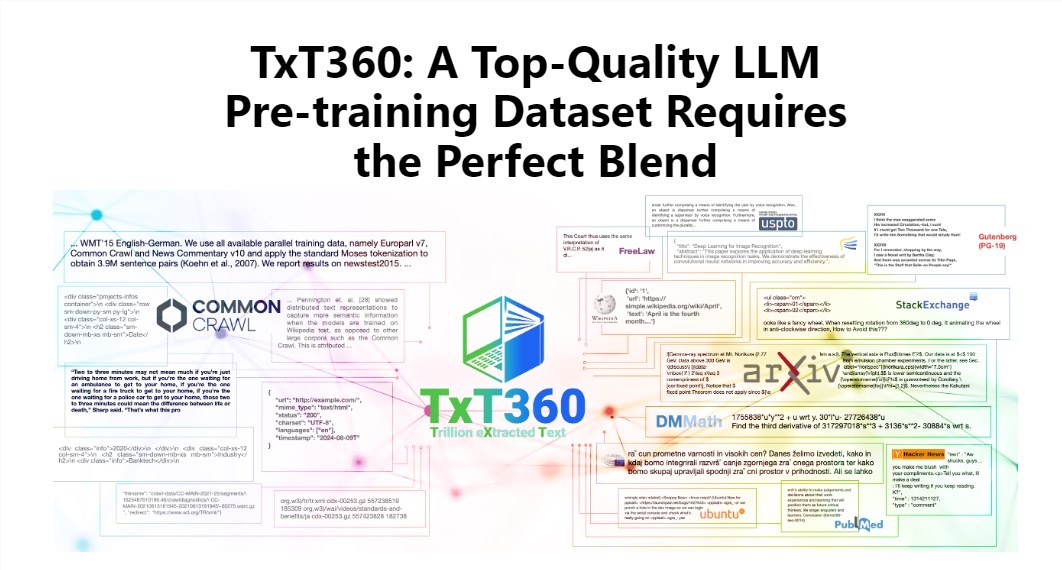

Downcodes のエディターは、LLM360 によってリリースされた最新の TxT360 データ セットについて学習します。これは、大規模な言語モデルのトレーニング用に特別に設計された、5.7 兆の高品質トークンを含む巨大なデータ セットです。規模が大きいだけでなく、FineWebやRedPajamaなどの既存のデータセットをはるかに上回る非常に高品質です。 TxT360 は、99 の Common Crawl スナップショットからインターネットの本質を抽出し、法的文書や百科事典などの 14 の高品質データ ソースを特別に選択して、データの多様性と信頼性を確保します。さらに重要なのは、ユーザーがさまざまなデータ ソースの重みを柔軟に調整し、料理と同じくらい細かくデータを制御できるようにする「データ重み調整レシピ」を提供することです。

TxT360 の魅力は、FineWeb や RedPajama などの既存のデータセットを完全に上回る超大規模かつ超高品質な点にあります。このデータ セットは、99 の Common Crawl スナップショットからインターネットの本質を捉えており、また、その内容が豊富で多様であるだけでなく、非常に信頼できるものにするために、法的文書や百科事典などの 14 の高品質のデータ ソースも特別に選択されています。

さらに優れているのは、TxT360 が、ニーズに応じてさまざまなデータ ソースの重みを柔軟に調整できる「データ重み調整レシピ」をユーザーに提供することです。これは、料理をするときと同じで、好みに応じてさまざまな材料を混ぜ合わせて、一口ごとに美味しくすることができます。

もちろん、重複排除テクノロジーも TxT360 のハイライトです。このデータ セットは、複雑な重複排除操作を通じて、トレーニング プロセス中のデータの冗長性と情報の重複の問題を効果的に解決し、各トークンが一意であることを保証します。同時に、プロジェクト チームは正規表現を使用して電子メールや IP アドレスなどの個人を特定できる情報を文書から巧みに削除し、データのプライバシーとセキュリティを確保しました。

TxT360 は、規模だけでなく品質も念頭に置いて設計されました。ネットワーク データと厳選されたデータ ソースの利点を組み合わせることで、研究者は、データの割合を自由に調整できる魔法のリモコンを持っているかのように、データの使用と配布を正確に制御できます。

トレーニング効果という点では、TxT360 も負けていません。シンプルなアップサンプリング戦略を使用してデータ量を大幅に増加させ、最終的には 15 兆を超えるトークンのデータ セットを作成します。一連の主要な評価指標において、TxT360 は、特に MMLU や NQ などの分野で FineWeb より優れたパフォーマンスを示し、強力な学習能力を示しています。コード データ (Stack V2 など) と組み合わせると、学習曲線がより安定し、モデルのパフォーマンスが大幅に向上します。

詳しい紹介:https://huggingface.co/spaces/LLM360/TxT360

全体として、TxT360 データセットの登場は、大規模な言語モデルのトレーニングに新たな可能性をもたらし、その巨大なスケール、高品質のデータ、および柔軟なデータ重み調整機能により、間違いなく大規模言語モデル技術のさらなる発展が促進されるでしょう。詳しい紹介はリンク先からどうぞ!