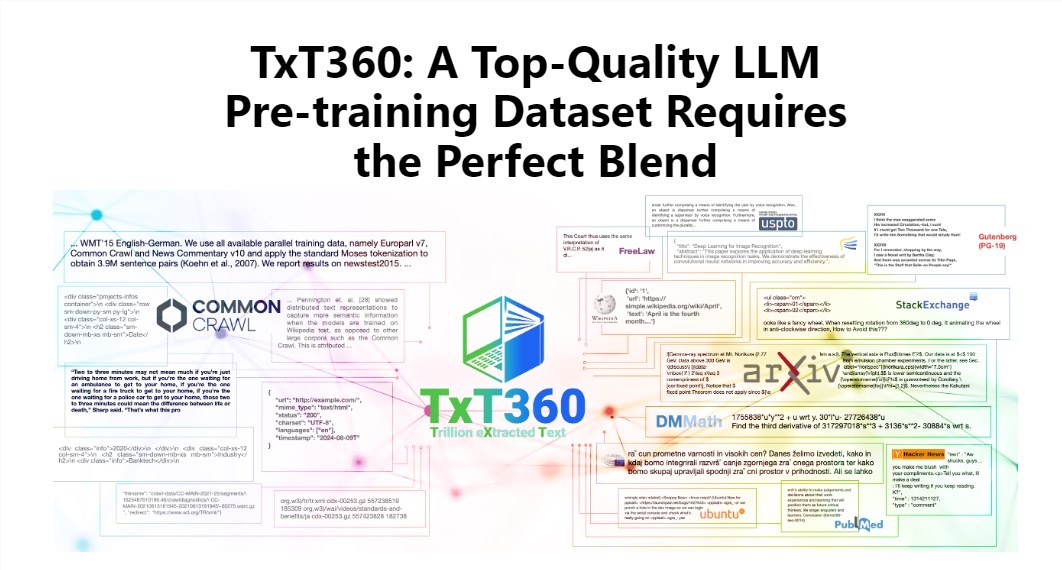

¡El editor de Downcodes lo llevará a conocer el último conjunto de datos TxT360 publicado por LLM360! Se trata de un enorme conjunto de datos con 5,7 billones de tokens de alta calidad, especialmente diseñado para el entrenamiento de modelos de lenguaje de gran tamaño. No sólo tiene una escala enorme, sino que también es de una calidad extremadamente alta, superando con creces los conjuntos de datos existentes como FineWeb y RedPajama. TxT360 extrae la esencia de Internet de 99 instantáneas de rastreo común y selecciona especialmente 14 fuentes de datos de alta calidad, como documentos legales y enciclopedias, para garantizar la diversidad y confiabilidad de los datos. Más importante aún, proporciona "recetas de ajuste de peso de datos" que permiten a los usuarios ajustar de manera flexible los pesos de diferentes fuentes de datos y controlar los datos con tanta precisión como cocinar.

El encanto de TxT360 radica en su escala ultragrande y su calidad ultraalta, que supera por completo a los conjuntos de datos existentes como FineWeb y RedPajama. Este conjunto de datos captura la esencia de Internet a partir de 99 instantáneas de rastreo común y también selecciona especialmente 14 fuentes de datos de alta calidad, como documentos legales y enciclopedias, para que su contenido no solo sea rico y diverso, sino también bastante confiable.

Lo que es aún mejor es que TxT360 proporciona a los usuarios una "receta de ajuste de peso de datos" que les permite ajustar de manera flexible los pesos de diferentes fuentes de datos según sus necesidades. Esto es como cuando cocinas, puedes mezclar varios ingredientes según tu gusto para asegurarte de que cada bocado quede delicioso.

Por supuesto, la tecnología de deduplicación también es un punto destacado de TxT360. A través de complejas operaciones de deduplicación, este conjunto de datos resuelve efectivamente el problema de la redundancia de datos y la duplicación de información durante el proceso de capacitación, asegurando que cada token sea único. Al mismo tiempo, el equipo del proyecto también utilizó expresiones regulares para eliminar inteligentemente información de identificación personal, como correos electrónicos y direcciones IP, de los documentos para garantizar la privacidad y seguridad de los datos.

TxT360 fue diseñado teniendo en cuenta la calidad y la escala. Combinando las ventajas de los datos de red y las fuentes de datos seleccionadas, permite a los investigadores controlar con precisión el uso y la distribución de los datos, como si tuvieran un control remoto mágico que puede ajustar la proporción de datos a voluntad.

En términos de efecto de entrenamiento, el TxT360 no se queda atrás. Utiliza una estrategia de muestreo simple para aumentar considerablemente la cantidad de datos y, finalmente, crear un conjunto de datos de más de 15 billones de tokens. En una serie de indicadores de evaluación clave, TxT360 se desempeña mejor que FineWeb, especialmente en campos como MMLU y NQ, y muestra una sólida capacidad de aprendizaje. Cuando se combina con datos de código (como Stack V2), la curva de aprendizaje es más estable y el rendimiento del modelo mejora significativamente.

Introducción detallada: https://huggingface.co/spaces/LLM360/TxT360

Con todo, la aparición del conjunto de datos TxT360 proporciona nuevas posibilidades para el entrenamiento de modelos de lenguaje grandes. Su gran escala, datos de alta calidad y funciones flexibles de ajuste de peso de datos sin duda promoverán un mayor desarrollo de la tecnología de modelos de lenguaje grandes. Para obtener más información, visite el enlace para obtener una introducción detallada.