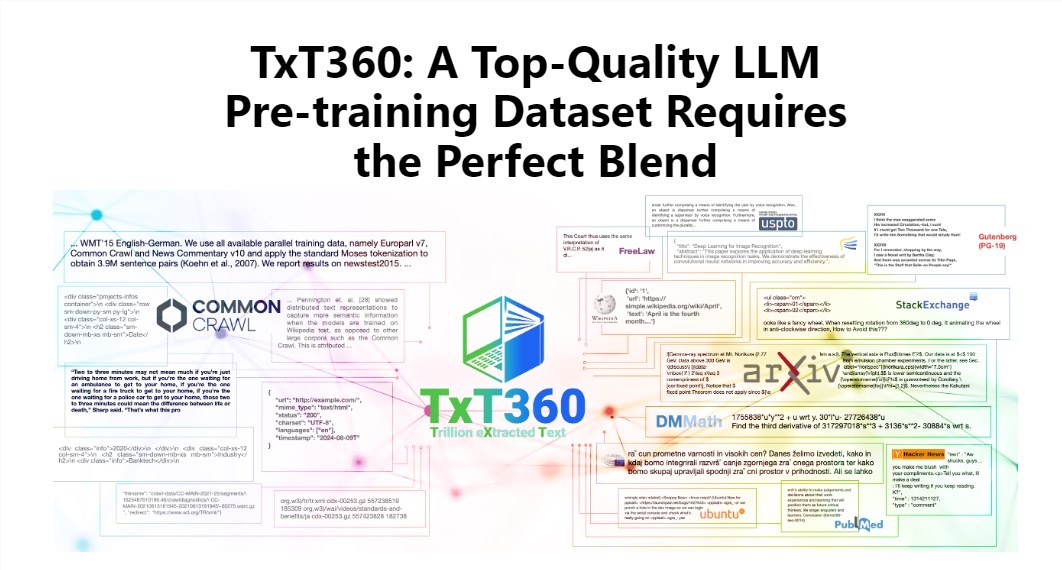

L'éditeur de Downcodes vous fera découvrir le dernier ensemble de données TxT360 publié par LLM360 ! Il s'agit d'un énorme ensemble de données comprenant 5,7 billions de jetons de haute qualité, spécialement conçus pour la formation de grands modèles de langage. Non seulement son échelle est énorme, mais elle est également d’une qualité extrêmement élevée, dépassant de loin les ensembles de données existants tels que FineWeb et RedPajama. TxT360 extrait l'essence d'Internet à partir de 99 instantanés Common Crawl et sélectionne spécialement 14 sources de données de haute qualité, telles que des documents juridiques et des encyclopédies, pour garantir la diversité et la fiabilité des données. Plus important encore, il fournit des « recettes d'ajustement du poids des données » qui permettent aux utilisateurs d'ajuster de manière flexible les poids de différentes sources de données et de contrôler les données aussi finement que la cuisson.

Le charme de TxT360 réside dans sa très grande échelle et sa très haute qualité, qui surpassent complètement les ensembles de données existants tels que FineWeb et RedPajama. Cet ensemble de données capture l'essence d'Internet à partir de 99 instantanés Common Crawl et sélectionne également spécialement 14 sources de données de haute qualité, telles que des documents juridiques et des encyclopédies, pour rendre son contenu non seulement riche et diversifié, mais également assez fiable.

Ce qui est encore plus cool, c'est que TxT360 fournit aux utilisateurs une « recette d'ajustement du poids des données » qui vous permet d'ajuster de manière flexible les poids des différentes sources de données en fonction de vos besoins. C'est comme lorsque vous cuisinez, vous pouvez mélanger divers ingrédients selon vos goûts pour vous assurer que chaque bouchée est délicieuse.

Bien entendu, la technologie de déduplication est également un point fort de TxT360. Grâce à des opérations de déduplication complexes, cet ensemble de données résout efficacement le problème de la redondance des données et de la duplication des informations pendant le processus de formation, garantissant que chaque jeton est unique. Dans le même temps, l'équipe du projet a également utilisé des expressions régulières pour supprimer intelligemment les informations personnelles identifiables, telles que les e-mails et les adresses IP, des documents afin de garantir la confidentialité et la sécurité des données.

Le TxT360 a été conçu dans un souci de qualité et d'échelle. Combinant les avantages des données en réseau et des sources de données organisées, il permet aux chercheurs de contrôler avec précision l’utilisation et la distribution des données, tout comme s’ils disposaient d’une télécommande magique capable d’ajuster la proportion de données à volonté.

En termes d’effet d’entraînement, le TxT360 n’est pas en reste. Il utilise une stratégie de suréchantillonnage simple pour augmenter considérablement la quantité de données, créant finalement un ensemble de données de plus de 15 000 milliards de jetons. Dans une série d'indicateurs d'évaluation clés, TxT360 obtient de meilleurs résultats que FineWeb, en particulier dans des domaines tels que MMLU et NQ, démontrant de solides capacités d'apprentissage. Lorsqu'elle est combinée avec des données de code (telles que Stack V2), la courbe d'apprentissage est plus stable et les performances du modèle sont considérablement améliorées.

Introduction détaillée : https://huggingface.co/spaces/LLM360/TxT360

Dans l'ensemble, l'émergence de l'ensemble de données TxT360 offre de nouvelles possibilités pour la formation de grands modèles de langage. Ses données à grande échelle, de haute qualité et ses fonctions flexibles d'ajustement du poids des données favoriseront sans aucun doute le développement ultérieur de la technologie des grands modèles de langage. Pour plus d’informations, veuillez visiter le lien pour une introduction détaillée !