ส่วนแรกของทรัพยากรกลุ่มนี้สรุปทรัพยากรที่ใช้ในการแก้ปัญหาการสร้างข้อความโดยใช้โมเดลภาษา GPT2 รวมถึงเอกสารรหัสการสาธิตการสาธิตและแบบฝึกหัดบนมือ ส่วนที่สองแสดงแอปพลิเคชันของ GPT2 ในงานสร้างข้อความของการแปลเครื่องการสร้างการสรุปอัตโนมัติการเรียนรู้การย้ายถิ่นและการสร้างดนตรี ในที่สุดมีการเปรียบเทียบโมเดลภาษาหลัก 15 แบบที่อิงจากหม้อแปลงระหว่างปี 2561 ถึง 2562

ส่วนแรกของการรวบรวมทรัพยากรนี้สรุปทรัพยากรที่ใช้ในการแก้ปัญหาการสร้างข้อความโดยใช้โมเดลภาษา GPT2 รวมถึงเอกสารรหัสการสาธิตการนำเสนอและแบบฝึกหัดบนมือ ส่วนที่สองแสดงแอปพลิเคชันของ GPT2 ในงานสร้างข้อความเช่นการแปลเครื่องการสร้างสรุปอัตโนมัติการเรียนรู้การถ่ายโอนและการสร้างเพลง ในที่สุดเราเปรียบเทียบโมเดลภาษาที่สำคัญ 15 แบบตามหม้อแปลงตั้งแต่ปี 2561 ถึง 2562

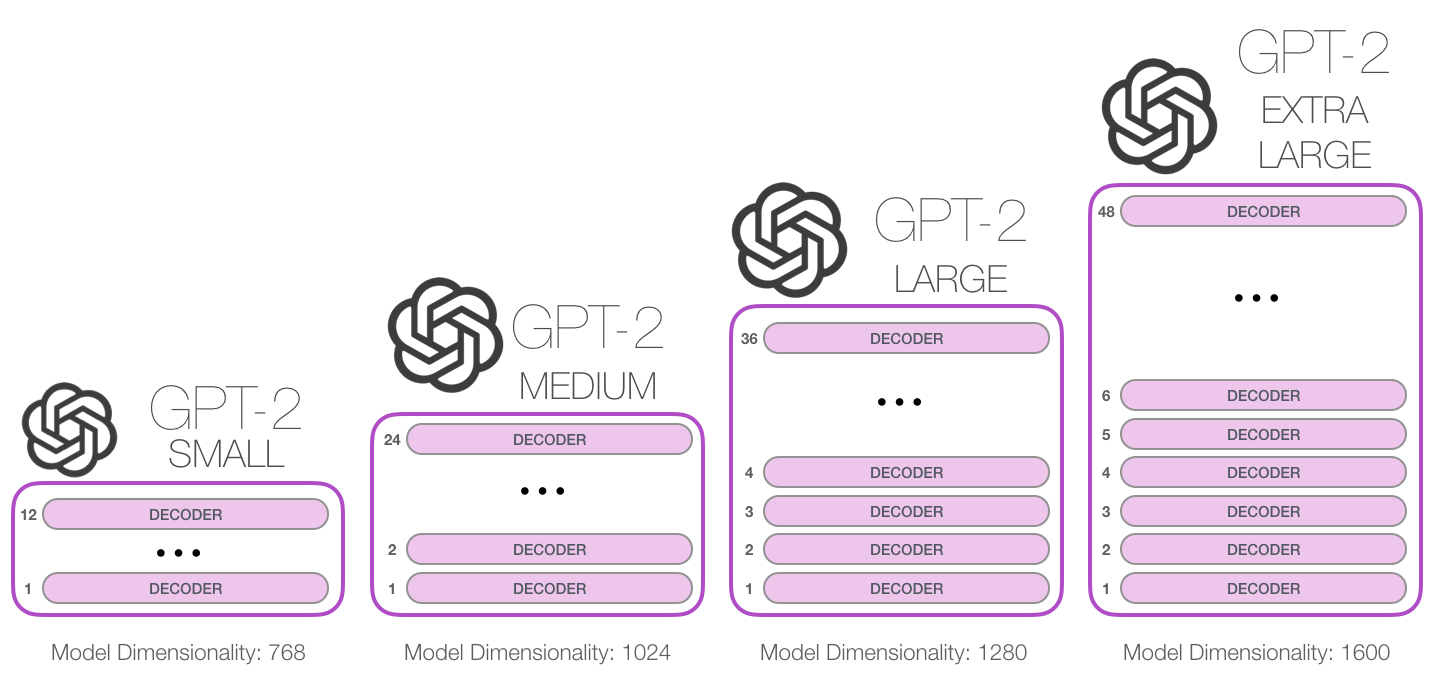

GPT-2 เป็นรูปแบบภาษาที่ใช้หม้อแปลงขนาดใหญ่ที่เปิดตัวโดย OpenAI ในเดือนกุมภาพันธ์ 2019 มีพารามิเตอร์ 1.5 พันล้านพารามิเตอร์และได้รับการฝึกฝนในชุดข้อมูลเว็บ 8 ล้านชุด ตามรายงานโมเดลเป็นส่วนขยายโดยตรงของโมเดล GPT การฝึกอบรมมากกว่า 10 เท่าของปริมาณข้อมูลจำนวนพารามิเตอร์ก็เพิ่มขึ้น 10 เท่า ในแง่ของประสิทธิภาพโมเดลมีความสามารถในการสร้างย่อหน้าข้อความพิกัดและบรรลุประสิทธิภาพของ SOTA ในมาตรฐานการสร้างแบบจำลองภาษาจำนวนมาก นอกจากนี้โมเดลสามารถดำเนินการอ่านเบื้องต้นการอ่านการแปลของเครื่องคำถามและคำตอบและสรุปอัตโนมัติโดยไม่ต้องฝึกอบรมเฉพาะงาน

GPT-2 เป็นรูปแบบภาษาที่ใช้หม้อแปลงขนาดใหญ่ที่เปิดตัวโดย OpenAI ในเดือนกุมภาพันธ์ 2019 มีพารามิเตอร์ 1.5 พันล้านพารามิเตอร์และได้รับการฝึกฝนในชุดข้อมูลหน้าเว็บ 8 ล้าน ตามรายงานโมเดลนี้เป็นส่วนขยายโดยตรงของโมเดล GPT ได้รับการฝึกฝนมากกว่า 10 เท่าของปริมาณข้อมูลและจำนวนพารามิเตอร์มากกว่า 10 เท่า ในแง่ของประสิทธิภาพโมเดลสามารถสร้างย่อหน้าข้อความที่สอดคล้องกันและบรรลุประสิทธิภาพของ SOTA ในมาตรฐานการสร้างแบบจำลองภาษาจำนวนมาก ยิ่งไปกว่านั้นแบบจำลองสามารถบรรลุความเข้าใจในการอ่านเบื้องต้นการแปลของเครื่องการตอบคำถามและคำตอบและสรุปอัตโนมัติโดยไม่ต้องฝึกอบรมเฉพาะงาน

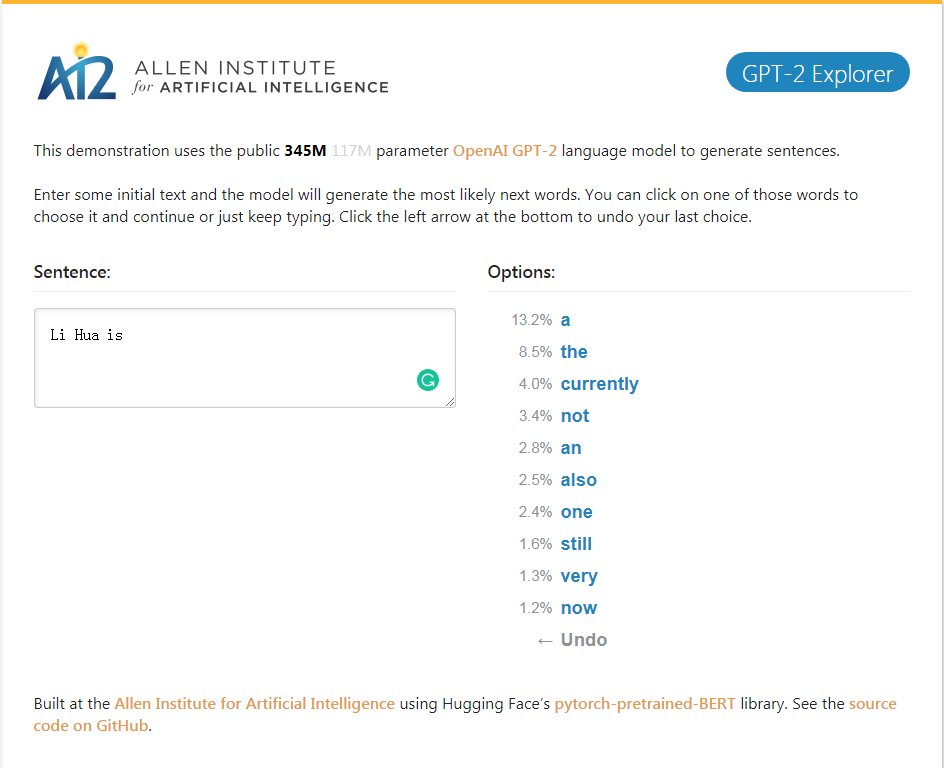

การสาธิต GPT-2_Explorer สามารถให้คำอีกสิบคำต่อไปของการจัดอันดับความเป็นไปได้และความน่าจะเป็นที่สอดคล้องกันตามข้อความอินพุตในปัจจุบัน คุณสามารถเลือกคำใดคำหนึ่งจากนั้นดูรายการของคำที่เป็นไปได้ถัดไปและอื่น ๆ และในที่สุดก็เสร็จสมบูรณ์ บทความ.

การสาธิต GPT-2_Explorer สามารถให้คำศัพท์สิบอันดับแรกในช่วงที่เป็นไปได้และความน่าจะเป็นที่สอดคล้องกันตามข้อความที่ป้อนในปัจจุบัน คุณสามารถเลือกหนึ่งคำและดูรายการคำที่เป็นไปได้ถัดไป สิ่งนี้จะถูกทำซ้ำซ้ำแล้วซ้ำอีกและในที่สุดก็ทำบทความให้เสร็จ

คลิกเพื่อสาธิต GPT-2 Explorer

แพ็คเกจ GPT-2-Simple Python เพื่อขึ้นรูปแบบการสร้างข้อความ GPT-2 ของ OpenAI บนข้อความใหม่ได้อย่างง่ายดาย

แพ็คเกจ GPT-2-Simple Python สามารถสร้างโมเดลการสร้างข้อความ GPT-2 ของ OpenAI บนข้อความใหม่ได้อย่างง่ายดาย

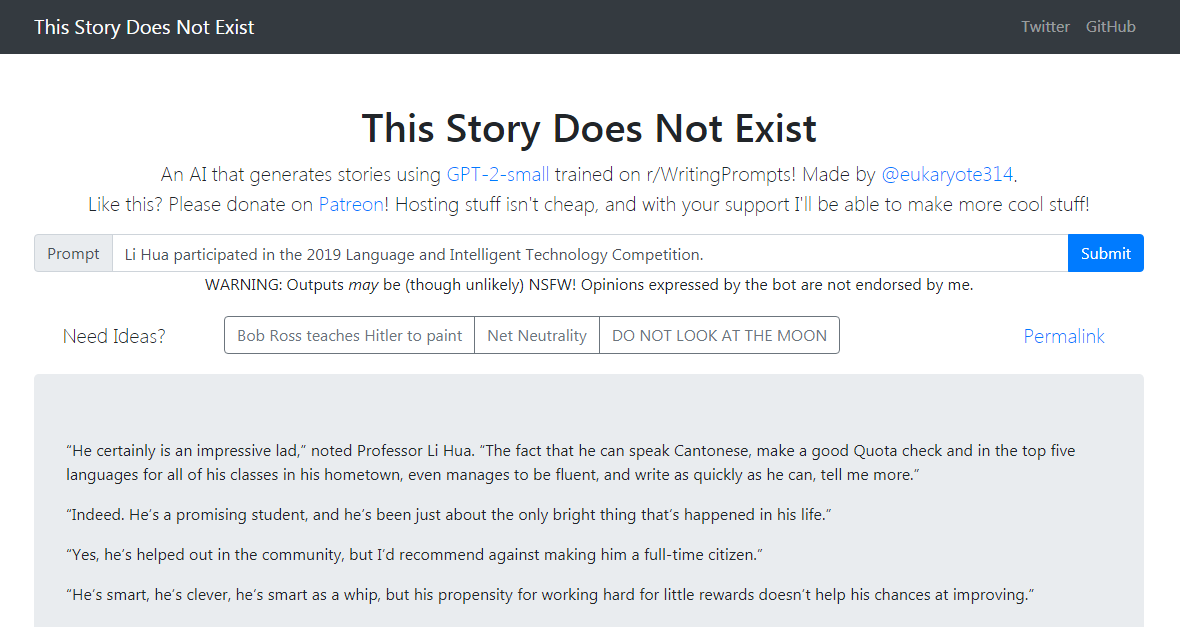

การสาธิต GPT-2-Simple เขียนเรื่องราวการติดตามตามข้อความอินพุตปัจจุบัน การสาธิต GPT-2-Simple เขียนเรื่องราวการติดตามตามข้อความอินพุตปัจจุบัน

คลิกเพื่อสัมผัสประสบการณ์คลิกเพื่อสาธิต GPT-2-Simple

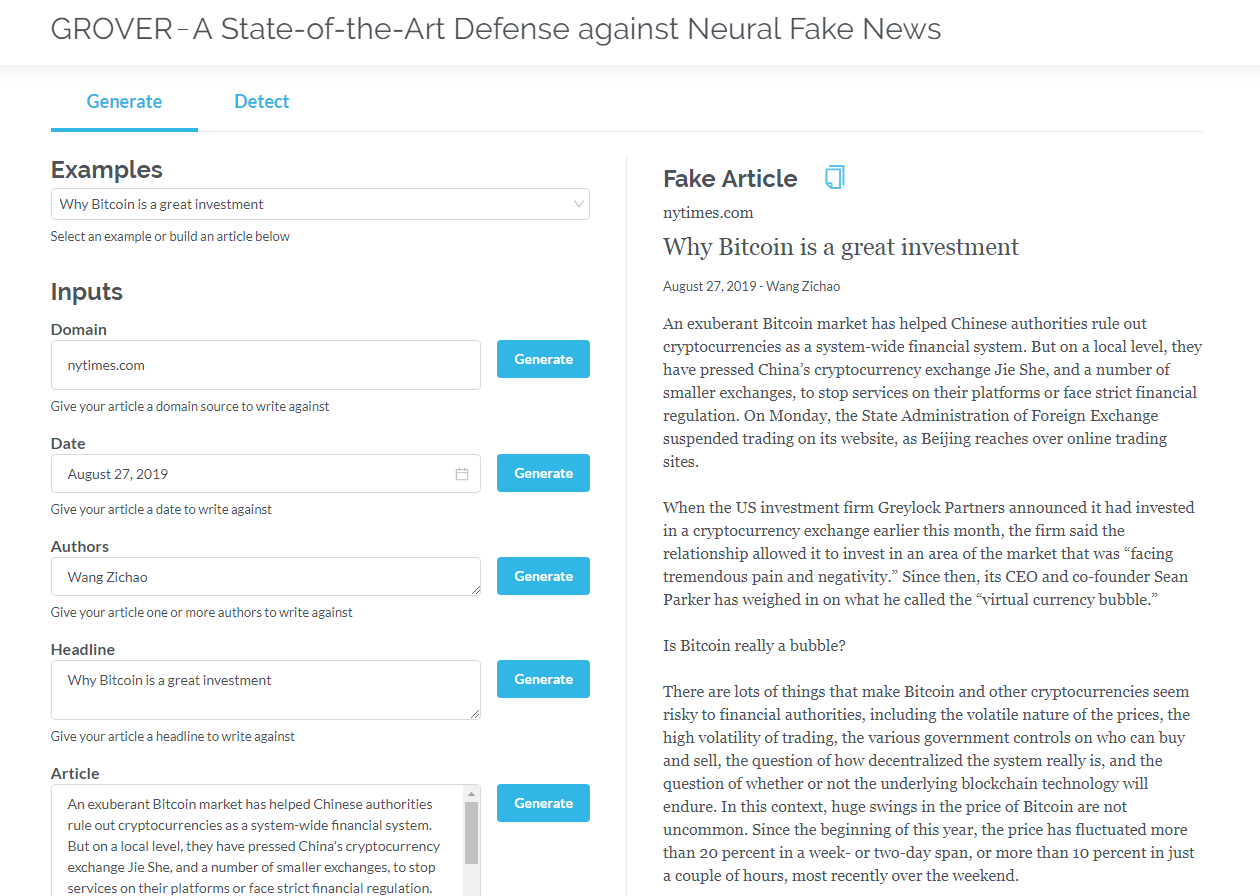

Grover เป็นแบบอย่างสำหรับข่าวปลอมของระบบประสาท - ทั้งรุ่นและการตรวจจับ Grover เป็นแบบอย่างสำหรับข่าวปลอม - การสร้างและการตรวจจับ

สร้างบทความตามข้อมูลเช่นชื่อเรื่องผู้แต่งและอื่น ๆ โกรเวอร์ยังสามารถตรวจจับได้ว่าข้อความถูกสร้างขึ้นโดยเครื่องหรือไม่

สร้างบทความตามชื่อเรื่องผู้แต่งและข้อมูลอื่น ๆ โกรเวอร์ยังสามารถตรวจพบว่าข้อความถูกสร้างขึ้นโดยเครื่องหรือไม่

คลิกเพื่อโกรเวอร์

คลิกเพื่ออ่านเวอร์ชันภาษาอังกฤษ

Transformers ที่มีเฉพาะตัวถอดรหัส (เช่น GPT2) แสดงโอกาสในการสร้างแอปพลิเคชันนอกการสร้างแบบจำลองภาษา ในหลายแอปพลิเคชันโมเดลดังกล่าวประสบความสำเร็จ: การแปลของเครื่อง, การสร้างสรุปอัตโนมัติ, การเรียนรู้การถ่ายโอนและการสร้างเพลง ลองตรวจสอบแอปพลิเคชันเหล่านี้ด้วยกัน

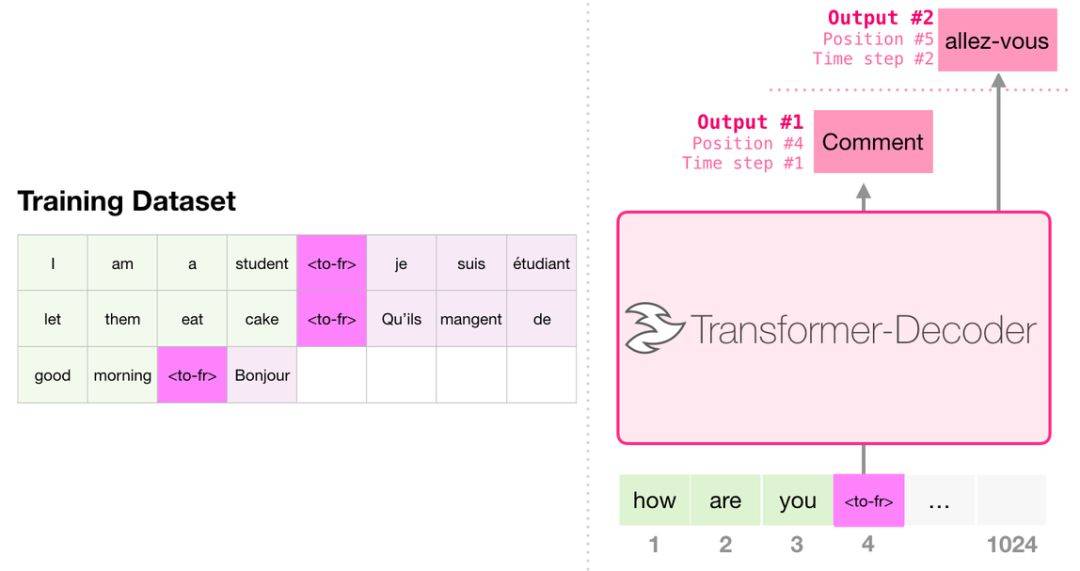

เมื่อแปลโมเดลไม่จำเป็นต้องมีตัวเข้ารหัส งานเดียวกันสามารถแก้ไขได้โดยหม้อแปลงที่มีตัวถอดรหัสเท่านั้น:

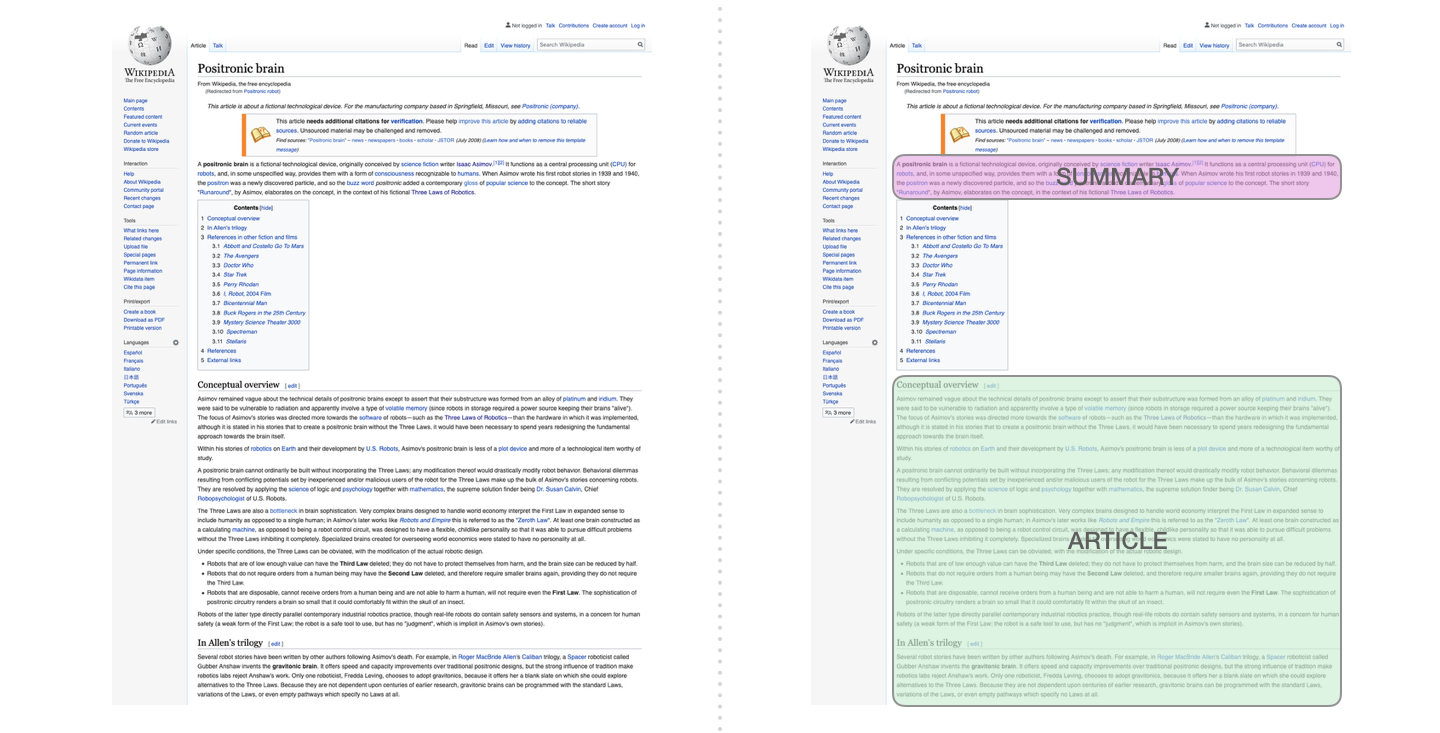

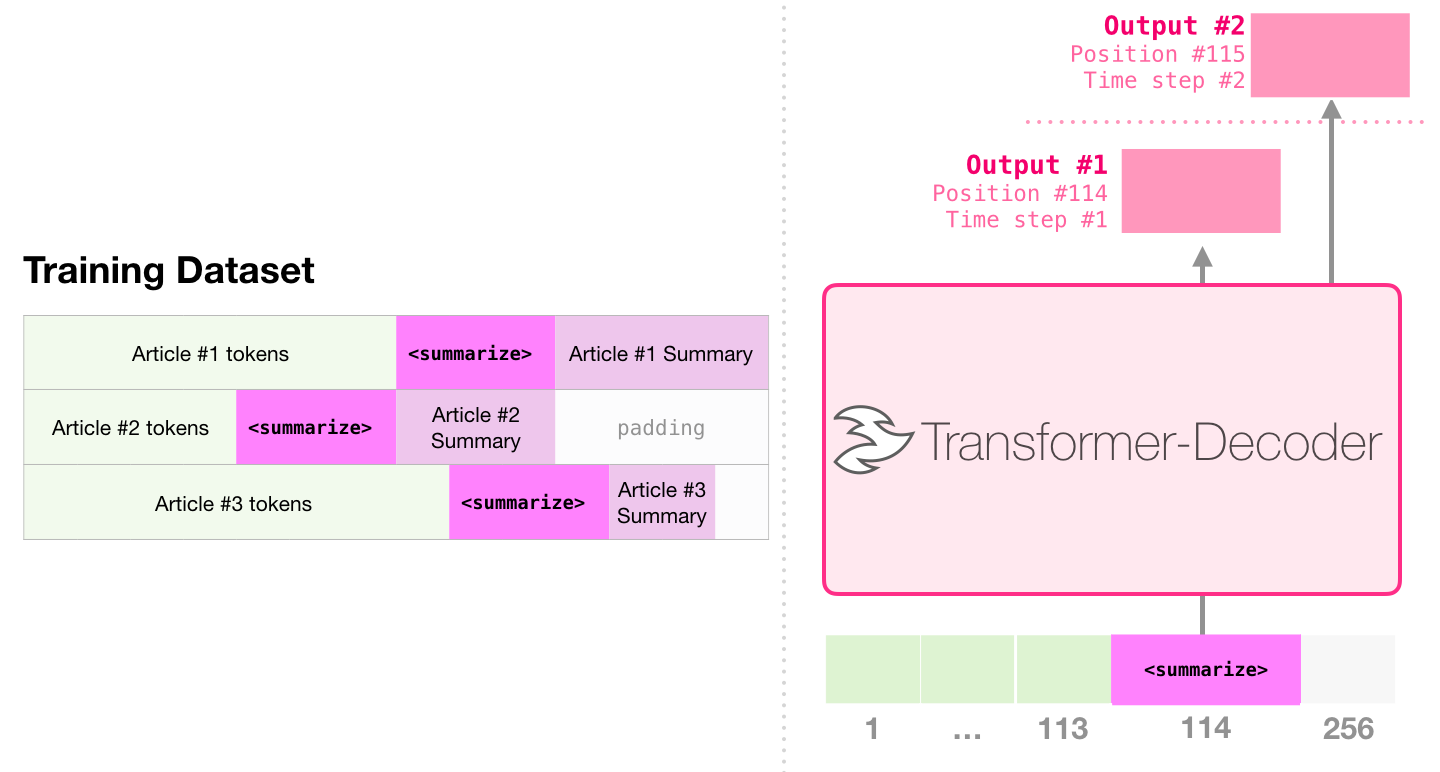

นี่เป็นงานแรกในการฝึกอบรมหม้อแปลงที่มีตัวถอดรหัสเท่านั้น นั่นคือโมเดลได้รับการฝึกฝนให้อ่านบทความ Wikipedia (โดยไม่มีจุดเริ่มต้นของไดเรกทอรี) จากนั้นสร้างบทสรุป จุดเริ่มต้นที่แท้จริงของบทความใช้เป็นฉลากสำหรับชุดข้อมูลการฝึกอบรม:

กระดาษใช้บทความ Wikipedia เพื่อฝึกอบรมแบบจำลองและแบบจำลองที่ผ่านการฝึกอบรมสามารถสร้างบทคัดย่อของบทความ:

ในตัวอย่างการสรุปข้อความที่มีประสิทธิภาพโดยใช้หม้อแปลงที่ผ่านการฝึกอบรมมาก่อนการฝึกอบรมก่อนการฝึกอบรมครั้งแรกจะดำเนินการในงานการสร้างแบบจำลองภาษาโดยใช้หม้อแปลงที่มีตัวถอดรหัสเท่านั้นและจากนั้นงานการสร้างสรุปจะเสร็จสิ้นผ่านการปรับแต่ง ผลลัพธ์แสดงให้เห็นว่าในกรณีของข้อมูลที่ จำกัด รูปแบบนี้จะได้ผลลัพธ์ที่ดีกว่าหม้อแปลงเครื่องเข้ารหัสเครื่องเข้ารหัส กระดาษของ GPT2 ยังแสดงให้เห็นถึงเอฟเฟกต์การสร้างนามธรรมที่ได้รับหลังจากฝึกอบรมแบบจำลองภาษาก่อน

Music Transformer ใช้ Transformers ที่มีตัวถอดรหัสเพื่อสร้างเพลงที่มีจังหวะและพลวัต เช่นเดียวกับการสร้างแบบจำลองภาษา "การสร้างแบบจำลองเพลง" คือการให้แบบจำลองเรียนรู้เพลงในแบบที่ไม่ได้รับการดูแลแล้วปล่อยให้ตัวอย่างส่งออก (ก่อนหน้านี้เราเรียกว่า "งานสุ่ม")

GPT2 เป็นเพียงหยดในมหาสมุทรของโมเดลที่ใช้หม้อแปลง สำหรับการเปรียบเทียบโมเดลที่ใช้หม้อแปลงที่สำคัญ 15 แบบตั้งแต่ปี 2561-2562 โปรดดูที่ยุคหลังเบิร์ต: การวิเคราะห์เปรียบเทียบแบบจำลอง 15 แบบที่ผ่านการฝึกอบรมมาก่อนและการสำรวจประเด็นสำคัญ