A primeira parte deste resumo do pool de recursos os recursos usados para resolver tarefas de geração de texto usando o modelo de idioma GPT2, incluindo papéis, código, demonstrações de demonstração e tutoriais práticos. A segunda parte mostra a aplicação do GPT2 nas tarefas de geração de texto da tradução da máquina, geração de resumo automático, aprendizado de migração e geração de música. Finalmente, os 15 principais modelos de idiomas baseados no transformador entre 2018 e 2019 são comparados.

A primeira parte desta coleção de recursos resume os recursos usados para resolver tarefas de geração de texto usando o modelo de idioma GPT2, incluindo papéis, código, demos de apresentação e tutoriais práticos. A segunda parte mostra a aplicação do GPT2 em tarefas de geração de texto, como tradução para a máquina, geração automática de resumo, aprendizado de transferência e geração de música. Finalmente, comparamos os 15 importantes modelos de idiomas baseados no Transformer de 2018 a 2019.

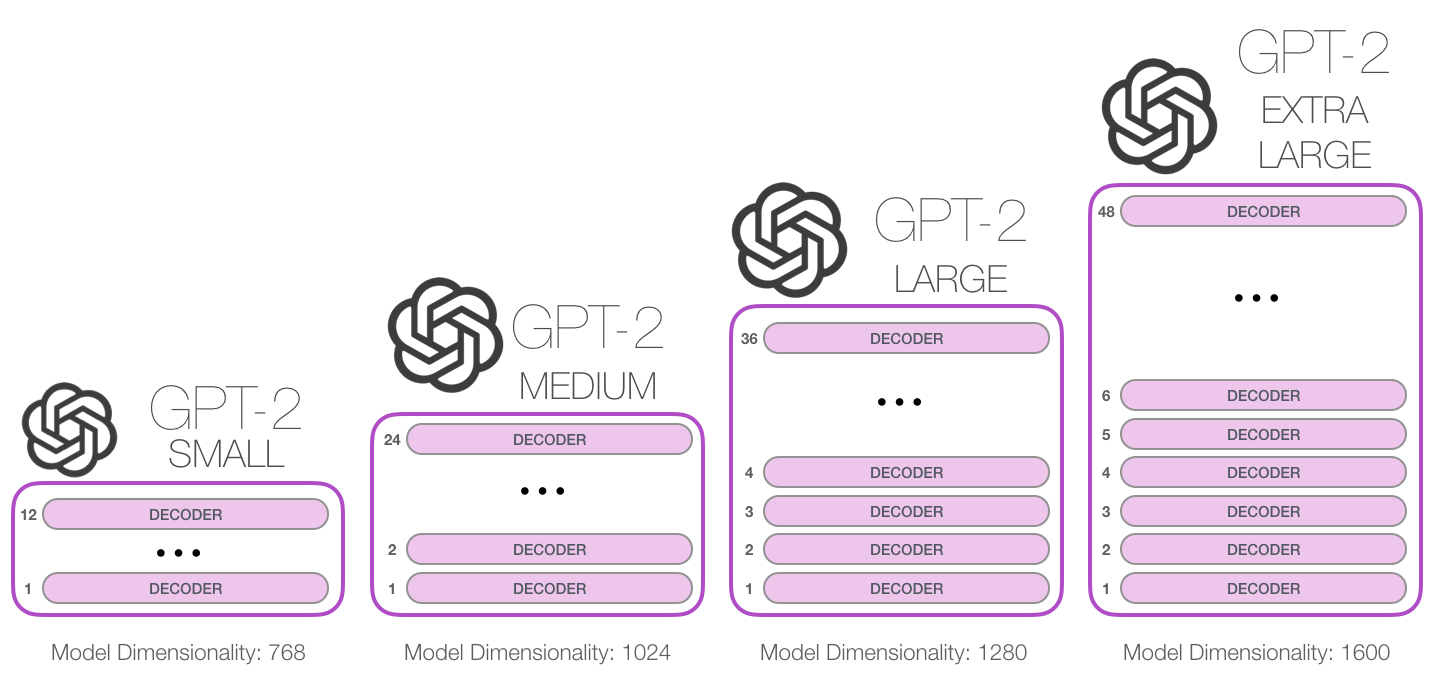

O GPT-2 é um grande modelo de idioma baseado em transformador divulgado pelo OpenAI em fevereiro de 2019. Ele contém 1,5 bilhão de parâmetros e é treinado em um conjunto de dados da Web de 8 milhões. Segundo relatos, o modelo é uma extensão direta do modelo GPT, treinamento em mais de 10 vezes a quantidade de dados, a quantidade de parâmetro também é 10 vezes mais. Em termos de desempenho, o modelo é capaz de produzir parágrafos de texto de coordenadas e atinge o desempenho do SOTA em muitos benchmarks de modelagem de idiomas. Além disso, o modelo pode realizar a compreensão preliminar da leitura, a tradução da máquina, a pergunta e a resposta e o resumo automático sem treinamento específico da tarefa.

O GPT-2 é um grande modelo de idioma baseado em transformador lançado pelo OpenAI em fevereiro de 2019. Ele contém 1,5 bilhão de parâmetros e é treinado em um conjunto de dados de 8 milhões de páginas da web. Segundo relatos, esse modelo é uma extensão direta do modelo GPT, treinada em mais de 10 vezes a quantidade de dados, e o número de parâmetros é 10 vezes mais. Em termos de desempenho, o modelo é capaz de produzir parágrafos coerentes de texto e atinge o desempenho do SOTA em muitos benchmarks de modelagem de idiomas. Além disso, o modelo pode obter compreensão preliminar de leitura, tradução de máquinas, questões e respostas e resumo automático sem treinamento específico da tarefa.

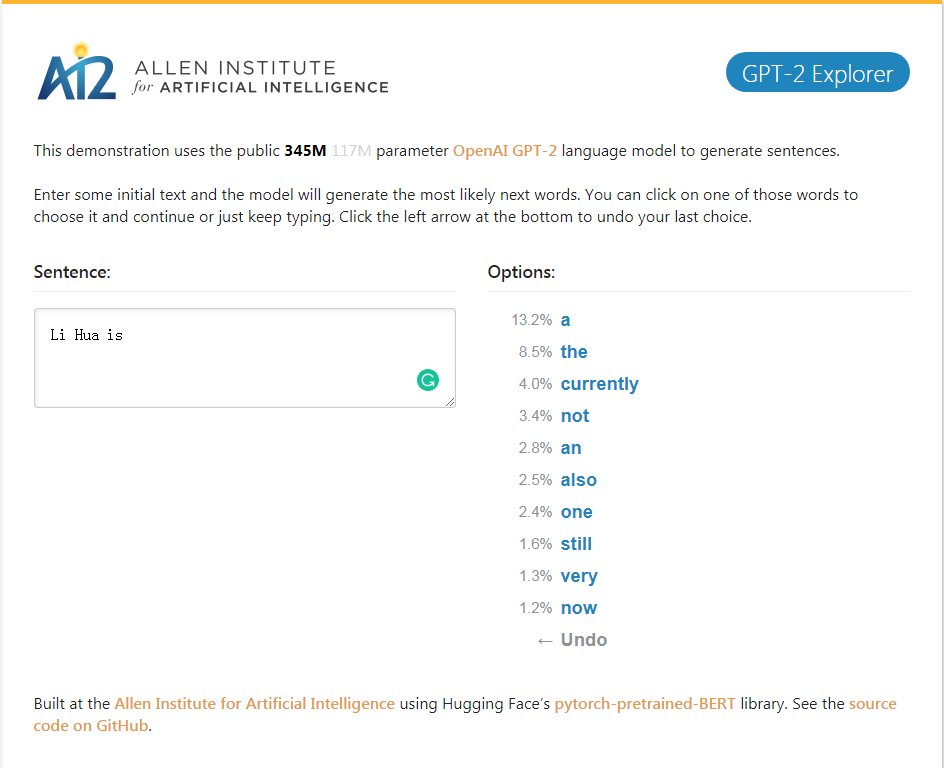

GPT-2_EXPLORER Demo, pode dar as próximas dez palavras da classificação da possibilidade e suas probabilidades correspondentes de acordo com o texto de entrada atualmente. Você pode selecionar uma das palavras e ver a lista da próxima palavra possível e assim por diante e finalmente concluir uma. Artigo.

GPT-2_Explorer Demo, ele pode dar o Top Ten Next Word no intervalo possível e sua probabilidade correspondente com base no texto inserido atualmente. Você pode selecionar uma das palavras e ver uma lista das próximas palavras possíveis. Isso será repetido repetidamente e finalmente concluirá um artigo.

Clique na demonstração do GPT-2 Explorer

Pacote Python GPT-2-Simple para restringir facilmente o modelo de geração de textos GPT-2 do OpenAI em novos textos.

O pacote Python GPT-2-Simple pode facilmente treinar o modelo de geração de texto GPT-2 do OpenAI no novo texto.

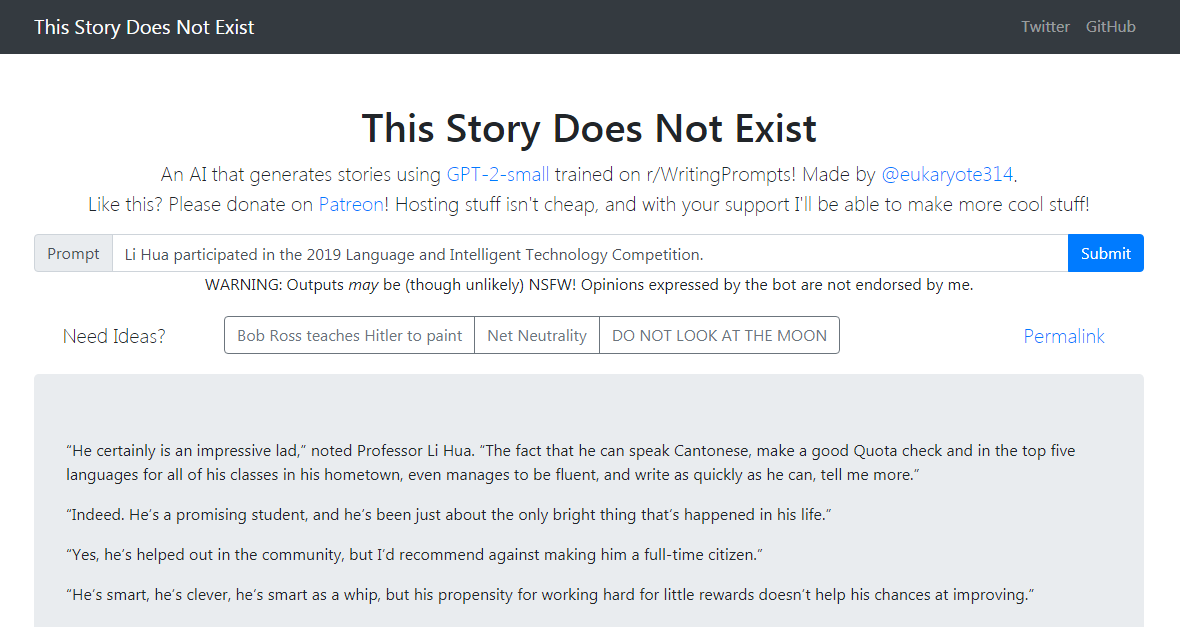

O GPT-2-Simple Demo escreve uma história de acompanhamento baseada no texto de entrada atual. O GPT-2-Simple Demo escreve uma história de acompanhamento baseada no texto de entrada atual.

Clique para experimentar clique na demonstração do GPT-2-Simple

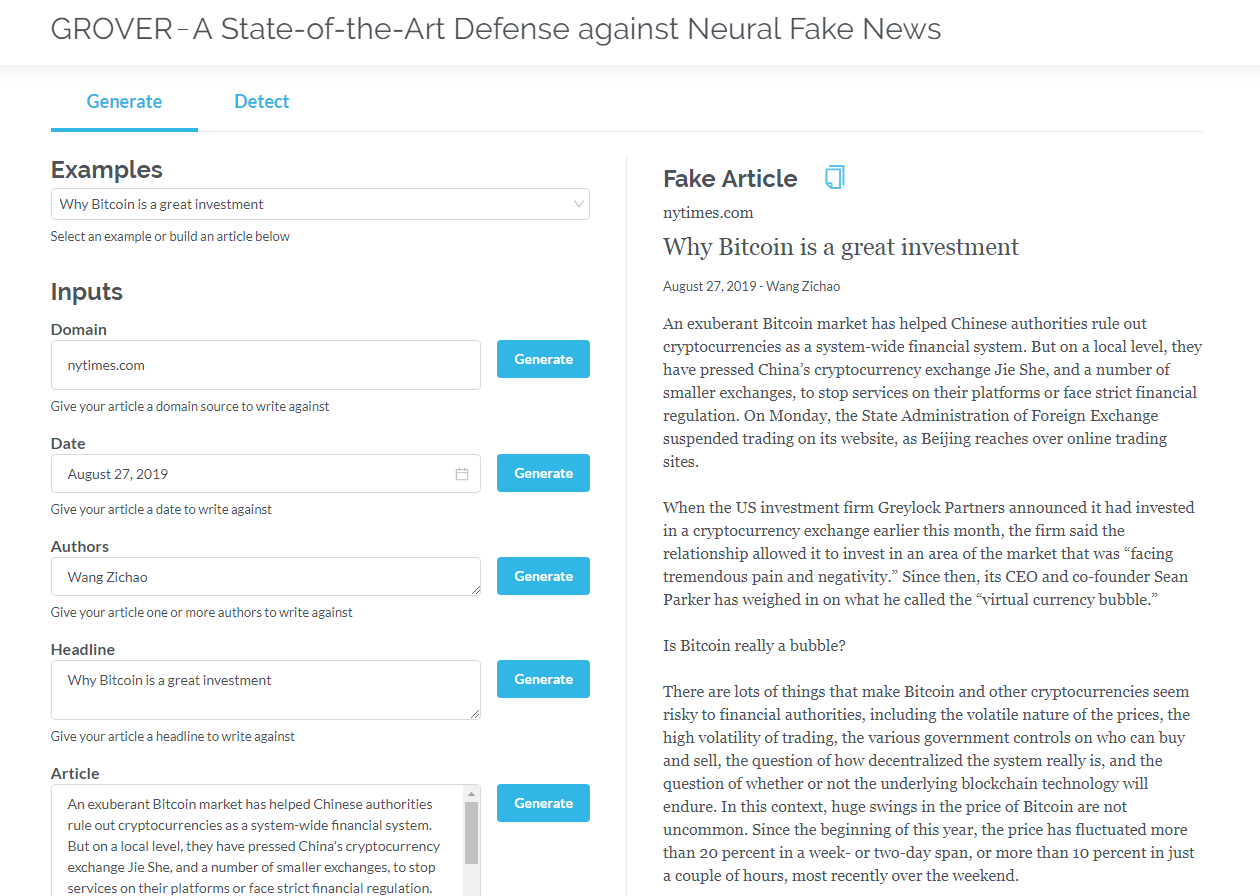

Grover é um modelo para notícias falsas neurais - geração e detecção. Grover é um modelo para notícias falsas neurais - geração e detecção.

Gere artigos com base em informações como título, autor e muito mais. Grover também pode detectar se o texto é gerado pela máquina.

Gere artigos com base no título, autor e outras informações. Grover também pode detectar se o texto é gerado pela máquina.

Clique para Grover

Clique para ler a versão em inglês

Transformadores que contêm apenas decodificadores (como GPT2) mostram constantemente as perspectivas de aplicativos fora da modelagem de idiomas. Em muitas aplicações, esses modelos foram bem -sucedidos: tradução da máquina, geração de resumo automático, aprendizado de transferência e geração de música. Vamos revisar alguns desses aplicativos juntos.

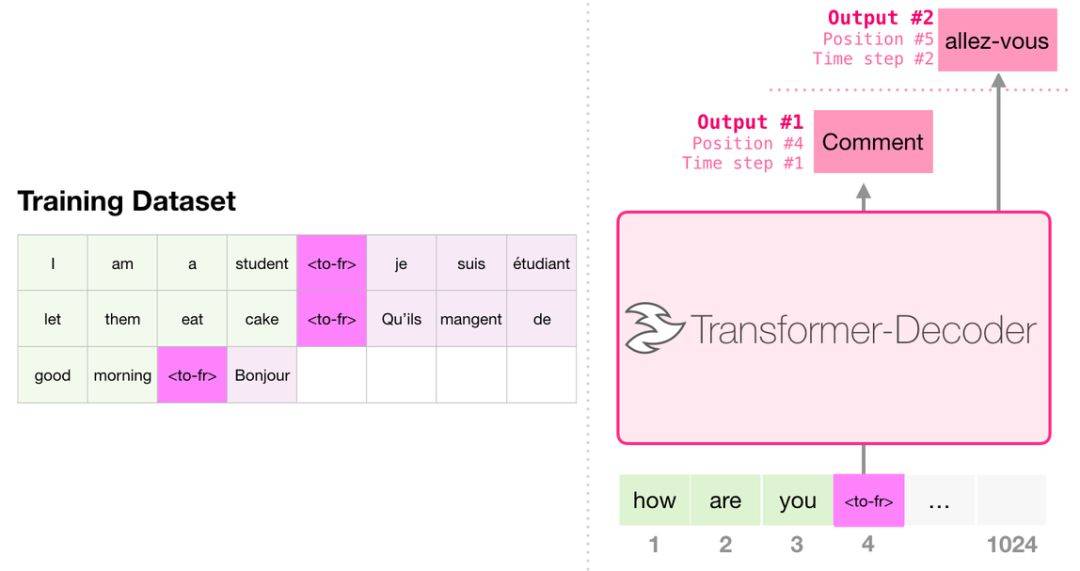

Ao traduzir, o modelo não requer um codificador. A mesma tarefa pode ser resolvida por um transformador com apenas decodificador:

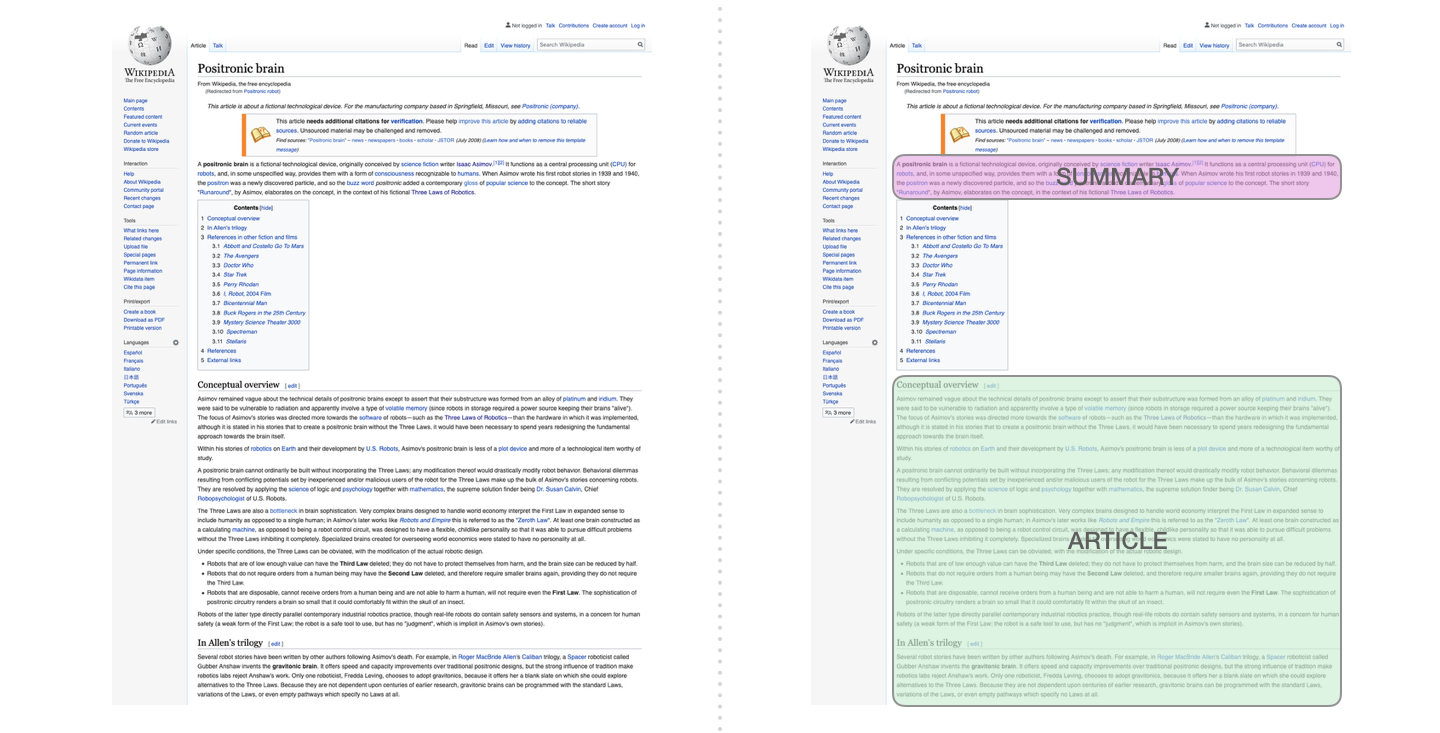

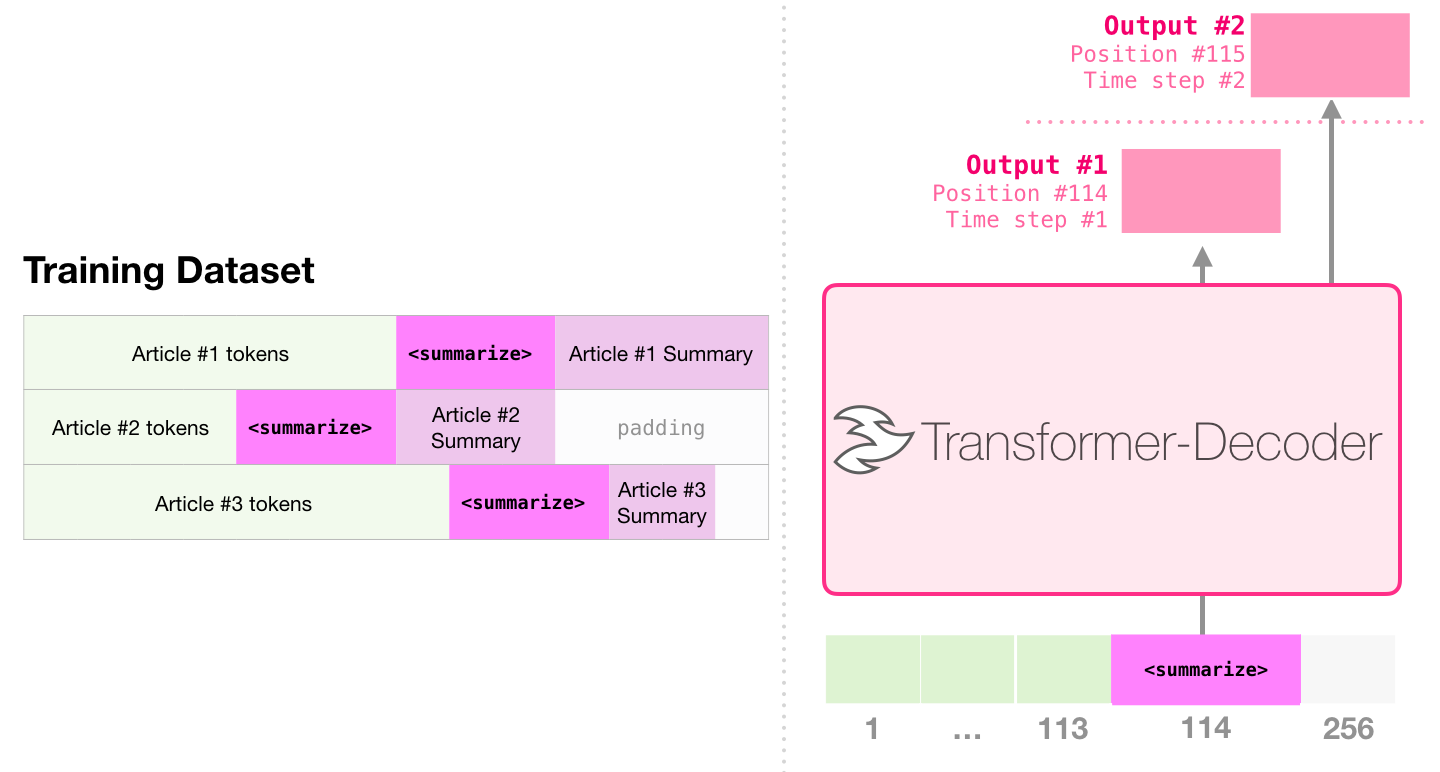

Esta é a primeira tarefa a treinar um transformador que contém apenas o decodificador. Ou seja, o modelo é treinado para ler os artigos da Wikipedia (sem o início do diretório) e, em seguida, gerar um resumo. O início real do artigo é usado como rótulo para o conjunto de dados de treinamento:

O artigo usa artigos da Wikipedia para treinar o modelo, e o modelo treinado pode gerar um resumo do artigo:

Na amostra de papel, resumo de texto eficiente usando um único transformador pré-treinado, o primeiro pré-treinamento é realizado na tarefa de modelagem de idiomas usando transformadores que contêm apenas decodificadores e, em seguida, a tarefa de geração de resumo é concluída através da ajuste. Os resultados mostram que, no caso de dados limitados, esse esquema alcança melhores resultados do que o transformador de decodificador de codificadores pré-traçado. O artigo do GPT2 também demonstra o efeito de geração abstrato obtido após o pré-treinamento do modelo de modelagem de idiomas.

O Music Transformer usa transformadores que contêm apenas decodificadores para gerar música com ritmo rico e dinâmica. Semelhante à modelagem de idiomas, "Modelagem de Música" é deixar o modelo aprender música de uma maneira não supervisionada e, em seguida, deixá -lo emitir amostras (previamente chamamos de "trabalho aleatório").

O GPT2 é apenas uma gota no oceano de modelos baseados em transformadores. Para comparações de 15 modelos importantes baseados em transformadores de 2018 a 2019, consulte a era pós-Bert: análise comparativa de 15 modelos pré-treinados e exploração de pontos-chave.