La première partie de ce résumé du pool de ressources Les ressources utilisées pour résoudre les tâches de génération de texte en utilisant le modèle de langue GPT2, y compris les articles, le code, les démos de démonstration et les didacticiels pratiques. La deuxième partie montre l'application de GPT2 dans les tâches de génération de texte de la traduction automatique, de la génération de résumé automatique, de l'apprentissage de la migration et de la génération de musique. Enfin, les 15 principaux modèles linguistiques basés sur Transformer entre 2018 et 2019 sont comparés.

La première partie de cette collection de ressources résume les ressources utilisées pour résoudre les tâches de génération de texte à l'aide du modèle de langue GPT2, y compris les articles, le code, les démos de présentation et les didacticiels pratiques. La deuxième partie montre l'application de GPT2 dans les tâches de génération de texte telles que la traduction automatique, la génération de résumé automatique, l'apprentissage du transfert et la génération de musique. Enfin, nous comparons les 15 modèles de langue importants basés sur Transformer de 2018 à 2019.

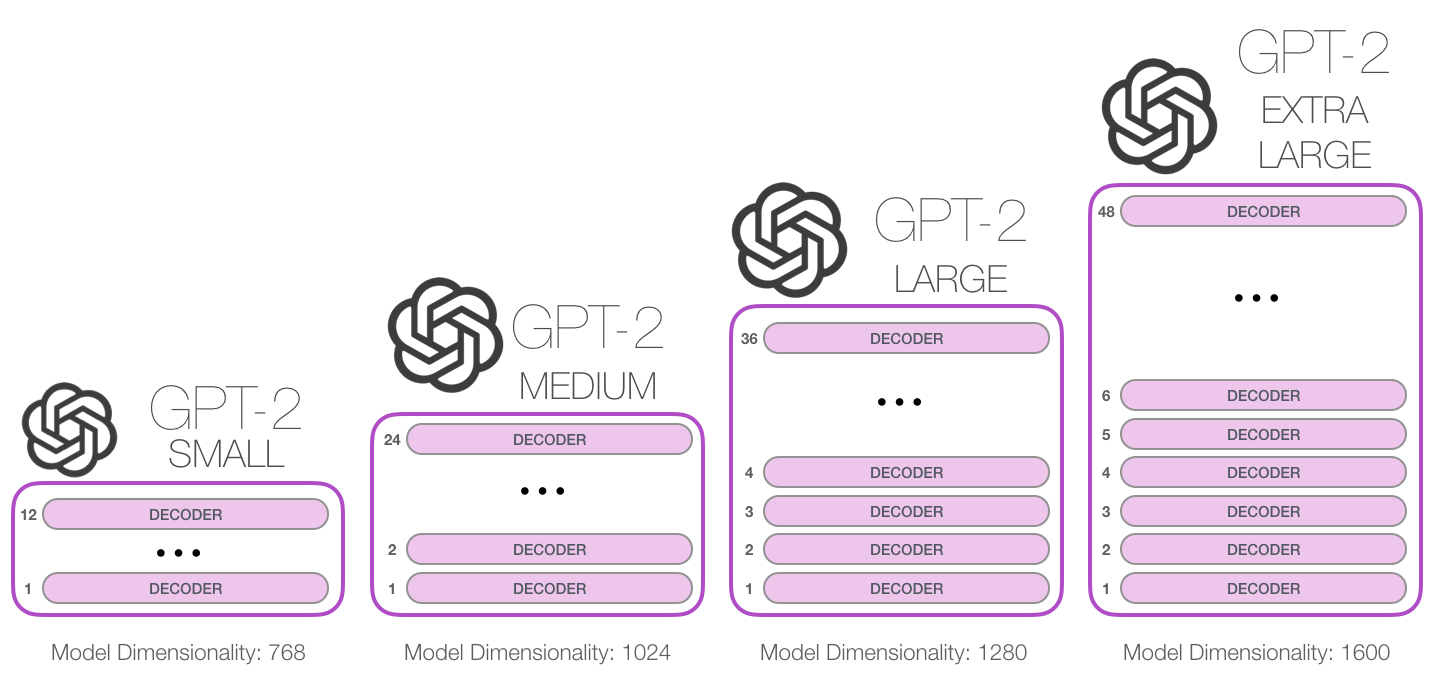

GPT-2 est un grand modèle de langue basé sur un transformateur publié par OpenAI en février 2019. Il contient 1,5 milliard de paramètres et est formé sur un ensemble de données Web de 8 millions. Selon les rapports, le modèle est une extension directe du modèle GPT, formant plus de 10 fois la quantité de données, la quantité de paramètre est également 10 fois plus. En termes de performances, le modèle est capable de produire des paragraphes de texte de coordonnées et réalise les performances SOTA sur de nombreuses références de modélisation de la langue. De plus, le modèle peut effectuer une compréhension préliminaire de la lecture, une traduction automatique, une question et une réponse et un résumé automatique sans formation spécifique à la tâche.

GPT-2 est un grand modèle linguistique basé sur un transformateur publié par OpenAI en février 2019. Il contient 1,5 milliard de paramètres et est formé sur un ensemble de données de page Web de 8 millions. Selon les rapports, ce modèle est une extension directe du modèle GPT, formé sur plus de 10 fois la quantité de données, et le nombre de paramètres est 10 fois plus. En termes de performances, le modèle est capable de produire des paragraphes de texte cohérents et réalise des performances SOTA sur de nombreuses références de modélisation de la langue. De plus, le modèle peut atteindre la compréhension préliminaire de la lecture, la traduction automatique, la question et le résumé et le résumé automatique sans formation spécifique à la tâche.

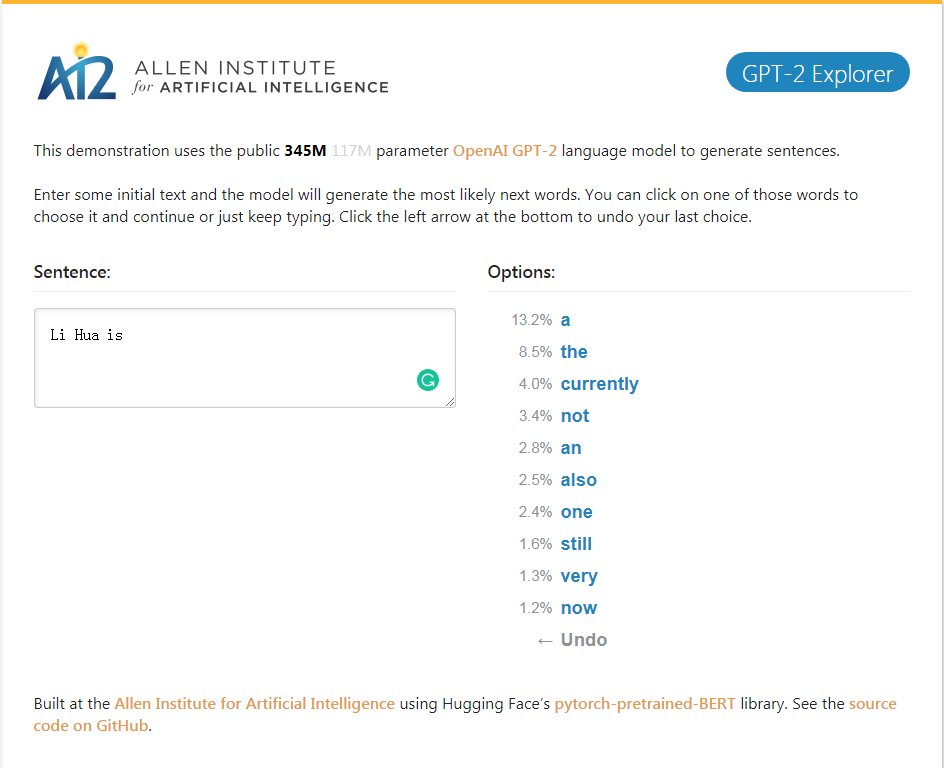

Demo GPT-2_Explorer Il peut donner les dix mots suivants du classement des possibilités et leurs probabilités correspondantes en fonction du texte actuellement d'entrée. Vous pouvez sélectionner l'un des mots, puis voir la liste du mot suivant possible, et ainsi de suite, et enfin en terminer un. Article.

Demo GPT-2_Explorer Il peut donner les dix premiers mots suivants dans la plage possible et sa probabilité correspondante basée sur le texte actuellement entré. Vous pouvez sélectionner l'un des mots et voir une liste des mots suivants. Cela sera répété encore et encore et finira par terminer un article.

Cliquez sur la démo GPT-2 Explorer

Package GPT-2-Simple Python pour recycler facilement le modèle de génération de texte GPT-2 d'OpenAI sur de nouveaux textes.

Le package GPT-2-Simple Python peut facilement recycler le modèle de génération de texte GPT-2 d'OpenAI sur un nouveau texte.

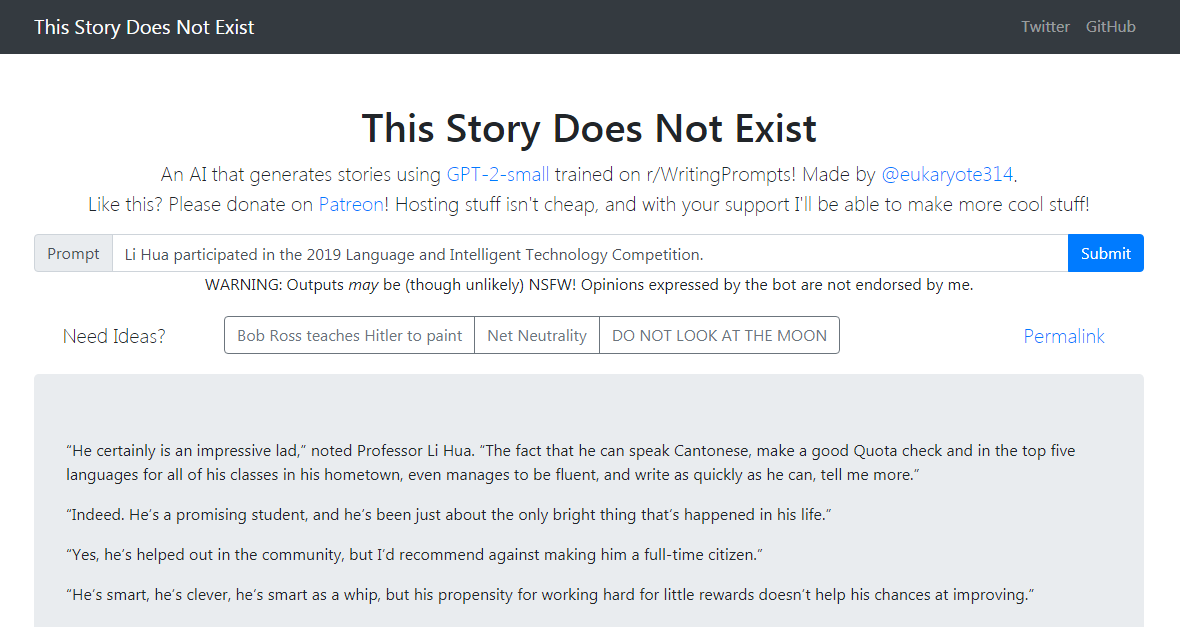

GPT-2-Simple Demo écrit une histoire de suivi basée sur le texte d'entrée actuel. GPT-2-Simple Demo écrit une histoire de suivi basée sur le texte d'entrée actuel.

Cliquez pour expérimenter Cliquez sur GPT-2-Simple Demo

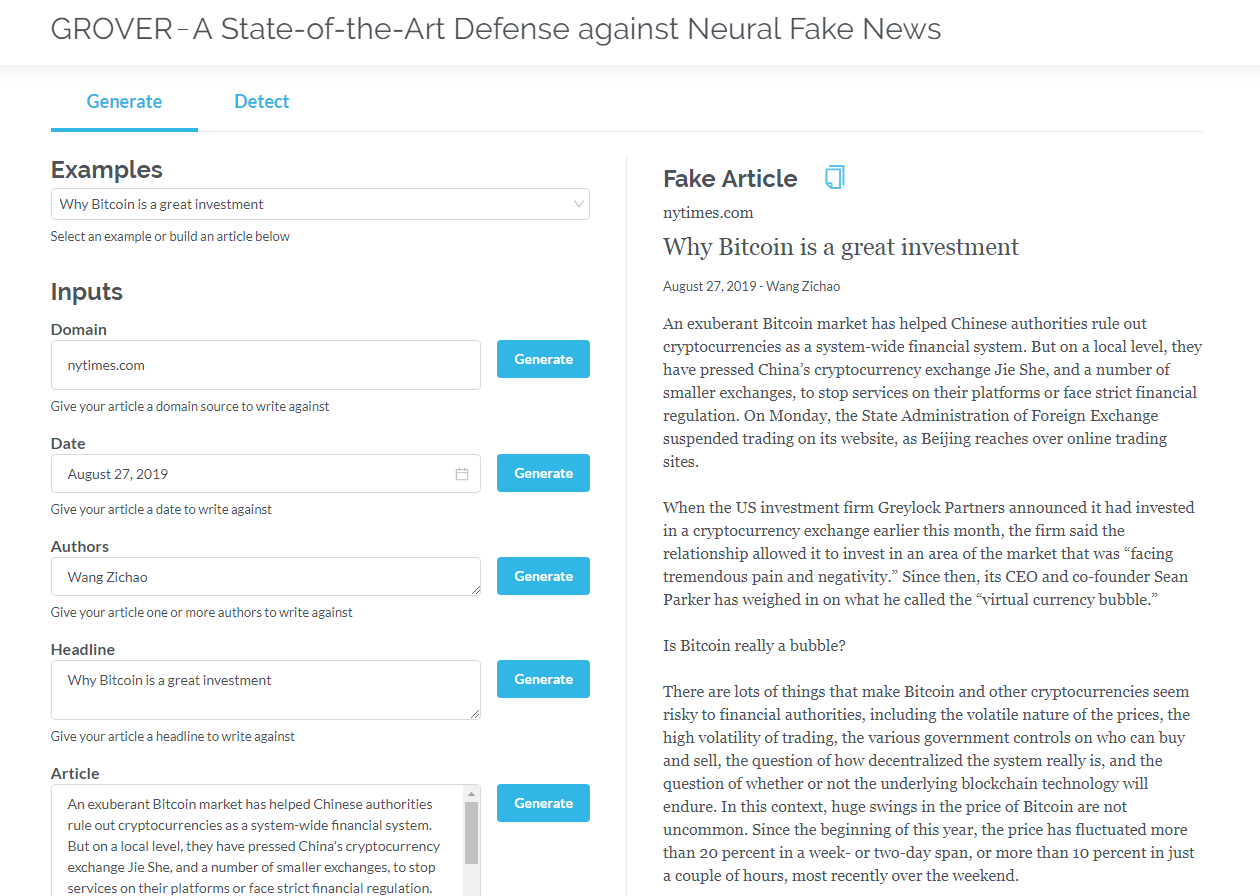

Grover est un modèle pour les fausses nouvelles neuronales - à la fois la génération et la détection. Grover est un modèle pour les fausses nouvelles neuronales - génération et détection.

Générez des articles basés sur des informations telles que le titre, l'auteur, etc. Grover peut également détecter si le texte est généré par la machine.

Générez des articles basés sur le titre, l'auteur et d'autres informations. Grover peut également détecter si le texte est généré par la machine.

Cliquez sur Grover

Cliquez pour lire la version anglaise

Les transformateurs qui ne contiennent que des décodeurs (tels que GPT2) montrent constamment des prospects d'application en dehors de la modélisation du langage. Dans de nombreuses applications, ces modèles ont réussi: la traduction automatique, la génération de résumé automatique, l'apprentissage du transfert et la génération de musique. Passons en revue certaines de ces applications ensemble.

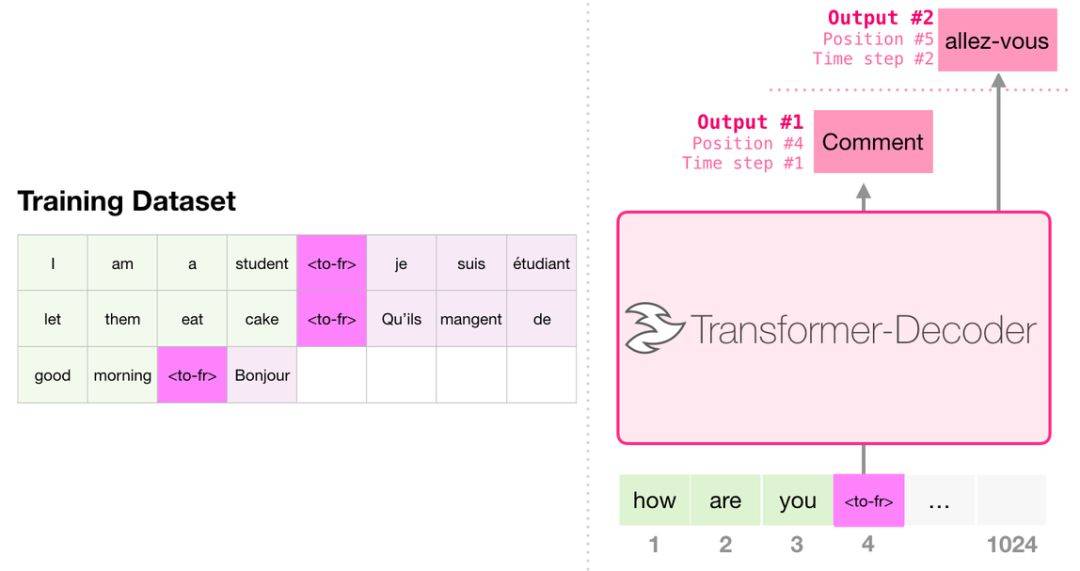

Lors de la traduction, le modèle ne nécessite pas de codeur. La même tâche peut être résolue par un transformateur avec seulement un décodeur:

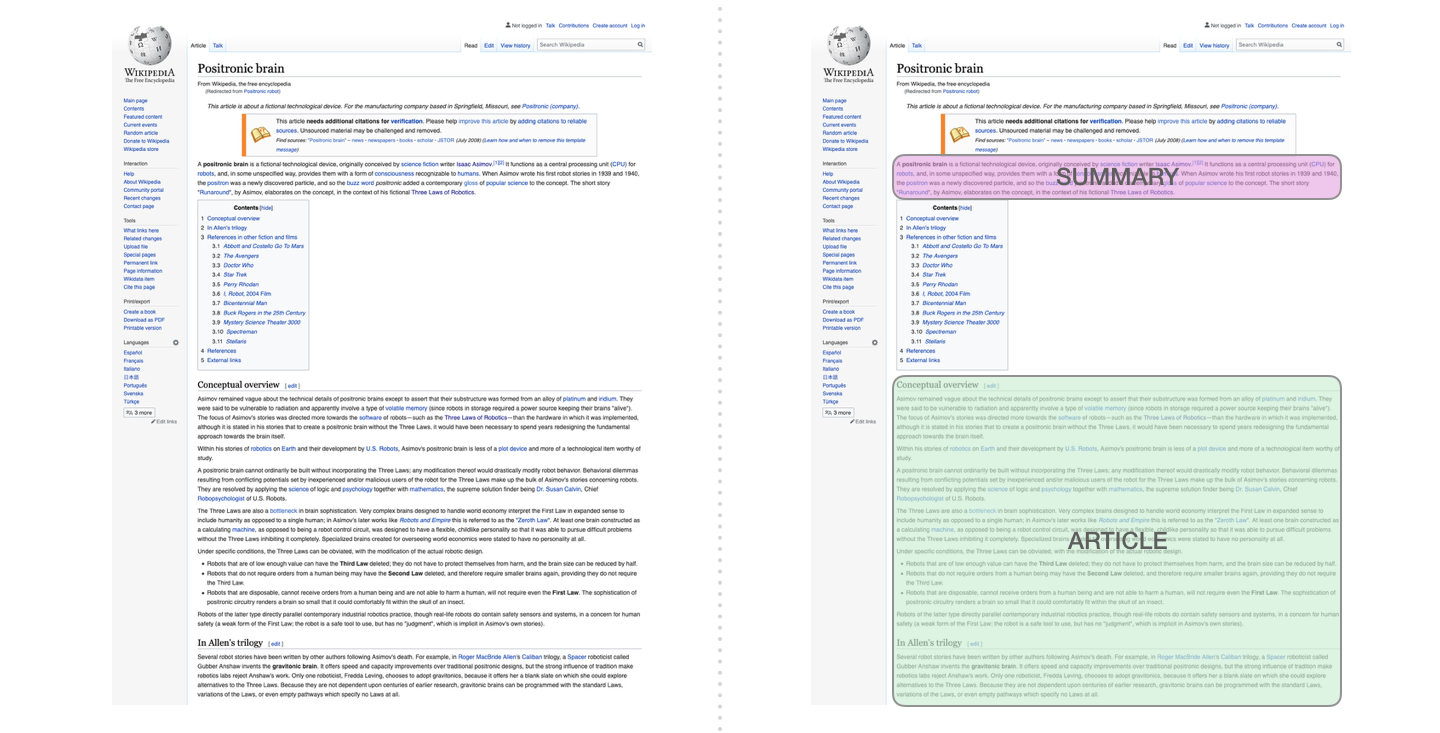

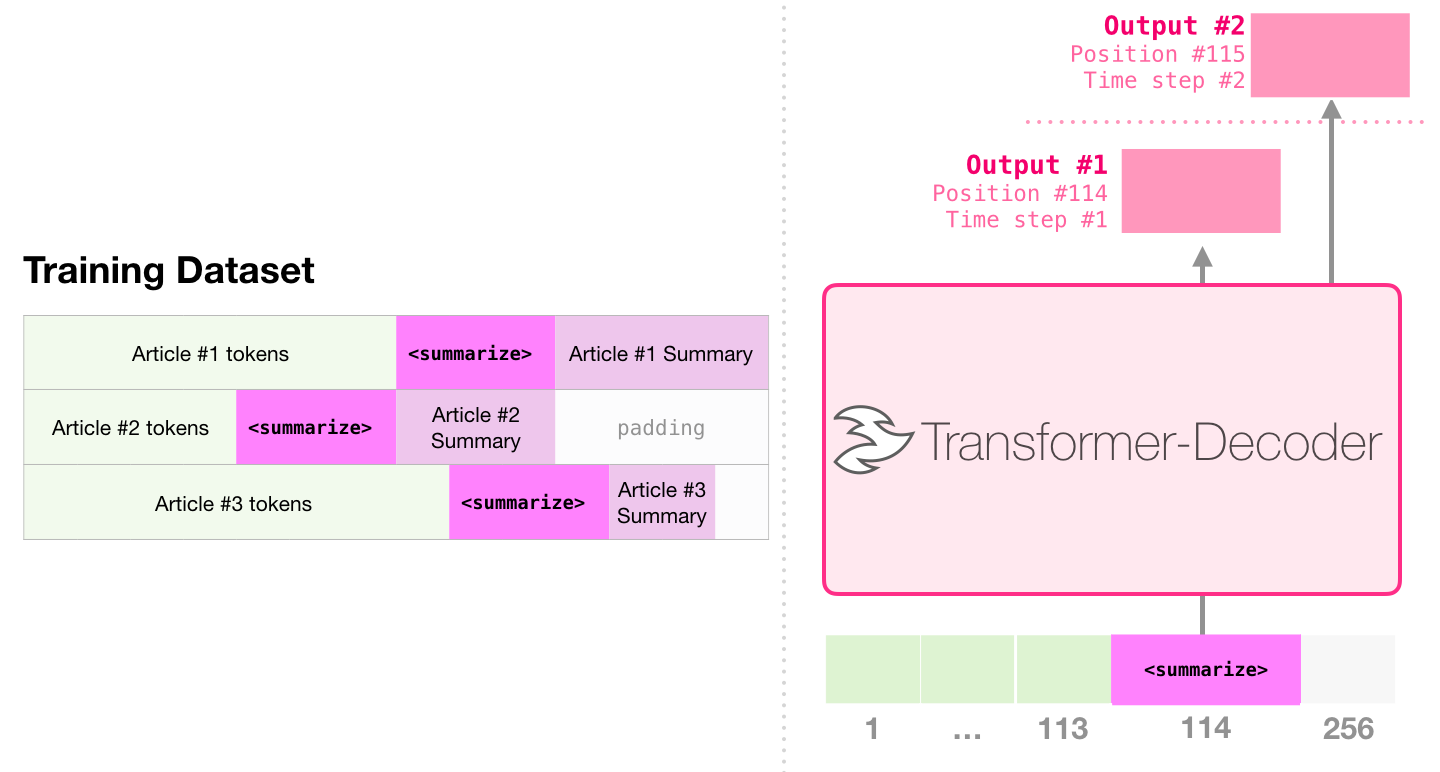

Il s'agit de la première tâche pour former un transformateur qui ne contient que le décodeur. Autrement dit, le modèle est formé pour lire les articles Wikipedia (sans le début du répertoire), puis générer un résumé. Le début réel de l'article est utilisé comme étiquette pour l'ensemble de données de formation:

Le document utilise des articles Wikipedia pour former le modèle, et le modèle formé peut générer un résumé de l'article:

Dans l'échantillon d'article, une résumé de texte efficace à l'aide d'un seul transformateur pré-formé, la première pré-formation est effectuée dans la tâche de modélisation du langage à l'aide de transformateurs qui ne contiennent que des décodeurs, puis la tâche de génération de résumé est terminée par accord. Les résultats montrent que dans le cas de données limitées, ce schéma obtient de meilleurs résultats que le transformateur d'encodeur pré-entraîné. L'article de GPT2 démontre également l'effet de génération abstrait obtenu après la pré-formation du modèle de modélisation du langage.

Music Transformer utilise des transformateurs qui ne contiennent que des décodeurs pour générer de la musique avec un rythme riche et une dynamique. Semblable à la modélisation du langage, la "modélisation musicale" consiste à laisser le modèle apprendre la musique de manière non supervisée, puis à la laisser sortir des échantillons (nous avons déjà appelé "travail aléatoire").

GPT2 n'est qu'une goutte dans l'océan des modèles à base de transformateurs. Pour les comparaisons de 15 modèles importants basés sur les transformateurs de 2018 à 2019, veuillez vous référer à l'ère post-BERT: analyse comparative de 15 modèles pré-formés et exploration des points clés.