Bagian pertama dari ringkasan kumpulan sumber daya ini sumber daya yang digunakan untuk menyelesaikan tugas pembuatan teks menggunakan model bahasa GPT2, termasuk makalah, kode, demo demo, dan tutorial langsung. Bagian kedua menunjukkan penerapan GPT2 dalam tugas pembuatan teks terjemahan mesin, generasi ringkasan otomatis, pembelajaran migrasi dan pembuatan musik. Akhirnya, 15 model bahasa utama berdasarkan transformator antara 2018 dan 2019 dibandingkan.

Bagian pertama dari koleksi sumber daya ini merangkum sumber daya yang digunakan untuk menyelesaikan tugas pembuatan teks menggunakan model bahasa GPT2, termasuk makalah, kode, demo presentasi, dan tutorial langsung. Bagian kedua menunjukkan aplikasi GPT2 dalam tugas pembuatan teks seperti terjemahan mesin, generasi ringkasan otomatis, pembelajaran transfer, dan pembuatan musik. Akhirnya, kami membandingkan model 15 bahasa penting berdasarkan transformator dari 2018 hingga 2019.

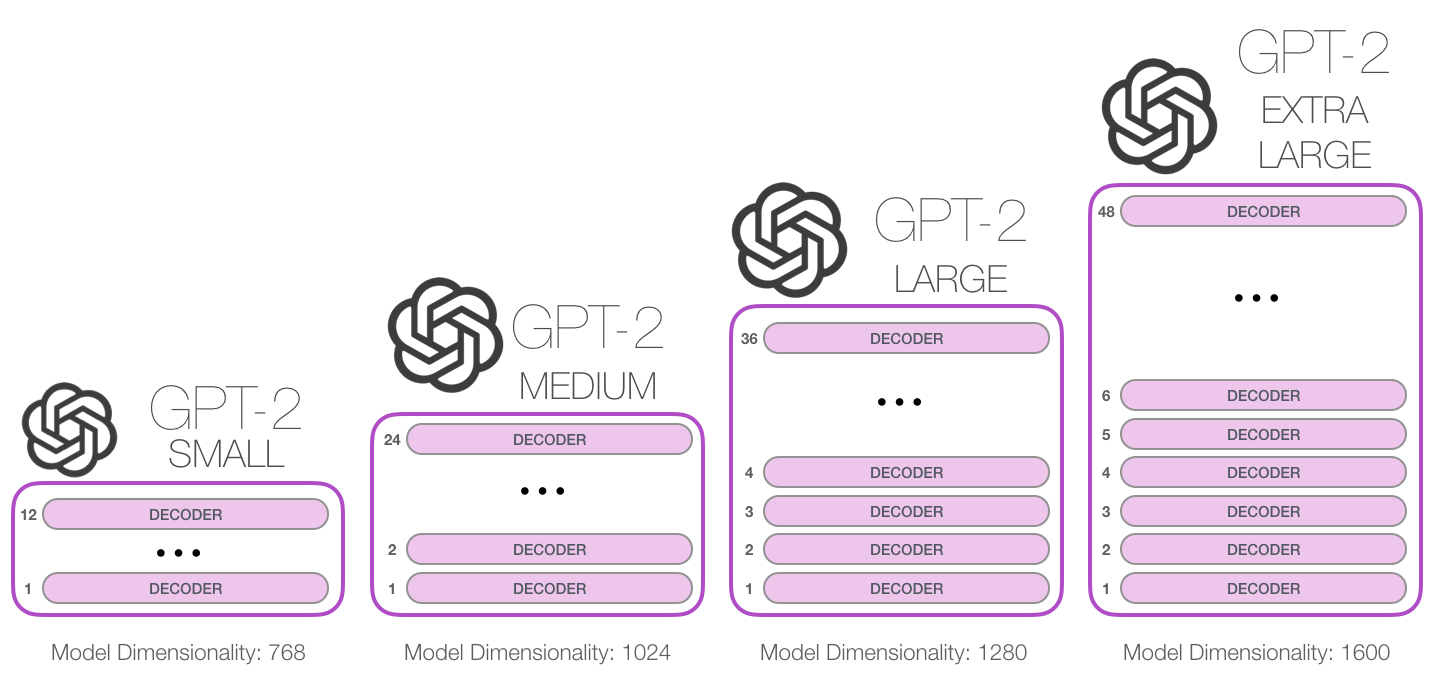

GPT-2 adalah model bahasa berbasis transformator besar yang dirilis oleh OpenAI pada Februari 2019. Ini berisi 1,5 miliar parameter dan dilatih pada dataset Web 8 juta. Menurut laporan, model ini merupakan perpanjangan langsung dari model GPT, pelatihan lebih dari 10 kali jumlah data, jumlah parameter juga 10 kali lebih banyak. Dalam hal kinerja, model ini mampu menghasilkan paragraf teks koordinat dan mencapai kinerja SOTA pada banyak tolok ukur pemodelan bahasa. Selain itu, model dapat melakukan pemahaman membaca awal, terjemahan mesin, tanya jawab dan jawaban dan ringkasan otomatis tanpa pelatihan khusus tugas.

GPT-2 adalah model bahasa berbasis transformator besar yang dirilis oleh OpenAI pada Februari 2019. Ini berisi 1,5 miliar parameter dan dilatih pada dataset halaman web 8 juta. Menurut laporan, model ini merupakan perpanjangan langsung dari model GPT, dilatih lebih dari 10 kali jumlah data, dan jumlah parameter adalah 10 kali lebih banyak. Dalam hal kinerja, model ini mampu menghasilkan paragraf teks yang koheren dan mencapai kinerja SOTA pada banyak tolok ukur pemodelan bahasa. Selain itu, model ini dapat mencapai pemahaman membaca awal, terjemahan mesin, tanya jawab dan ringkasan otomatis tanpa pelatihan khusus tugas.

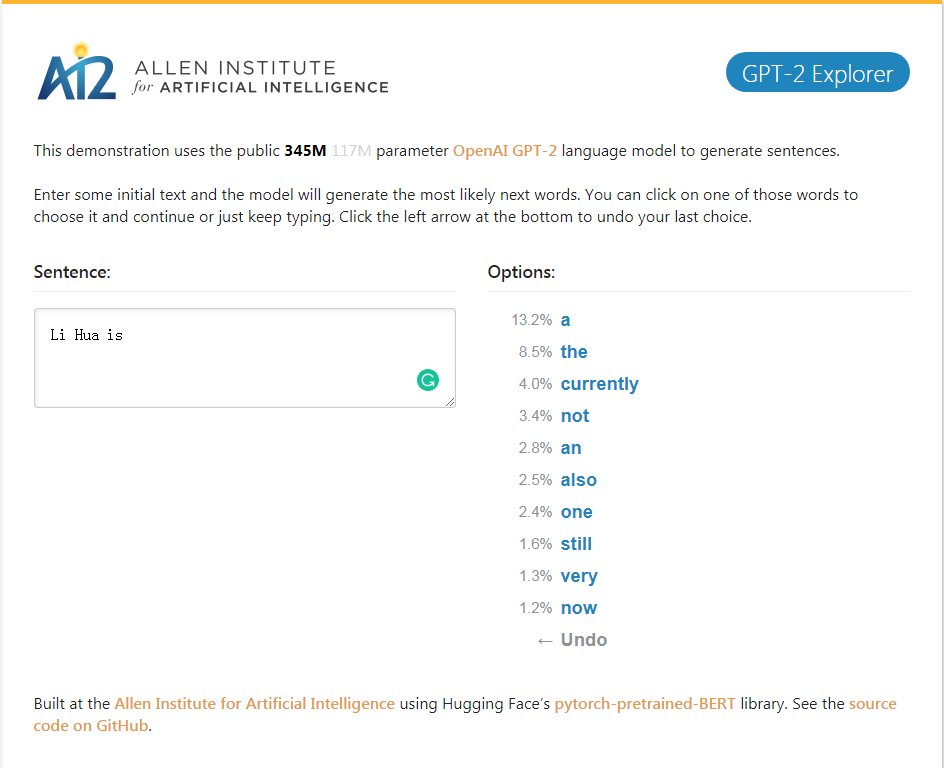

Demo GPT-2_Explorer dapat memberikan sepuluh kata berikutnya dari peringkat kemungkinan dan probabilitas yang sesuai sesuai dengan teks input yang saat ini. Anda dapat memilih salah satu kata, lalu melihat daftar kata yang mungkin berikutnya, dan seterusnya, dan akhirnya lengkapi satu. Artikel.

Demo GPT-2_Explorer dapat memberikan sepuluh besar kata berikutnya dalam rentang yang mungkin dan probabilitas yang sesuai berdasarkan teks yang saat ini dimasukkan. Anda dapat memilih salah satu kata dan melihat daftar kata -kata berikutnya yang mungkin. Ini akan diulangi berulang kali, dan akhirnya menyelesaikan artikel.

Klik ke demo GPT-2 Explorer

Paket Python GPT-2-Simple untuk dengan mudah melatih model penghasil teks GPT-2 Openai pada teks baru.

Paket Python GPT-2-Simple dapat dengan mudah melatih model pembuatan teks GPT-2 Openai pada teks baru.

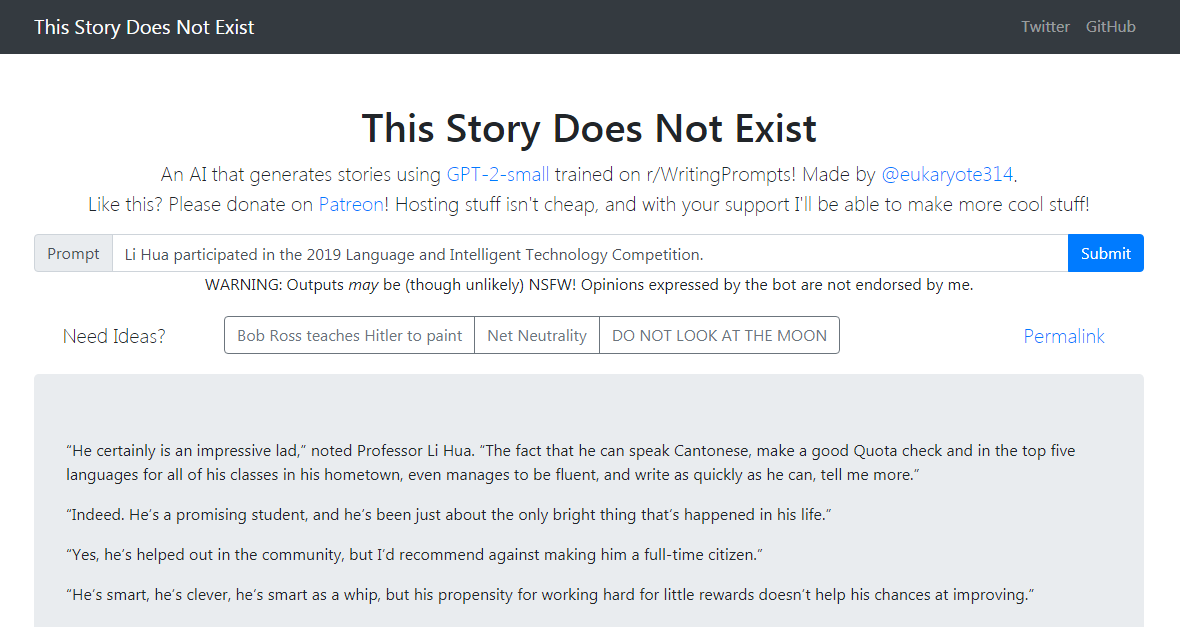

Demo GPT-2-Simple menulis cerita tindak lanjut berdasarkan teks input saat ini. Demo GPT-2-Simple menulis cerita tindak lanjut berdasarkan teks input saat ini.

Klik untuk mengalami klik ke demo GPT-2-Simple

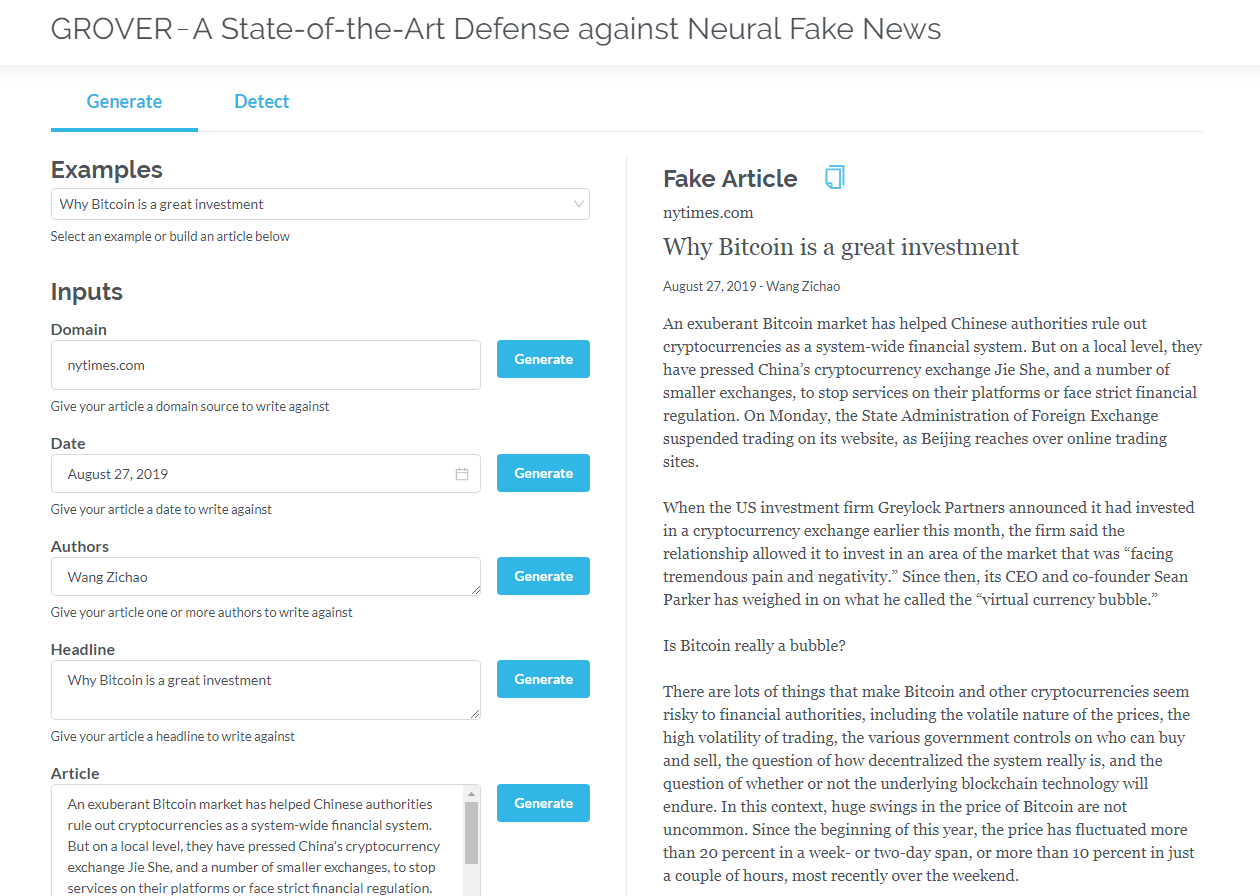

Grover adalah model untuk berita palsu saraf - baik generasi maupun deteksi. Grover adalah model untuk berita palsu saraf - generasi dan deteksi.

Hasilkan artikel berdasarkan informasi seperti judul, penulis, dan banyak lagi. Grover juga dapat mendeteksi jika teks dihasilkan oleh mesin.

Hasilkan artikel berdasarkan judul, penulis, dan informasi lainnya. Grover juga dapat mendeteksi apakah teks dihasilkan oleh mesin.

Klik ke Grover

Klik untuk membaca versi bahasa Inggris

Transformer yang hanya berisi decoder (seperti GPT2) terus -menerus menunjukkan prospek aplikasi di luar pemodelan bahasa. Dalam banyak aplikasi, model semacam itu telah berhasil: terjemahan mesin, generasi ringkasan otomatis, pembelajaran transfer, dan pembuatan musik. Mari kita tinjau beberapa aplikasi ini bersama -sama.

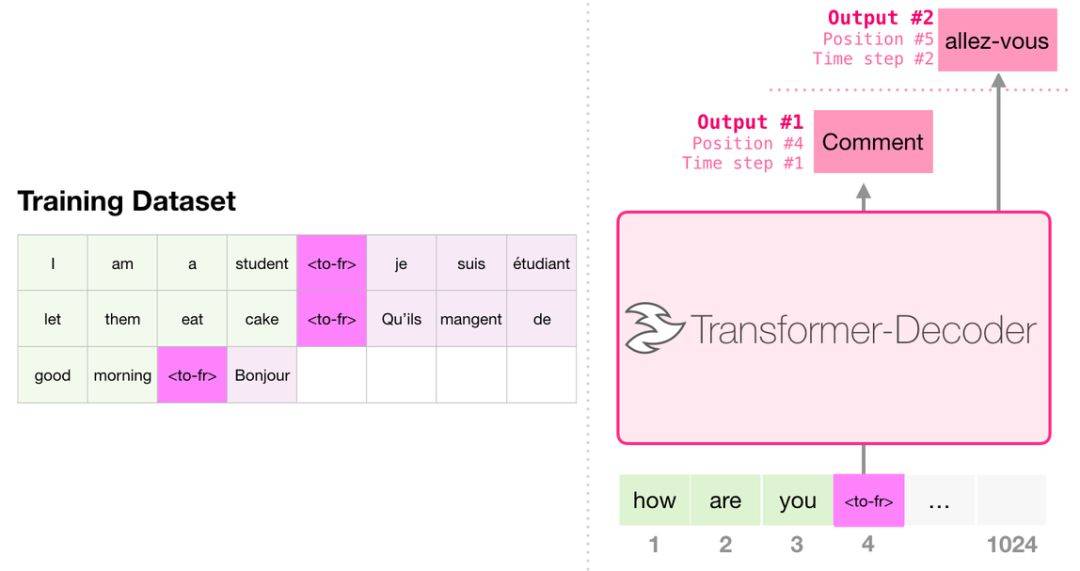

Saat menerjemahkan, model tidak memerlukan encoder. Tugas yang sama dapat diselesaikan dengan transformator dengan hanya decoder:

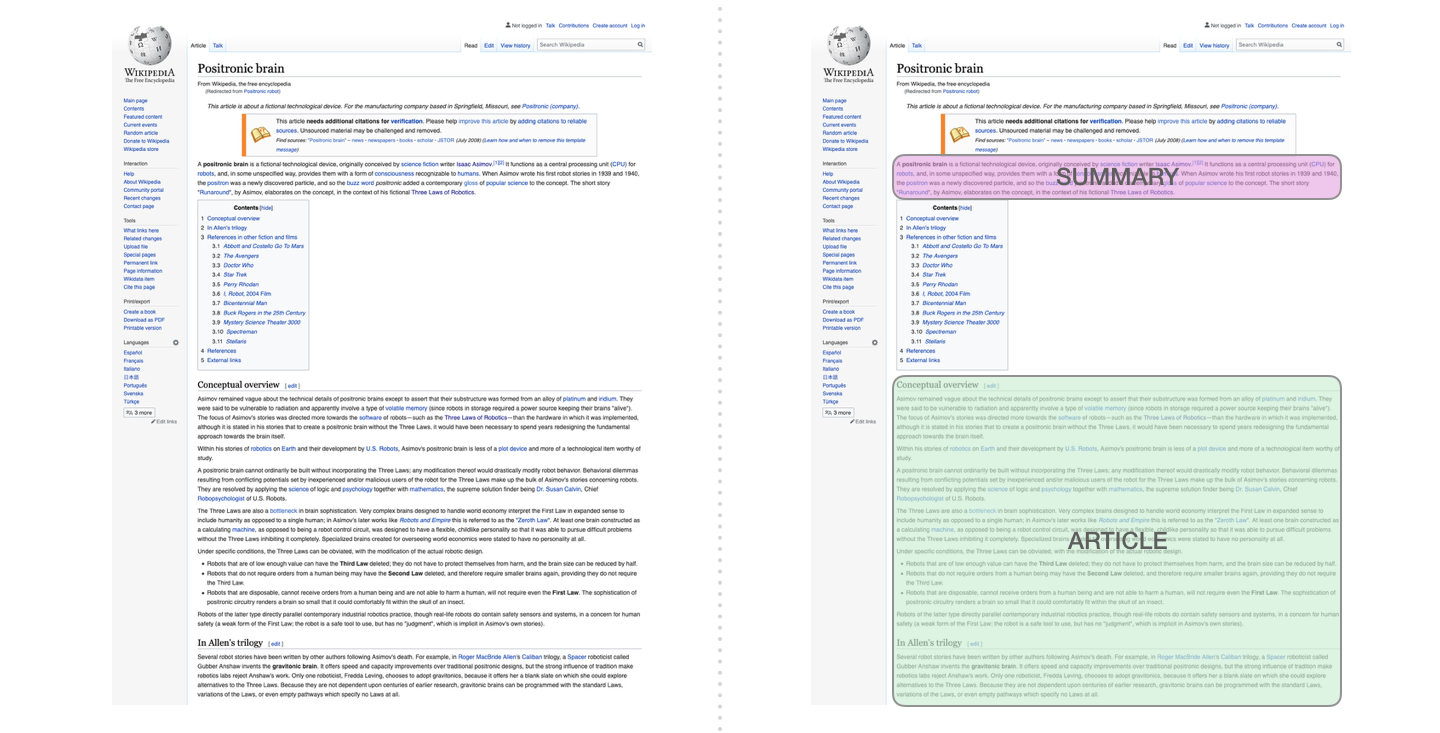

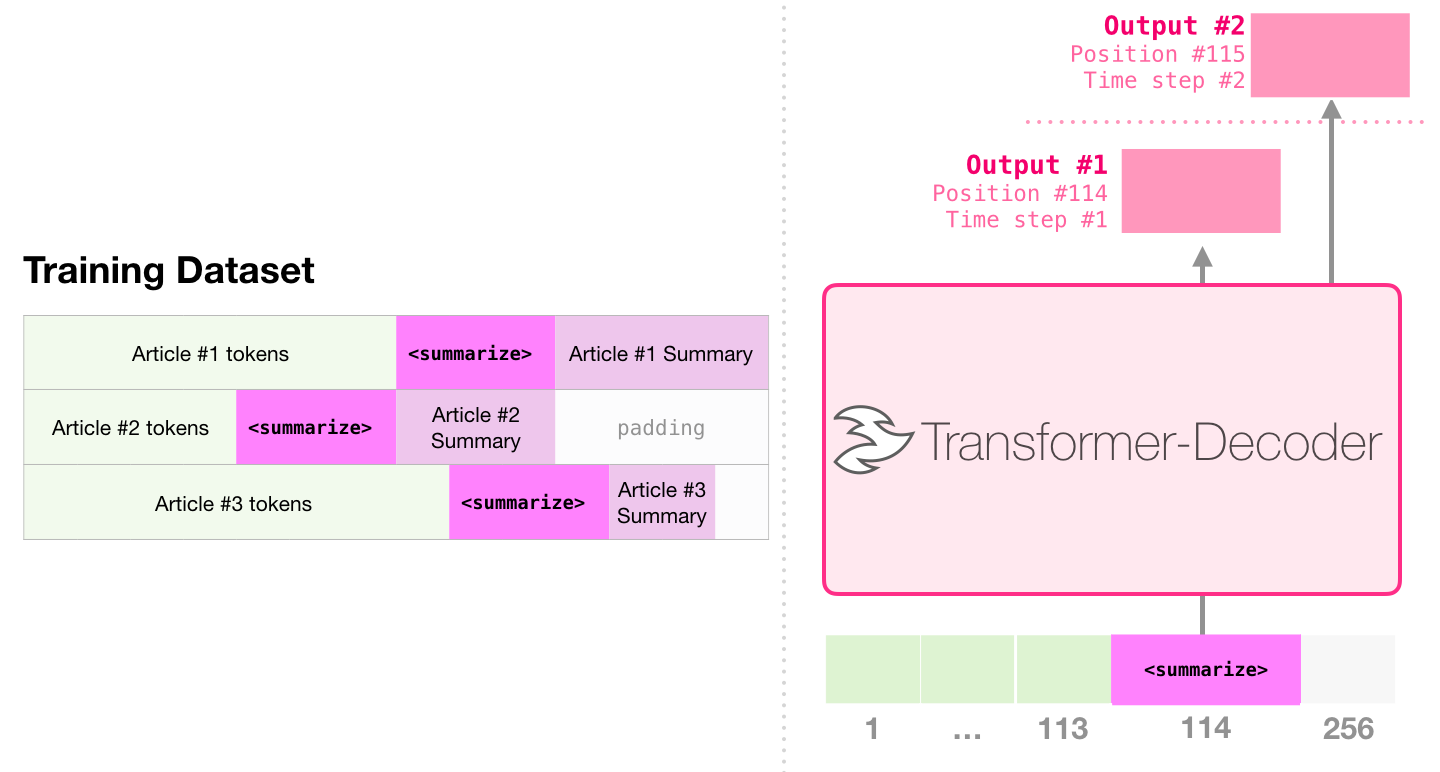

Ini adalah tugas pertama untuk melatih transformator yang hanya berisi decoder. Artinya, model ini dilatih untuk membaca artikel Wikipedia (tanpa awal direktori) dan kemudian menghasilkan ringkasan. Awal artikel yang sebenarnya digunakan sebagai label untuk dataset pelatihan:

Makalah ini menggunakan artikel Wikipedia untuk melatih model, dan model yang terlatih dapat menghasilkan abstrak artikel:

Dalam makalah sampel ringkasan teks yang efisien menggunakan transformator pra-terlatih tunggal, pra-pelatihan pertama dilakukan dalam tugas pemodelan bahasa menggunakan transformator yang hanya berisi decoder, dan kemudian tugas pembuatan ringkasan diselesaikan melalui penyetelan. Hasilnya menunjukkan bahwa dalam kasus data terbatas, skema ini mencapai hasil yang lebih baik daripada transformator enkoder-decoder pretrained. Makalah GPT2 juga menunjukkan efek generasi abstrak yang diperoleh setelah pra-pelatihan model pemodelan bahasa.

Music Transformer menggunakan transformator yang hanya berisi decoder untuk menghasilkan musik dengan ritme dan dinamika yang kaya. Mirip dengan pemodelan bahasa, "pemodelan musik" adalah membiarkan model mempelajari musik dengan cara yang tidak diawasi, dan kemudian membiarkannya mengoutput sampel (kami sebelumnya disebut "karya acak").

GPT2 hanyalah setetes di lautan model berbasis transformator. Untuk perbandingan 15 model berbasis transformator penting dari 2018 hingga 2019, silakan merujuk ke era pasca-Bert: analisis komparatif dari 15 model pra-terlatih dan eksplorasi poin-poin utama.