الجزء الأول من تجمع الموارد هذا ملخص الموارد المستخدمة لحل مهام توليد النص باستخدام نموذج اللغة GPT2 ، بما في ذلك الأوراق والرمز والعروض التوضيحية والدروس التعليمية العملية. يعرض الجزء الثاني تطبيق GPT2 في مهام توليد النص للترجمة الآلية ، وتوليد الملخصات التلقائية ، وتعلم الترحيل وتوليد الموسيقى. أخيرًا ، تتم مقارنة نماذج اللغة الرئيسية الـ 15 القائمة على المحول بين عامي 2018 و 2019.

يلخص الجزء الأول من مجموعة الموارد هذه الموارد المستخدمة لحل مهام توليد النص باستخدام نموذج اللغة GPT2 ، بما في ذلك الأوراق والرمز وعروض العرض التقديمي والدروس التعليمية العملية. يعرض الجزء الثاني تطبيق GPT2 في مهام توليد النص مثل الترجمة الآلية ، وتوليد الملخص التلقائي ، وتعلم النقل ، وتوليد الموسيقى. أخيرًا ، نقوم بمقارنة نماذج اللغة 15 المهمة التي تعتمد على محول من 2018 إلى 2019.

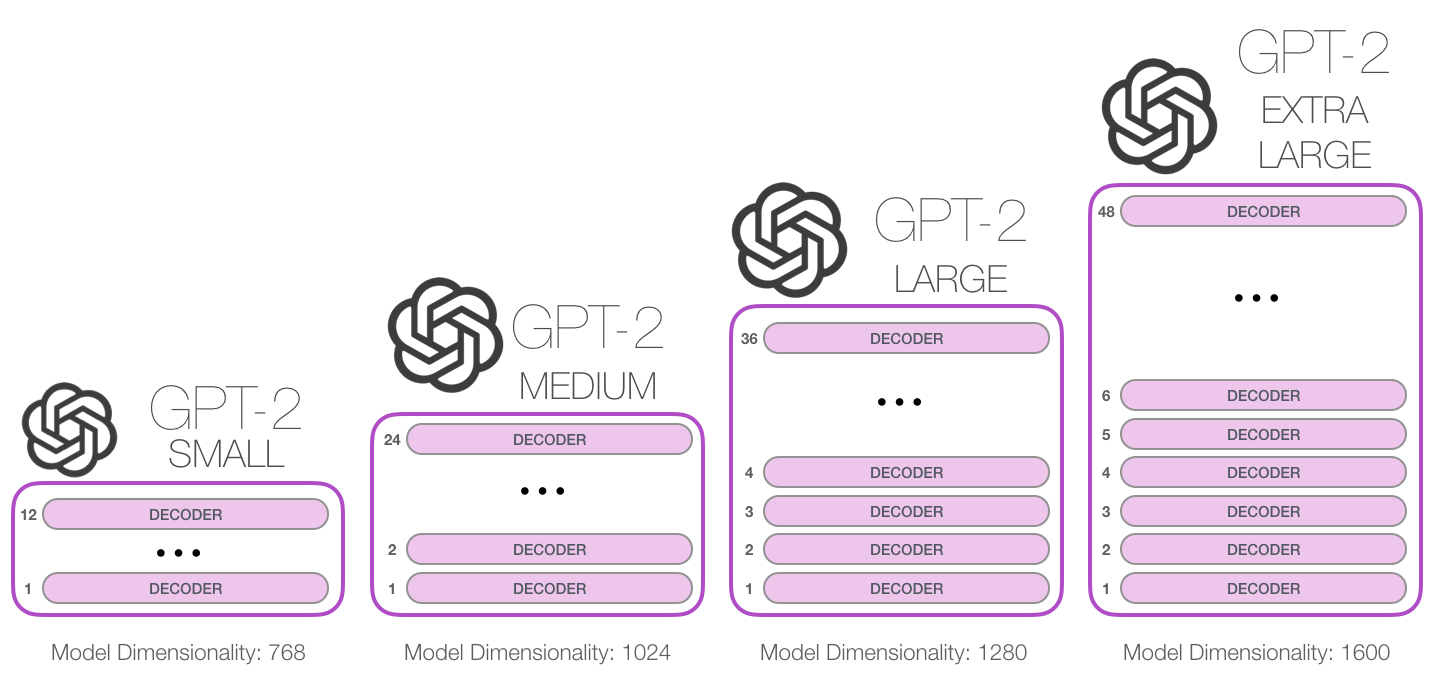

GPT-2 هو نموذج لغة كبير يعتمد على المحولات الصادرة عن Openai في فبراير 2019. ويحتوي على 1.5 مليار معلمة ويتم تدريبه على مجموعة بيانات ويب 8 ملايين. وفقًا للتقارير ، يعد النموذج امتدادًا مباشرًا لنموذج GPT ، حيث يتدرب على أكثر من 10 أضعاف كمية البيانات ، كما أن مبلغ المعلمة هو أيضًا 10 مرات. فيما يتعلق بالأداء ، يكون النموذج قادرًا على إنتاج فقرات نصية إحداثي ويحقق أداء SOTA على العديد من معايير نمذجة اللغة. علاوة على ذلك ، يمكن للنموذج إجراء فهم أولي للقراءة والترجمة الآلية والسؤال والإجابة والملخص التلقائي دون تدريب خاص بالمهمة.

GPT-2 هو نموذج لغة كبير يعتمد على المحولات الصادرة عن Openai في فبراير 2019. ويحتوي على 1.5 مليار معلمة ويتم تدريبه على مجموعة بيانات 8 ملايين ويب. وفقًا للتقارير ، يعد هذا النموذج امتدادًا مباشرًا لنموذج GPT ، حيث تم تدريبه على أكثر من 10 أضعاف كمية البيانات ، وعدد المعلمات 10 مرات أكثر. فيما يتعلق بالأداء ، فإن النموذج قادر على إنتاج فقرات نصية متماسكة ويحقق أداء SOTA على العديد من معايير نمذجة اللغة. علاوة على ذلك ، يمكن أن يحقق النموذج فهم القراءة الأولي ، والترجمة الآلية ، والأسئلة والأجوبة والملخص التلقائي دون تدريب خاص بالمهمة.

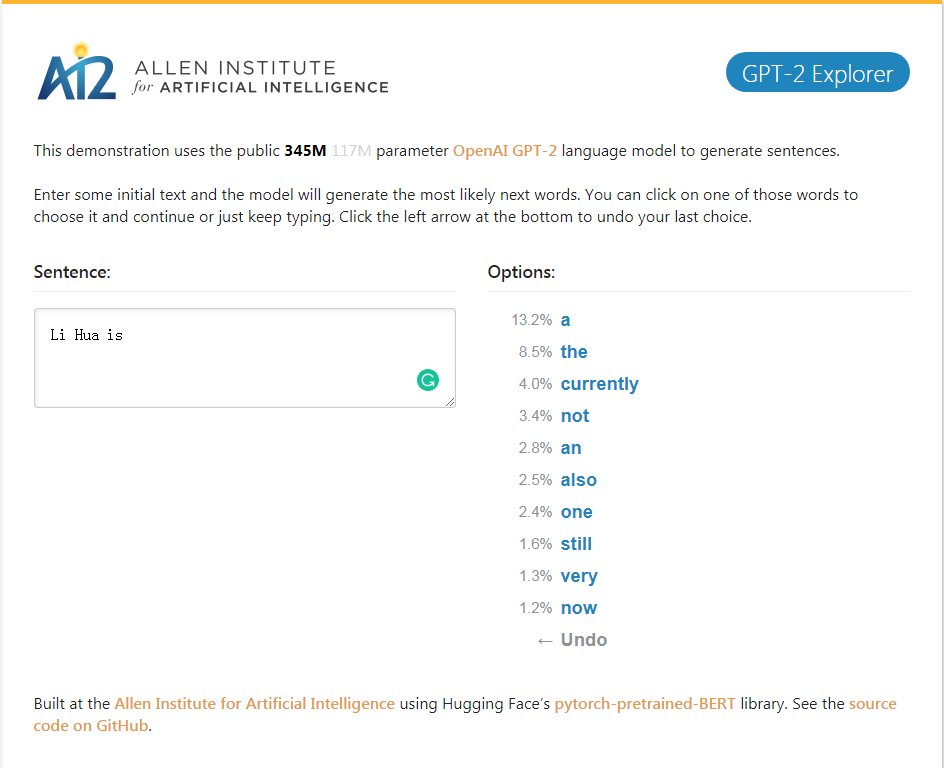

GPT-2_Explorer Demo يمكن أن يعطي الكلمات العشر التالية من ترتيب إمكانية واحتمالاتها المقابلة وفقًا لنص الإدخال حاليًا. يمكنك تحديد إحدى الكلمات ، ثم رؤية قائمة الكلمة الممكنة التالية ، وما إلى ذلك ، وإكمال الكاملة أخيرًا. شرط.

GPT-2_Explorer Demo يمكن أن يعطي الكلمة العشرة الأولى التالية في النطاق المحتمل واحتماله المقابل بناءً على النص الذي تم إدخاله حاليًا. يمكنك تحديد إحدى الكلمات ومشاهدة قائمة الكلمات الممكنة التالية. سيتم تكرار ذلك مرارًا وتكرارًا ، وأخيراً أكمل مقالًا.

انقر إلى GPT-2 Explorer Demo

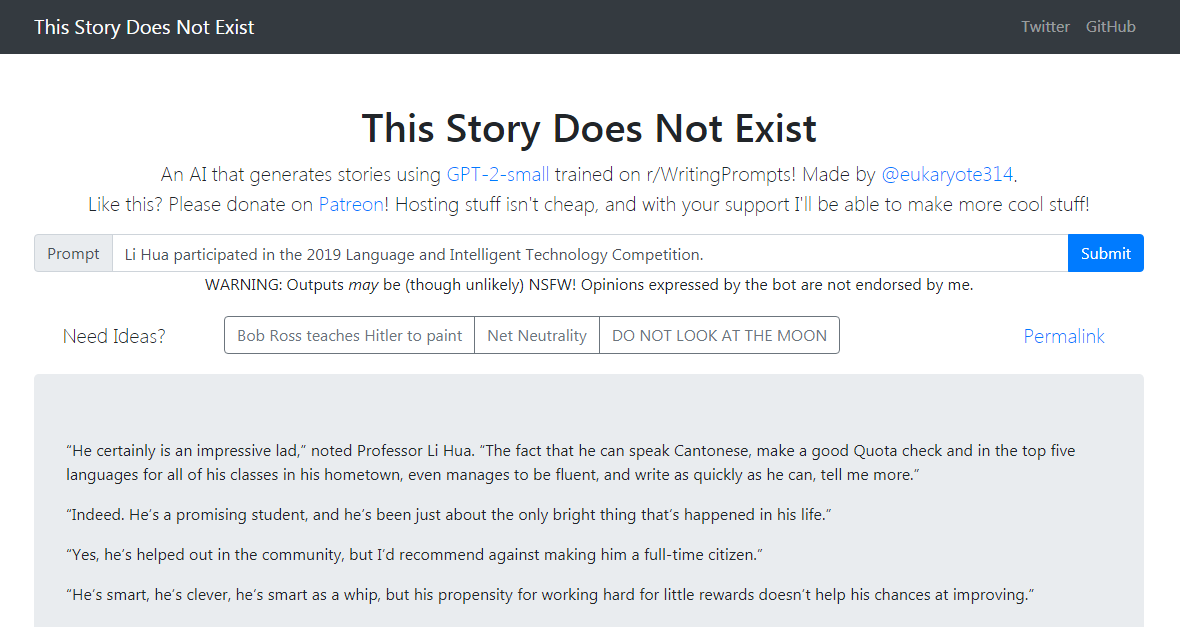

حزمة Python GPT-2 البسعار لإعادة تدريب موديل Openai GPT-2 بسهولة على نصوص جديدة.

يمكن أن تعيد حزمة Python GPT-2 البسيطة بسهولة إعادة تدريب نموذج توليد النص GPT-2 من Openai على نص جديد.

يكتب Demo GPT-2 Simple قصة متابعة تستند إلى نص الإدخال الحالي. يكتب Demo GPT-2 Simple قصة متابعة تستند إلى نص الإدخال الحالي.

انقر لتجربة انقر فوق العرض التوضيحي GPT-2 Simple

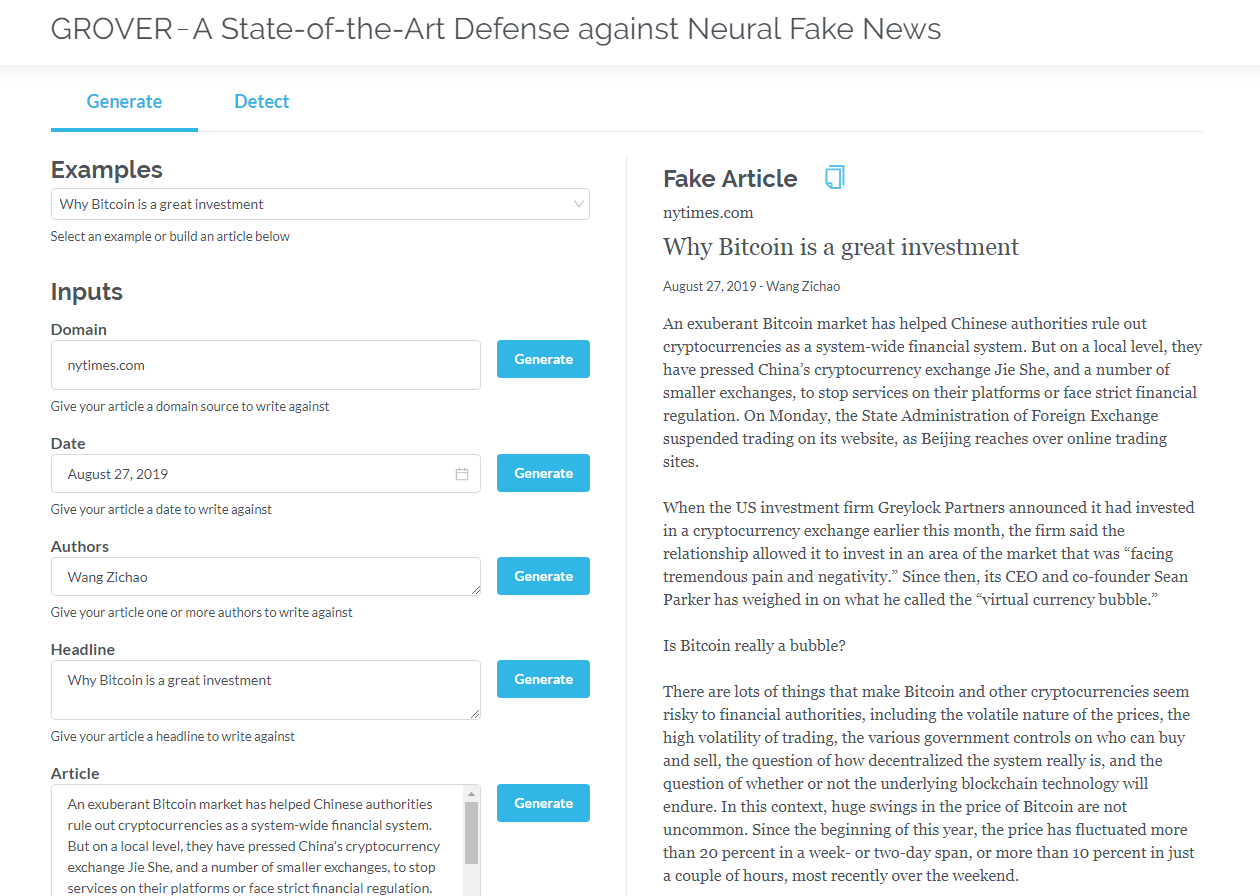

Grover هو نموذج للأخبار المزيفة العصبية - كل من الجيل والاكتشاف. Grover هو نموذج للأخبار المزيفة العصبية - توليد واكتشاف.

قم بإنشاء مقالات تستند إلى معلومات مثل العنوان والمؤلف والمزيد. يمكن لـ Grover أيضًا اكتشاف ما إذا تم إنشاء النص بواسطة الجهاز.

قم بإنشاء مقالات بناءً على العنوان والمؤلف والمعلومات الأخرى. يمكن لـ Grover أيضًا اكتشاف ما إذا كان الجهاز يتم إنشاؤه بواسطة الجهاز.

انقر إلى جروفر

انقر لقراءة النسخة الإنجليزية

المحولات التي تحتوي فقط على وحدة فك التشفير (مثل GPT2) تظهر باستمرار آفاق التطبيق خارج نمذجة اللغة. في العديد من التطبيقات ، كانت هذه النماذج ناجحة: الترجمة الآلية ، وتوليد الملخص التلقائي ، وتعلم النقل ، وتوليد الموسيقى. دعنا نراجع بعض هذه التطبيقات معًا.

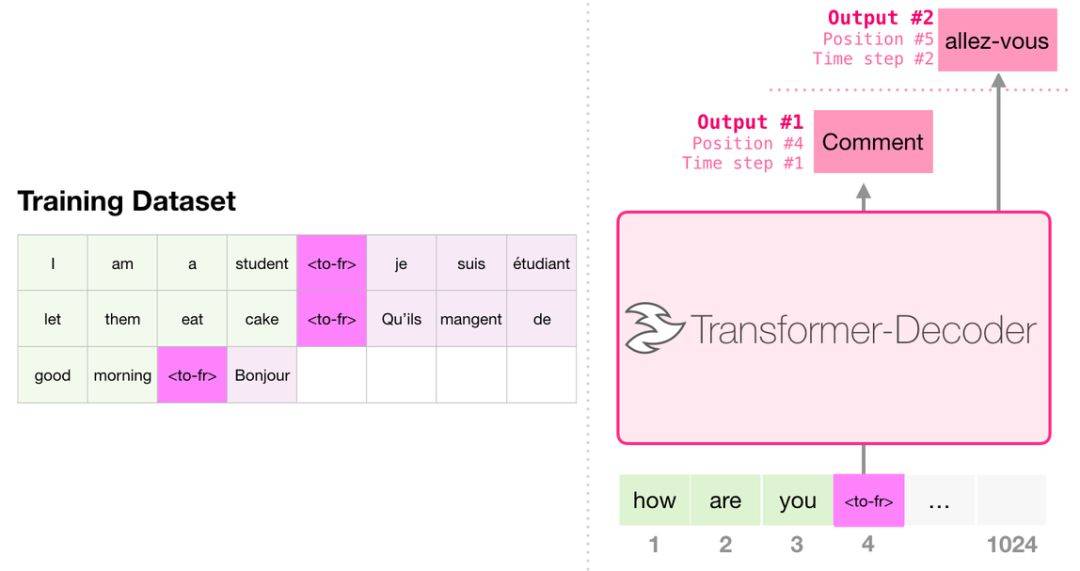

عند الترجمة ، لا يتطلب النموذج تشفيرًا. يمكن حل نفس المهمة بواسطة محول مع فك التشفير فقط:

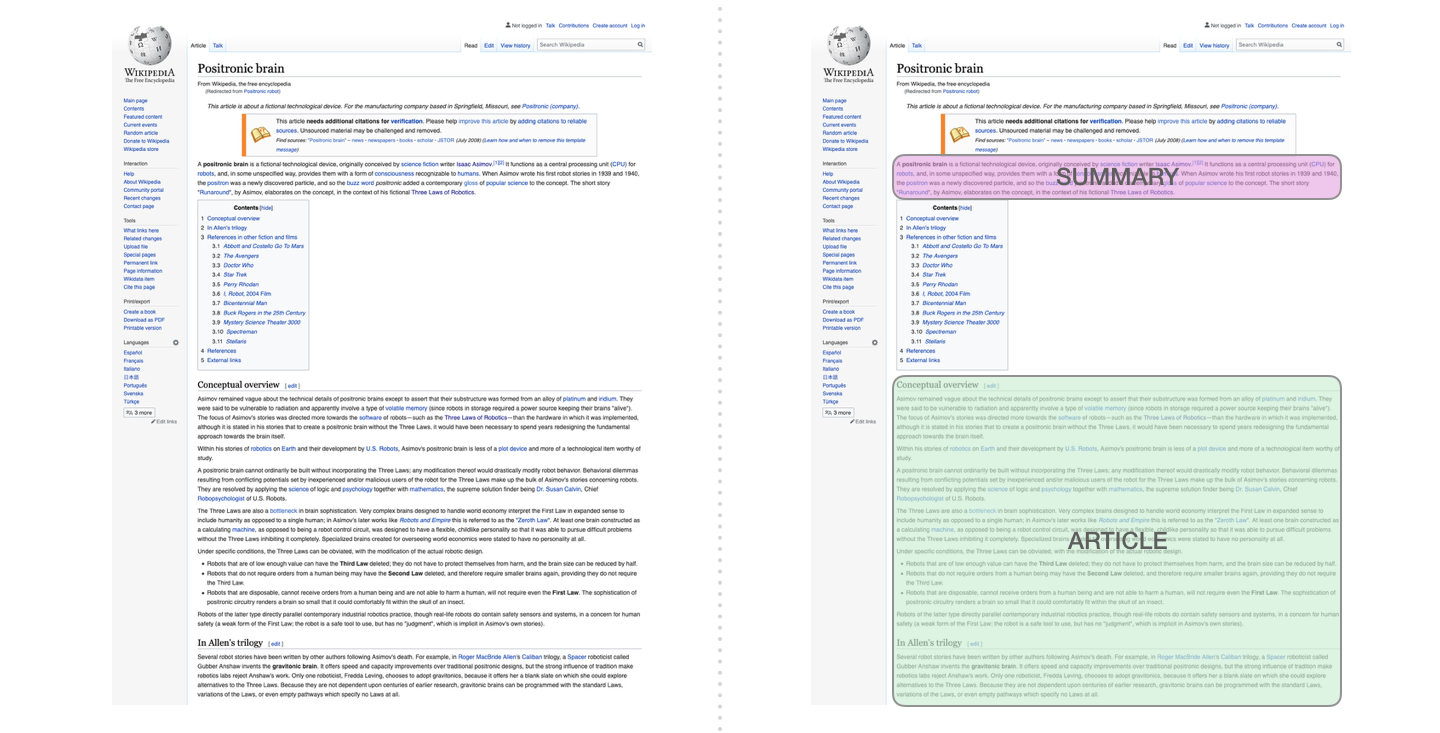

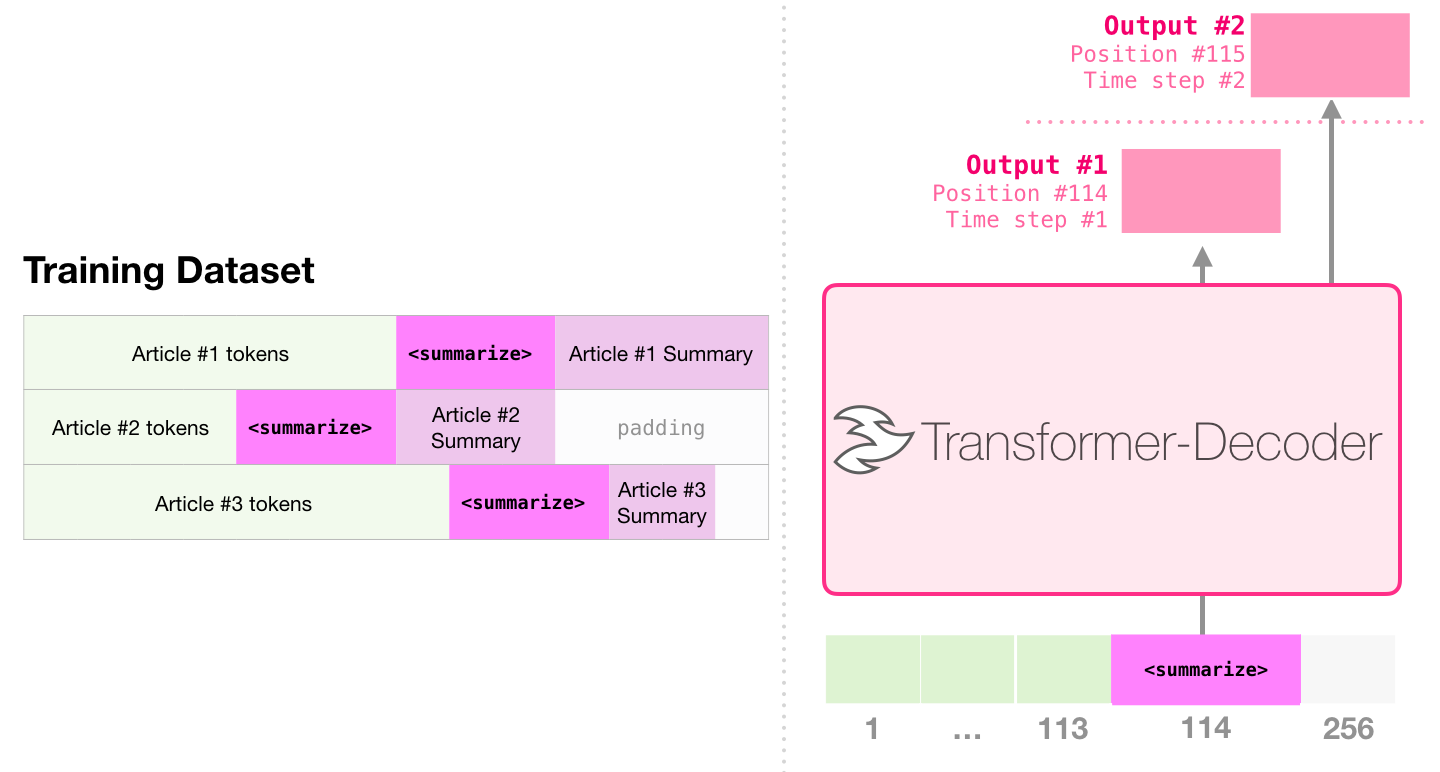

هذه هي المهمة الأولى لتدريب محول يحتوي فقط على وحدة فك الترميز. أي أن النموذج مدرب على قراءة مقالات ويكيبيديا (دون بداية الدليل) ثم إنشاء ملخص. يتم استخدام البداية الفعلية للمقالة كتسمية لمجموعة بيانات التدريب:

تستخدم الورقة مقالات ويكيبيديا لتدريب النموذج ، ويمكن للنموذج المدرب إنشاء ملخص للمقال:

في عينة الورق ، تلخيص النص الفعال باستخدام محول واحد تم تدريبه مسبقًا ، يتم تنفيذ التدريب الأول في مهمة نمذجة اللغة باستخدام المحولات التي تحتوي فقط على وحدة فك التشفير ، ثم يتم الانتهاء من مهمة توليد الملخص من خلال الضبط. تظهر النتائج أنه في حالة البيانات المحدودة ، يحقق هذا المخطط نتائج أفضل من محول ترميز المشفر المسبق. توضح ورقة GPT2 أيضًا تأثير الجيل التجريدي الذي تم الحصول عليه بعد تدريب نموذج نمذجة اللغة مسبقًا.

يستخدم Music Transformers محولات تحتوي فقط على وحدة فك التشفير لتوليد الموسيقى مع إيقاع غني وديناميات. على غرار نمذجة اللغة ، فإن "نمذجة الموسيقى" تتمثل في السماح للنموذج بتعلم الموسيقى بطريقة غير خاضعة للإشراف ، ثم دعها نخرج عينات من عينة (أطلقنا عليها سابقًا إلى "العمل العشوائي").

GPT2 هو مجرد انخفاض في محيط النماذج القائمة على المحولات. لمقارنات 15 نموذجًا مهمًا يستند إلى المحولات من 2018 إلى 2019 ، يرجى الرجوع إلى عصر ما بعد بيرت: التحليل المقارن لـ 15 نماذج مسبقة التدريب واستكشاف النقاط الرئيسية.