La primera parte de este grupo de recursos resumió los recursos utilizados para resolver tareas de generación de texto utilizando el modelo de idioma GPT2, incluidos los documentos, el código, las demostraciones de demostración y los tutoriales prácticos. La segunda parte muestra la aplicación de GPT2 en las tareas de generación de texto de traducción automática, generación de resumen automático, aprendizaje de migración y generación de música. Finalmente, se comparan los 15 modelos de idiomas principales basados en el transformador entre 2018 y 2019.

La primera parte de esta colección de recursos resume los recursos utilizados para resolver tareas de generación de texto utilizando el modelo de idioma GPT2, incluidos los documentos, el código, las demostraciones de presentación y los tutoriales prácticos. La segunda parte muestra la aplicación de GPT2 en tareas de generación de texto, como traducción automática, generación de resumen automático, aprendizaje de transferencia y generación de música. Finalmente, comparamos los 15 modelos de idioma importantes basados en Transformer de 2018 a 2019.

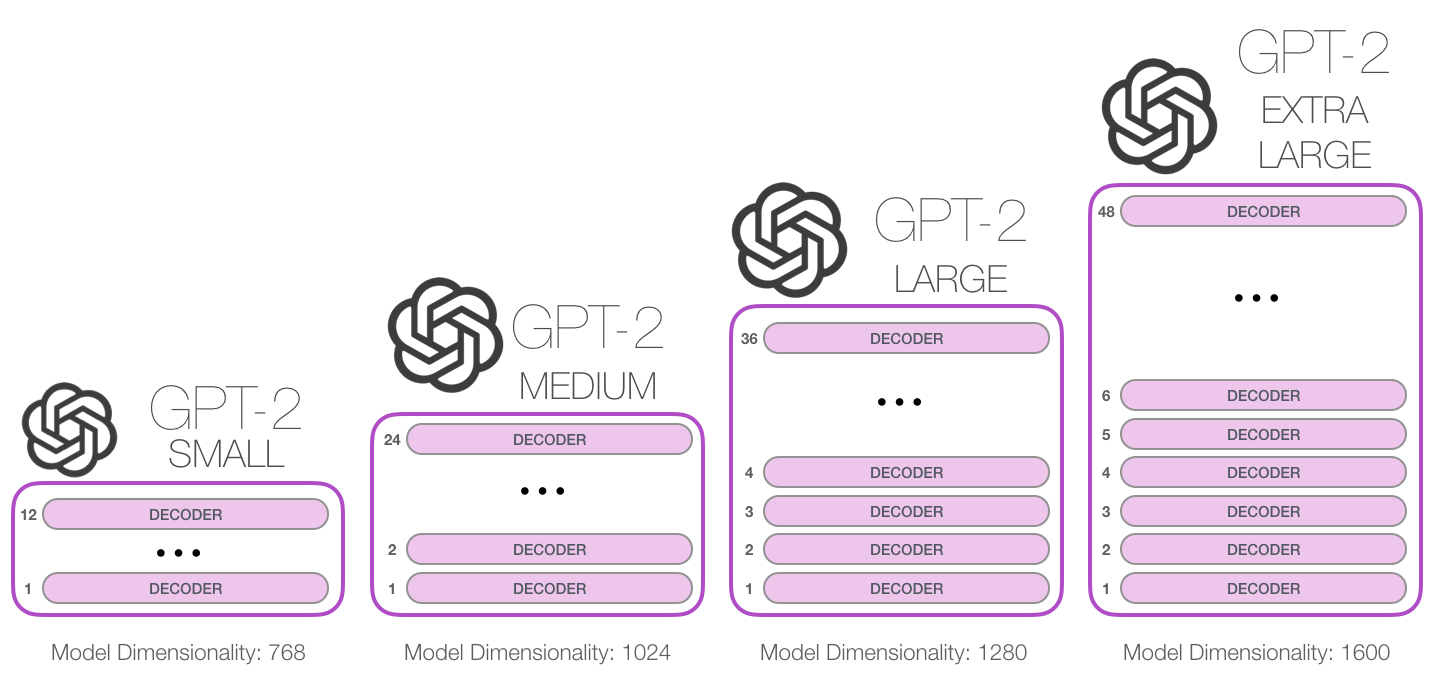

GPT-2 es un gran modelo de lenguaje basado en transformadores publicado por OpenAI en febrero de 2019. Contiene 1,5 mil millones de parámetros y está capacitado en un conjunto de datos web de 8 millones. Según los informes, el modelo es una extensión directa del modelo GPT, entrenando en más de 10 veces la cantidad de datos, la cantidad de parámetro también es 10 veces más. En términos de rendimiento, el modelo es capaz de producir párrafos de texto coordinados y logra el rendimiento de SOTA en muchos puntos de referencia de modelado de idiomas. Además, el modelo puede realizar una comprensión de lectura preliminar, traducción automática, preguntas y respuestas y resumen automático sin capacitación específica de tareas.

GPT-2 es un gran modelo de lenguaje basado en transformadores publicado por OpenAI en febrero de 2019. Contiene 1,5 mil millones de parámetros y está capacitado en un conjunto de datos de 8 millones de páginas web. Según los informes, este modelo es una extensión directa del modelo GPT, entrenado en más de 10 veces la cantidad de datos, y el número de parámetros es 10 veces más. En términos de rendimiento, el modelo puede producir párrafos de texto coherentes y logra el rendimiento de SOTA en muchos puntos de referencia de modelado de idiomas. Además, el modelo puede lograr la comprensión de lectura preliminar, la traducción automática, el resumen de preguntas y respuestas y automáticos sin capacitación específica de tareas.

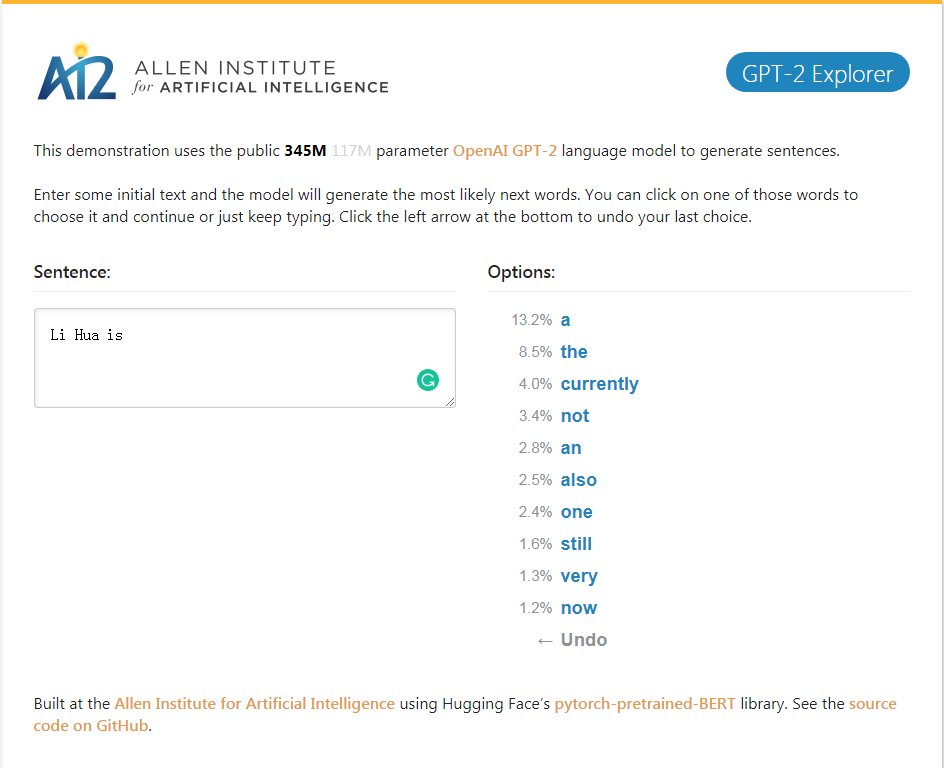

GPT-2_Explorer Demo Puede dar las siguientes diez palabras de la clasificación de posibilidades y sus probabilidades correspondientes de acuerdo con el texto de entrada actualmente. Puede seleccionar una de las palabras, luego ver la lista de la siguiente palabra posible, y así sucesivamente, y finalmente completar una. Artículo.

GPT-2_Explorer Demo Puede dar a las diez mejores palabras de la siguiente manera en el rango posible y su probabilidad correspondiente basada en el texto ingresado actualmente. Puede seleccionar una de las palabras y ver una lista de las siguientes palabras posibles. Esto se repetirá una y otra vez y finalmente completará un artículo.

Haga clic en Demo de Explorer GPT-2

Paquete Python-Simple GPT-2 para volver a entrenar fácilmente el modelo de generación de texto GPT-2 de OpenAI en nuevos textos.

El paquete Python GPT-2-simple puede volver a entrenar fácilmente el modelo de generación de texto GPT-2 de OpenAI en un texto nuevo.

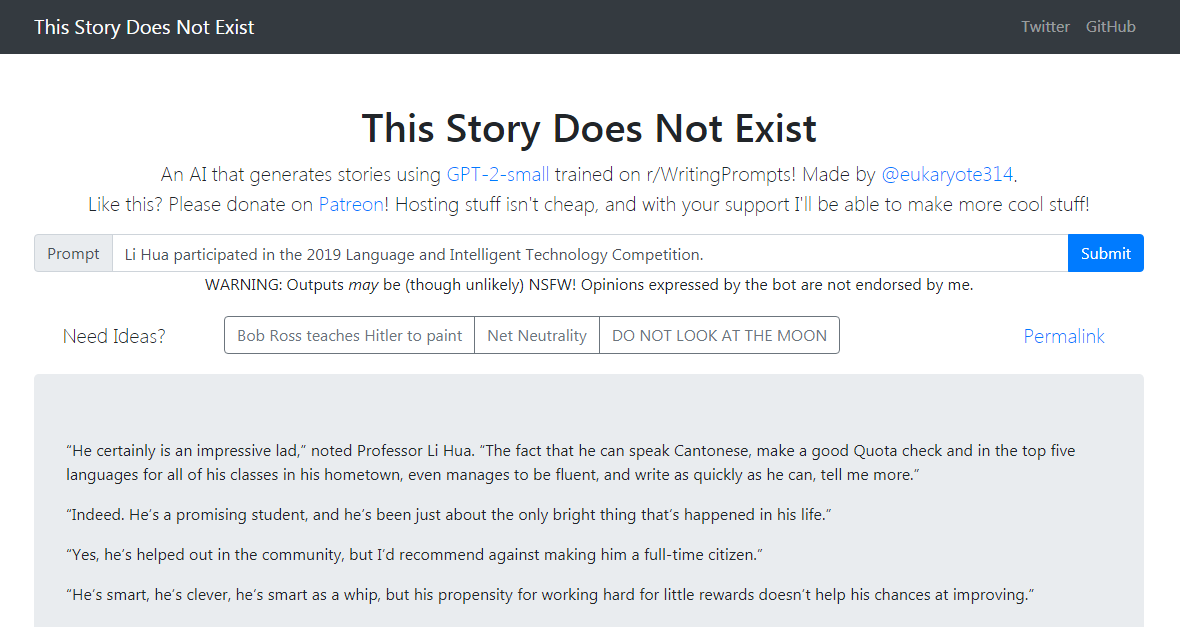

La demostración de GPT-2-simple escribe una historia de seguimiento basada en el texto de entrada actual. La demostración de GPT-2-simple escribe una historia de seguimiento basada en el texto de entrada actual.

Haga clic para experimentar Haga clic en Demo de Simple GPT-2

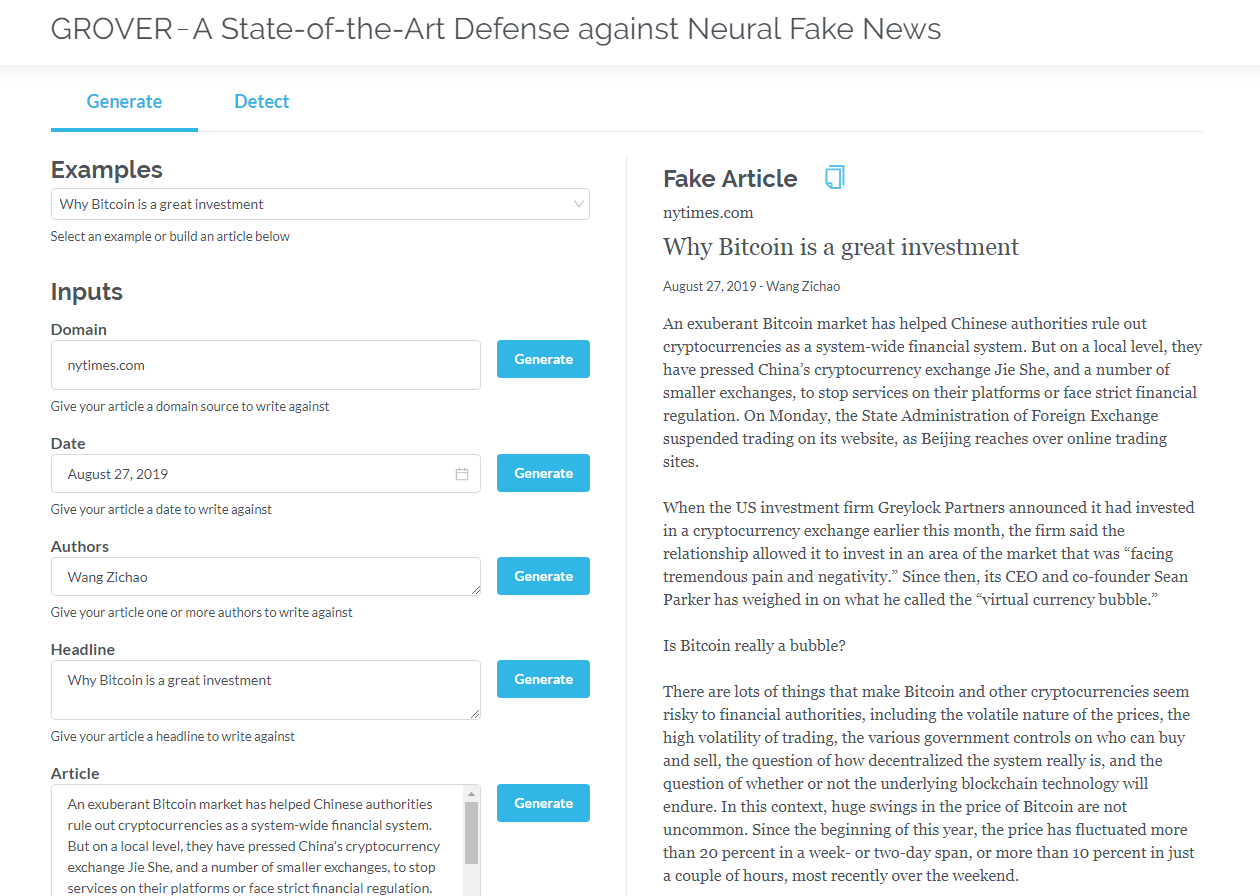

Grover es un modelo para noticias falsas neuronales, tanto generación como detección. Grover es un modelo para noticias falsas neuronales: generación y detección.

Genere artículos basados en información como el título, el autor y más. Grover también puede detectar si la máquina genera texto.

Genere artículos basados en el título, el autor y otra información. Grover también puede detectar si el texto es generado por la máquina.

Haga clic en Grover

Haga clic para leer la versión en inglés

Los transformadores que solo contienen decodificadores (como GPT2) muestran constantemente prospectos de aplicaciones fuera del modelado de idiomas. En muchas aplicaciones, tales modelos han tenido éxito: traducción automática, generación de resumen automático, aprendizaje de transferencia y generación de música. Revisemos algunas de estas aplicaciones juntas.

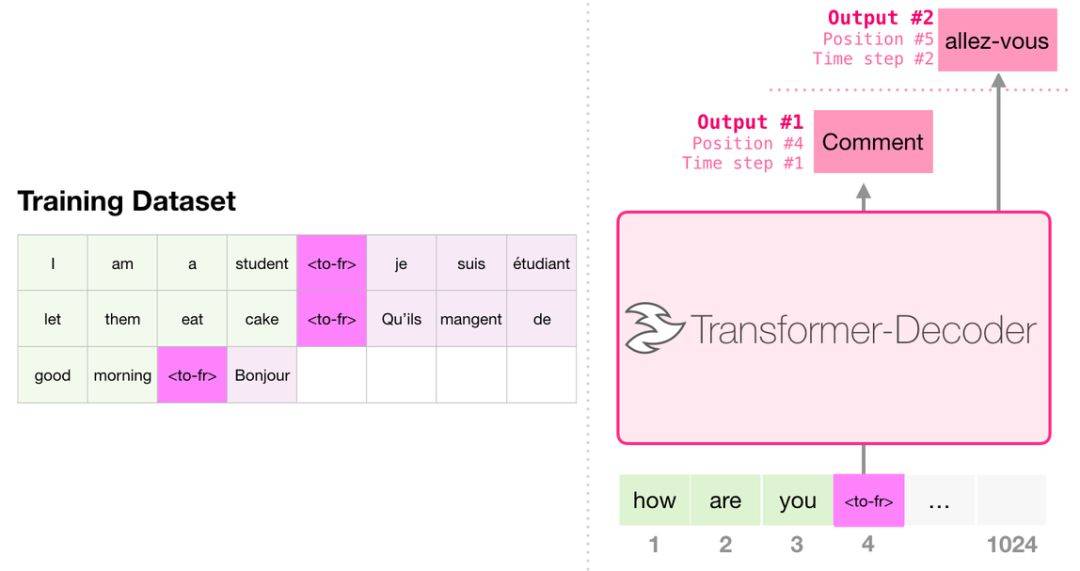

Al traducir, el modelo no requiere un codificador. La misma tarea puede resolverse mediante un transformador con solo decodificador:

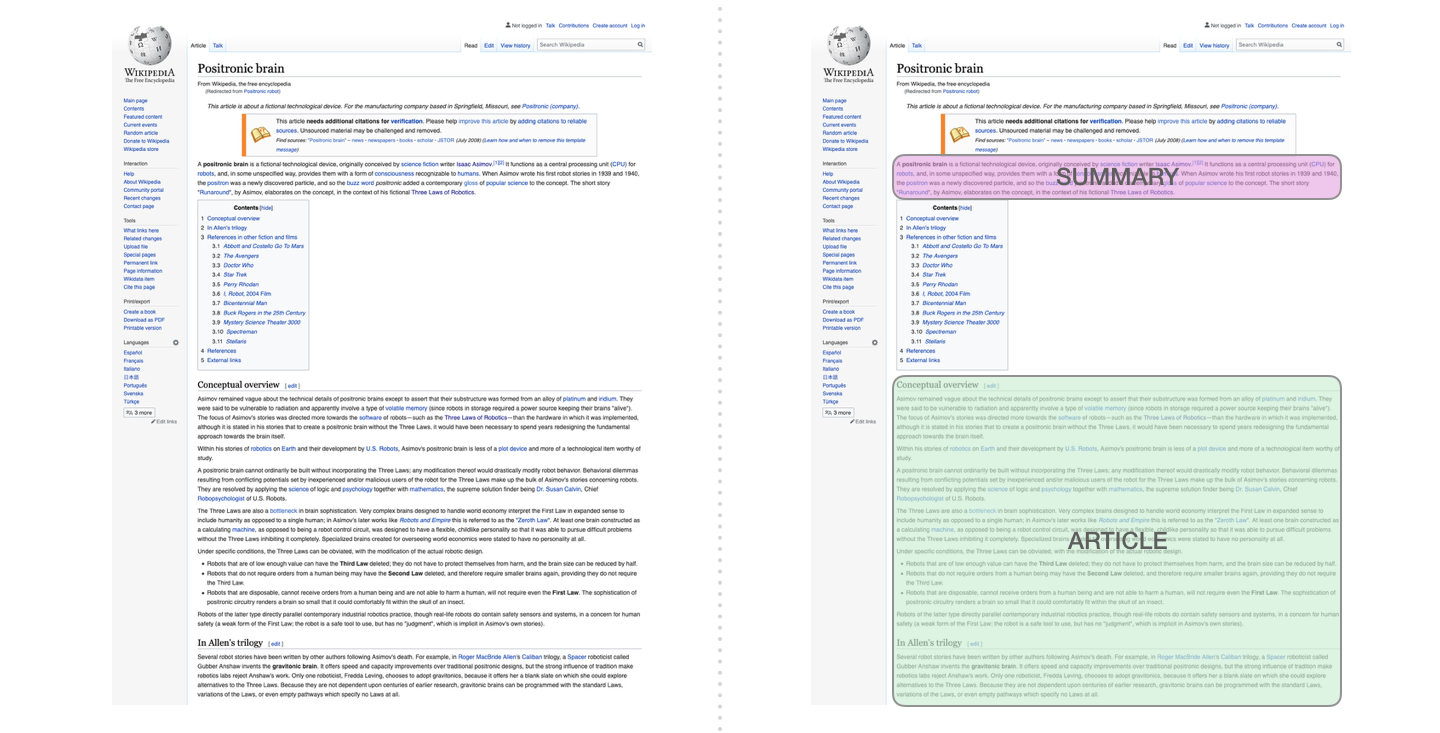

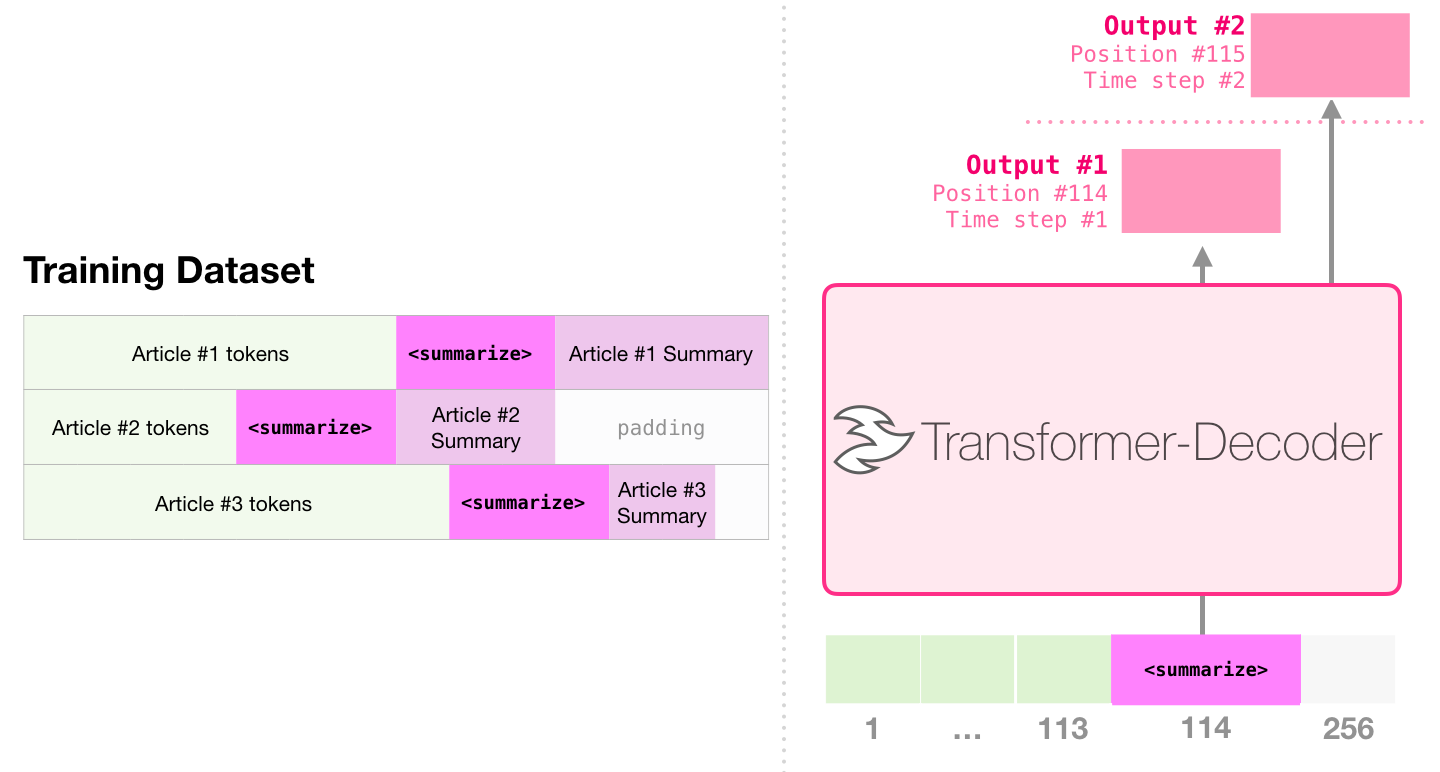

Esta es la primera tarea para entrenar un transformador que solo contiene el decodificador. Es decir, el modelo está entrenado para leer artículos de Wikipedia (sin el comienzo del directorio) y luego generar un resumen. El comienzo real del artículo se usa como etiqueta para el conjunto de datos de capacitación:

El documento utiliza artículos de Wikipedia para entrenar el modelo, y el modelo capacitado puede generar un resumen del artículo:

En la muestra de documento resumen de texto eficiente utilizando un solo transformador previamente capacitado, se realiza el primer pre-entrenamiento en la tarea de modelado de lenguaje utilizando transformadores que solo contienen decodificadores, y luego la tarea de generación de resumen se completa a través del ajuste. Los resultados muestran que en el caso de datos limitados, este esquema logra mejores resultados que el transformador de codificador del codificador previo. El documento de GPT2 también demuestra el efecto de generación abstracto obtenido después de la capacitación previa al modelo de modelado de idiomas.

Music Transformer utiliza transformadores que solo contienen decodificadores para generar música con ritmo rico y dinámica. Similar al modelado de idiomas, el "modelado de música" es dejar que el modelo aprenda música de manera no supervisada, y luego dejar que salga muestras (anteriormente llamamos "trabajo aleatorio").

GPT2 es solo una caída en el océano de los modelos basados en transformadores. Para las comparaciones de 15 modelos importantes basados en transformadores de 2018 a 2019, consulte la era posterior a Berten: análisis comparativo de 15 modelos previamente capacitados y exploración de puntos clave.