Der erste Teil dieser Ressourcenpool Zusammenfassung Die Ressourcen, mit denen die Aufgaben der Textgenerierung mithilfe des Sprachmodell GPT2, einschließlich Papieren, Code, Demo-Demos und praktischen Tutorials, verwendet werden. Der zweite Teil zeigt die Anwendung von GPT2 in den Aufgaben der Textgenerierung der maschinellen Übersetzung, der automatischen Zusammenfassungsgenerierung, der Migrationslernen und der Musikgenerierung. Schließlich werden die 15 wichtigsten Sprachmodelle, die auf Transformator zwischen 2018 und 2019 basieren, verglichen.

Der erste Teil dieser Ressourcensammlung fasst die Ressourcen zusammen, mit denen Textgenerierungsaufgaben mithilfe des Sprachmodells GPT2 gelöst werden können, einschließlich Papieren, Code, Präsentationsdemos und praktischen Tutorials. Der zweite Teil zeigt die Anwendung von GPT2 bei Aufgaben der Textgenerierung wie maschineller Übersetzung, automatischer Zusammenfassung der Generierung, Transferlernen und Musikgenerierung. Schließlich vergleichen wir die wichtigen 15 Sprachmodelle, die auf Transformator von 2018 bis 2019 basieren.

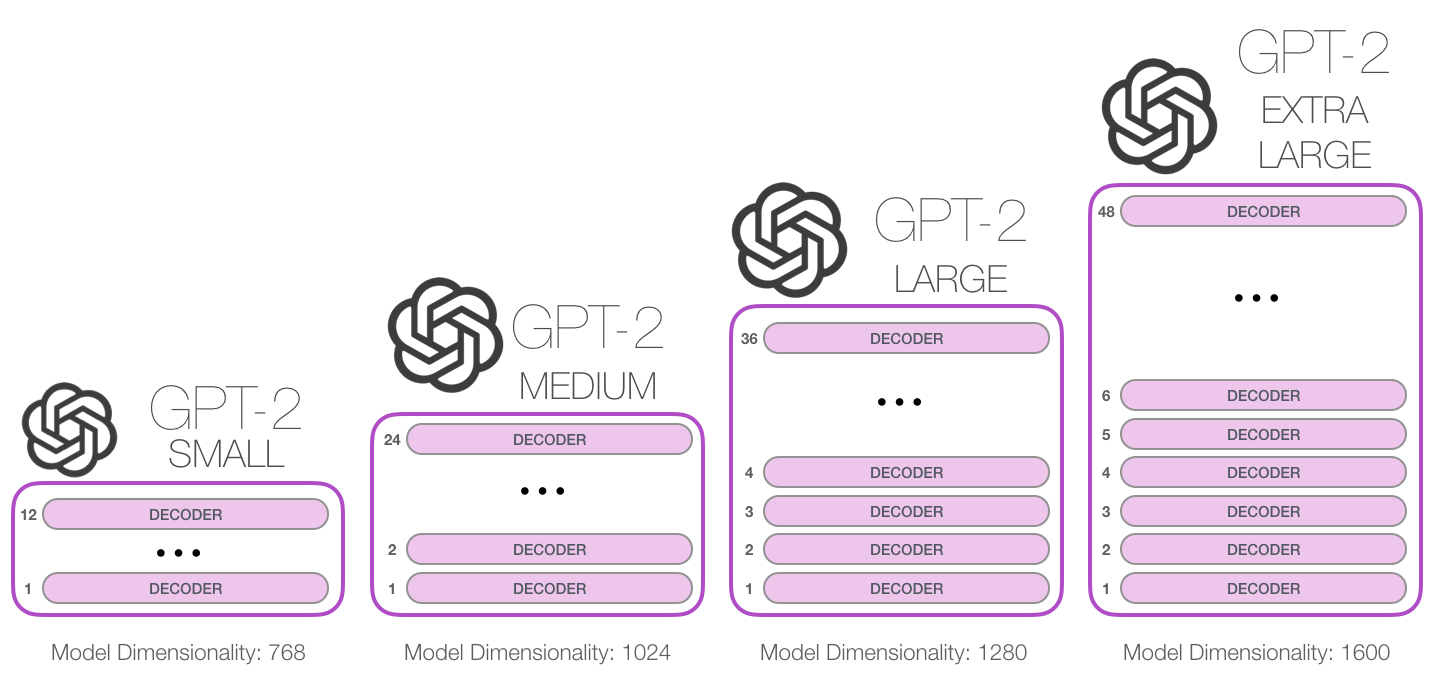

GPT-2 ist ein großes transformatorbasiertes Sprachmodell, das von OpenAI im Februar 2019 veröffentlicht wurde. Es enthält 1,5 Milliarden Parameter und wird in einem 8-Millionen-Web-Datensatz geschult. Berichten zufolge handelt es sich bei dem Modell um eine direkte Erweiterung des GPT -Modells, das mehr als das 10 -fache der Datenmenge, die Parametermenge, auch 10 -mal mehr. In Bezug auf die Leistung kann das Modell Koordinatenabsätze erstellen und die SOTA -Leistung bei vielen Langermodellierungs -Benchmarks erzielt. Darüber hinaus kann das Modell vorläufiges Leseverständnis, maschinelle Übersetzung, Frage und Antwort sowie automatische Zusammenfassung ohne aufgabenspezifisches Training durchführen.

GPT-2 ist ein großes transformatorbasiertes Sprachmodell, das von OpenAI im Februar 2019 veröffentlicht wurde. Es enthält 1,5 Milliarden Parameter und wird auf einem 8-Millionen-Webseiten-Datensatz geschult. Berichten zufolge handelt es sich bei diesem Modell um eine direkte Erweiterung des GPT -Modells, die mehr als das 10 -fache der Datenmenge geschult und die Anzahl der Parameter zehnmal mehr beträgt. In Bezug auf die Leistung ist das Modell in der Lage, kohärente Textabsätze zu erstellen und die SOTA -Leistung bei vielen Langermodellierungsbenchmarks zu erzielen. Darüber hinaus kann das Modell ein vorläufiges Leseverständnis, maschinelle Übersetzung, Frage-und-Antwort-und automatische Zusammenfassung ohne aufgabenspezifische Schulung erreichen.

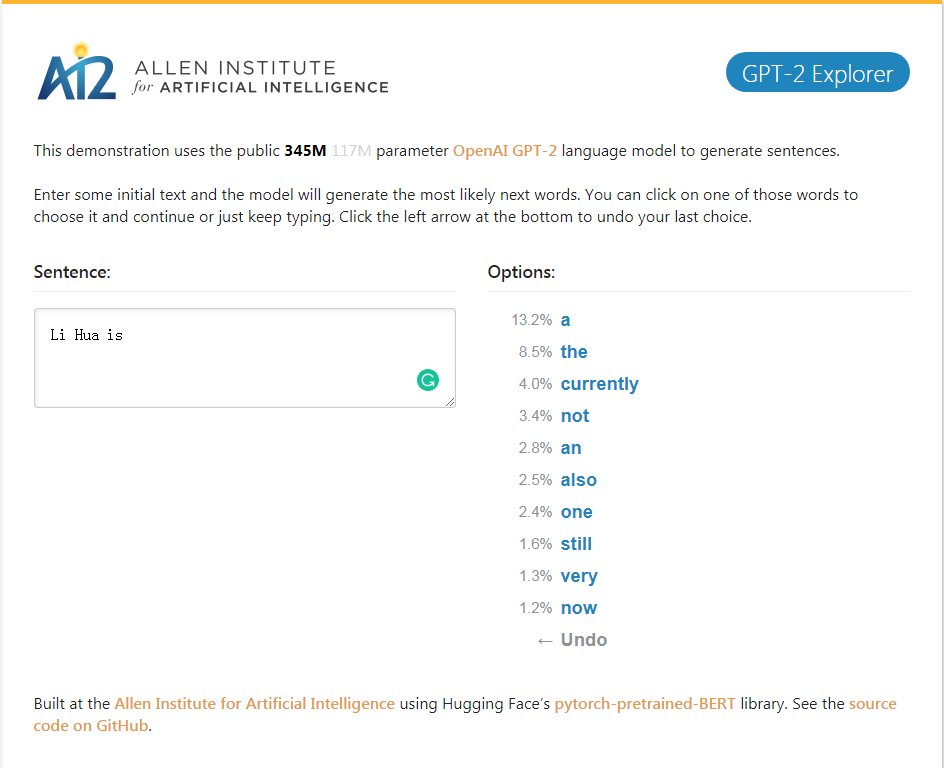

GPT-2_EXPLORER-Demo Es kann die nächsten zehn Wörter des Möglichkeitsrankings und deren entsprechenden Wahrscheinlichkeiten gemäß dem aktuell Eingabetxt geben. Sie können eines der Wörter auswählen, dann die Liste des nächsten möglichen Wortes usw. sehen und schließlich eine vervollständigen. Artikel.

GPT-2_EXPLORER-Demo Es kann das Top Ten nächste Wort im möglichen Bereich und seine entsprechende Wahrscheinlichkeit basierend auf dem aktuell eingegebenen Text geben. Sie können eines der Wörter auswählen und eine Liste der nächsten möglichen Wörter sehen. Dies wird immer und immer wieder wiederholt und schließlich einen Artikel abschließen.

Klicken Sie auf die GPT-2-Explorer-Demo

GPT-2-Simple Python-Paket, um das GPT-2-Erzeugermodell von OpenAI für neue Texte problemlos zu übernehmen.

Das Python-Paket von GPT-2-Simple kann das GPT-2-Textgenerierungsmodell von OpenAI auf neuem Text problemlos wiederholen.

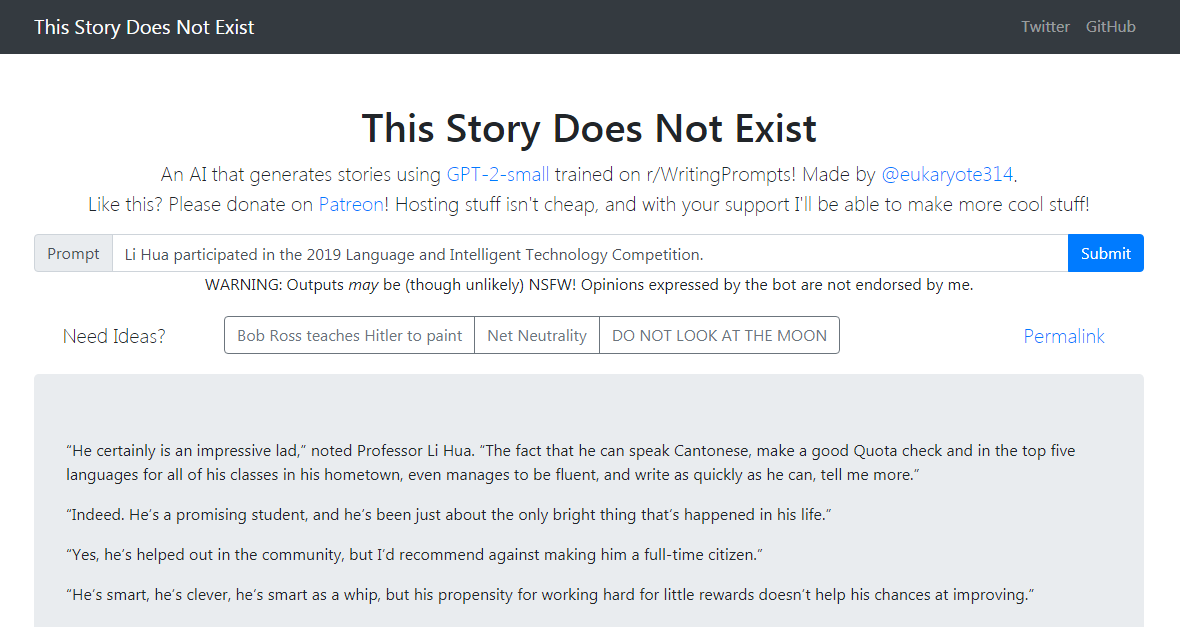

Die GPT-2-Simple-Demo schreibt eine Folgegeschichte, die auf dem aktuellen Eingabetxt basiert. Die GPT-2-Simple-Demo schreibt eine Folgegeschichte, die auf dem aktuellen Eingabetxt basiert.

Klicken Sie hier

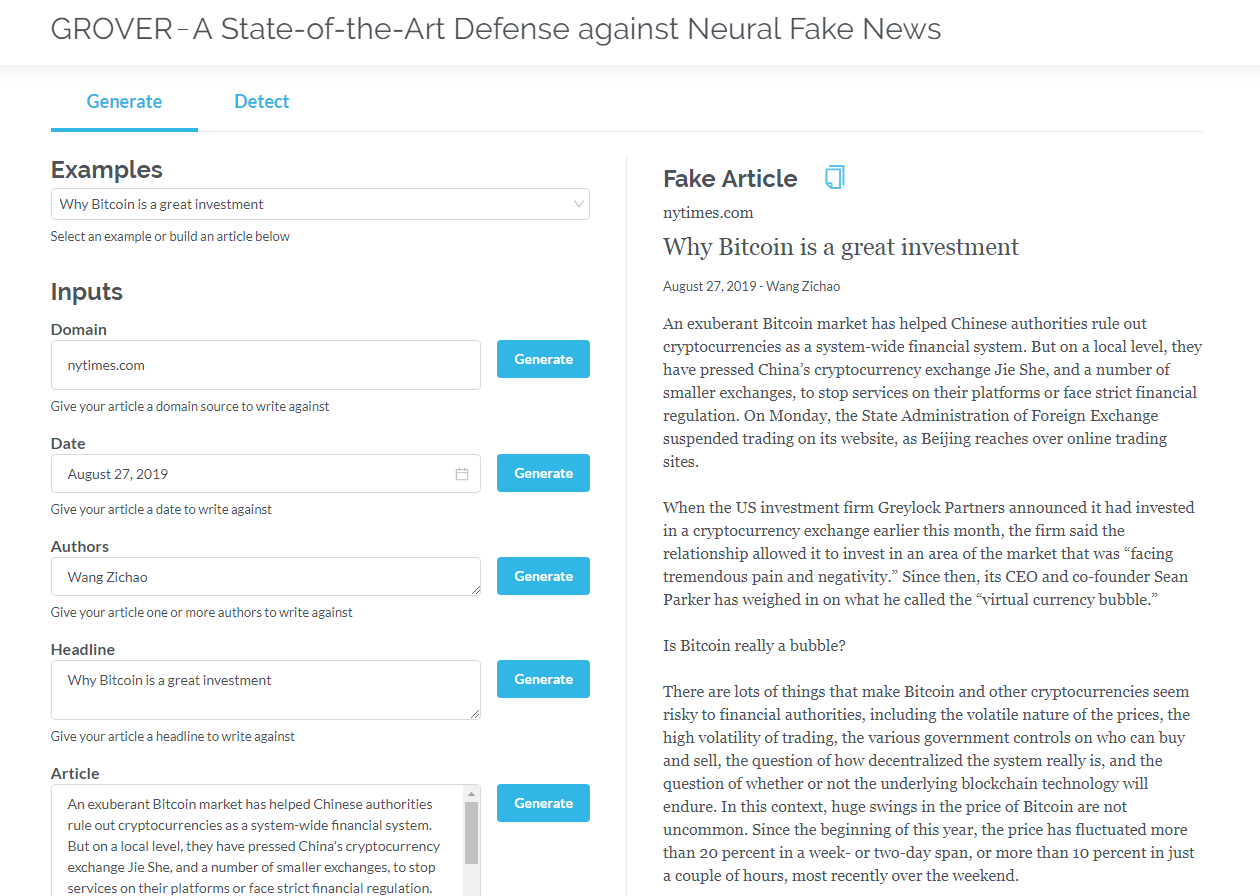

Grover ist ein Modell für neuronale gefälschte Nachrichten - sowohl Generation als auch Erkennung. Grover ist ein Modell für neuronale gefälschte Nachrichten - Generation und Erkennung.

Generieren Sie Artikel basierend auf Informationen wie Titel, Autor und mehr. Grover kann auch erkennen, ob der Text von der Maschine generiert wird.

Generieren Sie Artikel basierend auf Titel, Autor und anderen Informationen. Grover kann auch erkennen, ob der Text von der Maschine erzeugt wird.

Klicken Sie auf Grover

Klicken Sie hier, um die englische Version zu lesen

Transformatoren, die nur Decoder (wie GPT2) enthalten, zeigen ständig Anwendungsaussichten außerhalb der Sprachmodellierung. In vielen Anwendungen waren solche Modelle erfolgreich: maschinelle Übersetzung, automatische Zusammenfassungsgenerierung, Transferlernen und Musikgenerierung. Lassen Sie uns einige dieser Anwendungen gemeinsam überprüfen.

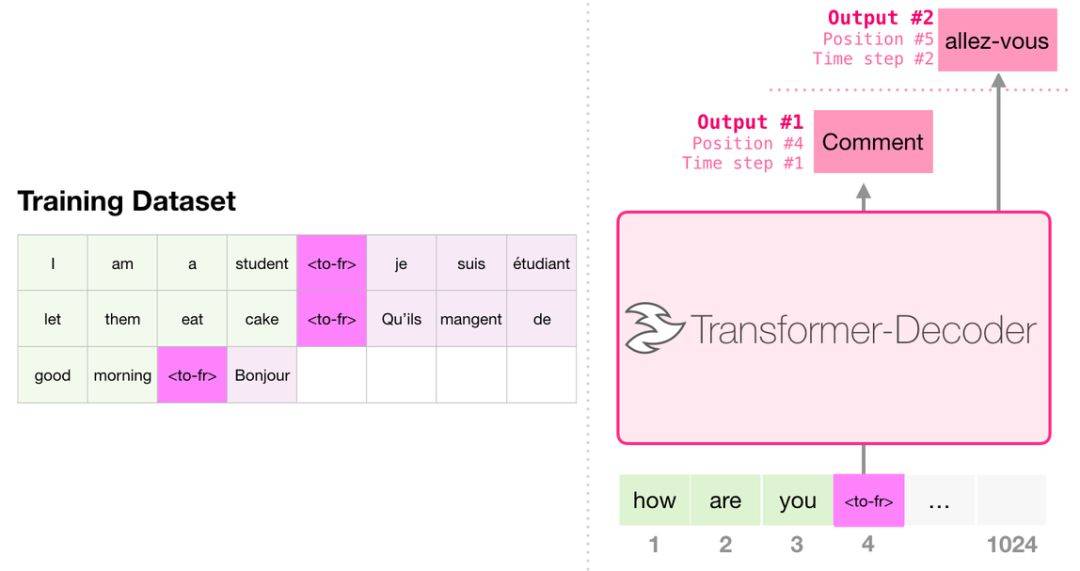

Bei der Übersetzung benötigt das Modell keinen Encoder. Die gleiche Aufgabe kann von einem Transformator mit nur Decoder gelöst werden:

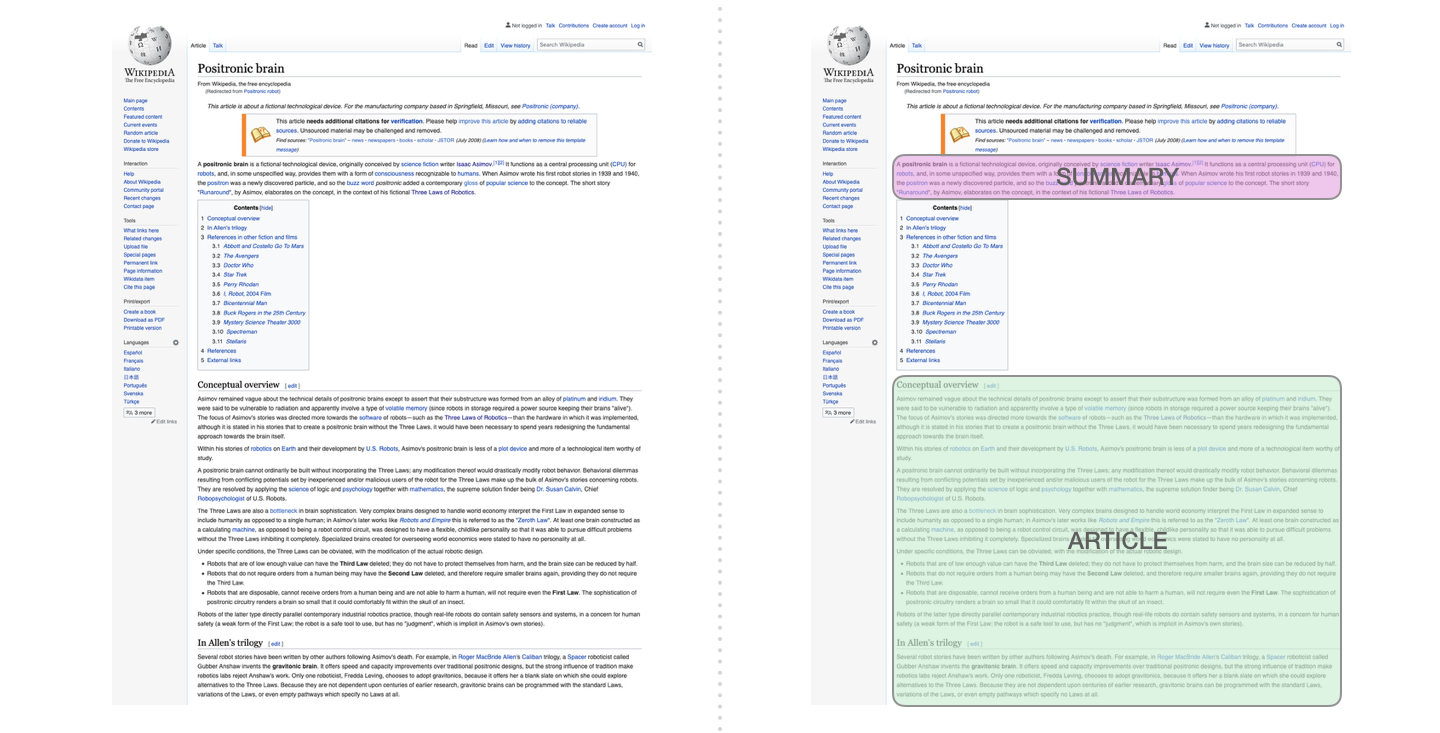

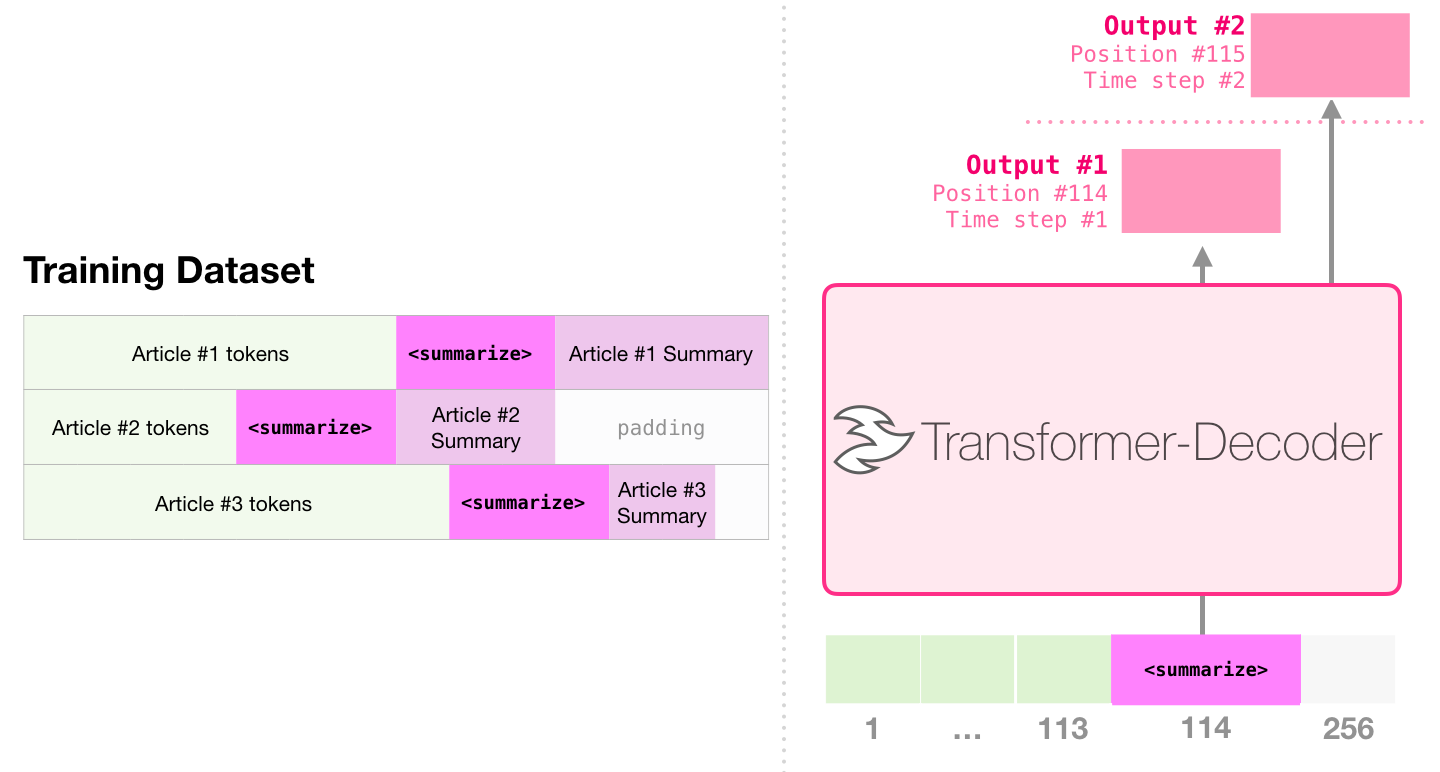

Dies ist die erste Aufgabe, die einen Transformator trainiert, der nur den Decoder enthält. Das heißt, das Modell ist ausgebildet, um Wikipedia -Artikel (ohne den Beginn des Verzeichnisses) zu lesen und dann eine Zusammenfassung zu erstellen. Der tatsächliche Beginn des Artikels wird als Etikett für den Trainingsdatensatz verwendet:

Das Papier verwendet Wikipedia -Artikel, um das Modell zu trainieren, und das geschulte Modell kann ein Zusammenfassung des Artikels erzeugen:

In der papierprobe effizienten Textübersicht unter Verwendung eines einzelnen vorgebreiteten Transformators wird zuerst vor der Ausbildung in der Sprachmodellierungsaufgabe unter Verwendung von Transformatoren durchgeführt, die nur Decoder enthalten, und dann wird die Aufgabe der Zusammenfassung der Erzeugungsaufgabe durch Tuning abgeschlossen. Die Ergebnisse zeigen, dass dieses Schema bei begrenzten Daten bessere Ergebnisse erzielt als ein vorbereiteter Encoder-Decoder-Transformator. Das Papier von GPT2 zeigt auch den nach dem Training des Sprachmodellierungsmodell erzielten Abstract-Erzeugungseffekts.

Music Transformer verwendet Transformatoren, die nur Decoder enthalten, um Musik mit reichen Rhythmus und Dynamik zu erzeugen. Ähnlich wie bei der Sprachmodellierung besteht "Musikmodellierung" darin, das Modell auf unbeaufsichtigte Weise Musik zu lernen und dann Beispiele auszugeben (wir haben zuvor "zufällige Arbeit" bezeichnet).

GPT2 ist nur ein Tropfen im Ozean der transformatorbasierten Modelle. Für Vergleiche von 15 wichtigen Transformator-basierten Modellen von 2018 bis 2019 finden Sie in der ERA nach der Nachberper: Vergleichende Analyse von 15 vorgebauten Modellen und wichtigen Punkten.