บันทึก

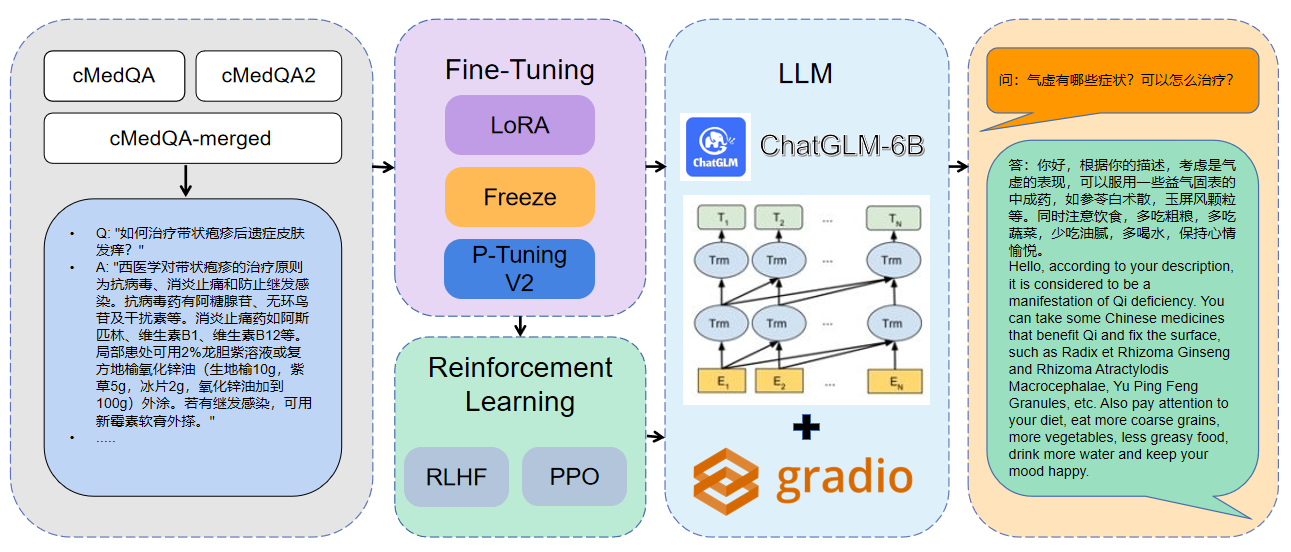

ยินดีต้อนรับสู่ผลงานล่าสุดของเรา: Carellama (Care Alpaca) รูปแบบภาษาขนาดใหญ่ทางการแพทย์ที่รวมชุดข้อมูลการปรับแต่งทางการแพทย์ที่เปิดเผยต่อสาธารณะหลายสิบชุด

1 ข้อมูลที่ใช้คือ cmedqa2

| โครงการ | ชุดข้อมูล | รุ่นฐาน |

|---|---|---|

| พูดคุย | Consult มีการให้คำปรึกษาออนไลน์ 50W + + CHATGPT ตอบกลับการวินิจฉัยการแพทย์จีนโบราณและชุดข้อมูลการรักษายังไม่ได้รับการเผยแพร่ | LLAMA-7B |

| Chatdoctor | HealthCaremagic-100K มีชุดข้อมูลการสนทนาผู้ป่วย-ผู้ป่วยจริง 100K+ จริง, ICLINIQ-10K ประกอบด้วยชุดข้อมูลการสนทนา 10K+ ผู้ป่วย--ด็อกต์, GenMedGPT-5K ประกอบด้วยชุดข้อมูลบทสนทนาของผู้ป่วย 5K+ | LLAMA-7B |

| Med-Chatglm | Huatuo-data, huatuo-liver-cancer | chatglm-6b |

| Huatuo-llama-med-chinese | Huatuo-data, huatuo-liver-cancer | LLAMA-7B |

| DoctorGLM | CMD., MedDialog, ชุดข้อมูลโครงการ ChatDoctor | chatglm-6b |

| Medicalgpt-ZH | ข้อมูลไม่ใช่โอเพ่นซอร์ส | chatglm-6b |

| Dr.llama | ลาม่า | |

| Medical_NLP 2 | - | - |

| CMCQA 3 | - | - |

| Qizhengpt | - | - |

| llm-pretrain-finetune | - | - |

| PMC-llama | - | LLAMA-7B |

| เบียน | - | - |

| Medalpaca | - | LLAMA-7B |

| แพทย์ | - | - |

| llm-pretrain-finetune | - | - |

| Shennong-tcm-llm | - | - |

| Sunsimiao | - | - |

| cmlm-zhongjing | - | - |

| จงจิง | - | - |

| หมิง | - | - |

| แผ่นดิสก์-Medllm | - | - |

pip install - r requirements . txt CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / finetune . py

- - do_train

- - dataset merged - cMedQA

- - finetuning_type lora

- - output_dir . / med - lora

- - per_device_train_batch_size 32

- - gradient_accumulation_steps 256

- - lr_scheduler_type cosine

- - logging_steps 500

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 10.0

- - fp16 CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / finetune . py

- - do_train

- - dataset merged - cMedQA

- - finetuning_type freeze

- - output_dir . / med - freeze

- - per_device_train_batch_size 32

- - gradient_accumulation_steps 256

- - lr_scheduler_type cosine

- - logging_steps 500

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 10.0

- - fp16 CUDA_VISIBLE_DEVICES = 1 python MedQA - ChatGLM / finetune . py

- - do_train - - dataset merged - cMedQA

- - finetuning_type p_tuning

- - output_dir . / med - p_tuning

- - per_device_train_batch_size 32

- - gradient_accumulation_steps 256

- - lr_scheduler_type cosine

- - logging_steps 500

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 10.0

- - fp16สำหรับข้อมูลพารามิเตอร์เพิ่มเติมคุณสามารถดูคำอธิบายโดยละเอียดของ docs/parameters.md

การฝึกอบรมแบบกระจายหลาย GPU:

# 配置分布式参数

accelerate config

# 分布式训练

accelerate launch src / finetune . py

- - do_train

- - dataset Huatuo , CMD , MedDialog , guanaco , cognition

- - finetuning_type lora

- - output_dir med - lora

- - per_device_train_batch_size 16

- - gradient_accumulation_steps 4

- - lr_scheduler_type cosine

- - logging_steps 10

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 3.0

- - fp16

- - ddp_find_unused_parameters False # 分布式训练时,LoRA微调需要添加防止报错

- - plot_loss CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / web_demo . py

- - checkpoint_dir med - lora /

( med - freez / )

( med - p_tuning / ) CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / infer . py

- - checkpoint_dir med - lora /

( med - freez / )

( med - p_tuning / )รวมโมเดล:

CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / export_weights . py

- - finetuning_weights_path . / med - lora

- - save_weights_path . / save_loraกำลังโหลดโมเดลที่ผสาน:

CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / load_export_weights . py

- - save_weights_path . / save_lora| วิธีการปรับแต่ง | น้ำหนักแบบจำลอง | ระยะเวลาการฝึกอบรม | รอบฝึกซ้อม |

|---|---|---|---|

| Lora | Medqa-Chatglm-Lora | 28h | 10 |

| P-tuning v2 | medqa-chatglm-ptuningv2 | 27h | 10 |

| แช่แข็ง | medqa-chatglm freeze | 28h | 10 |

* การทดลองดำเนินการในระบบ Linux, A100 (1x, 80GB)

ทรัพยากรที่เกี่ยวข้องกับโครงการนี้มีไว้สำหรับการวิจัยเชิงวิชาการเท่านั้นและห้ามมิให้มีวัตถุประสงค์เชิงพาณิชย์อย่างเคร่งครัด เมื่อใช้ชิ้นส่วนที่เกี่ยวข้องกับรหัสบุคคลที่สามโปรดติดตามโปรโตคอลโอเพ่นซอร์สที่สอดคล้องกันอย่างเคร่งครัด เนื้อหาที่สร้างขึ้นโดยแบบจำลองได้รับผลกระทบจากปัจจัยต่าง ๆ เช่นการคำนวณแบบจำลองการสุ่มและการสูญเสียความแม่นยำเชิงปริมาณและโครงการนี้ไม่สามารถรับประกันความถูกต้องได้ ชุดข้อมูลส่วนใหญ่ของโครงการนี้สร้างขึ้นโดยแบบจำลองและไม่สามารถใช้เป็นพื้นฐานสำหรับการวินิจฉัยทางการแพทย์ที่แท้จริงแม้ว่าพวกเขาจะปฏิบัติตามข้อเท็จจริงทางการแพทย์บางอย่าง โครงการนี้จะไม่มีความรับผิดทางกฎหมายสำหรับการส่งออกเนื้อหาใด ๆ โดยแบบจำลองและไม่รับผิดชอบต่อการสูญเสียใด ๆ ที่อาจเกิดขึ้นจากการใช้ทรัพยากรที่เกี่ยวข้องและผลลัพธ์ผลลัพธ์