ملحوظة

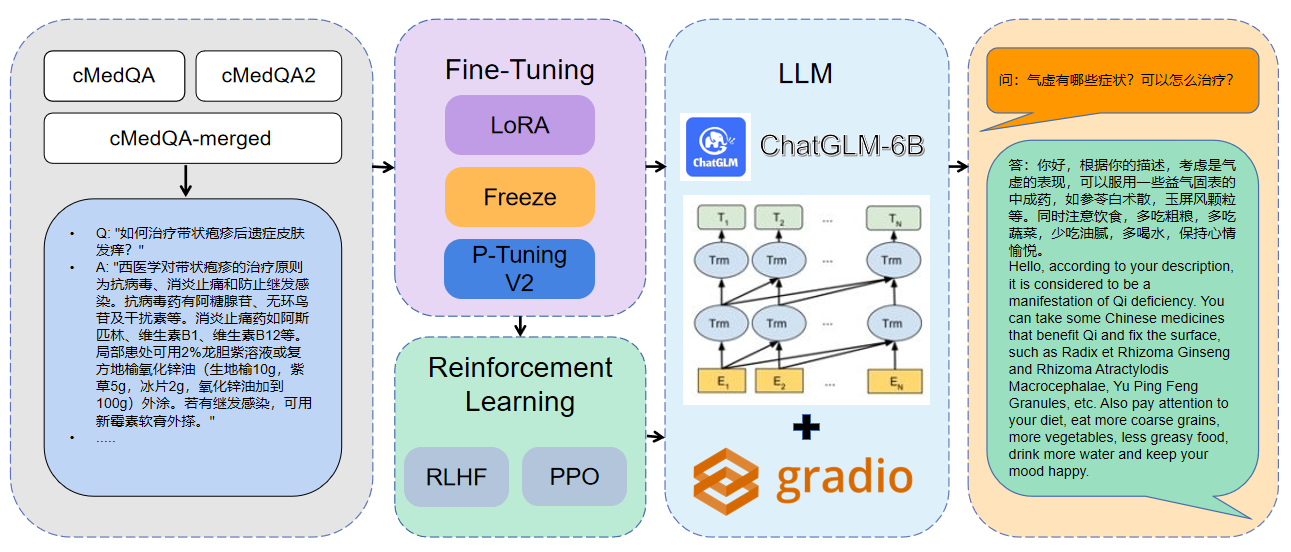

مرحبًا بكم في أحدث أعمالنا: Carellama (Care Alpaca) ، وهو نموذج لغة طبية كبيرة يجمع بين العشرات من مجموعات البيانات الطبية المتاحة للجمهور ونماذج لغة طبية كبيرة متوفرة للترويج للتطور السريع لـ Medical LLM:

1 البيانات المستخدمة هي CMEDQA2

| مشروع | مجموعة البيانات | نموذج قاعدة |

|---|---|---|

| chatmed | استشارة تحتوي على 50 واط + استشارة عبر الإنترنت + atchgpt رد ، لم يتم نشر مجموعة بيانات الطب الصينية التقليدية TCM | لاما -7 ب |

| Chatdoctor | HealthCaremagic-100K يحتوي على 100K+ مجموعة بيانات حوار حقيقية للمريض ، ICLINIQ-10K يحتوي على 10K+ مجموعة بيانات حوار المريض ، GENMEDGPT-5K يحتوي | لاما -7 ب |

| Med-Chatglm | Huatuo-data ، Huatuo-Liver-Cancer | ChatGlm-6b |

| Huatuo-llama-med-chinese | Huatuo-data ، Huatuo-Liver-Cancer | لاما -7 ب |

| DoctorGlm | CMD. ، Meddialog ، ChatDoctor Project | ChatGlm-6b |

| MedicalGPT-ZH | البيانات ليست مفتوحة المصدر | ChatGlm-6b |

| Dr.llama | لاما | |

| medical_nlp 2 | - | - |

| CMCQA 3 | - | - |

| Qizhengpt | - | - |

| LLM-pretrain-finetune | - | - |

| PMC-llama | - | لاما -7 ب |

| بيانك | - | - |

| ميدالباكا | - | لاما -7 ب |

| medicalgpt | - | - |

| LLM-pretrain-finetune | - | - |

| Shennong-TCM-LLM | - | - |

| صنسيميا | - | - |

| CMLM-Zhongjing | - | - |

| Zhongjing | - | - |

| مينغ | - | - |

| قرص medllm | - | - |

pip install - r requirements . txt CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / finetune . py

- - do_train

- - dataset merged - cMedQA

- - finetuning_type lora

- - output_dir . / med - lora

- - per_device_train_batch_size 32

- - gradient_accumulation_steps 256

- - lr_scheduler_type cosine

- - logging_steps 500

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 10.0

- - fp16 CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / finetune . py

- - do_train

- - dataset merged - cMedQA

- - finetuning_type freeze

- - output_dir . / med - freeze

- - per_device_train_batch_size 32

- - gradient_accumulation_steps 256

- - lr_scheduler_type cosine

- - logging_steps 500

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 10.0

- - fp16 CUDA_VISIBLE_DEVICES = 1 python MedQA - ChatGLM / finetune . py

- - do_train - - dataset merged - cMedQA

- - finetuning_type p_tuning

- - output_dir . / med - p_tuning

- - per_device_train_batch_size 32

- - gradient_accumulation_steps 256

- - lr_scheduler_type cosine

- - logging_steps 500

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 10.0

- - fp16لمزيد من معلومات المعلمة ، يمكنك عرض التفسير التفصيلي للمستندات/المعلمات.

التدريب المتعدد GPU الموزعة:

# 配置分布式参数

accelerate config

# 分布式训练

accelerate launch src / finetune . py

- - do_train

- - dataset Huatuo , CMD , MedDialog , guanaco , cognition

- - finetuning_type lora

- - output_dir med - lora

- - per_device_train_batch_size 16

- - gradient_accumulation_steps 4

- - lr_scheduler_type cosine

- - logging_steps 10

- - save_steps 1000

- - learning_rate 5e-5

- - num_train_epochs 3.0

- - fp16

- - ddp_find_unused_parameters False # 分布式训练时,LoRA微调需要添加防止报错

- - plot_loss CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / web_demo . py

- - checkpoint_dir med - lora /

( med - freez / )

( med - p_tuning / ) CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / infer . py

- - checkpoint_dir med - lora /

( med - freez / )

( med - p_tuning / )دمج النموذج:

CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / export_weights . py

- - finetuning_weights_path . / med - lora

- - save_weights_path . / save_loraتحميل النموذج المدمج:

CUDA_VISIBLE_DEVICES = 0 python MedQA - ChatGLM / load_export_weights . py

- - save_weights_path . / save_lora| طريقة الضبط | وزن النموذج | مدة التدريب | جولات التدريب |

|---|---|---|---|

| لورا | Medqa-Chatglm-Lora | 28H | 10 |

| P Tuning V2 | Medqa-Chatglm-Ptuningv2 | 27 ساعة | 10 |

| تجميد | Medqa-Chatglm Freeze | 28H | 10 |

* تم إجراء التجربة على نظام Linux ، A100 (1x ، 80 جيجابايت)

الموارد المتعلقة بهذا المشروع مخصصة للبحث الأكاديمي فقط وهي محظورة بشكل صارم لأغراض تجارية. عند استخدام أجزاء تتضمن رمز الطرف الثالث ، يرجى متابعة بروتوكول المصدر المفتوح المقابل. يتأثر المحتوى الناتج عن النموذج بعوامل مثل حساب النماذج والعشوائية وخسائر الدقة الكمية ، ولا يمكن أن يضمن هذا المشروع دقته. يتم إنشاء معظم مجموعات البيانات في هذا المشروع بواسطة النماذج ولا يمكن استخدامها كأساس للتشخيص الطبي الفعلي حتى لو كانت تتوافق مع بعض الحقائق الطبية. لا يتحمل هذا المشروع أي مسؤولية قانونية عن أي إخراج للمحتوى حسب النموذج ، كما أنه لا يتحمل أي خسائر قد تنشأ عن استخدام الموارد ذات الصلة ونتائج الإخراج.