- - - 中文文档

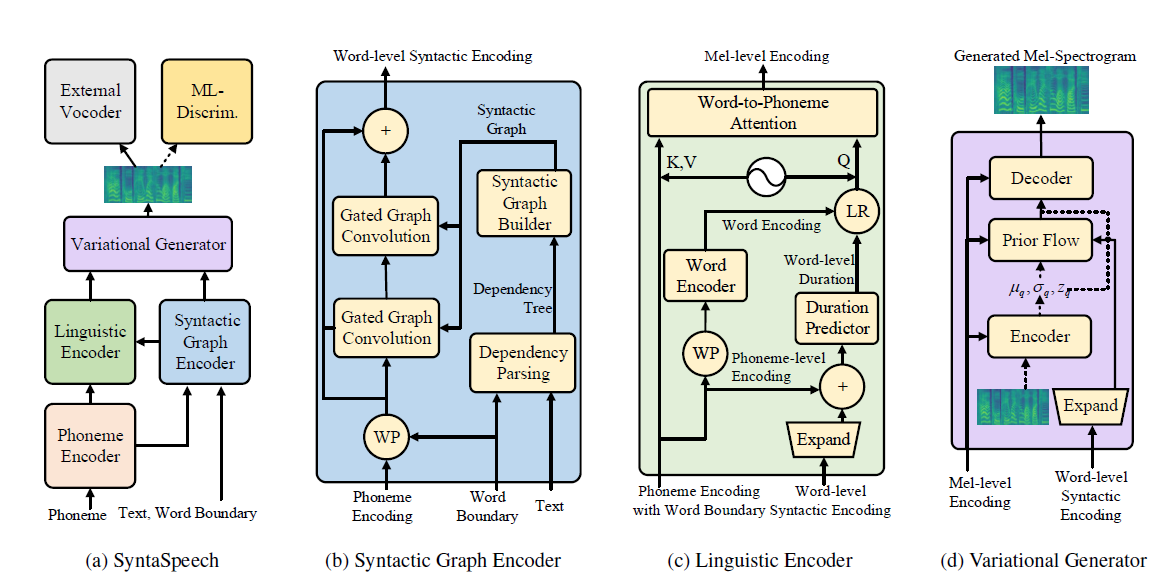

พื้นที่เก็บข้อมูลนี้คือการใช้งาน Pytorch อย่างเป็นทางการของกระดาษ IJCAI-20122 ของเราซึ่งเราเสนอ Syntaspeech สำหรับไวยากรณ์ที่ไม่ใช่ข้อความที่ไม่ใช่ข้อความ

syntaspeech ของเราสร้างขึ้นบนพื้นฐานของ Portaspeech (Neurips 2021) ด้วยคุณสมบัติใหม่สามประการ:

conda create -n synta python=3.7

condac activate synta

pip install -U pip

pip install Cython numpy==1.19.1

pip install torch==1.9.0

pip install -r requirements.txt

# install dgl for graph neural network, dgl-cu102 supports rtx2080, dgl-cu113 support rtx3090

pip install dgl-cu102 dglgo -f https://data.dgl.ai/wheels/repo.html

sudo apt install -y sox libsox-fmt-mp3

bash mfa_usr/install_mfa.sh # install force alignment tools โปรดทำตามขั้นตอนต่อไปนี้เพื่อเรียกใช้ repo นี้

คุณสามารถใช้ชุดข้อมูล binarized ของเราโดยตรงสำหรับ ljspeech และ biaobei ดาวน์โหลดพวกเขาและคลายซิปลงใน data/binary/ โฟลเดอร์

สำหรับ Libritts คุณสามารถดาวน์โหลดชุดข้อมูล RAW และประมวลผลด้วยโมดูล data_gen ของเรา คำแนะนำโดยละเอียดสามารถพบได้ใน DOSC/PREPAL_DATA

เราจัดทำโมเดลที่ผ่านการฝึกอบรมมาก่อนสำหรับชุดข้อมูลสามชุด โดยเฉพาะ hifi-gan สำหรับ ljspeech และ biaobei, parallelwavegan สำหรับ Libritts ดาวน์โหลดและคลายซิปลงใน checkpoints/ โฟลเดอร์

จากนั้นคุณสามารถฝึกซ้อม syntaspeech ในชุดข้อมูลทั้งสาม

cd < the root_dir of your SyntaSpeech folder >

export PYTHONPATH=./

CUDA_VISIBLE_DEVICES=0 python tasks/run.py --config egs/tts/lj/synta.yaml --exp_name lj_synta --reset # training in LJSpeech

CUDA_VISIBLE_DEVICES=0 python tasks/run.py --config egs/tts/biaobei/synta.yaml --exp_name biaobei_synta --reset # training in Biaobei

CUDA_VISIBLE_DEVICES=0 python tasks/run.py --config egs/tts/libritts/synta.yaml --exp_name libritts_synta --reset # training in LibriTTStensorboard --logdir=checkpoints/lj_synta

tensorboard --logdir=checkpoints/biaobei_synta

tensorboard --logdir=checkpoints/libritts_syntaCUDA_VISIBLE_DEVICES=0 python tasks/run.py --config egs/tts/lj/synta.yaml --exp_name lj_synta --reset --infer # inference in LJSpeech

CUDA_VISIBLE_DEVICES=0 python tasks/run.py --config egs/tts/biaobei/synta.yaml --exp_name biaobei_synta --reset --infer # inference in Biaobei

CUDA_VISIBLE_DEVICES=0 python tasks/run.py --config egs/tts/libritts/synta.yaml --exp_name libritts_synta --reset ---infer # inference in LibriTTS ตัวอย่างเสียงในกระดาษสามารถพบได้ในหน้าตัวอย่างของเรา

นอกจากนี้เรายังมีหน้าการสาธิต HuggingFace สำหรับ LJSpeech ลองใช้ประโยคที่น่าสนใจของคุณที่นั่น!

@article{ye2022syntaspeech,

title={SyntaSpeech: Syntax-Aware Generative Adversarial Text-to-Speech},

author={Ye, Zhenhui and Zhao, Zhou and Ren, Yi and Wu, Fei},

journal={arXiv preprint arXiv:2204.11792},

year={2022}

}

รหัสของเราขึ้นอยู่กับ repos ต่อไปนี้: