Официальный веб-сайт www.binance.com/zh-cn :введите официальный веб-сайт ☜☜

Приложение: ☞☞official App Download☜☜

Недавно Алленский институт искусственного интеллекта (AI2) выпустил свою последнюю крупномасштабную языковую модель - OLMO232B. Эта модель не только представляет собой последние достижения серии OLMO2, но также выпускает мощные проблемы для этих закрытых проприетарных моделей с его «полностью открытым» отношением. Атрибуты с открытым исходным кодом OLMO232B являются наиболее привлекательной особенностью. AI2 щедро раскрывает все данные, код, веса и подробные учебные процессы, которые резко контрастируют с некоторыми моделями с замкнутым исходным кодом.

AI2 надеется продвигать более широкие исследования и инновации с помощью этого открытого и совместного подхода, позволяя исследователям по всему миру продолжать двигаться вперед на плечах OLMO232B. В эпоху обмена знаниями скрытие, очевидно, не является долгосрочным решением. Выпуск OLMO232B отмечает важную веху в пути развития открытого и доступного ИИ.

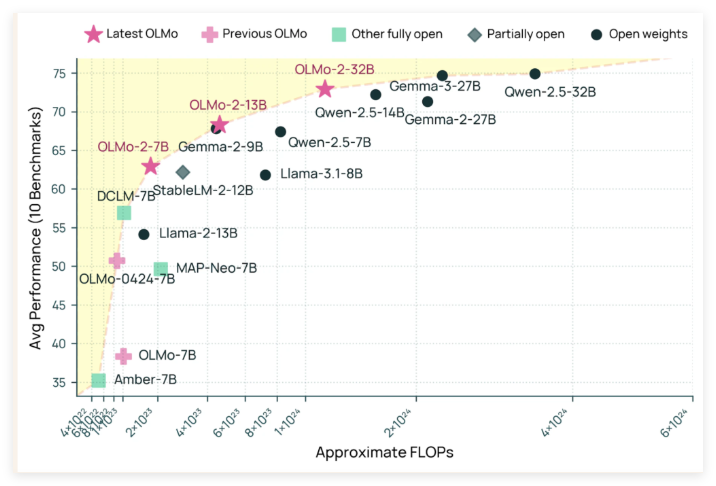

OLMO232B имеет 32 миллиарда параметров, что является значительным числом, что отмечает значительное увеличение масштаба по сравнению с предыдущим поколением. В ряде широко признанных академических показателей эта модель с открытым исходным кодом фактически превосходит MINI GPT-3.5Turbo и GPT-4O! Это, несомненно, внесло удар в сообщество ИИ с открытым исходным кодом, доказывая, что не только «богатые» учреждения могут создавать лучшие модели ИИ.

Причина, по которой OLMO232B может достичь таких впечатляющих результатов, неразделима от его тщательного обучения. Весь учебный процесс разделен на два основных этапа: предварительное обучение и среднесрочное обучение. На стадии предварительного обучения модель «Bited» огромный набор данных составляет около 3,9 триллионов токенов, которые широко источны, включая DCLM, Dolma, Starcoder и Proof Puil II. Это все равно, что позволить модели много читать и изучать широкий спектр языковых моделей.

Среднесрочное обучение фокусируется на наборе данных Dolmino, высококачественном наборе данных, содержащем 843 миллиарда токенов, охватывающий образование, математику и академическое содержание, что еще больше улучшает способность к пониманию модели в определенных областях. Этот поэтапный и целенаправленный метод обучения гарантирует, что OLMO232B может обладать прочные и тщательные языковые навыки.

В дополнение к своей превосходной производительности, OLMO232B также продемонстрировал удивительную силу в эффективности тренировок. Говорят, что он использовал только около трети вычислительных ресурсов, одновременно достигая уровней производительности, сравнимой с ведущей моделью открытого веса, по сравнению с такими моделями, как QWEN2,532B, требуют большей вычислительной мощности. Это как эффективный ремесленник, который завершил ту же или даже лучшую работу с меньшим количеством инструментов и времени.

Выпуск OLMO232B является не только новой моделью ИИ, но также символизирует важную веху в пути разработки открытого и доступного ИИ. Предоставляя полностью открытое и способное решение, которое сравнимо или превышает некоторые проприетарные модели, AI2 настаивает на том, что тщательный дизайн модели и эффективные методы обучения могут привести к огромным прорывам. Эта открытость побуждает глобальных исследователей и разработчиков активно участвовать, совместно способствует прогрессу в области искусственного интеллекта и в конечном итоге принесет пользу всему человеческому обществу.

Можно предположить, что появление OLMO232B принесет свежий воздух в область исследований ИИ. Это не только снижает порог исследования, способствует более широкому сотрудничеству, но также показывает нам более динамичный и инновационный путь к разработке ИИ. Что касается тех гигантов ИИ, которые все еще плотно держат «эксклюзивный секретный рецепт», они также должны рассмотреть его. Только обнимая открытость, они могут выиграть более широкое будущее.

GitHub: https://github.com/allenai/olmo-core

Huggingface: https: //huggingface.co/allenai/olmo-2-0325-32b-instruct