최근 Allen Institute of Artificial Intelligence (AI2)는 최신 대규모 언어 모델 인 OLMO232B를 발표했습니다. 이 모델은 OLMO2 시리즈의 최신 성과를 나타내는 것뿐만 아니라 "완전히 개방적인"태도를 가진 폐쇄 된 독점 모델에 강력한 도전을 시작합니다. OLMO232B의 오픈 소스 속성은 가장 눈길을 끄는 기능입니다. AI2는 모든 데이터, 코드, 가중치 및 세부 교육 프로세스를 관대하게 공개하며, 이는 일부 폐쇄 소스 모델과 대조됩니다.

AI2는이 개방적이고 협력적인 접근 방식을 통해 더 넓은 연구와 혁신을 촉진하기를 희망하며, 전 세계의 연구자들이 OLMO232B의 어깨를 계속 발전시킬 수 있습니다. 지식 공유 시대에 숨어있는 것은 분명히 장기적인 해결책이 아닙니다. OLMO232B의 방출은 개방적이고 접근 가능한 AI의 개발 경로에서 중요한 이정표를 나타냅니다.

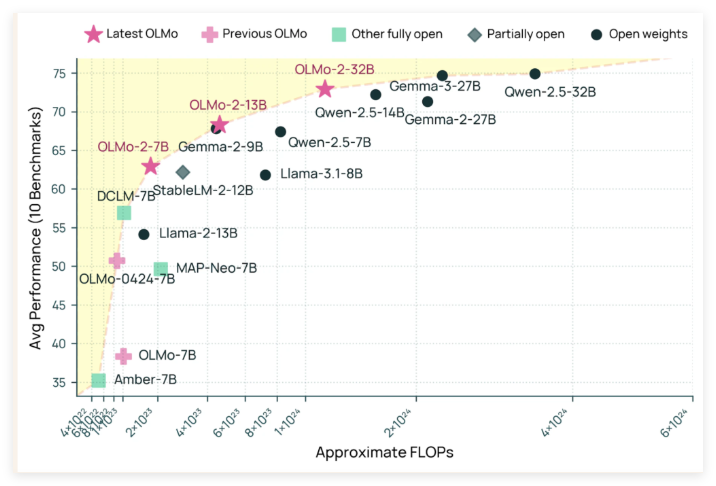

OLMO232B는 320 억 파라미터를 보유하고 있으며, 이는 상당한 수의 매개 변수를 보유하고 있으며, 이는 이전 세대에 비해 규모가 크게 증가했습니다. 널리 알려진 여러 학업 벤치 마크 에서이 오픈 소스 모델은 실제로 GPT-3.5Turbo 및 GPT-4O Mini를 능가합니다! 이것은 의심 할 여지없이 오픈 소스 AI 커뮤니티에 대한 강한 향상을 주입하여 "부유 한"기관뿐만 아니라 최고 AI 모델을 만들 수 있음을 증명했습니다.

OLMO232B가 그러한 인상적인 결과를 얻을 수있는 이유는 세심한 훈련 과정에서 분리 할 수 없습니다. 전체 교육 과정은 사전 훈련과 중기 훈련의 두 가지 주요 단계로 나뉩니다. 사전 훈련 단계에서,이 모델은 DCLM, Dolma, Starcoder 및 Proof Pile II를 포함하여 약 3.9 조 개의 토큰의 거대한 데이터 세트를 "사기"했습니다. 모델이 많이 읽고 광범위한 언어 패턴을 배우게하는 것과 같습니다.

중기 교육은 843 억 개의 토큰을 포함하는 고품질 데이터 세트 인 Dolmino Dataset, 교육, 수학 및 학업 내용을 포함하여 특정 분야에서 모델의 이해 능력을 더욱 향상시키는 데 중점을 둡니다. 이 단계적 및 집중된 교육 방법은 OLMO232B가 견고하고 세심한 언어 능력을 가질 수 있도록합니다.

OLMO232B는 우수한 성능 외에도 훈련 효율에 놀라운 강점을 보여주었습니다. QWEN2.532B와 같은 모델과 비교하여 선도적 인 오픈 웨이트 모델과 비교할 수있는 성능 수준에 도달하면서 컴퓨팅 리소스의 약 3 분의 1 만 사용했다고합니다. 그것은 도구와 시간이 적은 동일하거나 더 나은 작업을 완료 한 효율적인 장인과 같습니다.

OLMO232B의 출시는 새로운 AI 모델 일뿐 만 아니라 개방적이고 접근 가능한 AI의 개발 경로에서 중요한 이정표를 상징합니다. AI2는 일부 독점 모델과 비슷하거나 초과하는 완전히 개방적이고 유능한 솔루션을 제공함으로써 신중한 모델 설계와 효율적인 교육 방법이 큰 돌파구로 이어질 수 있음을 강력하게 보여줍니다. 이러한 개방성은 글로벌 연구원과 개발자가 적극적으로 참여하고 인공 지능 분야의 진보를 공동으로 홍보하며 궁극적으로 전체 인간 사회에 혜택을 주도록 장려 할 것입니다.

OLMO232B의 출현은 AI 연구 분야에 신선한 공기를 가져올 것임을 예견 할 수 있습니다. 그것은 연구 임계 값을 낮추고 더 넓은 협력을 촉진 할뿐만 아니라 AI 개발에 대한보다 역동적이고 혁신적인 경로를 보여줍니다. 여전히 "독점 비밀 레시피"를 단단히 보유하고있는 AI 자이언츠는 또한 고려해야합니다. 개방성을 포용함으로써 만 그들은 더 넓은 미래를 이길 수 있습니다.

github : https://github.com/allenai/olmo-core

Huggingface : https : //huggingface.co/allenai/olmo-2-0325-32b-instruct