Situs web resmi www.binance.com/zh-cn :Masukkan situs web resmi ☜☜

Aplikasi: ☞☞ Unduh Aplikasi Resmi☜☜

Baru -baru ini, Allen Institute of Artificial Intelligence (AI2) merilis model bahasa skala besar terbarunya - OLMO232B. Model ini tidak hanya mewakili pencapaian terbaru dari seri OLMO2, tetapi juga meluncurkan tantangan yang kuat untuk model -model berpemilik tertutup dengan sikap "sepenuhnya terbuka". Atribut open source OLMO232B adalah fitur yang paling menarik. AI2 dengan murah hati mengungkapkan semua data, kode, bobot dan proses pelatihan terperinci, yang sangat kontras dengan beberapa model sumber tertutup.

AI2 berharap untuk mempromosikan penelitian dan inovasi yang lebih luas melalui pendekatan terbuka dan kolaboratif ini, yang memungkinkan para peneliti di seluruh dunia untuk terus bergerak maju di pundak OLMO232B. Di era berbagi pengetahuan, persembunyian jelas bukan solusi jangka panjang. Rilis OLMO232B menandai tonggak penting dalam jalur pengembangan AI terbuka dan dapat diakses.

OLMO232B memiliki 32 miliar parameter, yang merupakan jumlah yang cukup besar, menandai peningkatan skala yang signifikan dibandingkan dengan generasi sebelumnya. Dalam sejumlah tolok ukur akademik yang diakui secara luas, model open source ini sebenarnya melampaui GPT-3.5turbo dan GPT-4O Mini! Ini tidak diragukan lagi menyuntikkan suntikan dorongan kuat ke komunitas AI open source, membuktikan bahwa tidak hanya lembaga "kaya" dapat membuat model AI top.

Alasan mengapa OLMO232B dapat mencapai hasil yang mengesankan seperti itu tidak dapat dipisahkan dari proses pelatihannya yang cermat. Seluruh proses pelatihan dibagi menjadi dua tahap utama: pelatihan pra-pelatihan dan jangka menengah. Selama tahap pra-pelatihan, model "menggigit" set data besar sekitar 3,9 triliun token, yang bersumber secara luas, termasuk DCLM, Dolma, Starcoder, dan Proof Pile II. Ini seperti membiarkan model membaca banyak dan mempelajari berbagai pola bahasa.

Pelatihan jangka menengah berfokus pada dataset Dolmino, dataset berkualitas tinggi yang berisi 843 miliar token, yang mencakup pendidikan, matematika dan konten akademik, lebih lanjut meningkatkan kemampuan pemahaman model dalam bidang tertentu. Metode pelatihan bertahap dan terfokus ini memastikan bahwa OLMO232B dapat memiliki keterampilan bahasa yang solid dan teliti.

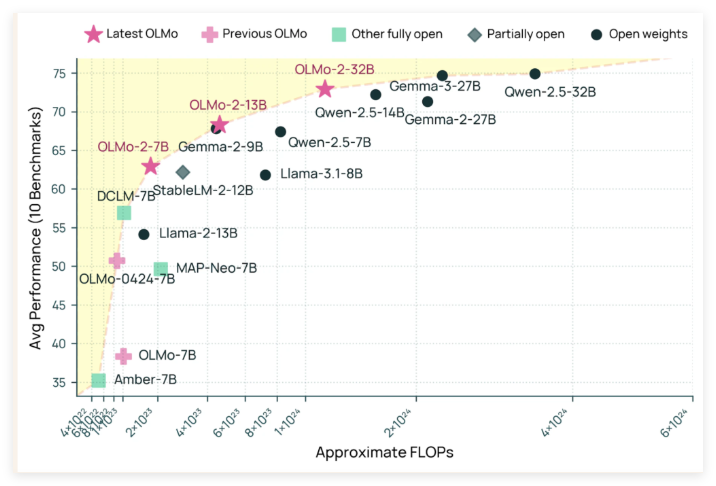

Selain kinerjanya yang sangat baik, OLMO232B juga menunjukkan kekuatan luar biasa dalam efisiensi pelatihan. Dikatakan hanya menggunakan sekitar sepertiga dari sumber daya komputasi sambil mencapai tingkat kinerja yang sebanding dengan model bobot terbuka terkemuka, dibandingkan dengan model seperti QWEN2.532B membutuhkan lebih banyak daya komputasi. Ini seperti pengrajin yang efisien yang telah menyelesaikan pekerjaan yang sama atau bahkan lebih baik dengan lebih sedikit alat dan waktu.

Rilis OLMO232B tidak hanya model AI baru, tetapi juga melambangkan tonggak penting dalam jalur pengembangan AI yang terbuka dan dapat diakses. Dengan memberikan solusi yang sepenuhnya terbuka dan mampu yang sebanding dengan atau melampaui beberapa model berpemilik, AI2 sangat menunjukkan bahwa desain model yang cermat dan metode pelatihan yang efisien dapat menyebabkan terobosan besar. Keterbukaan ini akan mendorong para peneliti dan pengembang global untuk berpartisipasi secara aktif, bersama -sama mempromosikan kemajuan di bidang kecerdasan buatan, dan pada akhirnya menguntungkan seluruh masyarakat manusia.

Dapat diramalkan bahwa kemunculan OLMO232B akan membawa udara segar ke bidang penelitian AI. Ini tidak hanya menurunkan ambang penelitian, mempromosikan kerja sama yang lebih luas, tetapi juga menunjukkan kepada kita jalur yang lebih dinamis dan inovatif untuk pengembangan AI. Adapun raksasa AI yang masih memegang "resep rahasia eksklusif" dengan erat, mereka juga harus mempertimbangkannya. Hanya dengan merangkul keterbukaan mereka dapat memenangkan masa depan yang lebih luas.

Github: https://github.com/allenai/olmo-core

HuggingFace: https: //huggingface.co/allenai/olmo-2-0325-32b-instruct