Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

Récemment, l'Institut d'Allen d'intelligence artificielle (AI2) a publié son dernier modèle de langue à grande échelle - OLMO232B. Ce modèle représente non seulement les dernières réalisations de la série OLMO2, mais lance également de puissants défis à ces modèles propriétaires fermés avec son attitude "complètement ouverte". Les attributs open source de OLMO232B sont sa caractéristique la plus accrocheuse. AI2 révèle généreusement toutes les données, le code, les poids et les processus d'entraînement détaillés, qui contraste fortement avec certains modèles de source fermée.

AI2 espère promouvoir des recherches et des innovations plus larges grâce à cette approche ouverte et collaborative, permettant aux chercheurs du monde entier de continuer à avancer sur les épaules d'Olmo232b. À une époque de partage des connaissances, la cachette n'est évidemment pas une solution à long terme. La libération d'OLMO232B marque une étape importante dans le chemin de développement de l'IA ouverte et accessible.

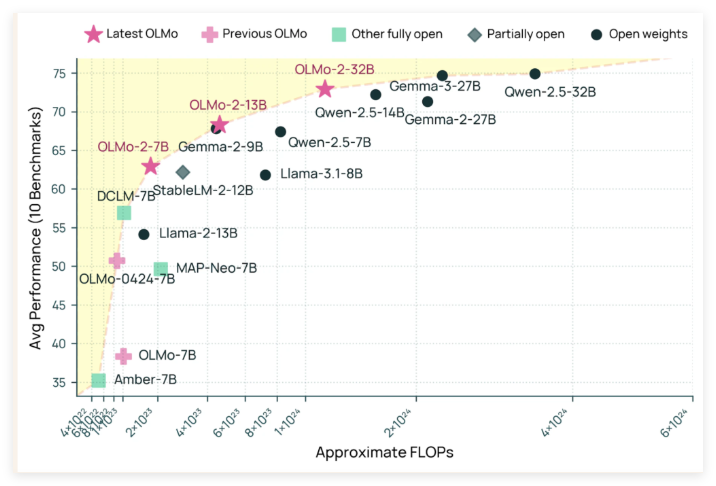

OLMO232B a 32 milliards de paramètres, ce qui est un nombre considérable, marquant une augmentation significative de l'échelle par rapport à sa génération précédente. Dans un certain nombre de références académiques largement reconnues, ce modèle open source dépasse en fait les mini GPT-3.5Turbo et GPT-4O! Cela a sans aucun doute injecté un coup de pouce à un fort coup de pouce à la communauté de l'IA open source, prouvant que non seulement les institutions "riches" peuvent créer des modèles d'IA supérieurs.

La raison pour laquelle OLMO232B peut obtenir des résultats aussi impressionnants est inséparable de son processus de formation méticuleux. L'ensemble du processus de formation est divisé en deux étapes principales: la formation pré-formation et à mi-parcours. Au cours de la phase de pré-formation, le modèle a "bité" un énorme ensemble de données d'environ 3,9 billions de jetons, qui sont largement provenant, notamment le DCLM, la Dolma, le coder Starcoder et la pile II. C'est comme laisser le modèle lire beaucoup et apprendre un large éventail de modèles de langue.

La formation à mi-parcours se concentre sur l'ensemble de données Dolmino, un ensemble de données de haute qualité contenant 843 milliards de jetons, couvrant l'éducation, les mathématiques et le contenu académique, améliorant davantage la capacité de compréhension du modèle dans des domaines spécifiques. Cette méthode de formation progressive et ciblée garantit que OLMO232B peut avoir des compétences linguistiques solides et méticuleuses.

En plus de ses excellentes performances, OLMO232B a également montré une force incroyable dans l'efficacité de l'entraînement. Il n'aurait utilisé qu'environ un tiers des ressources informatiques tout en atteignant des niveaux de performance comparables au modèle de poids ouvert leader, par rapport à des modèles comme QWEN2.532B nécessitent plus de puissance de calcul. C'est comme un artisan efficace qui a terminé le même travail ou même mieux avec moins d'outils et de temps.

La libération d'Olmo232b n'est pas seulement un nouveau modèle d'IA, mais symbolise également une étape importante dans le chemin de développement de l'IA ouverte et accessible. En fournissant une solution complètement ouverte et capable qui est comparable à ou dépasse certains modèles propriétaires, AI2 démontre fortement que la conception minutieuse des modèles et les méthodes de formation efficaces peuvent conduire à d'énormes percées. Cette ouverture encouragera les chercheurs et les développeurs mondiaux à participer activement, à promouvoir conjointement les progrès dans le domaine de l'intelligence artificielle et à profiter finalement à toute la société humaine.

On peut prévoir que l'émergence d'Olmo232b apportera un air frais sur le terrain de la recherche sur l'IA. Il réduit non seulement le seuil de recherche, favorise une coopération plus large, mais nous montre également un chemin plus dynamique et innovant vers le développement de l'IA. Quant aux géants de l'IA qui détiennent toujours étroitement la "recette secrète exclusive", ils devraient également le considérer. Ce n'est qu'en adoptant l'ouverture qu'ils peuvent gagner un avenir plus large.

github: https://github.com/allenai/olmo-core

Huggingface: https: //huggingface.co/allenai/olmo-2-0325-32b-instruct