Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

Recientemente, el Instituto Allen de Inteligencia Artificial (AI2) lanzó su último modelo de lenguaje a gran escala: OLMO232B. Este modelo no solo representa los últimos logros de la serie OLMO2, sino que también lanza poderosos desafíos a esos modelos patentados cerrados con su actitud "completamente abierta". Los atributos de código abierto de OLMO232B son su característica más llamativa. AI2 revela generosamente todos los datos, código, pesos y procesos de entrenamiento detallados, que están en marcado contraste con algunos modelos de código cerrado.

AI2 espera promover una investigación e innovación más amplias a través de este enfoque abierto y colaborativo, lo que permite a los investigadores de todo el mundo continuar avanzando sobre los hombros de OLMO232B. En una era de intercambio de conocimientos, ocultar obviamente no es una solución a largo plazo. El lanzamiento de OLMO232B marca un hito importante en la ruta de desarrollo de la IA abierta y accesible.

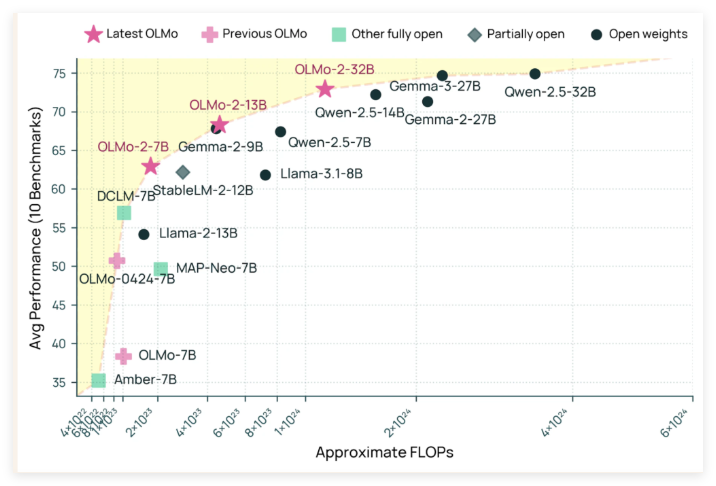

OLMO232B tiene 32 mil millones de parámetros, que es un número considerable, que marca un aumento significativo en la escala en comparación con su generación anterior. En varios puntos de referencia académicos ampliamente reconocidos, ¡este modelo de código abierto realmente supera el GPT-3.5Turbo y GPT-4O Mini! Esto indudablemente inyectó una foto de un fuerte impulso a la comunidad de IA de código abierto, lo que demuestra que no solo las instituciones "ricas" pueden crear los mejores modelos de IA.

La razón por la cual OLMO232B puede lograr resultados tan impresionantes es inseparable de su meticuloso proceso de entrenamiento. Todo el proceso de entrenamiento se divide en dos etapas principales: entrenamiento previo y mediano plazo. Durante la etapa previa a la capacitación, el modelo "Bited" un enorme conjunto de datos de aproximadamente 3.9 billones de tokens, que son ampliamente de origen, incluidos DCLM, Dolma, Starcoder y Proof Pile II. Es como dejar que el modelo lea mucho y aprenda una amplia gama de patrones de lenguaje.

La capacitación a mitad de período se centra en el conjunto de datos Dolmino, un conjunto de datos de alta calidad que contiene 843 mil millones de tokens, que cubre la educación, las matemáticas y el contenido académico, mejorando aún más la capacidad de comprensión del modelo en campos específicos. Este método de capacitación graduado y graduado asegura que OLMO232B pueda tener habilidades lingüísticas sólidas y meticulosas.

Además de su excelente rendimiento, OLMO232B también ha mostrado una fuerza sorprendente en la eficiencia de entrenamiento. Se dice que usó solo aproximadamente un tercio de los recursos informáticos mientras alcanza los niveles de rendimiento comparables al modelo de peso abierto líder, en comparación con modelos como Qwen2.532b requieren más potencia informática. Es como un artesano eficiente que ha completado el mismo o incluso mejor trabajo con menos herramientas y tiempo.

El lanzamiento de OLMO232B no es solo un nuevo modelo de IA, sino que también simboliza un hito importante en la ruta de desarrollo de la IA abierta y accesible. Al proporcionar una solución completamente abierta y capaz que sea comparable o excede algunos modelos patentados, AI2 demuestra fuertemente que el diseño del modelo cuidadoso y los métodos de entrenamiento eficientes pueden conducir a grandes avances. Esta apertura alentará a los investigadores y desarrolladores globales a participar activamente, promover conjuntamente el progreso en el campo de la inteligencia artificial y, en última instancia, beneficiará a toda la sociedad humana.

Se puede prever que la aparición de OLMO232B traiga un aire fresco al campo de la investigación de IA. No solo reduce el umbral de investigación, promueve una cooperación más amplia, sino que también nos muestra un camino más dinámico e innovador hacia el desarrollo de la IA. En cuanto a los gigantes de la IA que aún sostienen la "receta secreta exclusiva" con fuerza, también deberían considerarlo. Solo adoptando la apertura pueden ganar un futuro más amplio.

Github: https://github.com/allenai/olmo-core

Huggingface: https: //huggingface.co/allenai/olmo-2-0325-32b-instructa