في الآونة الأخيرة ، أصدر معهد ألين للذكاء الاصطناعي (AI2) أحدث نموذج لغوي واسع النطاق - OLMO232B. لا يمثل هذا النموذج أحدث الإنجازات لسلسلة OLMO2 فحسب ، بل يطلق أيضًا تحديات قوية لتلك النماذج الملكية المغلقة بموقفها "مفتوح تمامًا". سمات المصدر المفتوح لـ OLMO232B هي ميزة لافتة للنظر. تكشف AI2 بسخاء عن جميع البيانات والرمز والأوزان وعمليات التدريب التفصيلية ، والتي تتناقض بشكل حاد مع بعض نماذج المصدر المغلقة.

تأمل AI2 في تعزيز الأبحاث والابتكار الأوسع من خلال هذا النهج المفتوح والتعاون ، مما يسمح للباحثين في جميع أنحاء العالم بمواصلة المضي قدمًا على أكتاف OLMO232B. في عصر تبادل المعرفة ، من الواضح أن الاختباء ليس حلاً طويل الأجل. يمثل إطلاق OLMO232B علامة فارقة مهمة في مسار تطوير الذكاء الاصطناعي المفتوح ويمكن الوصول إليه.

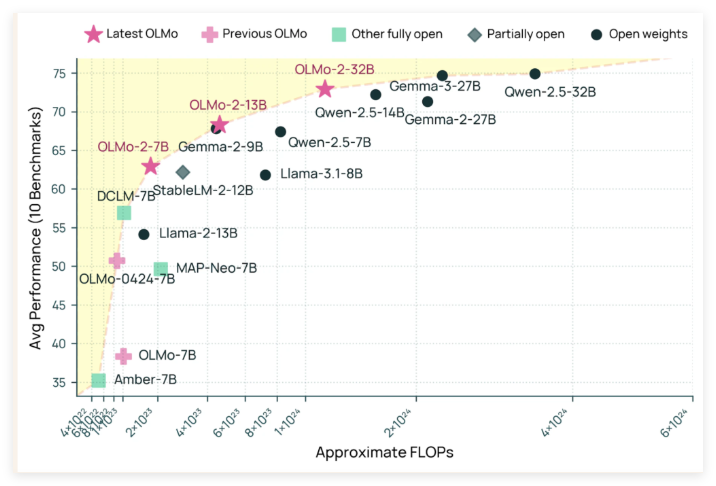

يحتوي OLMO232B على 32 مليار معلمة ، وهو عدد كبير ، مما يمثل زيادة كبيرة في الحجم مقارنة بالجيل السابق. في عدد من المعايير الأكاديمية المعترف بها على نطاق واسع ، يتجاوز هذا النموذج مفتوح المصدر GPT-3.5TURBO و GPT-4O MINI! هذا بلا شك حقن لقطة لزيادة قوية لمجتمع AI مفتوح المصدر ، مما يثبت أنه لا يمكن للمؤسسات "الأثرياء" فقط إنشاء نماذج منظمة العفو الدولية.

إن السبب وراء قدرة OLMO232B على تحقيق مثل هذه النتائج المثيرة للإعجاب لا ينفصل عن عملية التدريب الدقيقة. تنقسم عملية التدريب بأكملها إلى مرحلتين رئيسيتين: التدريب قبل التدريب والتدريب على المدى المتوسط. خلال مرحلة ما قبل التدريب ، فإن النموذج "قفل" مجموعة بيانات ضخمة تبلغ حوالي 3.9 تريليون رمز ، والتي يتم الحصول عليها على نطاق واسع ، بما في ذلك DCLM و Dolma و Starcoder و Proof Pile II. إنه مثل ترك النموذج يقرأ كثيرًا وتعلم مجموعة واسعة من أنماط اللغة.

يركز التدريب على منتصف المدة على مجموعة بيانات Dolmino ، وهي مجموعة بيانات عالية الجودة تحتوي على 843 مليار رمز ، تغطي التعليم والرياضيات والمحتوى الأكاديمي ، مما يؤدي إلى تحسين قدرة فهم النموذج في مجالات محددة. تضمن طريقة التدريب المدرسة والمركزة هذه أن OLMO232B يمكن أن يتمتع بمهارات لغوية قوية ودقيقة.

بالإضافة إلى أدائها الممتاز ، أظهر OLMO232B أيضًا قوة مذهلة في كفاءة التدريب. يقال إنه استخدم فقط حوالي ثلث موارد الحوسبة مع الوصول إلى مستويات الأداء مماثلة لنموذج الوزن المفتوح الرائد ، مقارنةً بنماذج مثل QWEN2.532B تتطلب المزيد من قوة الحوسبة. إنه مثل الحرفي الفعال الذي أكمل نفس العمل أو حتى أفضل من الأدوات والوقت.

إن إصدار OLMO232B ليس فقط نموذجًا جديدًا من الذكاء الاصطناعى ، ولكنه يرمز أيضًا إلى معلم مهم في مسار تطوير الذكاء الاصطناعي المفتوح ويمكن الوصول إليه. من خلال توفير حل مفتوح وقادر تمامًا والذي يشبه أو يتجاوز بعض النماذج الملكية ، يوضح AI2 بقوة أن تصميم النماذج الدقيقة وطرق التدريب الفعالة يمكن أن تؤدي إلى اختراقات ضخمة. سيشجع هذا الانفتاح الباحثين والمطورين العالميين على المشاركة بنشاط ، وتعزيز التقدم المشترك في مجال الذكاء الاصطناعي ، ويستفيد من المجتمع البشري بأكمله في النهاية.

يمكن توقع أن ظهور OLMO232B سيحضر الهواء النقي إلى مجال أبحاث الذكاء الاصطناعي. إنه لا يقلل فقط من عتبة البحث ، ويعزز التعاون الأوسع ، ولكنه يظهر لنا أيضًا طريقًا أكثر ديناميكية ومبتكرة لتطوير الذكاء الاصطناعي. أما بالنسبة لأولئك الذين لا يزالون يحملون "الوصفة السرية الحصرية" بإحكام ، فيجب عليهم أيضًا التفكير فيها. فقط من خلال تبني الانفتاح يمكنهم الفوز بمستقبل أوسع.

Github: https://github.com/allenai/olmo-core

Luggingface: https: //huggingface.co/allenai/olmo-2-0325-32b- instruct