Recentemente, o Instituto Allen de Inteligência Artificial (AI2) divulgou seu mais recente modelo de idioma em larga escala - OLMO232B. Esse modelo não apenas representa as últimas conquistas da série OLMO2, mas também lança desafios poderosos para os modelos proprietários fechados com sua atitude "completamente aberta". Os atributos de código aberto do OLMO232B são o recurso mais atraente. A AI2 divulga generosamente todos os dados, código, pesos e processos de treinamento detalhados, o que contrasta com alguns modelos de fonte fechada.

A AI2 espera promover pesquisas e inovação mais amplas por meio dessa abordagem aberta e colaborativa, permitindo que pesquisadores de todo o mundo continuem avançando nos ombros do OLMO232B. Em uma era de compartilhamento de conhecimento, o esconderijo obviamente não é uma solução de longo prazo. O lançamento do OLMO232B marca um marco importante no caminho de desenvolvimento da IA aberta e acessível.

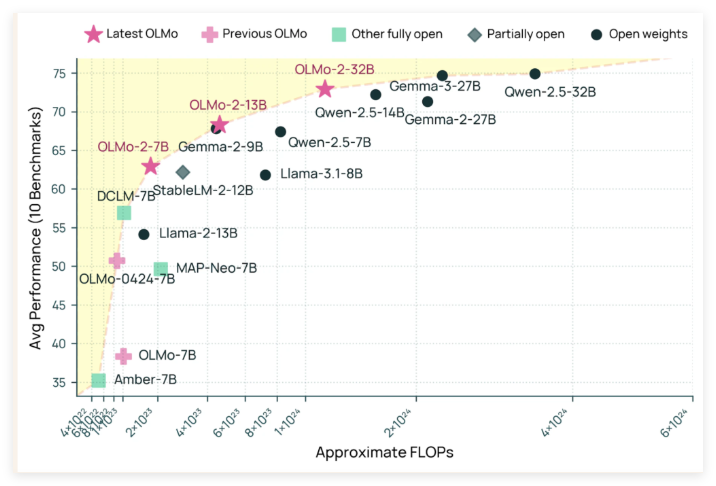

O OLMO232B possui 32 bilhões de parâmetros, que é um número considerável, marcando um aumento significativo na escala em comparação com sua geração anterior. Em vários benchmarks acadêmicos amplamente reconhecidos, esse modelo de código aberto supera o GPT-3.5Turbo e o GPT-4O Mini! Isso, sem dúvida, injetou uma foto de um forte impulso à comunidade de IA de código aberto, provando que não apenas as instituições "ricas" podem criar os principais modelos de IA.

A razão pela qual o OLMO232B pode alcançar resultados tão impressionantes é inseparável em relação ao seu processo de treinamento meticuloso. Todo o processo de treinamento é dividido em dois estágios principais: treinamento pré-treinamento e médio prazo. Durante o estágio de pré-treinamento, o modelo "acidou" um enorme conjunto de dados de cerca de 3,9 trilhões de tokens, que são amplamente adquiridos, incluindo DCLM, Dolma, Starcoder e Poof Pile II. É como deixar o modelo ler muito e aprender uma ampla gama de padrões de linguagem.

O treinamento de médio prazo se concentra no conjunto de dados Dolmino, um conjunto de dados de alta qualidade contendo 843 bilhões de tokens, abrangendo educação, matemática e conteúdo acadêmico, melhorando ainda mais a capacidade de compreensão do modelo em campos específicos. Esse método de treinamento faseado e focado garante que o OLMO232B possa ter habilidades de linguagem sólidas e meticulosas.

Além de seu excelente desempenho, o OLMO232B também mostrou força incrível na eficiência do treinamento. Diz-se que ele usou apenas um terço dos recursos de computação enquanto atinge níveis de desempenho comparável ao modelo de peso aberto principal, em comparação com modelos como QWEN2.532B, requerem mais potência de computação. É como um artesão eficiente que completou o mesmo ou até melhor trabalho com menos ferramentas e tempo.

O lançamento do OLMO232B não é apenas um novo modelo de IA, mas também simboliza um marco importante no caminho de desenvolvimento da IA aberta e acessível. Ao fornecer uma solução completamente aberta e capaz que seja comparável ou exceda alguns modelos proprietários, a AI2 demonstra fortemente que o design cuidadoso do modelo e os métodos de treinamento eficientes podem levar a enormes avanços. Essa abertura incentivará pesquisadores e desenvolvedores globais a participar ativamente, promoverá em conjunto o progresso no campo da inteligência artificial e, finalmente, beneficiará toda a sociedade humana.

Pode ser previsto que o surgimento do OLMO232B trará um ar fresco ao campo da pesquisa de IA. Não apenas reduz o limiar de pesquisa, promove uma cooperação mais ampla, mas também nos mostra um caminho mais dinâmico e inovador para o desenvolvimento da IA. Quanto aos gigantes da IA que ainda possuem a "receita secreta exclusiva" com força, eles também devem considerá -la. Somente abraçando a abertura, eles podem ganhar um futuro mais amplo.

Github: https://github.com/allenai/olmo-core

Huggingface: https: //huggingface.co/allenai/olmo-2-0325-32b-struct