最近、アレン人工知能研究所(AI2)は、最新の大規模な言語モデルであるOLMO232Bをリリースしました。このモデルは、OLMO2シリーズの最新の成果を表すだけでなく、「完全に開かれた」態度で閉じた独自モデルに強力な課題を開始します。 OLMO232Bのオープンソース属性は、最も人目を引く機能です。 AI2は、すべてのデータ、コード、重み、および詳細なトレーニングプロセスをgeneしみなく開示しています。これは、一部の閉じたソースモデルとは対照的です。

AI2は、このオープンで協力的なアプローチを通じて、より広範な研究と革新を促進したいと考えており、世界中の研究者がOLMO232Bの肩を前進させ続けることができます。知識共有の時代において、隠すことは明らかに長期的な解決策ではありません。 OLMO232Bのリリースは、オープンでアクセス可能なAIの開発パスにおける重要なマイルストーンを示しています。

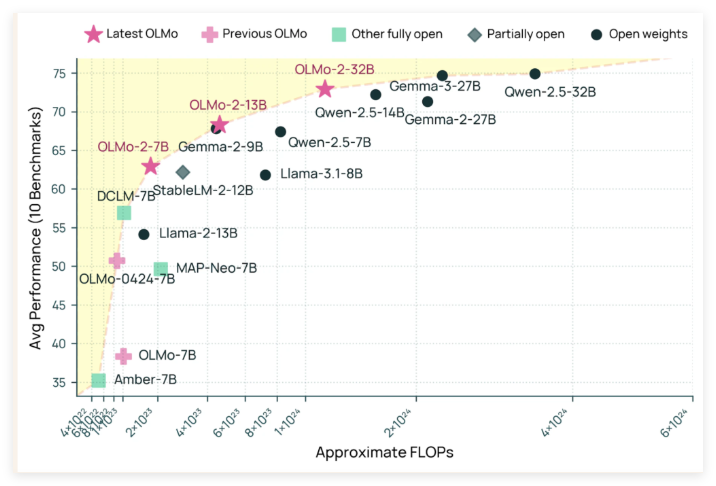

OLMO232Bには320億パラメーターがあり、これはかなりの数であり、前世代と比較してスケールが大幅に増加することを示しています。広く認識されている多くのアカデミックベンチマークでは、このオープンソースモデルは実際にGPT-3.5turboおよびGPT-4o Miniを上回ります!これは間違いなく、オープンソースのAIコミュニティに強力な後押しのショットを注入し、「裕福な」機関だけでなく、トップAIモデルを作成できることを証明しました。

OLMO232Bがこのような印象的な結果を達成できる理由は、その細心のトレーニングプロセスと切り離せないものです。トレーニングプロセス全体は、トレーニング前トレーニングと中期トレーニングの2つの主要な段階に分かれています。トレーニング前の段階では、モデルは、DCLM、Dolma、Starcoder、Proof Pile IIなど、広く供給されている約3.9兆トークンの巨大なデータセットを「噛みました」。それは、モデルに多くを読んで、幅広い言語パターンを学ぶようなものです。

中期トレーニングは、教育、数学、学術コンテンツをカバーする843億トークンを含む高品質のデータセットであるDolminoデータセットに焦点を当てており、特定の分野でのモデルの理解能力をさらに向上させます。この段階的で焦点を絞ったトレーニング方法により、OLMO232Bが堅実で細心の言語スキルを持つことができます。

優れたパフォーマンスに加えて、OLMO232Bはトレーニング効率の驚くべき強さも示しています。 QWEN2.532Bのようなモデルと比較して、主要なオープンウェイトモデルに匹敵するパフォーマンスレベルに到達しながら、コンピューティングリソースの約3分の1しか使用していないと言われています。それは、より少ないツールと時間で同じまたはより良い作業を完了した効率的な職人のようなものです。

OLMO232Bのリリースは、新しいAIモデルであるだけでなく、オープンでアクセス可能なAIの開発パスにおける重要なマイルストーンを象徴しています。一部の独自モデルに匹敵する、またはそれを超える完全にオープンで有能なソリューションを提供することにより、AI2は、慎重なモデル設計と効率的なトレーニング方法が大きなブレークスルーにつながる可能性があることを強く示しています。このオープン性は、グローバルな研究者と開発者が積極的に参加し、人工知能の分野での進歩を共同で促進し、最終的に人間社会全体に利益をもたらすことを奨励します。

OLMO232Bの出現がAI研究の分野に新鮮な空気をもたらすことが予見される可能性があります。研究のしきい値を低下させ、幅広い協力を促進するだけでなく、AI開発へのよりダイナミックで革新的な道を示しています。まだ「排他的な秘密のレシピ」をしっかりと保持しているAIの巨人については、それも考慮する必要があります。開放性を受け入れることによってのみ、彼らはより広い未来を獲得できます。

Github:https://github.com/allenai/olmo-core

Huggingface:https://huggingface.co/allenai/olmo-2-0325-32b-instruct