Kürzlich veröffentlichte das Allen Institute of Artificial Intelligence (AI2) sein neuestes großes Sprachmodell - OLMO232B. Dieses Modell stellt nicht nur die neuesten Errungenschaften der OLMO2 -Serie dar, sondern startet auch leistungsstarke Herausforderungen für die geschlossenen proprietären Modelle mit seiner "völlig offenen" Haltung. Die Open Source-Attribute von OLMO232B sind die auffälligste Funktion. AI2 gibt großzügig alle Daten, Code, Gewichte und detaillierte Trainingsprozesse offen, was in scharfem Kontrast zu einigen geschlossenen Quellmodellen steht.

AI2 hofft, durch diesen offenen und kollaborativen Ansatz umfassendere Forschungen und Innovationen zu fördern, sodass Forscher auf der ganzen Welt die Schultern von OLMO232B weiterentwickeln können. In einer Ära des Wissensaustauschs ist das Verstecken offensichtlich keine langfristige Lösung. Die Veröffentlichung von OLMO232B ist ein wichtiger Meilenstein im Entwicklungspfad der offenen und zugänglichen KI.

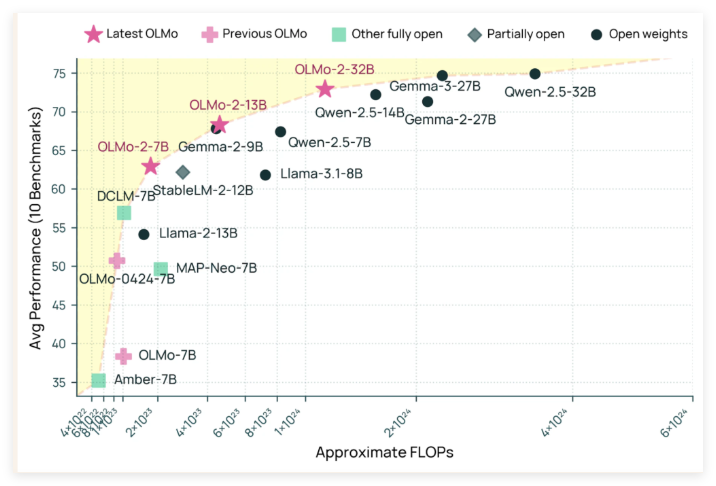

OLMO232B hat 32 Milliarden Parameter, was eine beträchtliche Zahl darstellt und eine signifikante Erhöhung der Skalierung im Vergleich zur vorherigen Generation kennzeichnet. In einer Reihe von weithin anerkannten akademischen Benchmarks übertrifft dieses Open-Source-Modell den GPT-3,5-Turbo und den GPT-4O-Mini! Dies brachte zweifellos die Open -Source -AI -Community einen Schuss eines starken Schubs, der beweist, dass nicht nur "wohlhabende" Institutionen Top -KI -Modelle erstellen können.

Der Grund, warum OLMO232B so beeindruckende Ergebnisse erzielen kann, ist untrennbar mit seinem akribischen Trainingsprozess untrennbar miteinander verbunden. Der gesamte Trainingsprozess ist in zwei Hauptphasen unterteilt: Vorausbildung und mittelfristige Schulung. Während der Vorausbildung "bassete" das Modell einen riesigen Datensatz von etwa 3,9 Billionen Token, die weit verbreitet sind, einschließlich DCLM, Dolma, StarCoder und Proof Stapel II. Es ist, als würde das Modell viel lesen und eine Vielzahl von Sprachmustern lernen.

Das mittelfristige Training konzentriert sich auf den Dolmino-Datensatz, einen hochwertigen Datensatz mit 843 Milliarden Token, der Bildung, Mathematik und akademische Inhalte abdeckt und die Verständnisfähigkeit des Modells in bestimmten Bereichen weiter verbessert. Diese schrittweise und fokussierte Trainingsmethode stellt sicher, dass OLMO232B solide und akribische Sprachkenntnisse haben kann.

Zusätzlich zu seiner hervorragenden Leistung hat OLMO232B auch eine erstaunliche Kraft in der Trainingseffizienz gezeigt. Es soll nur etwa ein Drittel der Rechenressourcen verwendet haben und gleichzeitig die Leistungsstufen erreicht, die mit dem führenden offenen Gewichtsmodell vergleichbar ist, im Vergleich zu Modellen wie QWEN2.532b mehr Rechenleistung. Es ist wie ein effizienter Handwerker, der die gleiche oder sogar bessere Arbeit mit weniger Werkzeugen und Zeit erledigt hat.

Die Veröffentlichung von OLMO232B ist nicht nur ein neues KI -Modell, sondern symbolisiert auch einen wichtigen Meilenstein im Entwicklungspfad der offenen und zugänglichen KI. Durch die Bereitstellung einer vollständig offenen und fähigen Lösung, die mit einigen proprietären Modellen vergleichbar ist oder überschreitet, zeigt AI2 stark, dass sorgfältiges Modelldesign und effiziente Trainingsmethoden zu enormen Durchbrüchen führen können. Diese Offenheit wird globale Forscher und Entwickler ermutigen, aktiv teilzunehmen, den Fortschritt im Bereich der künstlichen Intelligenz gemeinsam zu fördern und letztendlich der gesamten menschlichen Gesellschaft zugute.

Es kann vorausgesehen werden, dass die Entstehung von OLMO232B eine frische Luft auf den Bereich der KI -Forschung bringt. Es senkt nicht nur die Forschungsschwelle, fördert die Zusammenarbeit, sondern zeigt auch einen dynamischeren und innovativeren Weg zur KI -Entwicklung. Diese KI -Giants, die das "exklusive geheime Rezept" immer noch fest halten, sollten sie es auch berücksichtigen. Nur wenn sie Offenheit umarmen, können sie eine breitere Zukunft gewinnen.

Github: https://github.com/allenai/olmo-core

Huggingface: https: //huggingface.co/Allenai/olmo-2-0325-32b-instruct