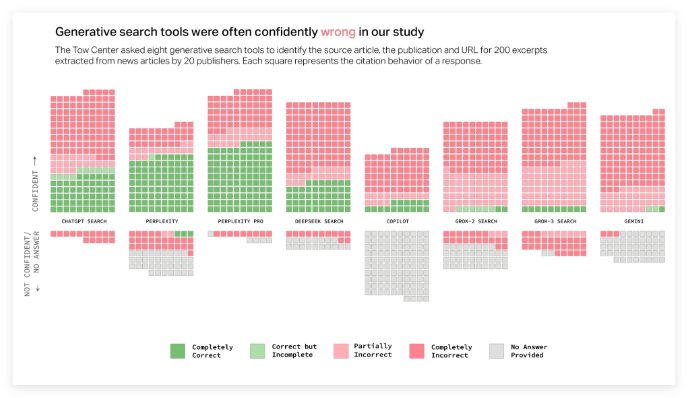

Недавнее исследование поисковых систем ИИ выявило серьезные проблемы при обработке информации о новостях. Центр цифровых новостей Columbia News (CJR) провел подробные тесты на восьми инструментах искусственного интеллекта с возможностями поиска в реальном времени, и результаты были шокирующими: более 60% новостей получили неточные ответы. Это открытие привлекло широкое внимание общественности к надежности технологии ИИ.

Исследования показывают, что существуют значительные различия в частоте ошибок среди различных платформ искусственного интеллекта. Среди них частота ошибок GROK3 достигает 94%, в то время как частота ошибок в поисках CHATGPT также достигает 67%. Стоит отметить, что даже оплачиваемые версии, такие как «Служба Presmity Pro» и «Премиум Grok3», не смогли избежать частых уверенных, но неверных ответов. Исследователи специально указывают на то, что эти модели ИИ имеют широко распространенную тенденцию к «уверенному неправильному», то есть, когда не хватает надежной информации, они не решают отклонять ответы, но, как правило, изготовляют, казалось бы, разумные неправильные ответы.

Кроме того, исследование также выявляет проблемы цитирования поисковых систем искусственного интеллекта. Эти инструменты часто направляют пользователей на совместную публикационную платформу для новостного контента, а не на веб -сайт оригинального издателя. Что еще более серьезно, так это то, что некоторые инструменты ИИ даже изготавливают неверные ссылки на URL, заставляющие пользователей не могут получить доступ к источнику информации. Например, более половины справочных ссылок Grok3 были недействительными в тесте, что еще больше усугубляло сложность получения информации.

Эти проблемы представляют серьезную проблему для издателей новостей. Если Clawlers предотвращается ползание контента, контент может потерять свою подпись полностью; В то время как ползание может столкнуться с дилеммой содержания, широко используемого, но не может быть доставлен обратно на свой собственный веб -сайт. Главный операционный директор Times Марк Ховард выразил глубокие озабоченности по поводу этого, подчеркнув необходимость прозрачности и контроля.

Исследователи отметили, что около четверти американцев в настоящее время использовали модели ИИ в качестве замены традиционных поисковых систем, и такой высокий уровень ошибок беспокоит надежность информации. Исследование дополнительно подтверждает аналогичный отчет, опубликованный в ноябре прошлого года, который также указывает на вопросы точности, которые Catgpt имеет при работе с новостным контентом. Хотя OpenAI и Microsoft признали результаты получения исследований, они не отвечали напрямую на конкретные вопросы, что вызвало дальнейшие общественные сомнения относительно прозрачности технологии ИИ.

Подводя итог, что высокие показатели ошибок в поисках ИИ, запутанные цитаты и плохая производительность платных услуг в обработке информации о новостях, показывают, что в текущей технологии все еще существует много недостатков. Поскольку роль ИИ в получении информации становится все более важной, решение этих проблем стало неотложной задачей.