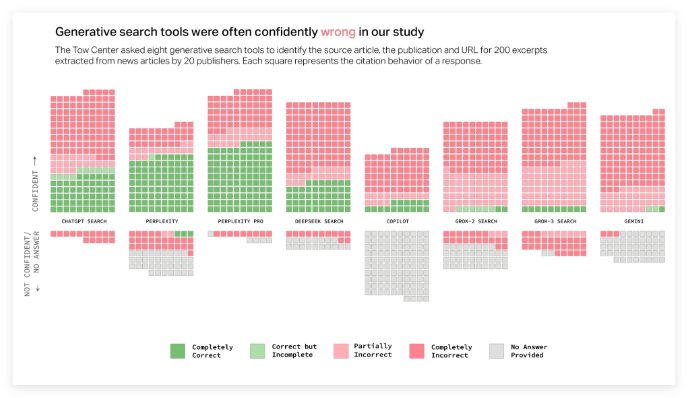

AI 검색 엔진에 대한 최근의 연구에 따르면 뉴스 정보 처리에서 심각한 문제가 나타났습니다. CJR (Columbia News Review)의 Digital News Center는 실시간 검색 기능을 갖춘 8 개의 AI 도구에서 심층 테스트를 수행했으며 결과는 충격적이었습니다. 뉴스 쿼리의 60% 이상이 부정확 한 답변을 받았습니다. 이 발견은 AI 기술의 신뢰성에 대한 대중의 관심을 끌었습니다.

연구에 따르면 다른 AI 플랫폼간에 오류율이 크게 차이가 있습니다. 그중에서도 Grok3의 오류율은 94%로 높고 ChatGpt 검색의 오류율도 67%로 높습니다. Perplexity Pro 및 Grok3의 프리미엄 서비스와 같은 유료 버전조차 자주 자신감이 있지만 잘못된 답변을 피하지 못했습니다. 연구원들은이 AI 모델이“자신있게 잘못”하는 경향이 있으며, 즉 신뢰할 수있는 정보가 부족할 때 답을 거부하는 것을 선택하지 않지만 합리적인 잘못된 답변을 제작하는 경향이 있다고 지적합니다.

또한이 연구는 AI 검색 엔진의 인용 문제를 보여줍니다. 이러한 도구는 종종 사용자가 원래 게시자 웹 사이트가 아닌 뉴스 컨텐츠를위한 공동 게시 플랫폼으로 안내합니다. 더 심각한 점은 일부 AI 도구는 잘못된 URL 링크를 제작하여 사용자가 정보 소스에 액세스 할 수 없다는 것입니다. 예를 들어, Grok3의 기준 링크의 절반 이상이 테스트에서 유효하지 않아 정보를 얻는 데 어려움이 더욱 악화되었습니다.

이러한 문제는 뉴스 게시자에게 심각한 도전을 제기합니다. AI 크롤러가 콘텐츠를 크롤링하지 못하면 콘텐츠가 서명을 완전히 잃을 수 있습니다. 크롤링은 널리 사용되는 콘텐츠의 딜레마에 직면 할 수 있지만 자체 웹 사이트로 다시 전송할 수는 없습니다. 타임즈 최고 운영 책임자 마크 하워드 (Mark Howard)는 이에 대한 깊은 우려를 표명하면서 투명성과 통제의 필요성을 강조했습니다.

연구원들은 미국인의 약 1/4이 이제 AI 모델을 전통적인 검색 엔진의 대체물로 사용했으며 이러한 높은 오류율은 정보의 신뢰성에 대해 걱정하고 있다고 지적했습니다. 이 연구는 지난 11 월에 발표 된 유사한 보고서를 추가로 확인했으며,이 보고서는 또한 뉴스 내용을 다룰 때 Chatgpt의 정확성 문제를 지적합니다. OpenAI와 Microsoft는 연구 결과를받는 것을 인정했지만 특정 질문에 직접 응답하지 않았으며, 이는 AI 기술의 투명성에 대한 추가 대중의 의심을 일으켰습니다.

요약하면, AI 검색 엔진의 높은 오류율, 혼란스러운 인용 및 뉴스 정보 처리에서 유료 서비스의 성능 저하는 현재 기술에 여전히 많은 단점이 있음을 나타냅니다. 정보 획득에서 AI의 역할이 점점 중요 해짐에 따라 이러한 문제를 해결하는 것이 긴급한 작업이되었습니다.