Une étude récente sur les moteurs de recherche d'IA a révélé de graves problèmes dans le traitement des informations sur les informations. Le centre de nouvelles numériques de Columbia News Review (CJR) a effectué des tests approfondis sur huit outils d'IA avec des capacités de recherche en temps réel, et les résultats étaient choquants: plus de 60% des requêtes d'actualités ont reçu des réponses inexactes. Cette découverte a attiré une grande attention du public sur la fiabilité de la technologie de l'IA.

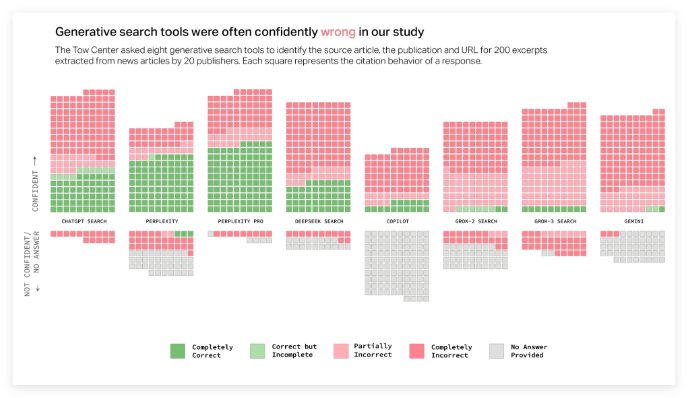

La recherche montre qu'il existe des différences significatives dans les taux d'erreur entre les différentes plateformes d'IA. Parmi eux, le taux d'erreur de Grok3 a une hauteur jusqu'à 94%, tandis que le taux d'erreur de recherche de chatppt atteint également 67%. Il convient de noter que même les versions payées, telles que Perplexity Pro et les services premium de Grok3, n'ont pas réussi à éviter des réponses fréquentes mais incorrectes. Les chercheurs soulignent spécifiquement que ces modèles d'IA ont une tendance généralisée à «mal en toute confiance», c'est-à-dire lorsqu'il y a un manque d'informations fiables, ils ne choisissent pas de rejeter les réponses, mais ont tendance à fabriquer des réponses erronées apparemment raisonnables.

De plus, la recherche révèle également les problèmes de citation des moteurs de recherche d'IA. Ces outils dirigent souvent les utilisateurs vers une plate-forme de publication conjointe pour le contenu d'actualités plutôt que sur le site Web de l'éditeur original. Ce qui est plus grave, c'est que certains outils d'IA fabriquent même des liens d'URL non valides, ce qui fait que les utilisateurs ne peuvent pas accéder à la source d'informations. Par exemple, plus de la moitié des liens de référence de Grok3 n'étaient pas valides dans le test, ce qui a encore exacerbé la difficulté d'obtenir des informations.

Ces questions posent un sérieux défi aux éditeurs d'informations. Si les robots de l'IA sont empêchés de ramper, le contenu peut perdre complètement sa signature; Bien que ramper peut faire face au dilemme du contenu largement utilisé, mais à ne pas pouvoir être transporté sur son propre site Web. Le chef de l'exploitation de Times, Mark Howard, a exprimé de profondes préoccupations à ce sujet, soulignant la nécessité de transparence et de contrôle.

Les chercheurs ont noté qu'environ un quart des Américains ont maintenant utilisé des modèles d'IA en remplacement des moteurs de recherche traditionnels, et un taux d'erreur aussi élevé se soucie de la fiabilité de l'information. L'étude confirme en outre un rapport similaire publié en novembre dernier, qui souligne également les problèmes de précision que Chatgpt a lorsqu'il s'agit de contenu d'actualités. Bien que OpenAI et Microsoft aient reconnu avoir reçu des résultats de recherche, ils n'ont pas répondu directement à des questions spécifiques, ce qui a déclenché de nouveaux doutes publics sur la transparence de la technologie de l'IA.

Pour résumer, les taux d'erreur élevés des moteurs de recherche d'IA, les citations confuses et les mauvaises performances des services payants dans le traitement de l'information des informations indiquent tous qu'il existe encore de nombreuses lacunes dans la technologie actuelle. À mesure que le rôle de l'IA dans l'acquisition d'informations devient de plus en plus importante, la résolution de ces problèmes est devenue une tâche urgente.