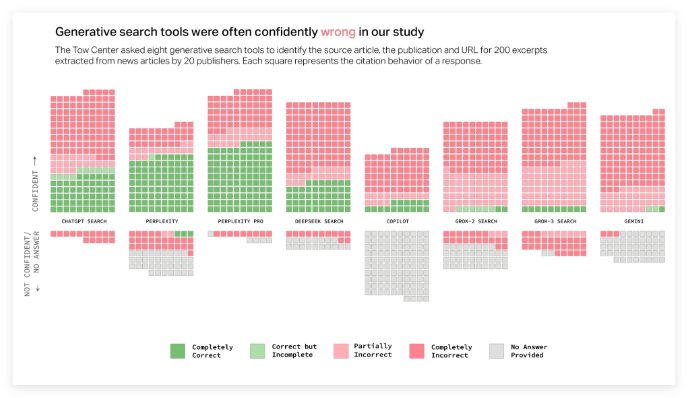

AI検索エンジンに関する最近の調査では、ニュース情報の処理に深刻な問題が明らかになりました。 Columbia News Review(CJR)のデジタルニュースセンターは、リアルタイムの検索機能を備えた8つのAIツールで詳細なテストを実施し、結果は衝撃的でした。ニュースクエリの60%以上が不正確な回答を受けました。この発見は、AIテクノロジーの信頼性に広範囲の国民の注目を集めています。

調査によると、さまざまなAIプラットフォーム間でエラー率に大きな違いがあることが示されています。その中でも、GROK3のエラー率は94%になりますが、CHATGPT検索のエラー率も67%です。 Perplexity ProやGrok3のプレミアムサービスなどの有料バージョンでさえ、頻繁に自信を持っているが間違った答えを避けることができなかったことは注目に値します。研究者は、これらのAIモデルが「自信を持って間違っている」という広範な傾向があること、つまり信頼できる情報がない場合、回答を拒否することを選択しないが、一見合理的に間違った答えを作成する傾向があることを具体的に指摘しています。

さらに、この研究では、AI検索エンジンの引用問題も明らかにしています。これらのツールは、多くの場合、ユーザーを元の出版社のWebサイトではなく、ニュースコンテンツのための共同パブリッシングプラットフォームに向けます。さらに深刻なのは、一部のAIツールが無効なURLリンクを製造し、ユーザーが情報源にアクセスできなくなったことです。たとえば、GROK3の参照リンクの半分以上がテストで無効であり、情報を取得することの難しさをさらに悪化させました。

これらの問題は、ニュース出版社にとって深刻な挑戦をもたらします。 AIクローラーがコンテンツをクロールすることを妨げられた場合、コンテンツはその署名を完全に失う可能性があります。クロールすることは、コンテンツが広く使用されているが、それ自体のウェブサイトに戻ることができないというジレンマに直面する可能性があります。タイムズの最高執行責任者であるマーク・ハワードは、これについて深い懸念を表明し、透明性と制御の必要性を強調しました。

研究者は、アメリカ人の約4分の1が従来の検索エンジンの代替品としてAIモデルを使用しており、そのような高いエラー率は情報の信頼性を心配していると指摘しました。この調査では、昨年11月にリリースされた同様のレポートがさらに確認されており、これはCHATGPTがニュースコンテンツを扱うときに抱えている精度の問題を指摘しています。 OpenaiとMicrosoftは研究結果を受け取ることを認めていましたが、特定の質問に直接対応しなかったため、AIテクノロジーの透明性についてさらに大衆の疑いを引き起こしました。

要約すると、AI検索エンジンの高いエラー率、混乱の引用、ニュース情報処理における有料サービスのパフォーマンスの低下はすべて、現在のテクノロジーにはまだ多くの欠点があることを示しています。情報取得におけるAIの役割がますます重要になるにつれて、これらの問題を解決することは緊急の課題になりました。