В последнее время успешный запуск проекта VLM-R1 привлек New Dawn в область моделей визуального языка. Этот проект является успешной миграцией метода R1 DeepSeek команды R1 в модели визуального языка, отмечая, что понимание AI визуального контента выйдет на совершенно новый этап. Запуск VLM-R1 не только демонстрирует технологические прорывы, но и открывает новые направления для исследования мультимодального ИИ.

VLM-R1 был вдохновлен методом R1, который команда DeepSeek открыла источник в прошлом году. Этот метод принимает технологию обучения GRPO (сгенерированная оптимизация обработки вознаграждений) и достигла замечательных результатов в области обработки простого текста. Сегодня команда VLM-R1 успешно применила этот метод к моделям визуального языка, что еще больше расширила объем применения. Это инновация предоставляет новые идеи для исследования мультимодального ИИ и закладывает прочную основу для будущего технологического развития.

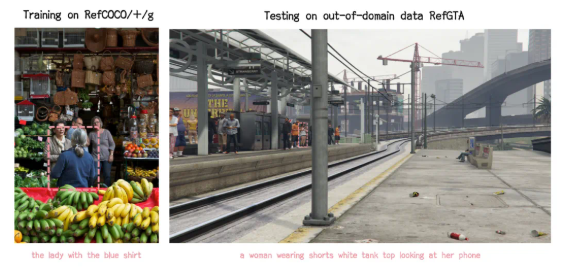

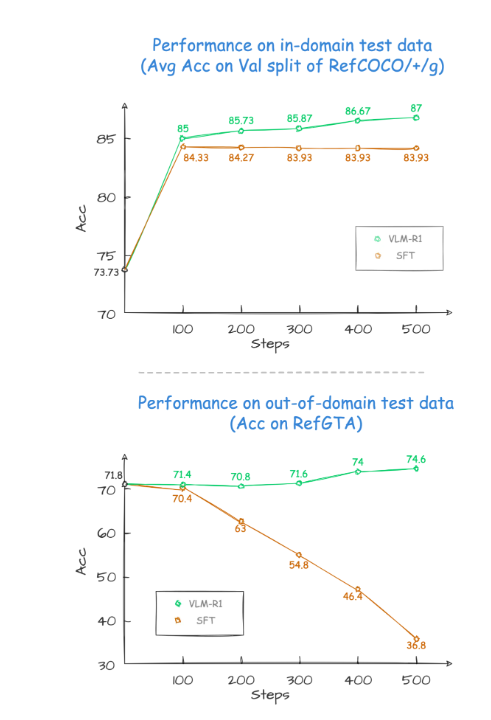

В процессе проверки проекта производительность VLM-R1 была удивительной. Прежде всего, метод R1 показывает чрезвычайно высокую стабильность в сложных сценариях, что особенно важно в практических приложениях. Во -вторых, модель превосходно работает в возможностях обобщения. Для сравнения экспериментов, производительность традиционной модели SFT (контролируемой тонкой настройки) постепенно снижается с увеличением числа этапов обучения на тестовых данных вне поля, в то время как модель R1 может продолжать улучшаться во время обучения. Это показывает, что метод R1 позволяет модели по -настоящему овладеть способностью понимать визуальный контент, а не полагаться исключительно на память.

Кроме того, проект VLM-R1 чрезвычайно трудно начать, и команда предоставляет разработчикам полный процесс обучения и оценки, чтобы разработчики могли быстро начать работу. В практическом случае модель было предложено найти пищу с самым высоким содержанием белка на сытной пищевой картине. Результатом стало не только ответ был точным, но и яичный пирог с наибольшим содержанием белка был выбран на картинке точно. Этот случай полностью демонстрирует выдающуюся производительность VLM-R1 в области визуального понимания и рассуждений.

Успешный запуск VLM-R1 не только доказывает универсальность метода R1, но также предоставляет новые идеи для обучения мультимодальных моделей, что указывает на прибытие новой тенденции обучения модели визуального языка. Что еще более захватывающе, так это то, что проект полностью открыт, и заинтересованные разработчики могут найти соответствующую информацию о GitHub. Эта мера с открытым исходным кодом, несомненно, привлечет больше разработчиков для участия и совместно способствовать развитию мультимодальной технологии ИИ.

Короче говоря, появление VLM-R1 ввело новую жизненную силу в исследование моделей визуального языка. Это не только демонстрирует технологические прорывы, но и обеспечивает новые направления для будущих исследований. Мы с нетерпением ожидаем участия в нем больше разработчиков, совместно продвигая постоянный прогресс мультимодальной технологии искусственного интеллекта, а также привнести больше инноваций и прорывов в области искусственного интеллекта.