최근 VLM-R1 프로젝트의 성공적인 출시로 인해 새로운 새벽이 시각적 언어 모델 분야로 가져 왔습니다. 이 프로젝트는 시각적 언어 모델에서 DeepSeek 팀의 R1 방법을 성공적으로 마이그레이션하여 AI의 시각적 컨텐츠에 대한 이해가 완전히 새로운 단계에 들어갈 것이라고 표시합니다. VLM-R1의 출시는 기술 혁신을 보여줄뿐만 아니라 멀티 모달 AI 연구를위한 새로운 방향을 열어줍니다.

VLM-R1은 작년에 DeepSeek 팀이 소스를 개설 한 R1 방법에서 영감을 얻었습니다. 이 방법은 GRPO (생성 된 보상 처리 최적화) 강화 학습 기술을 채택하며 일반 텍스트 처리 분야에서 놀라운 결과를 얻었습니다. 오늘날 VLM-R1 팀은이 방법을 시각적 언어 모델에 성공적으로 적용하여 응용 프로그램 범위를 더욱 확장했습니다. 이 혁신은 멀티 모달 AI 연구를위한 새로운 아이디어를 제공하고 미래의 기술 개발을위한 견고한 토대를 마련합니다.

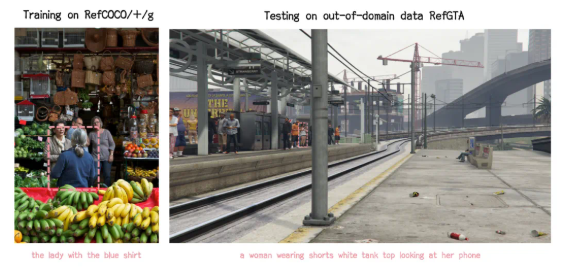

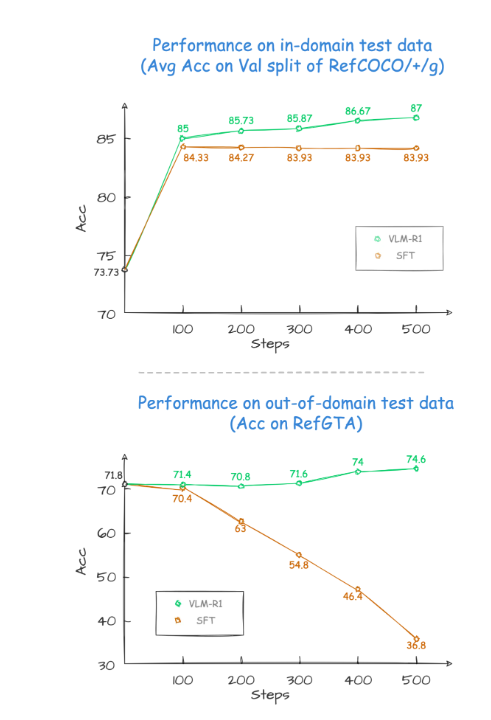

프로젝트 검증 프로세스 동안 VLM-R1의 성능은 놀랍습니다. 우선, R1 방법은 복잡한 시나리오에서 매우 높은 안정성을 보여 주며, 이는 실제 응용 분야에서 특히 중요합니다. 둘째, 모델은 일반화 기능에서 훌륭하게 수행됩니다. 비교하면, 전통적인 SFT (감독 미세 조정) 모델의 성능은 현장 외부 테스트 데이터에 대한 교육 단계의 수가 증가함에 따라 점차 감소하는 반면, R1 모델은 훈련 중에 계속 개선 될 수 있습니다. 이는 R1 방법을 통해 모델이 메모리에만 의존하기보다는 시각적 컨텐츠를 이해하는 능력을 진정으로 마스터 할 수 있음을 보여줍니다.

또한 VLM-R1 프로젝트는 시작하기가 매우 어렵고 팀은 개발자에게 완전한 교육 및 평가 프로세스를 제공하여 개발자가 빠르게 시작할 수 있도록 제공합니다. 실용적으로,이 모델은 풍성한 음식 그림에서 가장 높은 단백질 함량이있는 음식을 찾도록 요청 받았다. 결과는 답이 정확했을뿐만 아니라 가장 높은 단백질 함량을 가진 계란 케이크가 그림 상자에서 선택되었습니다. 이 사례는 시각적 이해와 추론 능력에서 VLM-R1의 뛰어난 성능을 완전히 보여줍니다.

VLM-R1의 성공적인 출시는 R1 방법의 다양성을 증명할뿐만 아니라 멀티 모달 모델 교육에 대한 새로운 아이디어를 제공하여 시각적 언어 모델 교육의 새로운 트렌드가 도착했음을 나타냅니다. 더 흥미로운 점은 프로젝트가 완전히 오픈 소스이며 관심있는 개발자가 GitHub에 대한 관련 정보를 찾을 수 있다는 것입니다. 이 오픈 소스 조치는 의심 할 여지없이 더 많은 개발자가 참여하여 다중 모드 AI 기술의 발전을 공동으로 홍보 할 것입니다.

요컨대, VLM-R1의 출현은 시각적 언어 모델의 연구에 새로운 활력을 주입했습니다. 그것은 기술적 혁신을 보여줄뿐만 아니라 향후 연구를위한 새로운 방향을 제공합니다. 우리는 더 많은 개발자들이 참여하여 멀티 모달 AI 기술의 지속적인 진행 상황을 공동으로 홍보하고 인공 지능 분야에 더 많은 혁신과 혁신을 가져 오기를 기대합니다.