Baru-baru ini, keberhasilan peluncuran proyek VLM-R1 telah membawa fajar baru ke bidang model bahasa visual. Proyek ini adalah migrasi yang sukses dari metode R1 tim Deepseek dalam model bahasa visual, menandai bahwa pemahaman AI tentang konten visual akan memasuki tahap yang sama sekali baru. Peluncuran VLM-R1 tidak hanya menunjukkan terobosan teknologi, tetapi juga membuka arah baru untuk penelitian AI multimodal.

VLM-R1 terinspirasi oleh metode R1 bahwa tim Deepseek membuka sumber tahun lalu. Metode ini mengadopsi teknologi pembelajaran penguatan GRPO (Optimasi Pemrosesan Hadiah), dan telah mencapai hasil yang luar biasa di bidang pemrosesan teks biasa. Saat ini, tim VLM-R1 telah berhasil menerapkan metode ini ke model bahasa visual, lebih lanjut memperluas ruang lingkup aplikasinya. Inovasi ini memberikan ide -ide baru untuk penelitian AI multimodal dan meletakkan dasar yang kuat untuk pengembangan teknologi di masa depan.

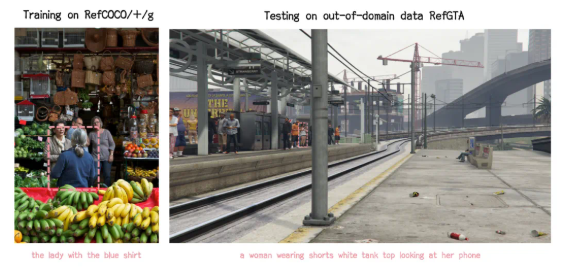

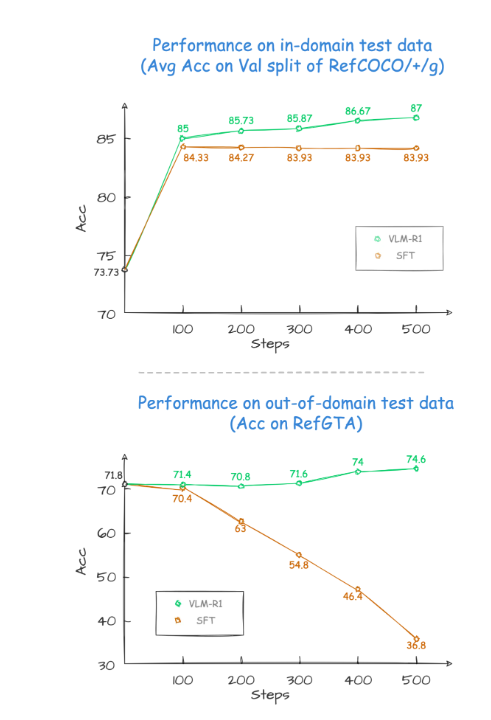

Selama proses verifikasi proyek, kinerja VLM-R1 luar biasa. Pertama -tama, metode R1 menunjukkan stabilitas yang sangat tinggi dalam skenario kompleks, yang sangat penting dalam aplikasi praktis. Kedua, model ini berkinerja sangat baik dalam kemampuan generalisasi. Sebagai percobaan perbandingan, kinerja model SFT tradisional (fine-tuning) secara bertahap menurun dengan peningkatan jumlah langkah pelatihan pada data uji di luar lapangan, sementara model R1 dapat terus meningkat selama pelatihan. Ini menunjukkan bahwa metode R1 memungkinkan model untuk benar -benar menguasai kemampuan untuk memahami konten visual daripada hanya mengandalkan memori.

Selain itu, proyek VLM-R1 sangat sulit untuk memulai, dan tim memberi pengembang proses pelatihan dan evaluasi lengkap, sehingga pengembang dapat memulai dengan cepat. Dalam kasus praktis, model ini diminta untuk menemukan makanan dengan kandungan protein tertinggi dalam gambaran makanan yang lezat. Hasilnya bukan hanya jawabannya akurat, tetapi juga kue telur dengan kandungan protein tertinggi dipilih dalam kotak secara akurat. Kasus ini sepenuhnya menunjukkan kinerja luar biasa dari VLM-R1 dalam pemahaman visual dan kemampuan penalaran.

Peluncuran VLM-R1 yang berhasil tidak hanya membuktikan fleksibilitas metode R1, tetapi juga menyediakan ide-ide baru untuk pelatihan model multimodal, yang menunjukkan kedatangan tren baru pelatihan model bahasa visual. Yang lebih menarik adalah bahwa proyek ini sepenuhnya open source dan pengembang yang tertarik dapat menemukan informasi yang relevan tentang GitHub. Ukuran open source ini tidak diragukan lagi akan menarik lebih banyak pengembang untuk berpartisipasi dan bersama -sama mempromosikan kemajuan teknologi AI multimodal.

Singkatnya, munculnya VLM-R1 telah menyuntikkan vitalitas baru ke dalam penelitian model bahasa visual. Ini tidak hanya menunjukkan terobosan teknologi, tetapi juga memberikan arahan baru untuk penelitian di masa depan. Kami menantikan lebih banyak pengembang yang berpartisipasi di dalamnya, bersama -sama mempromosikan kemajuan berkelanjutan teknologi AI multimodal, dan membawa lebih banyak inovasi dan terobosan ke bidang kecerdasan buatan.