最近、VLM-R1プロジェクトの発売の成功により、視覚言語モデルの分野に新しい夜明けがもたらされました。このプロジェクトは、Visual LanguageモデルにおけるDeepseekチームのR1メソッドの移行の成功であり、AIの視覚コンテンツの理解が完全に新しい段階に入ることをマークしています。 VLM-R1の発売は、技術的なブレークスルーを実証するだけでなく、マルチモーダルAIの研究のための新しい方向性を開始します。

VLM-R1は、DeepSeekチームが昨年ソースをオープンしたR1メソッドに触発されました。この方法は、GRPO(生成された報酬処理の最適化)補強学習技術を採用し、平易なテキスト処理の分野で顕著な結果を達成しています。今日、VLM-R1チームはこの方法を視覚言語モデルに適用し、アプリケーションの範囲をさらに拡大しています。この革新は、マルチモーダルAIの研究に新しいアイデアを提供し、将来の技術開発のための強固な基盤を築きます。

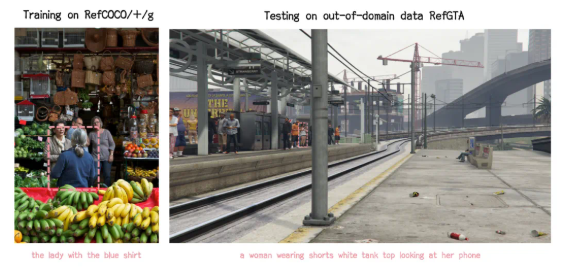

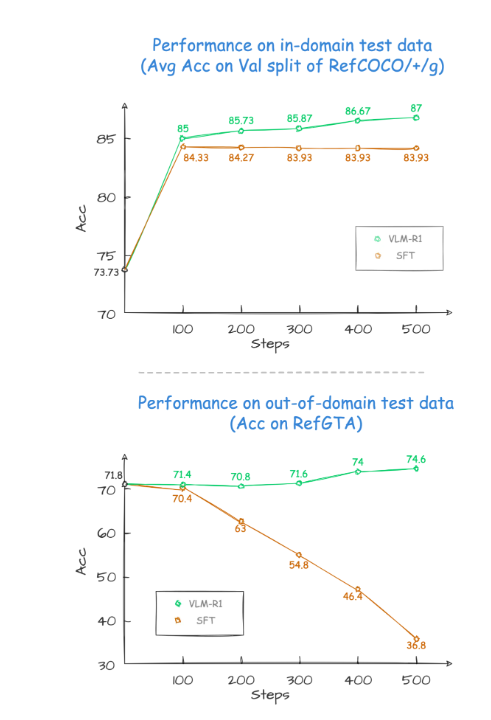

プロジェクト検証プロセス中、VLM-R1のパフォーマンスは驚くべきものでした。まず第一に、R1メソッドは複雑なシナリオで非常に高い安定性を示しています。これは、実際のアプリケーションで特に重要です。第二に、モデルは一般化機能において優れたパフォーマンスを発揮します。比較実験では、従来のSFT(監視付き微調整)モデルのパフォーマンスは、フィールド外のテストデータのトレーニングステップの数が増加すると徐々に減少しますが、R1モデルはトレーニング中に改善し続けることができます。これは、R1メソッドにより、モデルがメモリだけに依存するのではなく、視覚コンテンツを理解する能力を真にマスターできることを示しています。

さらに、VLM-R1プロジェクトを開始するのは非常に困難であり、チームは開発者に完全なトレーニングと評価プロセスを提供しているため、開発者は迅速に開始できます。実用的なケースでは、モデルは、心のこもった食物絵で最高のタンパク質含有量の食品を見つけるように求められました。その結果、答えは正確であるだけでなく、最高のタンパク質含有量を備えた卵ケーキも写真ボックスで選択されました。このケースは、視覚的理解と推論能力におけるVLM-R1の優れたパフォーマンスを完全に示しています。

VLM-R1の発売の成功は、R1メソッドの汎用性を証明するだけでなく、マルチモーダルモデルのトレーニングに新しいアイデアを提供し、視覚言語モデルトレーニングの新しいトレンドの到着を示しています。さらにエキサイティングなのは、プロジェクトが完全にオープンソースであり、興味のある開発者がGitHubで関連情報を見つけることができることです。このオープンソースの尺度は、間違いなく、より多くの開発者を引き付けて、マルチモーダルAIテクノロジーの進歩を共同で促進します。

要するに、VLM-R1の出現により、視覚言語モデルの研究に新しい活力を注入しました。技術的なブレークスルーを示すだけでなく、将来の研究のための新しい方向性も提供します。私たちは、より多くの開発者が参加し、マルチモーダルAIテクノロジーの継続的な進歩を共同で促進し、より多くのイノベーションとブレークスルーを人工知能の分野にもたらすことを楽しみにしています。