Récemment, le lancement réussi du projet VLM-R1 a amené une nouvelle aube dans le domaine des modèles de langage visuel. Ce projet est la migration réussie de la méthode R1 de l'équipe Deepseek dans le modèle de langage visuel, marquant que la compréhension de l'IA du contenu visuel entrera dans une étape complètement nouvelle. Le lancement de VLM-R1 démontre non seulement des percées technologiques, mais ouvre également de nouvelles directions pour la recherche de l'IA multimodale.

VLM-R1 a été inspiré par la méthode R1 que l'équipe Deepseek a ouvert la source l'année dernière. Cette méthode adopte la technologie d'apprentissage du renforcement GRPO (génération de récompense) et a obtenu des résultats remarquables dans le domaine du traitement de texte brut. Aujourd'hui, l'équipe VLM-R1 a réussi à appliquer cette méthode aux modèles de langage visuel, élargissant encore sa portée d'application. Cette innovation fournit de nouvelles idées pour la recherche de l'IA multimodale et jette une base solide pour le développement technologique futur.

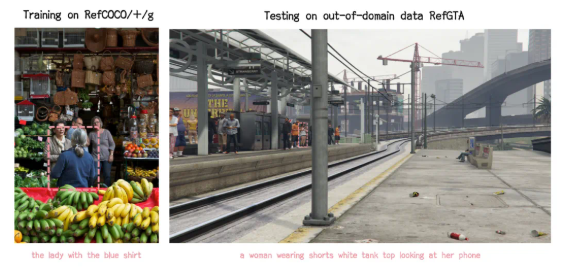

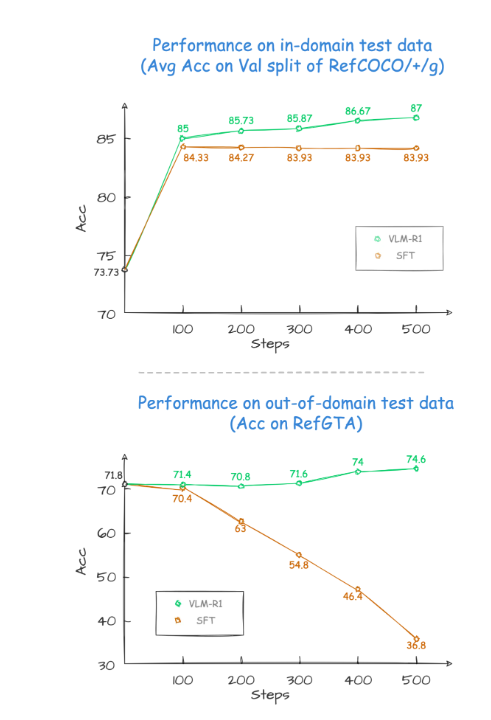

Pendant le processus de vérification du projet, les performances de VLM-R1 ont été incroyables. Tout d'abord, la méthode R1 montre une stabilité extrêmement élevée dans des scénarios complexes, ce qui est particulièrement important dans les applications pratiques. Deuxièmement, le modèle fonctionne parfaitement dans les capacités de généralisation. Dans les expériences de comparaison, les performances du modèle traditionnel SFT (réglage fin supervisé) diminue progressivement avec l'augmentation du nombre d'étapes de formation sur les données de test en dehors du domaine, tandis que le modèle R1 peut continuer à s'améliorer pendant la formation. Cela montre que la méthode R1 permet au modèle de maîtriser vraiment la capacité de comprendre le contenu visuel plutôt que de se fier uniquement à la mémoire.

De plus, le projet VLM-R1 est extrêmement difficile à commencer, et l'équipe offre aux développeurs un processus complet de formation et d'évaluation, afin que les développeurs puissent commencer rapidement. Dans un cas pratique, le modèle a été invité à trouver la nourriture avec la plus grande teneur en protéines dans une image alimentaire copieuse. Le résultat a été non seulement la réponse était exacte, mais aussi le gâteau à l'œuf avec la plus haute teneur en protéines a été sélectionné dans l'image avec précision. Cette affaire démontre entièrement les performances exceptionnelles de VLM-R1 dans la compréhension visuelle et les capacités de raisonnement.

Le lancement réussi de VLM-R1 prouve non seulement la polyvalence de la méthode R1, mais fournit également de nouvelles idées pour la formation des modèles multimodaux, indiquant l'arrivée d'une nouvelle tendance de la formation du modèle de langage visuel. Ce qui est encore plus excitant, c'est que le projet est entièrement open source et que les développeurs intéressés peuvent trouver des informations pertinentes sur GitHub. Cette mesure open source attirera sans aucun doute plus de développeurs pour participer et promouvoir conjointement l'avancement de la technologie d'IA multimodale.

En bref, l'avènement de VLM-R1 a injecté une nouvelle vitalité dans la recherche de modèles de langage visuel. Il démontre non seulement des percées technologiques, mais fournit également de nouvelles directions pour les recherches futures. Nous attendons avec impatience davantage de développeurs y participant, promouvant conjointement les progrès continus de la technologie d'IA multimodale et apportant plus d'innovations et de percées dans le domaine de l'intelligence artificielle.