Recentemente, o lançamento bem-sucedido do projeto VLM-R1 trouxe um novo amanhecer ao campo dos modelos de linguagem visual. Este projeto é a migração bem -sucedida do método R1 da equipe Deepseek no modelo de linguagem visual, marcando que a compreensão do conteúdo visual da IA entrará em um estágio completamente novo. O lançamento do VLM-R1 não apenas demonstra avanços tecnológicos, mas também abre novas direções para a pesquisa de IA multimodal.

O VLM-R1 foi inspirado pelo método R1 que a equipe Deepseek abriu a fonte no ano passado. Esse método adota a tecnologia de aprendizado de reforço de GRPO (Otimização de Processamento de Recompensa gerada) e alcançou resultados notáveis no campo do processamento de texto simples. Hoje, a equipe VLM-R1 aplicou com sucesso esse método aos modelos de linguagem visual, expandindo ainda mais seu escopo de aplicação. Essa inovação fornece novas idéias para a pesquisa de IA multimodal e estabelece uma base sólida para o desenvolvimento tecnológico futuro.

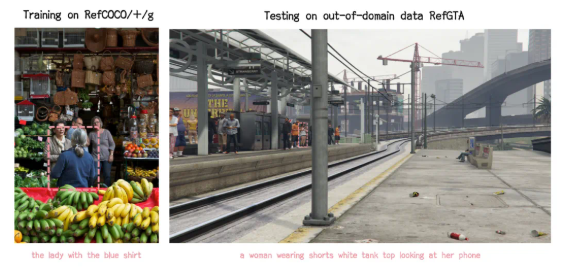

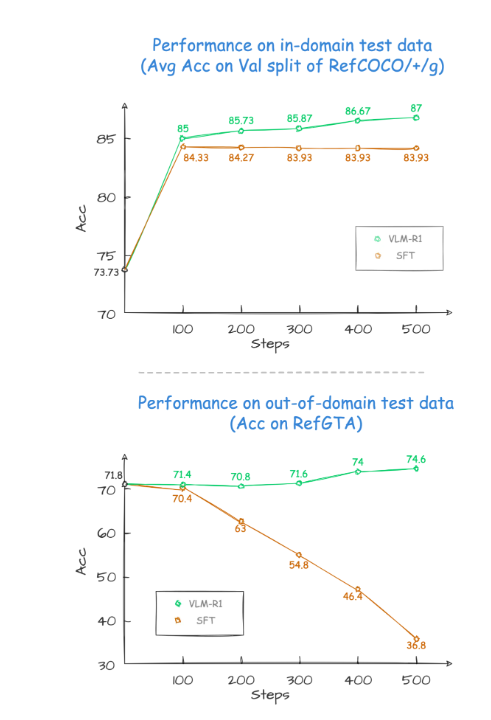

Durante o processo de verificação do projeto, o desempenho do VLM-R1 foi incrível. Primeiro de tudo, o método R1 mostra estabilidade extremamente alta em cenários complexos, o que é particularmente importante em aplicações práticas. Segundo, o modelo tem um desempenho excelentemente nas capacidades de generalização. Em experimentos de comparação, o desempenho do modelo tradicional de SFT (ajuste fino supervisionado) diminui gradualmente com o aumento do número de etapas de treinamento nos dados de teste fora do campo, enquanto o modelo R1 pode continuar a melhorar durante o treinamento. Isso mostra que o método R1 permite que o modelo domine verdadeiramente a capacidade de entender o conteúdo visual, em vez de confiar apenas na memória.

Além disso, o projeto VLM-R1 é extremamente difícil de começar, e a equipe fornece aos desenvolvedores um processo completo de treinamento e avaliação, para que os desenvolvedores possam começar rapidamente. Em um caso prático, o modelo foi convidado a encontrar a comida com o maior teor de proteínas em uma imagem saudável. O resultado não foi apenas a resposta foi precisa, mas também o bolo de ovo com o maior teor de proteínas foi selecionado na imagem com precisão da caixa. Este caso demonstra totalmente o excelente desempenho do VLM-R1 nas habilidades visuais de compreensão e raciocínio.

O lançamento bem-sucedido do VLM-R1 não apenas prova a versatilidade do método R1, mas também fornece novas idéias para o treinamento de modelos multimodais, indicando a chegada de uma nova tendência de treinamento em modelos de linguagem visual. O que é ainda mais emocionante é que o projeto é completamente de código aberto e os desenvolvedores interessados podem encontrar informações relevantes no GitHub. Essa medida de código aberto atrairá, sem dúvida, mais desenvolvedores para participar e promover em conjunto o avanço da tecnologia multimodal de IA.

Em suma, o advento do VLM-R1 injetou uma nova vitalidade na pesquisa de modelos de linguagem visual. Ele não apenas demonstra avanços tecnológicos, mas também fornece novas direções para pesquisas futuras. Estamos ansiosos para mais desenvolvedores que participam de TI, promovendo conjuntamente o progresso contínuo da tecnologia multimodal de IA e trazendo mais inovações e avanços para o campo da inteligência artificial.