Vor kurzem hat der erfolgreiche Start des VLM-R1-Projekts neue Morgendämmerung auf das Gebiet der visuellen Sprachmodelle gebracht. Dieses Projekt ist die erfolgreiche Migration der R1 -Methode des Deepseek -Teams im visuellen Sprachmodell und markiert, dass das Verständnis von AI für visuelle Inhalte in eine völlig neue Stufe eintritt. Der Start von VLM-R1 zeigt nicht nur technologische Durchbrüche, sondern eröffnet auch neue Richtungen für die Erforschung der multimodalen KI.

VLM-R1 wurde von der R1-Methode inspiriert, dass das Deepseek-Team im vergangenen Jahr die Quelle eröffnet hat. Diese Methode übernimmt die GRPO -Technologie zur Verstärkung der Verstärkung der Verstärkung von GRPO (generierte Belohnungsverarbeitung) und hat im Bereich der einfachen Textverarbeitung bemerkenswerte Ergebnisse erzielt. Heute hat das VLM-R1-Team diese Methode erfolgreich auf visuelle Sprachmodelle angewendet und seinen Anwendungsbereich weiter erweitert. Diese Innovation bietet neue Ideen für die Erforschung multimodaler KI und bildet eine solide Grundlage für die zukünftige technologische Entwicklung.

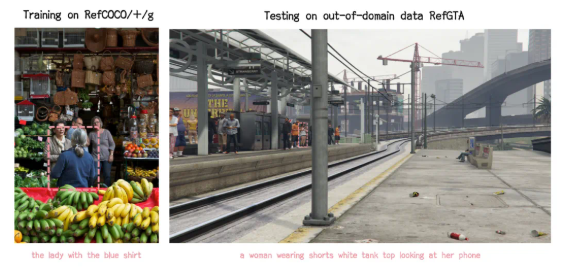

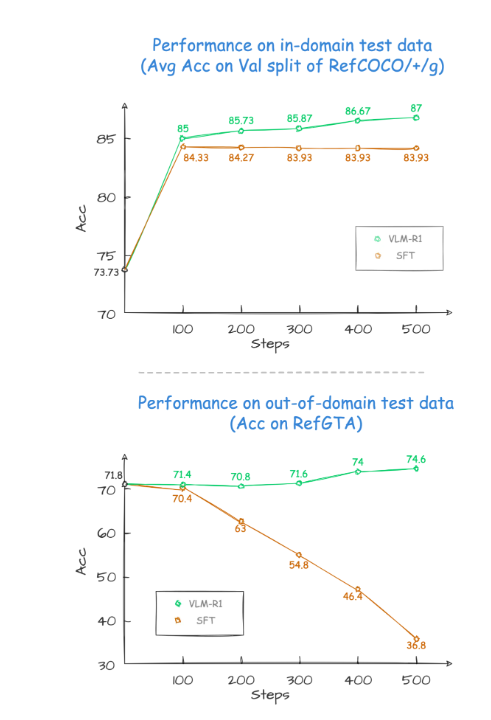

Während des Projektverifizierungsprozesses war die Leistung von VLM-R1 erstaunlich. Erstens zeigt die R1 -Methode eine extrem hohe Stabilität in komplexen Szenarien, was in praktischen Anwendungen besonders wichtig ist. Zweitens führt das Modell hervorragend in den Generalisierungsfunktionen aus. Bei Vergleichexperimenten nimmt die Leistung des traditionellen SFT-Modells (überwachte Feinabstimmung) mit der Zunahme der Anzahl der Trainingsschritte auf den Testdaten außerhalb des Feldes allmählich ab, während sich das R1-Modell während des Trainings weiter verbessern kann. Dies zeigt, dass die R1 -Methode es dem Modell ermöglicht, die Fähigkeit zu beherrschen, visuelle Inhalte zu verstehen, anstatt sich ausschließlich auf das Gedächtnis zu verlassen.

Darüber hinaus ist das VLM-R1-Projekt äußerst schwierig zu beginnen, und das Team bietet Entwicklern einen vollständigen Schulungs- und Bewertungsprozess, damit Entwickler schnell beginnen können. In einem praktischen Fall wurde das Modell gebeten, das Essen mit dem höchsten Proteingehalt in einem herzhaften Lebensmittelbild zu finden. Das Ergebnis war nicht nur die Antwort genau, sondern auch der Eierkuchen mit dem höchsten Proteingehalt wurde im Bild genau Box ausgewählt. Dieser Fall zeigt vollständig die herausragende Leistung von VLM-R1 in visuellen Verständnis- und Argumentationsfähigkeiten.

Der erfolgreiche Start von VLM-R1 beweist nicht nur die Vielseitigkeit der R1-Methode, sondern liefert auch neue Ideen für das Training multimodaler Modelle, was auf die Ankunft eines neuen Trends des Trainings für visuelles Sprachmodell hinweist. Noch aufregender ist, dass das Projekt vollständig Open Source ist und interessierte Entwickler relevante Informationen zu GitHub finden können. Diese Open -Source -Maßnahme wird zweifellos mehr Entwickler für die Teilnahme und gemeinsame Förderung der multimodalen KI -Technologie anziehen.

Kurz gesagt, das Aufkommen von VLM-R1 hat die Erforschung von visuellen Sprachmodellen neue Vitalität injiziert. Es zeigt nicht nur technologische Durchbrüche, sondern bietet auch neue Richtungen für zukünftige Forschung. Wir freuen uns darauf, dass mehr Entwickler daran teilnehmen, gemeinsam den kontinuierlichen Fortschritt der multimodalen KI -Technologie fördern und mehr Innovationen und Durchbrüche auf den Bereich der künstlichen Intelligenz bringen.