Recientemente, el exitoso lanzamiento del proyecto VLM-R1 ha traído al campo nuevo al campo de los modelos de lenguaje visual. Este proyecto es la migración exitosa del método R1 del equipo de Deepseek en el modelo de lenguaje visual, marcando que la comprensión de la IA del contenido visual entrará en una etapa completamente nueva. El lanzamiento de VLM-R1 no solo demuestra avances tecnológicos, sino que también abre nuevas direcciones para la investigación de IA multimodal.

VLM-R1 se inspiró en el método R1 que el equipo de Deepseek abrió la fuente el año pasado. Este método adopta la tecnología de aprendizaje de refuerzo GRPO (generada de procesamiento de recompensas), y ha logrado resultados notables en el campo del procesamiento de texto plano. Hoy, el equipo VLM-R1 ha aplicado con éxito este método a los modelos de lenguaje visual, ampliando aún más su alcance de aplicación. Esta innovación proporciona nuevas ideas para la investigación de la IA multimodal y establece una base sólida para el desarrollo tecnológico futuro.

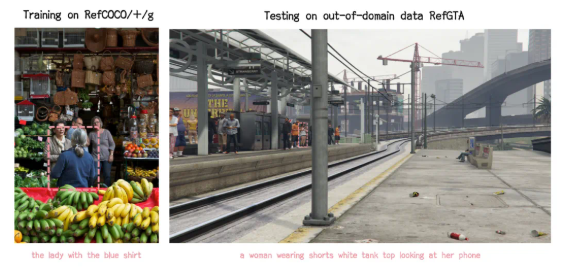

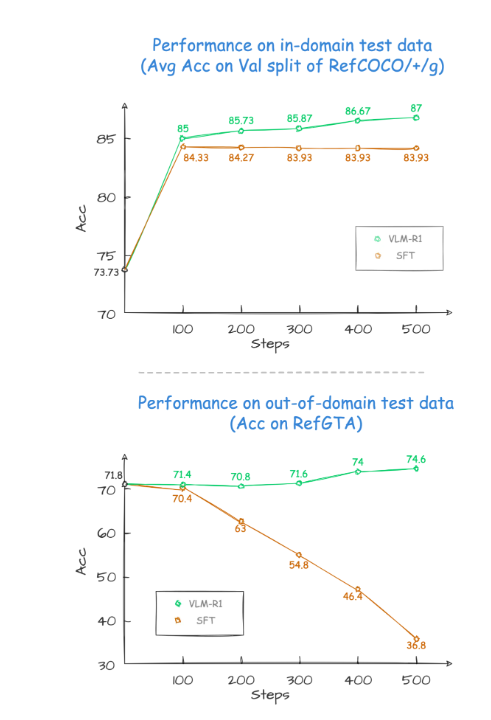

Durante el proceso de verificación del proyecto, el rendimiento de VLM-R1 fue increíble. En primer lugar, el método R1 muestra una estabilidad extremadamente alta en escenarios complejos, que es particularmente importante en aplicaciones prácticas. En segundo lugar, el modelo se desempeña excelentemente en las capacidades de generalización. En experimentos de comparación, el rendimiento del modelo SFT tradicional (ajuste fino supervisado) disminuye gradualmente con el aumento en el número de pasos de entrenamiento en los datos de prueba fuera del campo, mientras que el modelo R1 puede continuar mejorando durante el entrenamiento. Esto muestra que el método R1 permite que el modelo realmente domine la capacidad de comprender el contenido visual en lugar de depender únicamente de la memoria.

Además, el proyecto VLM-R1 es extremadamente difícil de comenzar, y el equipo ofrece a los desarrolladores un proceso completo de capacitación y evaluación, para que los desarrolladores puedan comenzar rápidamente. En un caso práctico, se le pidió al modelo que encontrara el alimento con el mayor contenido de proteínas en una imagen de comida abundante. El resultado no fue solo que la respuesta fue precisa, sino que también el pastel de huevo con el mayor contenido de proteína se seleccionó en la imagen con precisión. Este caso demuestra completamente el rendimiento sobresaliente de VLM-R1 en habilidades de comprensión visual y razonamiento.

El lanzamiento exitoso de VLM-R1 no solo prueba la versatilidad del método R1, sino que también proporciona nuevas ideas para la capacitación de modelos multimodales, lo que indica la llegada de una nueva tendencia de capacitación en modelos de lenguaje visual. Lo que es aún más emocionante es que el proyecto es completamente abierto y los desarrolladores interesados pueden encontrar información relevante en GitHub. Esta medida de código abierto sin duda atraerá a más desarrolladores para participar y promover conjuntamente el avance de la tecnología de IA multimodal.

En resumen, el advenimiento de VLM-R1 ha inyectado una nueva vitalidad en la investigación de los modelos de lenguaje visual. No solo demuestra avances tecnológicos, sino que también proporciona nuevas direcciones para futuras investigaciones. Esperamos que más desarrolladores participen en él, promoviendo conjuntamente el progreso continuo de la tecnología de IA multimodal y trayendo más innovaciones y avances al campo de la inteligencia artificial.