Редактор Downcodes узнал, что исследовательский институт Чжиюань недавно выпустил Infinity-Instruct — тщательно настроенный набор данных, содержащий десятки миллионов инструкций, призванный значительно улучшить производительность языковых моделей, особенно моделей диалога. Набор данных разделен на две части: базовый набор данных инструкций Infinity-Instruct-7M и набор данных диалоговых инструкций Infinity-Instruct-Gen. Первый содержит более 7,44 миллиона фрагментов данных, охватывающих несколько полей, и используется для улучшения. базовые возможности модели; последняя содержит 1,49 миллиона сложных инструкций, предназначенных для повышения устойчивости модели в реальных сценариях диалога. Согласно результатам испытаний, модель, настроенная с помощью Infinity-Instruct, добилась отличных результатов в нескольких основных оценочных списках, даже превзойдя некоторые официальные диалоговые модели.

Исследовательский институт Чжиюань запустил набор данных для точной настройки десятков миллионов инструкций под названием Infinity-Instruct, целью которого является повышение производительности языковых моделей в диалоге и других аспектах. Недавно Infinity Instruct завершила новый раунд итераций, включая базовый набор данных инструкций Infinity-Instruct-7M и набор данных диалоговых инструкций Infinity-Instruct-Gen.

Базовый набор данных инструкций Infinity-Instruct-7M содержит более 7,44 миллиона фрагментов данных, охватывающих такие области, как математика, кодирование и общие знания, вопросы и ответы, и предназначен для улучшения базовых возможностей предварительно обученных моделей. Результаты испытаний показывают, что модели Llama3.1-70B и Mistral-7B-v0.1, доработанные с использованием этого набора данных, по комплексным возможностям близки к официально выпущенной разговорной модели. Среди них Mistral-7B даже превосходит GPT. -3,5, а Llama3 .1-70B близок к GPT-4.

Набор данных инструкций диалога Infinity-Instruct-Gen содержит 1,49 миллиона синтетических сложных инструкций с целью повышения надежности модели в реальных сценариях диалога. После дальнейшей тонкой настройки с использованием этого набора данных модель может превзойти официальные диалоговые модели.

Исследовательский институт Чжиюань протестировал Infinity-Instruct в таких популярных списках оценки, как MTBench, AlpacaEval2 и Arena-Hard. Результаты показали, что модель, настроенная Infinity-Instruct, превзошла официальную модель с точки зрения диалоговых возможностей.

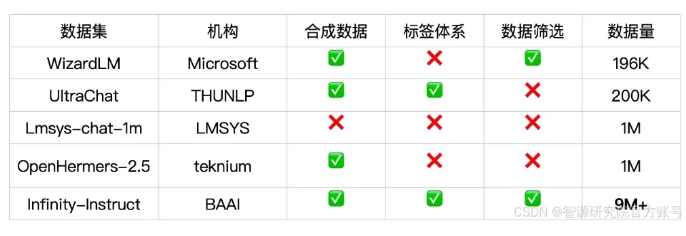

Infinity-Instruct предоставляет подробные аннотации для данных каждой инструкции, таких как язык, тип возможностей, тип задачи и источник данных, что позволяет пользователям легко фильтровать подмножества данных в соответствии с потребностями. Исследовательский институт Чжиюань создал высококачественные наборы данных посредством отбора данных и синтеза инструкций, чтобы устранить разрыв между моделями диалога с открытым исходным кодом и GPT-4.

В проекте также используется платформа обучения FlagScale для снижения затрат на тонкую настройку и устраняется дублирование выборок за счет дедупликации MinHash и извлечения BGE. В будущем Zhiyuan планирует открыть исходный код всего технологического кода обработки данных и обучения моделей, а также изучить возможность расширения стратегии данных Infinity-Instruct на этапы согласования и предварительного обучения для поддержки требований к данным полного жизненного цикла языковых моделей.

Ссылка на набор данных:

https://modelscope.cn/datasets/BAAI/Infinity-Instruct

Выпуск набора данных Infinity-Instruct предоставляет новый способ повышения производительности языковых моделей и способствует развитию технологии больших моделей. Редактор Downcodes надеется, что Infinity-Instruct можно будет улучшить в будущем, чтобы обеспечить поддержку большему количеству исследователей и разработчиков.