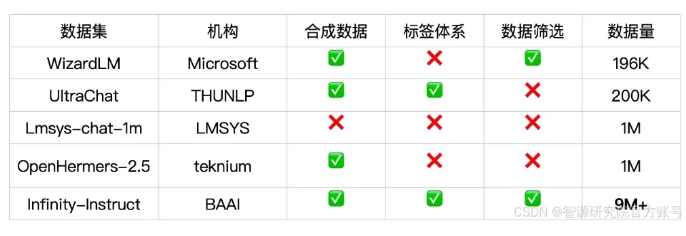

Downcodes의 편집자는 Zhiyuan Research Institute가 최근 언어 모델, 특히 대화 모델의 성능을 크게 향상시키는 것을 목표로 수천만 개의 명령이 포함된 미세 조정된 데이터 세트인 Infinity-Instruct를 출시했다는 사실을 알게 되었습니다. 데이터 세트는 Infinity-Instruct-7M 기본 명령 데이터 세트와 Infinity-Instruct-Gen 대화 명령 데이터 세트의 두 부분으로 나누어집니다. 전자는 여러 필드를 포괄하는 744만 개 이상의 데이터를 포함하고 있으며, 모델의 기본 기능에는 실제 대화 시나리오에서 모델의 견고성을 향상시키기 위해 설계된 149만 개의 복잡한 지침이 포함되어 있습니다. 테스트 결과에 따르면 Infinity-Instruct를 사용하여 미세 조정된 모델은 여러 주류 평가 목록에서 일부 공식 대화 모델을 능가하는 우수한 결과를 얻었습니다.

Zhiyuan Research Institute는 대화 및 기타 측면에서 언어 모델의 성능을 향상시키는 것을 목표로 Infinity-Instruct라는 수천만 개의 명령 미세 조정 데이터 세트를 출시했습니다. 최근 Infinity Instruct는 Infinity-Instruct-7M 기본 명령 데이터 세트와 Infinity-Instruct-Gen 대화 명령 데이터 세트를 포함하여 새로운 반복 라운드를 완료했습니다.

Infinity-Instruct-7M 기본 명령 데이터 세트에는 수학, 코드, 일반 지식 Q&A 등의 분야를 포괄하는 744만 개 이상의 데이터가 포함되어 있으며 사전 훈련된 모델의 기본 기능을 향상시키는 데 전념하고 있습니다. 테스트 결과는 이 데이터 세트를 사용하여 미세 조정된 Llama3.1-70B 및 Mistral-7B-v0.1 모델이 포괄적인 기능 측면에서 공식 출시된 대화 모델에 가까운 것으로 나타났습니다. 그중 Mistral-7B는 심지어 GPT를 능가합니다. -3.5, Llama3 .1-70B는 GPT-4에 가깝습니다.

Infinity-Instruct-Gen 대화 명령 데이터 세트에는 실제 대화 시나리오에서 모델의 견고성을 향상시키기 위한 목적으로 149만 개의 합성 복합 명령이 포함되어 있습니다. 이 데이터 세트를 사용하여 추가로 미세 조정한 후에는 모델이 공식 대화 모델보다 성능이 뛰어날 수 있습니다.

Zhiyuan Research Institute는 MTBench, AlpacaEval2 및 Arena-Hard와 같은 주류 평가 목록에서 Infinity-Instruct를 테스트한 결과 Infinity-Instruct로 미세 조정된 모델이 대화 기능 측면에서 공식 모델을 능가하는 것으로 나타났습니다.

Infinity-Instruct는 언어, 기능 유형, 작업 유형 및 데이터 소스와 같은 각 명령 데이터에 대한 자세한 주석을 제공하므로 사용자는 필요에 따라 데이터 하위 집합을 쉽게 필터링할 수 있습니다. Zhiyuan Research Institute는 오픈 소스 대화 모델과 GPT-4 간의 격차를 해소하기 위해 데이터 선택 및 명령 합성을 통해 고품질 데이터 세트를 구축했습니다.

또한 이 프로젝트는 FlagScale 교육 프레임워크를 사용하여 미세 조정 비용을 줄이고 MinHash 중복 제거 및 BGE 검색을 통해 중복 샘플을 제거합니다. Zhiyuan은 앞으로 데이터 처리 및 모델 훈련의 전체 프로세스 코드를 오픈 소스로 제공하고 Infinity-Instruct 데이터 전략을 정렬 및 사전 훈련 단계로 확장하여 언어 모델의 전체 수명 주기 데이터 요구 사항을 지원할 계획입니다.

데이터세트 링크:

https://modelscope.cn/datasets/BAAI/Infinity-Instruct

Infinity-Instruct 데이터 세트의 출시는 언어 모델의 성능을 향상시키는 새로운 방법을 제공하고 대형 모델 기술 개발에 기여합니다. Downcodes의 편집자는 Infinity-Instruct가 향후 더욱 개선되어 더 많은 연구자와 개발자에게 지원을 제공할 수 있기를 바랍니다.