Editor Downcodes mengetahui bahwa Zhiyuan Research Institute baru-baru ini merilis Infinity-Instruct, kumpulan data yang disempurnakan berisi puluhan juta instruksi, yang bertujuan untuk meningkatkan kinerja model bahasa secara signifikan, terutama model dialog. Kumpulan data dibagi menjadi dua bagian: kumpulan data instruksi dasar Infinity-Instruct-7M dan kumpulan data instruksi dialog Infinity-Instruct-Gen. Yang pertama berisi lebih dari 7,44 juta keping data, mencakup berbagai bidang, dan digunakan untuk meningkatkan kemampuan dasar model; model terakhir berisi 1,49 juta instruksi kompleks yang dirancang untuk meningkatkan ketahanan model dalam skenario dialog nyata. Berdasarkan hasil pengujian, model yang disempurnakan menggunakan Infinity-Instruct telah mencapai hasil luar biasa di berbagai daftar evaluasi arus utama, bahkan melampaui beberapa model dialog resmi.

Zhiyuan Research Institute telah meluncurkan puluhan juta kumpulan data penyempurnaan instruksi yang disebut Infinity-Instruct, yang bertujuan untuk meningkatkan kinerja model bahasa dalam dialog dan aspek lainnya. Baru-baru ini, Infinity Instruct telah menyelesaikan putaran baru iterasi, termasuk kumpulan data instruksi dasar Infinity-Instruct-7M dan kumpulan data instruksi dialog Infinity-Instruct-Gen.

Kumpulan data instruksi dasar Infinity-Instruct-7M berisi lebih dari 7,44 juta keping data, yang mencakup bidang-bidang seperti matematika, kode, dan Tanya Jawab pengetahuan umum, dan didedikasikan untuk meningkatkan kemampuan dasar model yang telah dilatih sebelumnya. Hasil pengujian menunjukkan bahwa model Llama3.1-70B dan Mistral-7B-v0.1 yang disempurnakan menggunakan kumpulan data ini mendekati model percakapan yang dirilis secara resmi dalam hal kemampuan komprehensif. Di antaranya, Mistral-7B bahkan melampaui GPT -3.5, sedangkan Llama3 .1-70B mendekati GPT-4.

Kumpulan data instruksi dialog Infinity-Instruct-Gen berisi 1,49 juta instruksi kompleks sintetik, dengan tujuan meningkatkan ketahanan model dalam skenario dialog nyata. Setelah penyempurnaan lebih lanjut menggunakan kumpulan data ini, model tersebut dapat mengungguli model percakapan resmi.

Zhiyuan Research Institute menguji Infinity-Instruct pada daftar evaluasi arus utama seperti MTBench, AlpacaEval2, dan Arena-Hard. Hasilnya menunjukkan bahwa model yang disempurnakan oleh Infinity-Instruct telah melampaui model resmi dalam hal kemampuan percakapan.

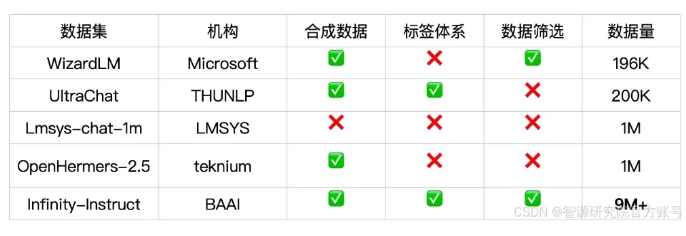

Infinity-Instruct memberikan anotasi mendetail untuk setiap data instruksi, seperti bahasa, tipe kapabilitas, tipe tugas, dan sumber data, sehingga memudahkan pengguna untuk memfilter subset data sesuai kebutuhan. Zhiyuan Research Institute telah membangun kumpulan data berkualitas tinggi melalui pemilihan data dan sintesis instruksi untuk menjembatani kesenjangan antara model percakapan sumber terbuka dan GPT-4.

Proyek ini juga menggunakan kerangka pelatihan FlagScale untuk mengurangi biaya penyesuaian, dan menghilangkan sampel duplikat melalui deduplikasi MinHash dan pengambilan BGE. Zhiyuan berencana untuk menjadikan seluruh kode proses pemrosesan data dan pelatihan model menjadi sumber terbuka di masa depan, dan mengeksplorasi perluasan strategi data Infinity-Instruct ke tahap penyelarasan dan pra-pelatihan untuk mendukung persyaratan data siklus hidup penuh model bahasa.

Tautan kumpulan data:

https://modelscope.cn/datasets/BAAI/Infinity-Instruct

Peluncuran kumpulan data Infinity-Instruct memberikan cara baru untuk meningkatkan kinerja model bahasa dan berkontribusi pada pengembangan teknologi model besar. Editor Downcodes berharap Infinity-Instruct dapat lebih ditingkatkan di masa depan untuk memberikan dukungan bagi lebih banyak peneliti dan pengembang.