Fastspeech-Pytorch

Реализация Fastspeech на основе Pytorch.

Обновление (2020/07/20)

- Оптимизировать процесс обучения.

- Оптимизировать реализацию регулятора длины.

- Используйте тот же гипер -параметр, что и Fastspeech2.

- Меры 1, 2 и 3 делают учебный процесс в 3 раза быстрее, чем раньше.

- Лучшее качество речи.

Модель

Мой блог

- Примечания к чтению быстрого речи

- Детали и переосмысление этой реализации

Подготовьте набор данных

- Скачать и извлечь набор данных LJSPEECH.

- Поместите набор данных LJSPEECH в

data . - Unzip

alignments.zip . - Поместите предварительную модель волнового потока NVIDIA в

waveglow/pretrained_model и переименовать в виде waveglow_256channels.pt ; - Запустите

python3 preprocess.py .

Обучение

Запустить python3 train.py .

Оценка

Запустить python3 eval.py

Примечания

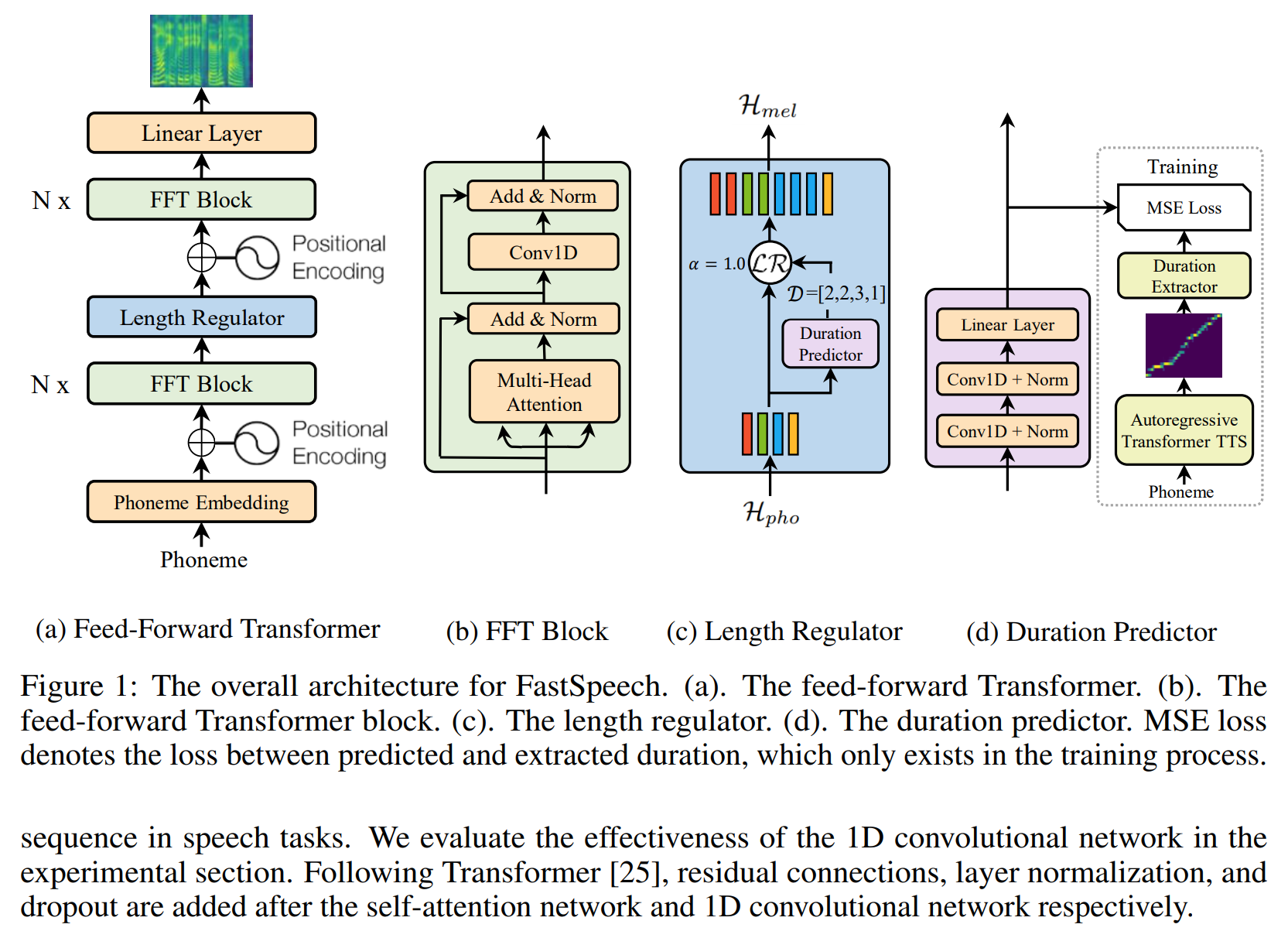

- В статье Fastspeech авторы используют предварительно обученную модель Transformer-TTS, чтобы обеспечить цель выравнивания. У меня не было хорошо обученной модели Transformer-TTS, поэтому я использую такотрон2 вместо этого.

- Я использую тот же гиперпараметр, что и Fastspeech2.

- Примеры звука находятся в

sample . - Предварительная модель.

Ссылка

Репозиторий

- Реализация такотрона на основе Tensorflow

- Реализация трансформатора на основе Pytorch

- Реализация Transformer-TTS на основе Pytorch

- Реализация такотрон2 на основе Pytorch

- Реализация FastSpeech2 на основе Pytorch

Бумага

- Такотрон2

- Трансформатор

- Fastspeech

- Fastspeech2