Fastspeech-pytorch

تنفيذ Fastspeech على أساس pytorch.

تحديث (2020/07/20)

- تحسين عملية التدريب.

- تحسين تنفيذ منظم الطول.

- استخدم نفس المعلمة Hyper مثل Fastspeech2.

- تدابير 1 و 2 و 3 تجعل عملية التدريب أسرع 3 مرات من ذي قبل.

- جودة الكلام الأفضل.

نموذج

مدونتي

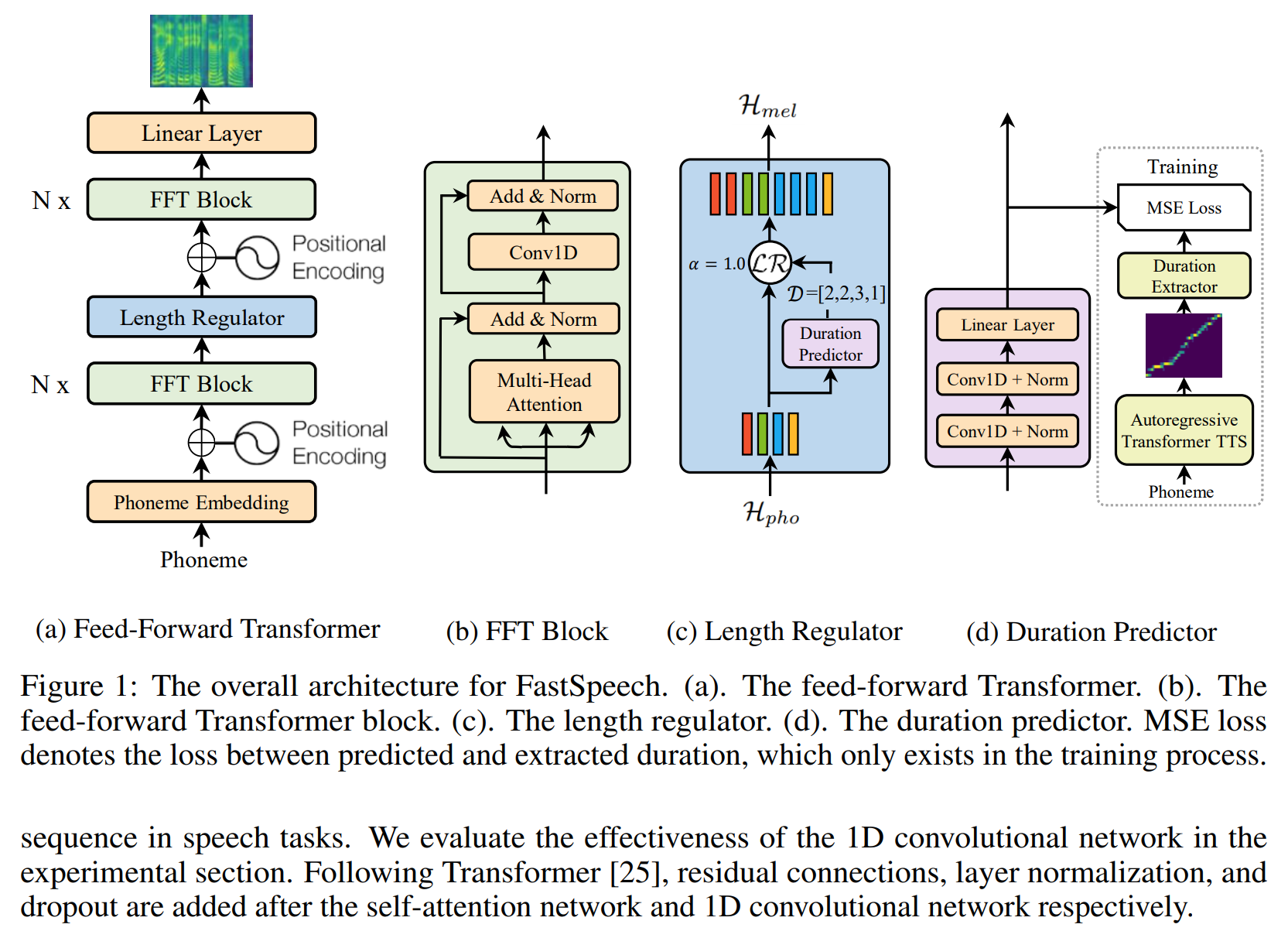

- ملاحظات القراءة السريعة

- التفاصيل وإعادة التفكير في هذا التنفيذ

إعداد مجموعة البيانات

- قم بتنزيل واستخراج مجموعة بيانات LJSpeech.

- ضع مجموعة بيانات LJSpeech في

data . - unzip

alignments.zip . - ضع نموذج WaveGlow pretrained nvidia في

waveglow/pretrained_model وإعادة تسمية باسم waveglow_256channels.pt ؛ - تشغيل

python3 preprocess.py .

تمرين

تشغيل python3 train.py .

تقييم

تشغيل python3 eval.py

ملحوظات

- في ورقة Fastspeech ، يستخدم المؤلفون نموذج Transformer Transed Transfort مسبقًا لتوفير هدف المحاذاة. لم يكن لدي نموذج Transformer-TTS مدرب جيدًا ، لذا فأنا أستخدم Tacotron2 بدلاً من ذلك.

- أستخدم نفس المعلمة المفرطة مثل Fastspeade2.

- أمثلة الصوت في

sample . - نموذج ما قبل.

مرجع

مستودع

- تنفيذ Tacotron على أساس TensorFlow

- تنفيذ المحول على أساس pytorch

- تنفيذ Transformer-TTS على أساس Pytorch

- تنفيذ Tacotron2 على أساس Pytorch

- تنفيذ fastspech2 بناءً على pytorch

ورق

- Tacotron2

- محول

- Fastspeech

- Fastspeech2