Fastspeech-Pytorch

Pytorch를 기반으로하는 FastSpeech의 구현.

업데이트 (2020/07/20)

- 교육 과정을 최적화하십시오.

- 길이 조절기의 구현을 최적화하십시오.

- FastSpeech2와 동일한 하이퍼 매개 변수를 사용하십시오.

- 1, 2 및 3의 측정 값은 훈련 과정을 이전보다 3 배 빠르게 만듭니다.

- 더 나은 언어 품질.

모델

내 블로그

- FastSpeech 읽기 노트

- 이 구현의 세부 사항 및 재고

데이터 세트를 준비하십시오

- ljspeech 데이터 세트를 다운로드하여 추출하십시오.

- ljspeech 데이터 세트를

data 에 넣으십시오. - zip

alignments.zip . - nvidia pretrained waveglow 모델을

waveglow/pretrained_model 에 넣고 waveglow_256channels.pt 로 이름을 바꿉니다. -

python3 preprocess.py 실행하십시오.

훈련

python3 train.py 실행하십시오.

평가

python3 eval.py 실행하십시오.

메모

- FastSpeech의 논문에서 저자는 사전 훈련 된 변압기 TTS 모델을 사용하여 정렬 목표를 제공합니다. 잘 훈련 된 변압기 TTS 모델이 없었기 때문에 대신 Tacotron2를 사용합니다.

- 나는 FastSpeech2와 동일한 하이퍼 매개 변수를 사용합니다.

- 오디오의 예는

sample 에 있습니다. - 사방 모델.

참조

저장소

- 텐서 플로에 기초한 타코 트론의 구현

- Pytorch를 기반으로 한 변압기 구현

- Pytorch를 기반으로 한 변압기 TT의 구현

- Pytorch에 기초한 Tacotron2의 구현

- Pytorch를 기반으로하는 FastSpeech2의 구현

종이

- 타코 트론 2

- 변신 로봇

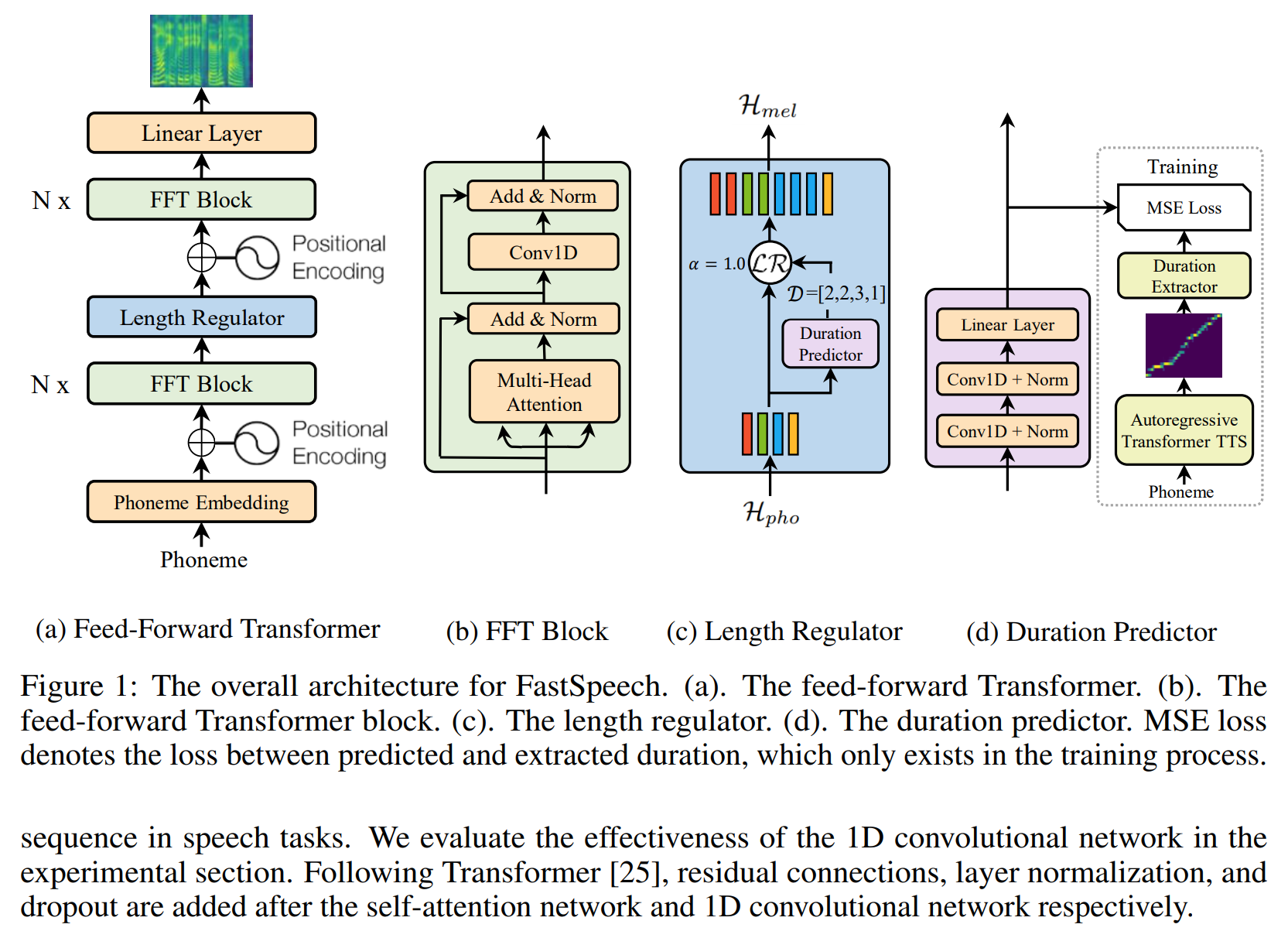

- FastSpeech

- FastSpeech2