В Европейской конференции по компьютерному видению (ECCV) 2024

(2024.08.07) Мы выпустили сценарий вывода для анимации изображений на основе ключей! Пожалуйста, обратитесь к здесь для получения дополнительных инструкций.

(2024.07.15) Мы выпустили код обучения для анимации изображений на основе траектории! Пожалуйста, обратитесь к здесь для получения дополнительных инструкций.

MOFA-Video будет появляться в ECCV 2024! ??????

Мы выпустили код вывода Gradio и контрольные точки для гибридных элементов управления! Пожалуйста, обратитесь к здесь для получения дополнительных инструкций.

Бесплатная онлайн -демонстрация через пространства для Huggingface скоро появится!

Если вы найдете эту работу интересной, пожалуйста, не стесняйтесь давать!

|  |  |

| Траектория + контроль достопримечательности | ||

|  |  |  |

| Контроль траектории | |||

|  |  |  |  |

| Основной контроль | ||||

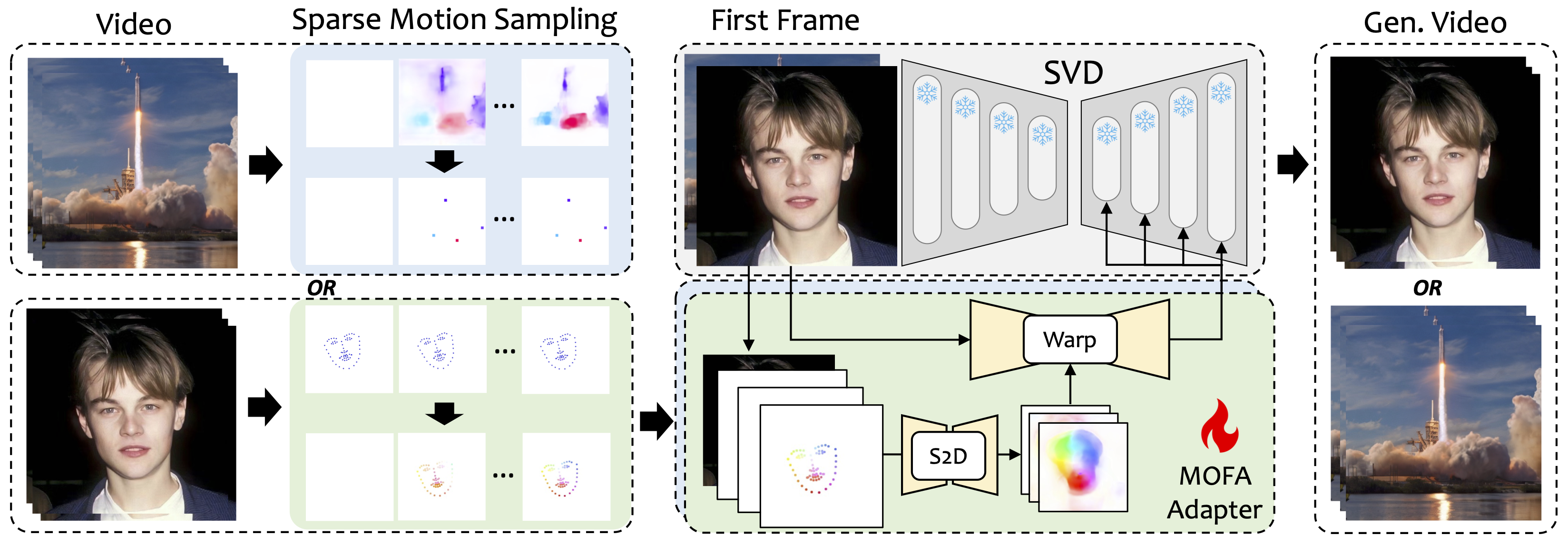

Мы вводим MOFA-Video, метод, предназначенный для адаптации движений из разных доменов к модели замороженной диффузии видео. Используя разреженную генерацию движения (S2D) и адаптацию движения на основе потока, MOFA-Video может эффективно оживить одно изображение, используя различные типы контрольных сигналов, включая траектории, последовательности клавиатуры и их комбинации.

На этапе тренировок мы генерируем редкие контрольные сигналы с помощью разреженной выборки движения, а затем обучаем различные адаптеры MOFA для создания видео через предварительно обученный SVD. На стадии вывода различные адаптеры MOFA могут быть объединены для совместного контроля замороженного SVD.

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

Демонстрация была протестирована на версии CUDA 11.7.

cd ./MOFA-Video-Hybrid

conda create -n mofa python==3.10

conda activate mofa

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

ВАЖНЫЙ:requirements.txt следует строго соблюдать, поскольку другие версии могут вызвать ошибки.

Загрузите контрольную точку CMP отсюда и поместите его в ./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints .

Загрузите папку ckpts из репо Haggingface, который содержит необходимые предварительные контрольные точки и поместите ее под ./MOFA-Video-Hybrid . Вы можете использовать git lfs для загрузки всей папки ckpts :

git lfs с https://git-lfs.github.com. Он обычно используется для клонирования хранилища с большими модельными контрольно -пропускными пунктами на HuggingFace.git clone https://huggingface.co/MyNiuuu/MOFA-Video-Hybrid чтобы загрузить полный репозиторий Huggingface, который в настоящее время включает в себя только папку ckpts .ckpts в репозиторий GitHub. ПРИМЕЧАНИЕ. Если вы столкнетесь с ошибкой git: 'lfs' is not a git command на Linux, вы можете попробовать это решение, которое хорошо сработало для моего случая.

Наконец, контрольно-пропускные пункты должны быть оборваны как ./MOFA-Video-Hybrid/ckpt_tree.md .

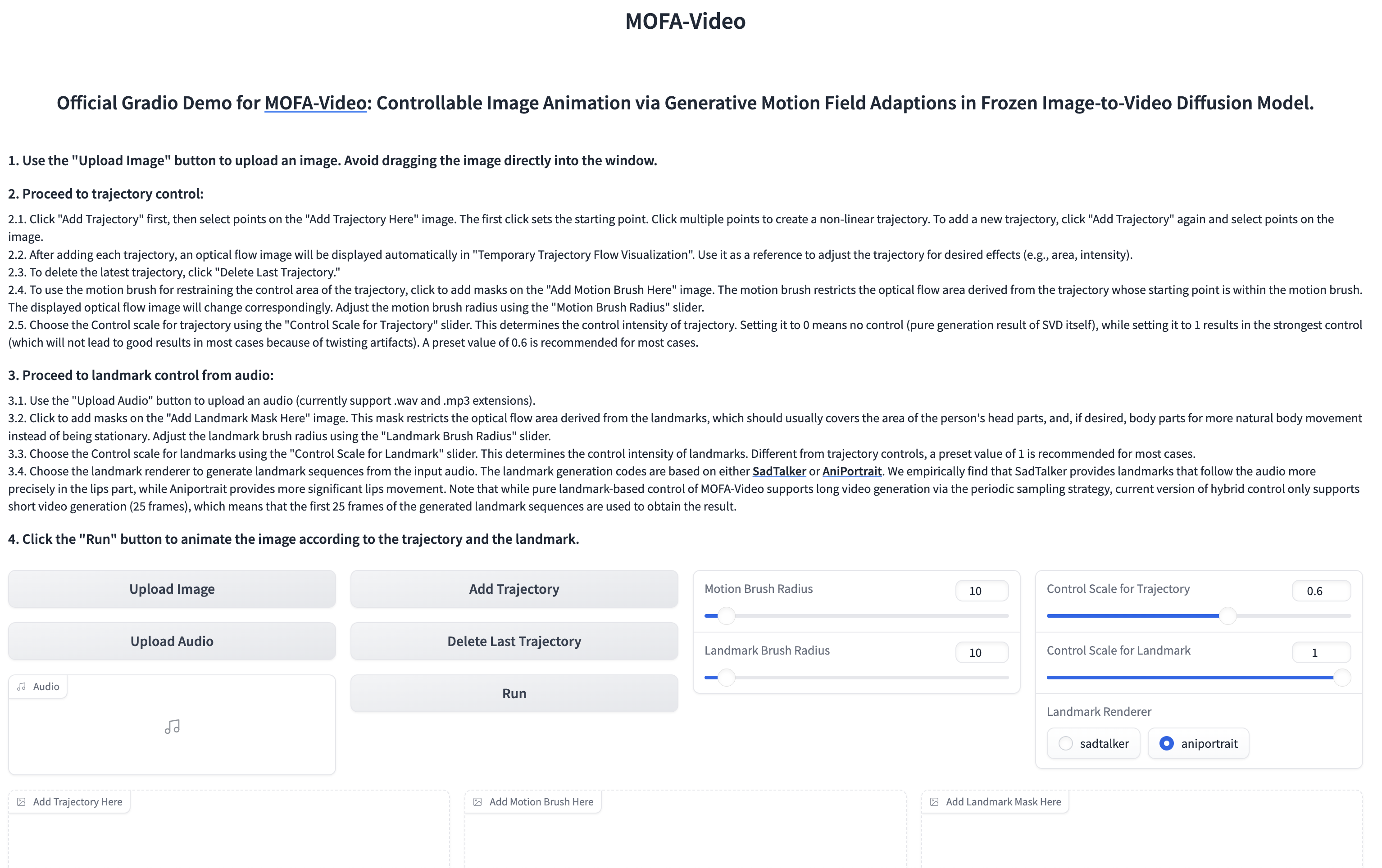

Использование аудио для анимулирования лица лица

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

??? Интерфейс Gradio отображается, как показано ниже. Пожалуйста, обратитесь к инструкциям по интерфейсу Gradio в процессе вывода!

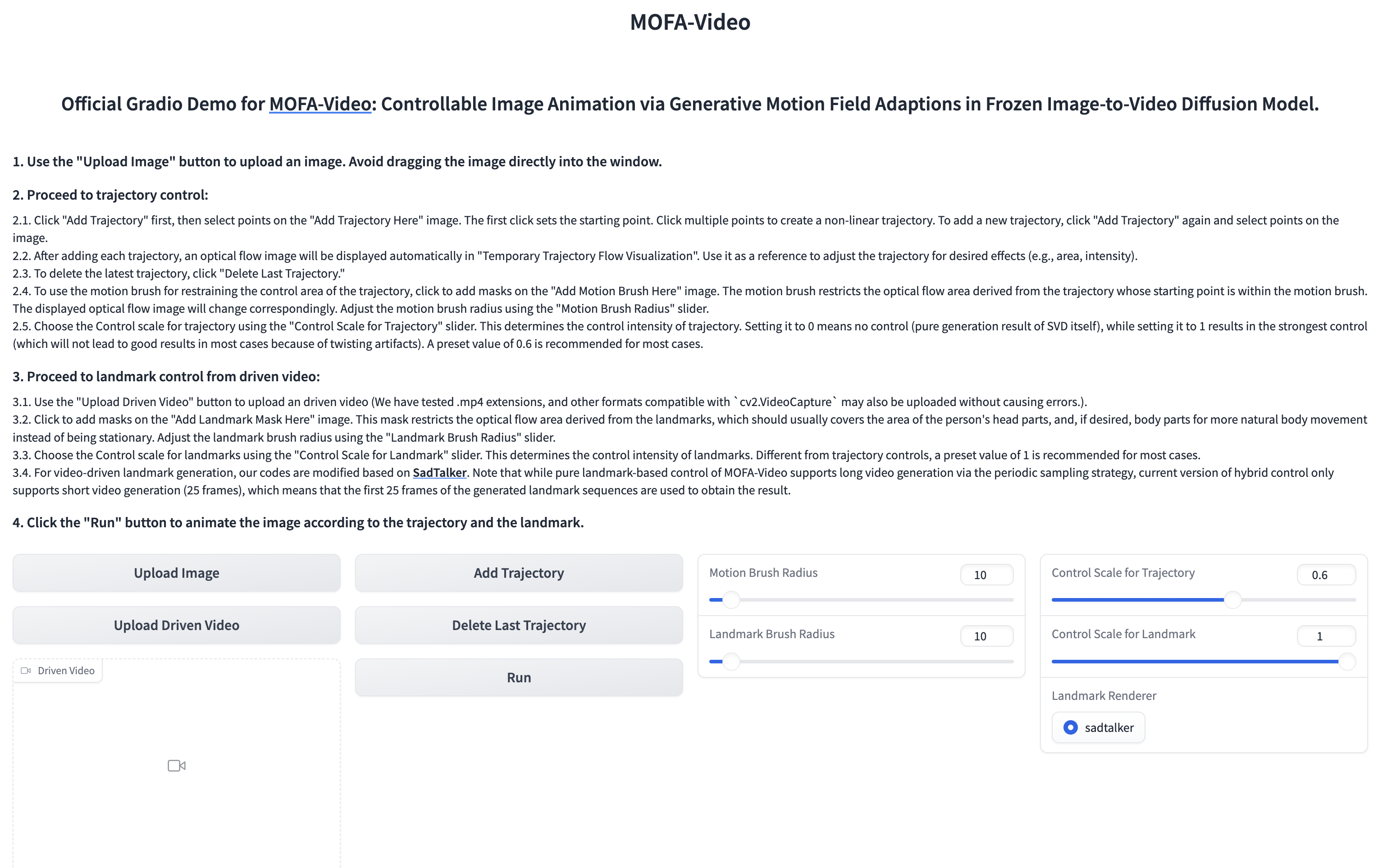

Использование эталонного видео, чтобы оживить лицевую часть

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

??? Интерфейс Gradio отображается, как показано ниже. Пожалуйста, обратитесь к инструкциям по интерфейсу Gradio в процессе вывода!

Пожалуйста, обратитесь к инструкциям.

Пожалуйста, обратитесь к здесь для получения дополнительных инструкций.

@article{niu2024mofa,

title={MOFA-Video: Controllable Image Animation via Generative Motion Field Adaptions in Frozen Image-to-Video Diffusion Model},

author={Niu, Muyao and Cun, Xiaodong and Wang, Xintao and Zhang, Yong and Shan, Ying and Zheng, Yinqiang},

journal={arXiv preprint arXiv:2405.20222},

year={2024}

}

Мы искренне ценим выпуск кода следующих проектов: Dragnuwa, Sadtalker, Aniportrait, Diffusers, SVD_XTEND, Распространение по условным движениям и Unimatch.