컴퓨터 비전에 관한 유럽 회의 (ECCV) 2024

(2024.08.07) 우리는 KeyPoint 기반 얼굴 이미지 애니메이션에 대한 추론 스크립트를 발표했습니다! 더 많은 지침은 여기를 참조하십시오.

(2024.07.15) 우리는 궤적 기반 이미지 애니메이션을위한 교육 코드를 발표했습니다! 더 많은 지침은 여기를 참조하십시오.

Mofa-Video는 ECCV 2024에 나타납니다! ??????

우리는 하이브리드 컨트롤에 대한 Gradio 추론 코드와 검문소를 출시했습니다! 더 많은 지침은 여기를 참조하십시오.

Huggingface Spaces를 통한 무료 온라인 데모가 곧 출시 될 예정입니다!

이 일이 흥미로워지면 주저하지 말고 주시기 바랍니다!

|  |  |

| 궤적 + 랜드 마크 제어 | ||

|  |  |  |

| 궤적 제어 | |||

|  |  |  |  |

| 랜드 마크 제어 | ||||

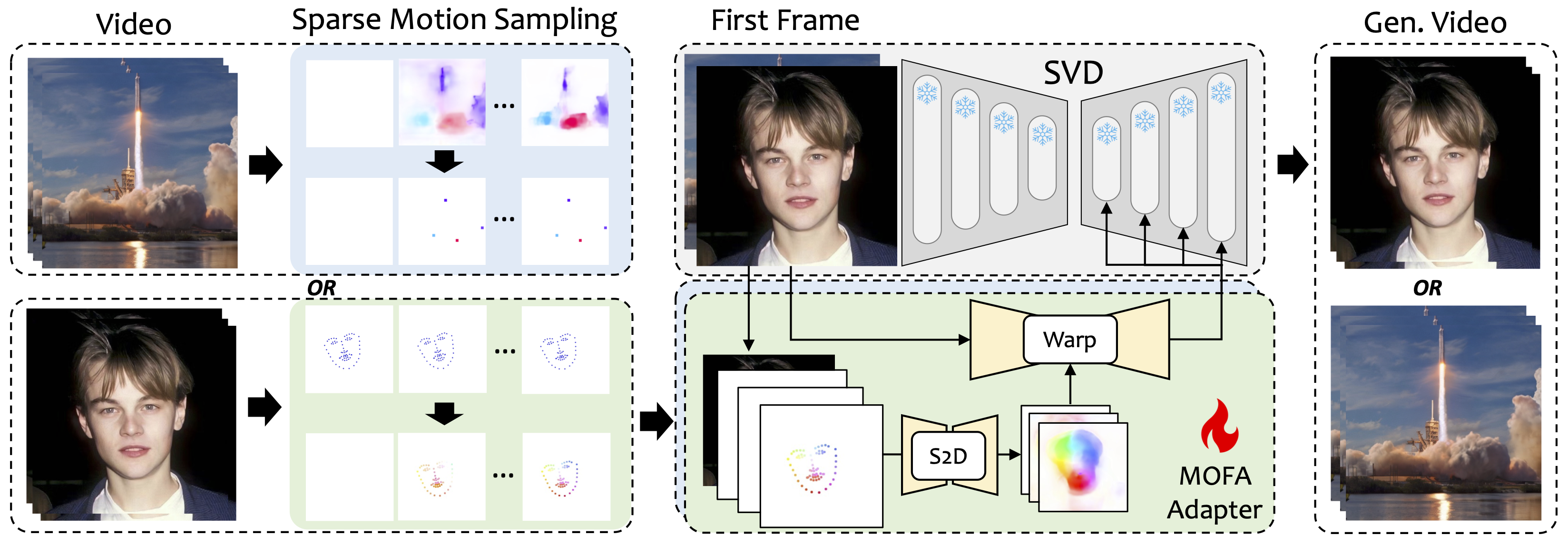

우리는 다른 도메인에서 냉동 비디오 확산 모델로의 동작을 조정하도록 설계된 방법 인 Mofa-Video를 소개합니다. S2D (Sparse-to-dense) 모션 생성 및 흐름 기반 모션 적응을 사용함으로써 MoFA-Video는 궤적, 키패 시퀀스 및 조합을 포함한 다양한 유형의 제어 신호를 사용하여 단일 이미지를 효과적으로 애니메이션 할 수 있습니다.

훈련 단계에서 드문 모션 샘플링을 통해 드문 제어 신호를 생성 한 다음 다른 MOFA 자산을 훈련하여 미리 훈련 된 SVD를 통해 비디오를 생성합니다. 추론 단계 동안, 상이한 MOFA 자산을 결합하여 동결 된 SVD를 공동 제어 할 수있다.

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

데모는 Cuda 버전 11.7에서 테스트되었습니다.

cd ./MOFA-Video-Hybrid

conda create -n mofa python==3.10

conda activate mofa

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

중요한:requirements.txt 에서 4.5.0 의 Gradio 버전 .TXT는 다른 버전이 오류를 일으킬 수 있으므로 엄격하게 따라야합니다.

여기에서 CMP의 체크 포인트를 다운로드하여 ./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints 에 넣으십시오.

필요한 사전 체크 포인트가 포함 된 Huggingface Repo에서 ckpts 폴더를 다운로드하여 ./MOFA-Video-Hybrid 아래에 넣으십시오. git lfs 사용하여 전체 ckpts 폴더를 다운로드 할 수 있습니다.

git lfs 다운로드하십시오. 포옹 페이스에 큰 모델 체크 포인트가있는 저장소 복제에 일반적으로 사용됩니다.git clone https://huggingface.co/MyNiuuu/MOFA-Video-Hybrid 실행하여 현재 ckpts 폴더 만 포함하는 완전한 HuggingFace 저장소를 다운로드하십시오.ckpts 폴더를 GitHub 저장소로 복사하거나 이동하십시오. 참고 : 오류가 발생하면 git: 'lfs' is not a git command 로 제 케이스에 잘 작동 한이 솔루션을 시도해 볼 수 있습니다.

마지막으로, 체크 포인트는 ./MOFA-Video-Hybrid/ckpt_tree.md 로 orgnized해야합니다.

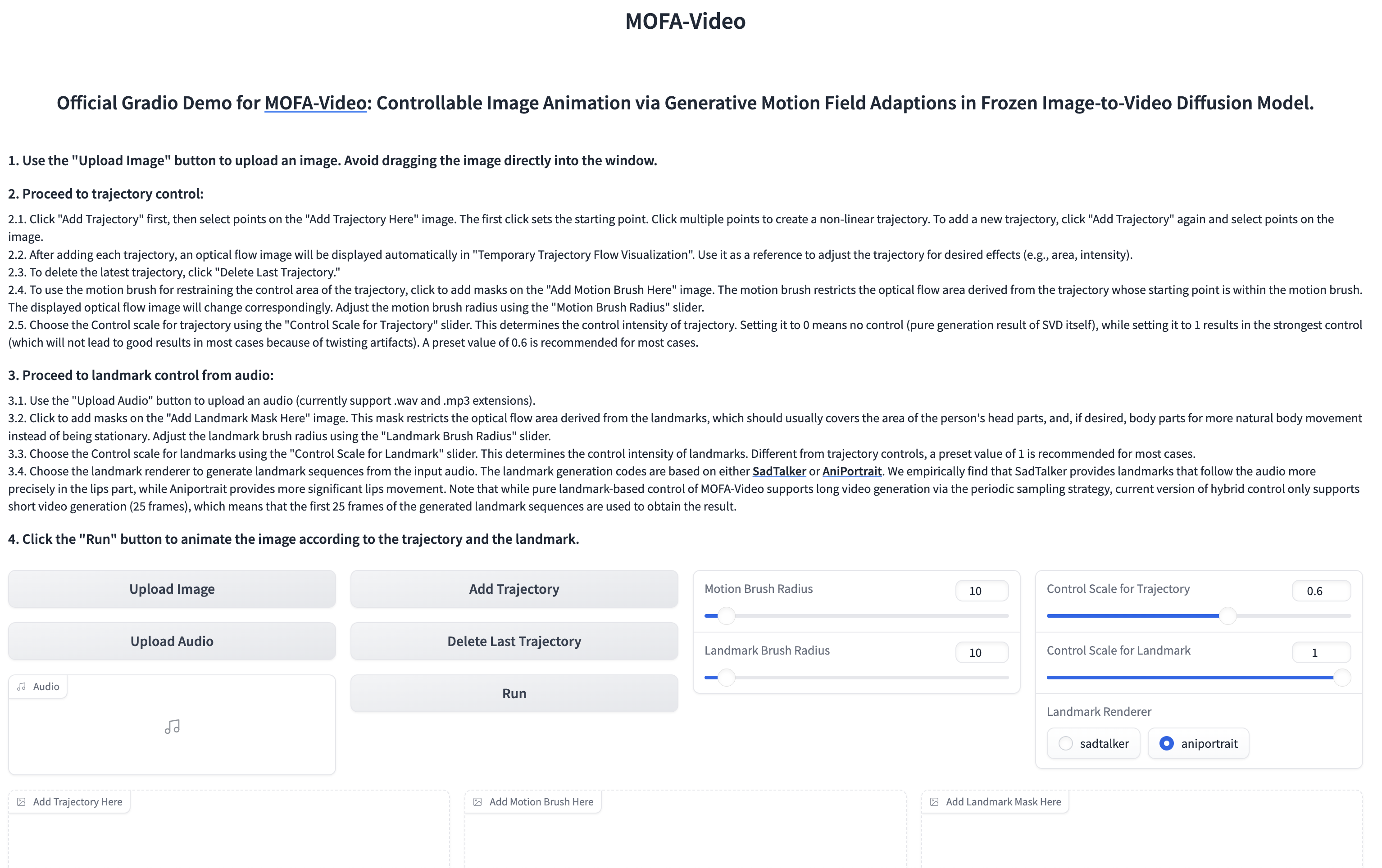

오디오를 사용하여 얼굴 부분을 애니메이션합니다

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

? Gradio 인터페이스는 다음과 같이 표시됩니다. 추론 과정에서 Gradio 인터페이스의 지침을 참조하십시오!

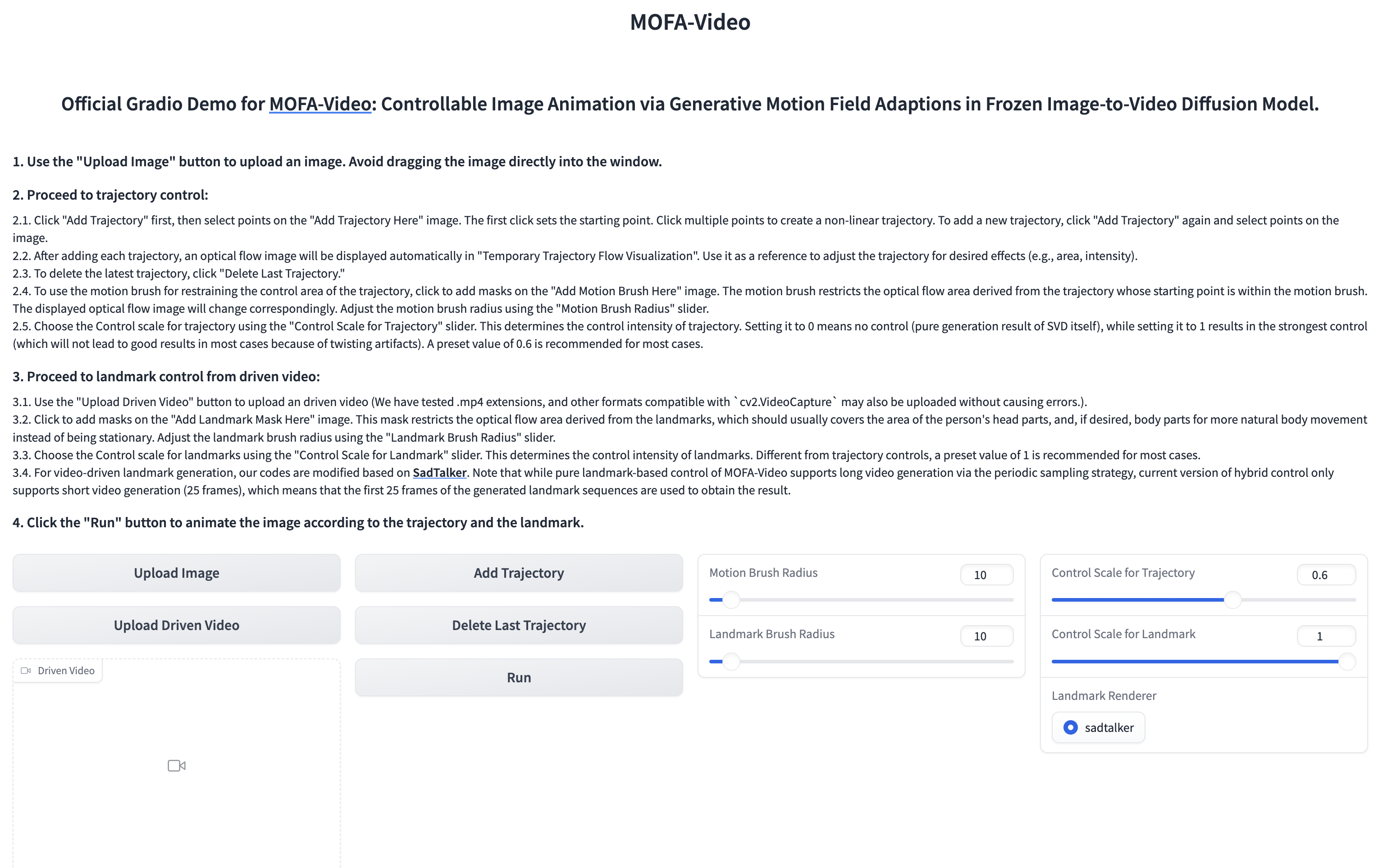

참조 비디오를 사용하여 얼굴 부분에 애니메이션

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

? Gradio 인터페이스는 다음과 같이 표시됩니다. 추론 과정에서 Gradio 인터페이스의 지침을 참조하십시오!

지침은 여기를 참조하십시오.

더 많은 지침은 여기를 참조하십시오.

@article{niu2024mofa,

title={MOFA-Video: Controllable Image Animation via Generative Motion Field Adaptions in Frozen Image-to-Video Diffusion Model},

author={Niu, Muyao and Cun, Xiaodong and Wang, Xintao and Zhang, Yong and Shan, Ying and Zheng, Yinqiang},

journal={arXiv preprint arXiv:2405.20222},

year={2024}

}

Dragnuwa, Sadtalker, Aniportrait, Diffusers, SVD_Xtend, 조건부 모션 프로파일 및 Unimatch의 코드 릴리스에 진심으로 감사드립니다.