في المؤتمر الأوروبي حول رؤية الكمبيوتر (ECCV) 2024

(2024.08.07) لقد أصدرنا البرنامج النصي للاستدلال للرسوم المتحركة على صورة الوجه المستندة إلى Keypoint! يرجى الرجوع إلى هنا لمزيد من التعليمات.

(2024.07.15) لقد أصدرنا رمز التدريب للرسوم المتحركة القائمة على المسار! يرجى الرجوع إلى هنا لمزيد من التعليمات.

سيظهر Mofa-Video في ECCV 2024! ؟؟؟؟؟؟

لقد أصدرنا رمز الاستدلال Gradio ونقاط التفتيش لعناصر التحكم الهجينة ! يرجى الرجوع إلى هنا لمزيد من التعليمات.

سيأتي العرض التجريبي المجاني عبر الإنترنت عبر مساحات Huggingface قريبًا!

إذا وجدت هذا العمل مثيرًا للاهتمام ، فالرجاء عدم التردد في إعطاء!

|  |  |

| المسار + السيطرة التاريخية | ||

|  |  |  |

| السيطرة على المسار | |||

|  |  |  |  |

| السيطرة التاريخية | ||||

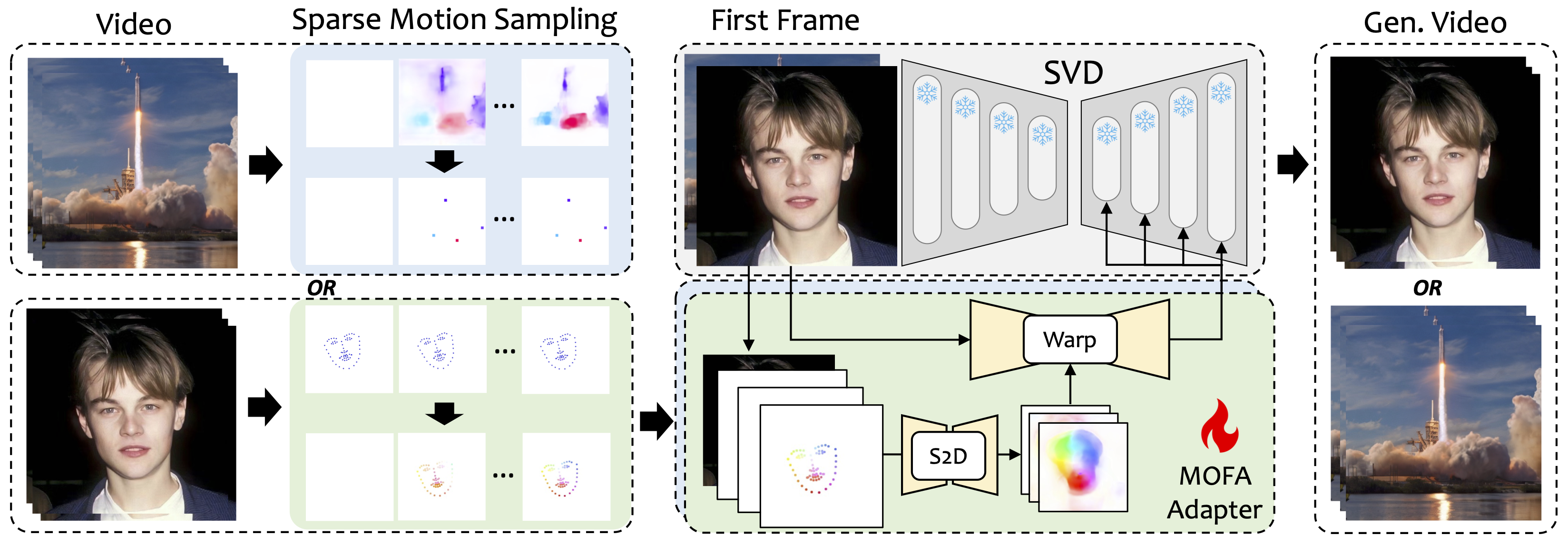

نقدم Mofa-Video ، وهي طريقة مصممة لتكييف الحركات من مجالات مختلفة إلى نموذج نشر الفيديو المجمد. من خلال استخدام توليد الحركة المتناثر إلى الكثافة (S2D) والتكيف مع الحركة المستندة إلى التدفق ، يمكن لـ MOFA-Video تنشيط صورة واحدة بشكل فعال باستخدام أنواع مختلفة من إشارات التحكم ، بما في ذلك المسارات وتسلسلات المفاتيح ومجموعاتها.

خلال مرحلة التدريب ، نقوم بإنشاء إشارات تحكم متفرقة من خلال أخذ عينات من الحركة المتفرقة ثم تدريبات Mofa-Adapters مختلفة لإنشاء الفيديو عبر SVD المدربين مسبقًا. خلال مرحلة الاستدلال ، يمكن الجمع بين أدوات MOFA المختلفة للتحكم في SVD المجمدة بشكل مشترك.

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

تم اختبار العرض التوضيحي على إصدار CUDA من 11.7.

cd ./MOFA-Video-Hybrid

conda create -n mofa python==3.10

conda activate mofa

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

مهم:requirements.txt يجب اتباعها بدقة لأن الإصدارات الأخرى قد تسبب أخطاء.

قم بتنزيل نقطة تفتيش CMP من هنا ووضعها في ./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints

قم بتنزيل مجلد ckpts من Reggingface Repo الذي يحتوي على نقاط تفتيش ضرورية ووضعه تحت ./MOFA-Video-Hybrid . يمكنك استخدام git lfs لتنزيل مجلد ckpts بالكامل :

git lfs من https://git-lfs.github.com. يتم استخدامه بشكل شائع لاستنساخ مستودعات مع نقاط تفتيش نموذج كبيرة على Luggingface.git clone https://huggingface.co/MyNiuuu/MOFA-Video-Hybrid لتنزيل مستودع Luggingface الكامل ، والذي يتضمن حاليًا فقط مجلد ckpts .ckpts إلى مستودع GitHub. ملاحظة: إذا واجهت git: 'lfs' is not a git command على Linux ، فيمكنك تجربة هذا الحل الذي عمل بشكل جيد لحالتي.

أخيرًا ، يجب أن تكون نقاط التفتيش orgnized As ./MOFA-Video-Hybrid/ckpt_tree.md .

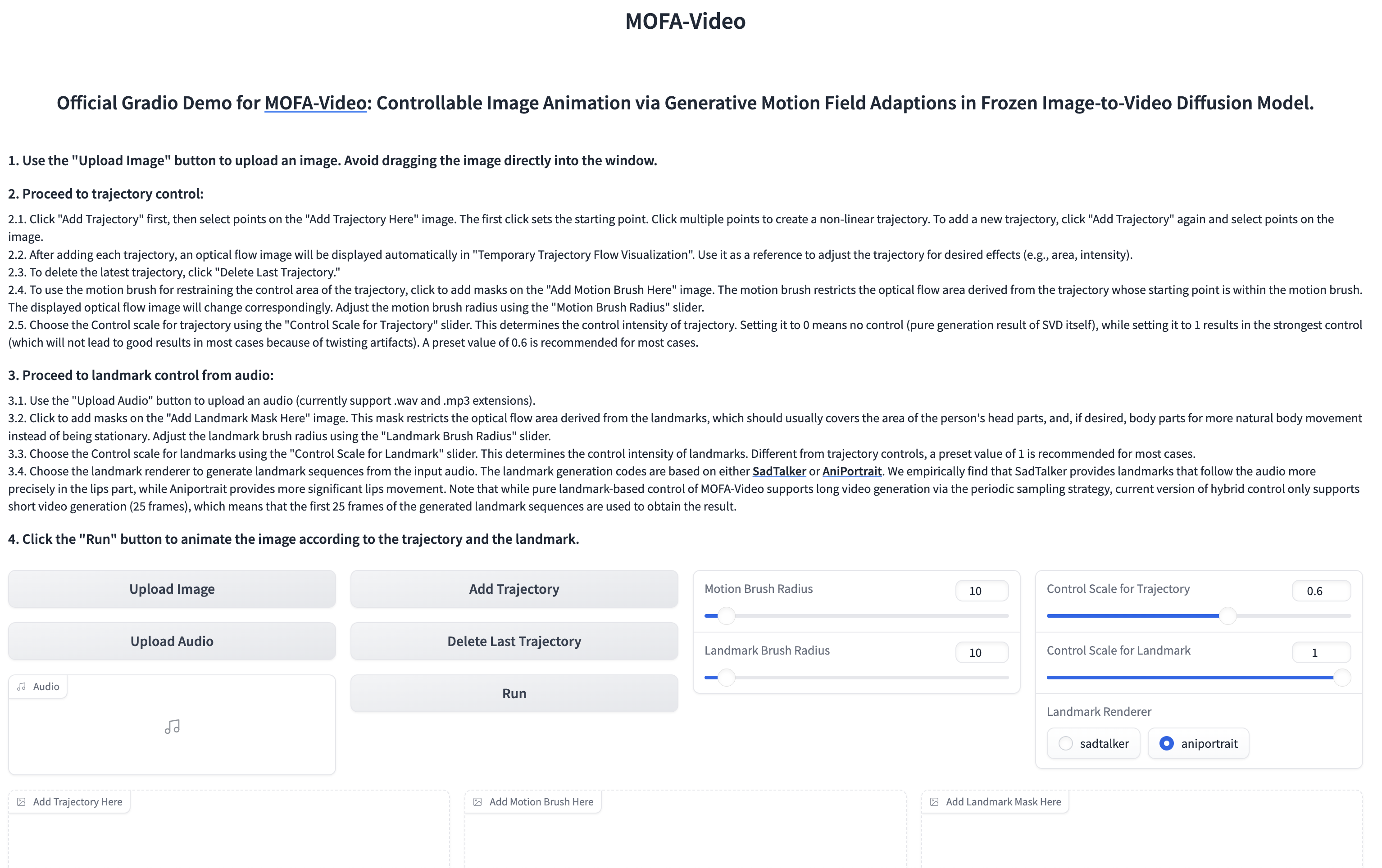

استخدام الصوت لتحريك جزء الوجه

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

؟؟؟ يتم عرض واجهة Gradio على النحو التالي. يرجى الرجوع إلى التعليمات الموجودة على واجهة Gradio أثناء عملية الاستدلال!

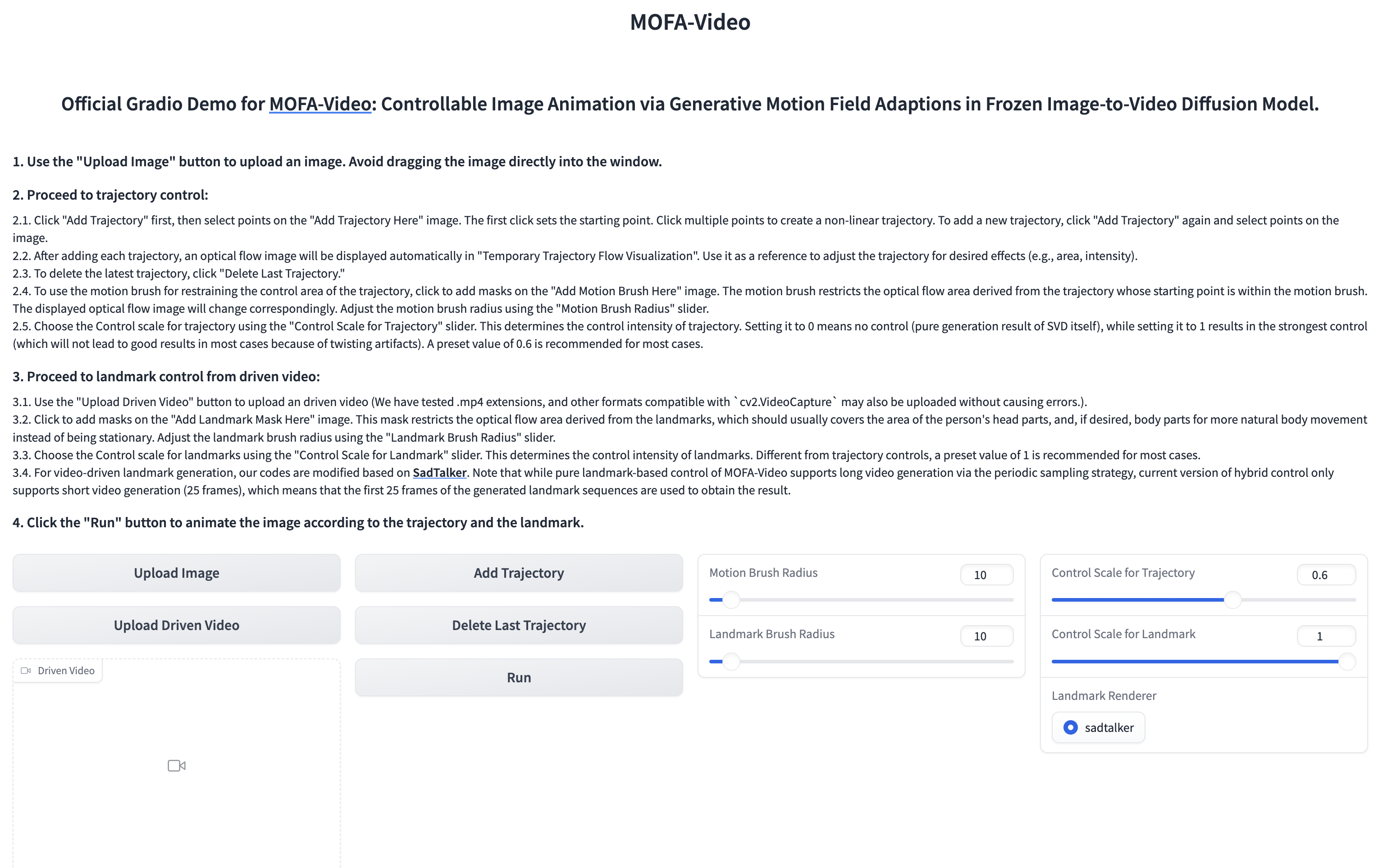

استخدام الفيديو المرجعي لتحريك جزء الوجه

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

؟؟؟ يتم عرض واجهة Gradio على النحو التالي. يرجى الرجوع إلى التعليمات الموجودة على واجهة Gradio أثناء عملية الاستدلال!

يرجى الرجوع إلى هنا للحصول على التعليمات.

يرجى الرجوع إلى هنا لمزيد من التعليمات.

@article{niu2024mofa,

title={MOFA-Video: Controllable Image Animation via Generative Motion Field Adaptions in Frozen Image-to-Video Diffusion Model},

author={Niu, Muyao and Cun, Xiaodong and Wang, Xintao and Zhang, Yong and Shan, Ying and Zheng, Yinqiang},

journal={arXiv preprint arXiv:2405.20222},

year={2024}

}

نحن نقدر بإخلاص إصدار الكود للمشاريع التالية: Dragnuwa و Sadtalker و AniporTrait و Diffusers و SVD_XTEND والانتشار الشرطي للحفاظ على الحركة و UNIMATCH.